Peranti teknologi

Peranti teknologi

AI

AI

OccFusion: Rangka kerja gabungan berbilang sensor yang mudah dan berkesan untuk Occ (Prestasi SOTA)

OccFusion: Rangka kerja gabungan berbilang sensor yang mudah dan berkesan untuk Occ (Prestasi SOTA)

OccFusion: Rangka kerja gabungan berbilang sensor yang mudah dan berkesan untuk Occ (Prestasi SOTA)

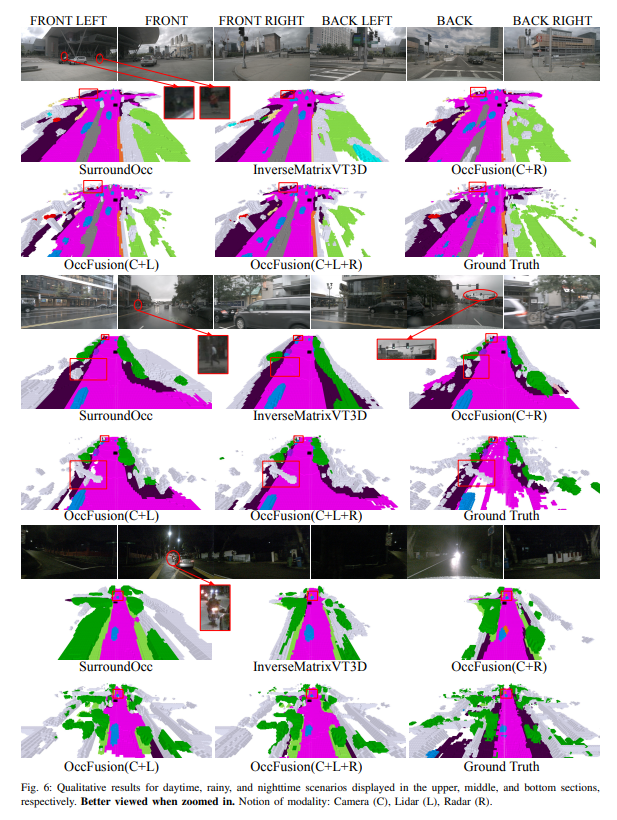

Pemahaman menyeluruh tentang adegan 3D adalah penting dalam pemanduan autonomi, dan model ramalan penghunian semantik 3D terkini telah berjaya menangani cabaran untuk menerangkan objek dunia sebenar dengan bentuk dan kategori yang berbeza. Walau bagaimanapun, kaedah ramalan penghunian 3D sedia ada banyak bergantung pada imej kamera panoramik, yang menjadikannya mudah terdedah kepada perubahan dalam keadaan pencahayaan dan cuaca. Dengan menyepadukan keupayaan penderia tambahan seperti lidar dan radar pandangan sekeliling, rangka kerja kami meningkatkan ketepatan dan keteguhan ramalan penghunian, menghasilkan prestasi terbaik pada penanda aras nuScenes. Tambahan pula, eksperimen yang meluas pada set data nuScene, termasuk adegan waktu malam dan hujan yang mencabar, mengesahkan prestasi unggul strategi gabungan sensor kami merentas pelbagai julat penderiaan.

Pautan kertas: https://arxiv.org/pdf/2403.01644.pdf

Nama kertas: OccFusion: A Straightforward and Effective Multi-Sensor Fusion Framework for 3D Occupancy Prediction

Sumbangan utama artikel ini diringkaskan seperti berikut :

- Rangka kerja gabungan berbilang sensor dicadangkan untuk menyepadukan maklumat kamera, lidar dan radar untuk melaksanakan tugas ramalan penghunian semantik 3D.

- Dalam tugas ramalan penghunian semantik 3D, kaedah kami dibandingkan dengan algoritma tercanggih (SOTA) lain untuk menunjukkan kelebihan gabungan berbilang sensor.

- Kajian ablasi menyeluruh telah dijalankan untuk menilai peningkatan prestasi yang dicapai oleh kombinasi sensor yang berbeza di bawah pencahayaan yang mencabar dan keadaan cuaca seperti malam dan hujan.

- Kajian komprehensif telah dijalankan untuk menganalisis kesan faktor julat persepsi terhadap prestasi rangka kerja kami dalam tugas ramalan penghunian semantik 3D, dengan mengambil kira pelbagai kombinasi penderia dan senario yang mencabar!

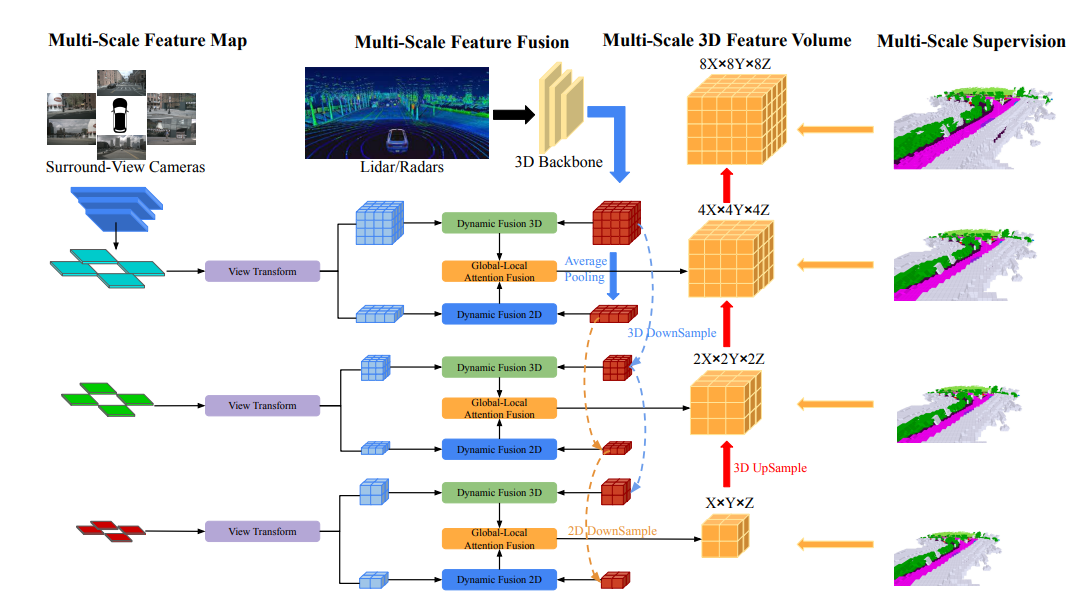

Gambaran keseluruhan struktur rangkaian

Seni bina keseluruhan OccFusion adalah seperti berikut. Pertama, imej paparan sekeliling dimasukkan ke dalam tulang belakang 2D untuk mengekstrak ciri berbilang skala. Selepas itu, transformasi paparan dilakukan pada setiap skala untuk mendapatkan ciri BEV global dan volum ciri 3D tempatan pada setiap peringkat. Awan titik 3D yang dijana oleh lidar dan radar sekeliling juga dimasukkan ke dalam tulang belakang 3D untuk menjana kuantiti ciri 3D tempatan berbilang skala dan ciri BEV global. Modul gabungan dinamik 3D/2D pada setiap peringkat menggabungkan keupayaan kamera dan lidar/radar. Selepas ini, gabungan ciri BEV global dan volum ciri 3D tempatan pada setiap peringkat dimasukkan ke dalam gabungan perhatian global-tempatan untuk menjana volum 3D akhir pada setiap skala. Akhir sekali, volum 3D pada setiap peringkat ditingkatkan dan disambungkan langkau dengan mekanisme penyeliaan berbilang skala.

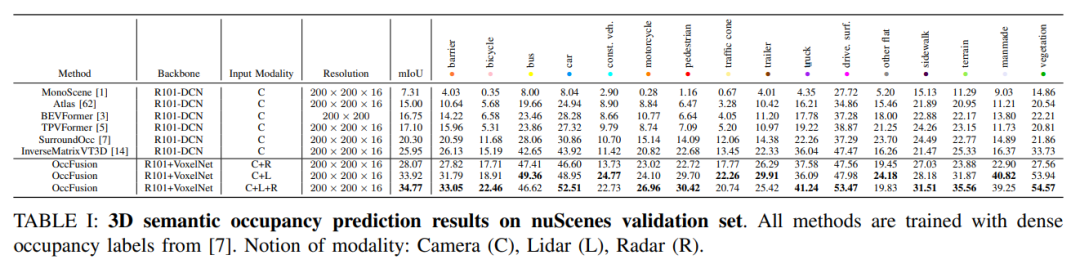

Analisis perbandingan eksperimen

Pada set pengesahan nuScenes, hasil pelbagai kaedah berdasarkan latihan label penghunian padat dalam ramalan penghunian semantik 3D ditunjukkan. Kaedah ini melibatkan konsep modal yang berbeza termasuk kamera (C), lidar (L) dan radar (R).

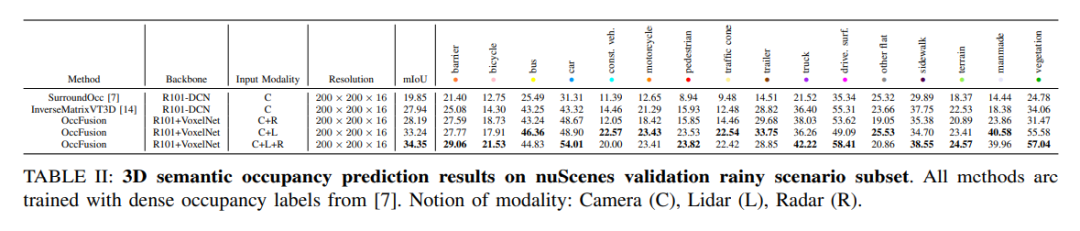

Pada subset kejadian hujan bagi set data nuScenes, kami meramalkan penghunian semantik 3D dan menggunakan label penghunian padat untuk latihan. Dalam eksperimen ini, kami mempertimbangkan data daripada modaliti yang berbeza seperti kamera (C), lidar (L), radar (R), dsb. Gabungan mod ini boleh membantu kami lebih memahami dan meramalkan adegan hujan, memberikan rujukan penting untuk pembangunan sistem pemanduan autonomi.

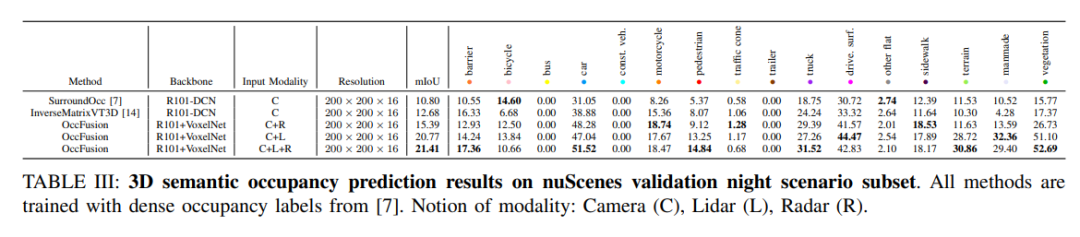

nuScenes mengesahkan keputusan ramalan penghunian semantik 3D untuk subset adegan waktu malam. Semua kaedah dilatih menggunakan label penghunian padat. Konsep modal: kamera (C), lidar (L), radar (R).

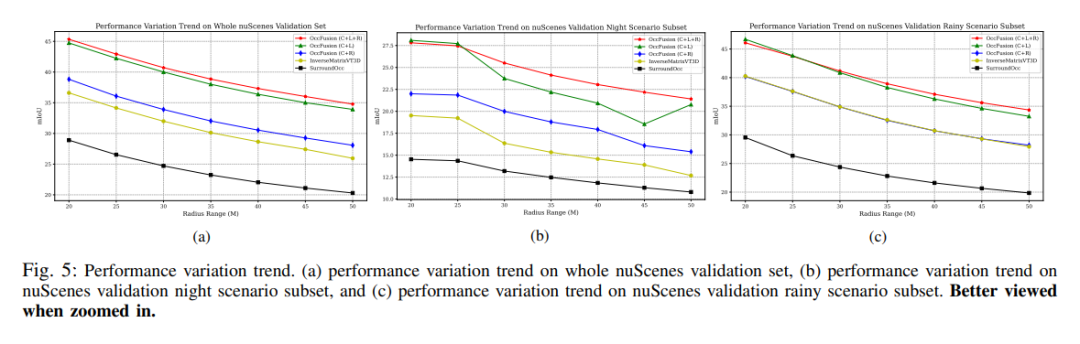

Trend perubahan prestasi. (a) Trend perubahan prestasi bagi keseluruhan set pengesahan nuScenes, (b) subset adegan malam pengesahan nuScenes, dan (c) trend perubahan prestasi pengesahan nuScene bagi subset pemandangan hujan.

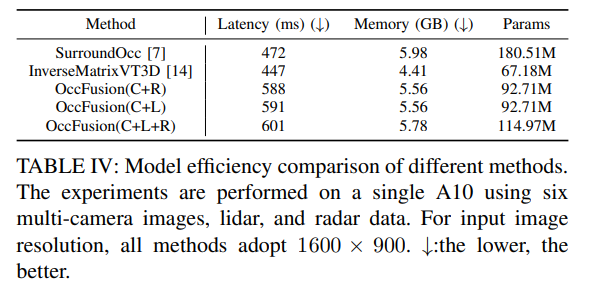

Jadual 4: Perbandingan kecekapan model kaedah yang berbeza. Eksperimen telah dijalankan pada A10 menggunakan enam imej berbilang kamera, data lidar dan radar. Untuk resolusi imej input, 1600×900 digunakan untuk semua kaedah. ↓:Lebih rendah lebih baik.

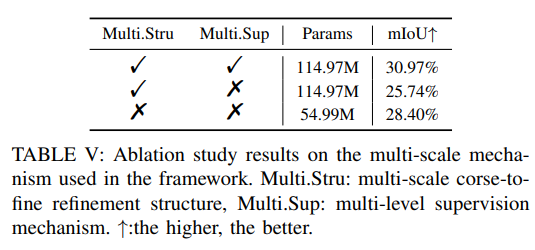

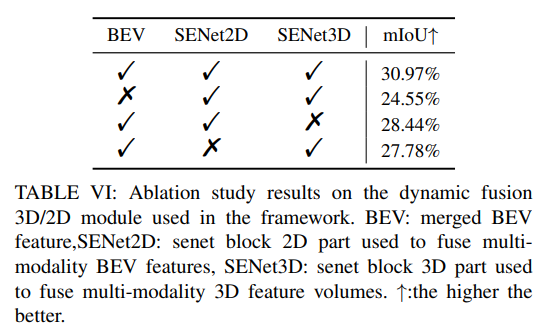

Lebih banyak eksperimen ablasi:

Atas ialah kandungan terperinci OccFusion: Rangka kerja gabungan berbilang sensor yang mudah dan berkesan untuk Occ (Prestasi SOTA). Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1378

1378

52

52

Wah hebat! Pengalaman Samsung Galaxy Ring: 2999 yuan cincin pintar sebenar

Jul 19, 2024 pm 02:31 PM

Wah hebat! Pengalaman Samsung Galaxy Ring: 2999 yuan cincin pintar sebenar

Jul 19, 2024 pm 02:31 PM

Samsung secara rasmi mengeluarkan versi kebangsaan Samsung Galaxy Ring pada 17 Julai, berharga 2,999 yuan. Telefon sebenar Galaxy Ring adalah versi 2024 "WowAwesome, ini adalah detik eksklusif saya". Ia adalah produk elektronik yang membuatkan kita berasa paling segar dalam beberapa tahun kebelakangan ini (walaupun bunyinya seperti bendera) dalam beberapa tahun kebelakangan ini. (Dalam gambar, cincin di kiri dan kanan ialah Galaxy Ring↑) Spesifikasi Samsung Galaxy Ring (data dari laman web rasmi Bank of China): Sistem ZephyrRTOS, storan 8MB kalis air + kapasiti bateri IP68; mAh (saiz yang berbeza

Tingkatkan ke skrin penuh! iPhone SE4 maju ke bulan September

Jul 24, 2024 pm 12:56 PM

Tingkatkan ke skrin penuh! iPhone SE4 maju ke bulan September

Jul 24, 2024 pm 12:56 PM

Baru-baru ini, berita baru mengenai iPhone SE4 telah didedahkan di Weibo Dikatakan bahawa proses penutup belakang iPhone SE4 adalah sama seperti versi standard iPhone 16 Dengan kata lain, iPhone SE4 akan menggunakan panel belakang kaca dan a skrin lurus dan reka bentuk tepi lurus. Dilaporkan bahawa iPhone SE4 akan dikeluarkan lebih awal hingga September tahun ini, bermakna ia berkemungkinan akan dilancarkan pada masa yang sama dengan iPhone 16. 1. Menurut paparan yang terdedah, reka bentuk hadapan iPhone SE4 adalah serupa dengan iPhone 13, dengan kamera hadapan dan sensor FaceID pada skrin takuk. Bahagian belakang menggunakan reka letak yang serupa dengan iPhoneXr, tetapi ia hanya mempunyai satu kamera dan tidak mempunyai modul kamera keseluruhan.

Nama kod penuh siri Xiaomi 15 didedahkan: Dada, Haotian, Xuanyuan

Aug 22, 2024 pm 06:47 PM

Nama kod penuh siri Xiaomi 15 didedahkan: Dada, Haotian, Xuanyuan

Aug 22, 2024 pm 06:47 PM

Siri Xiaomi Mi 15 dijangka akan dikeluarkan secara rasmi pada bulan Oktober, dan nama kod siri penuhnya telah didedahkan dalam pangkalan kod MiCode media asing. Antaranya, perdana Xiaomi Mi 15 Ultra diberi nama kod "Xuanyuan" (bermaksud "Xuanyuan"). Nama ini berasal daripada Maharaja Kuning dalam mitologi Cina, yang melambangkan bangsawan. Xiaomi 15 diberi nama kod "Dada", manakala Xiaomi 15Pro dinamakan "Haotian" (bermaksud "Haotian"). Nama kod dalaman Xiaomi Mi 15S Pro ialah "dijun", yang merujuk kepada Maharaja Jun, tuhan pencipta "The Classic of Mountains and Seas". Sarung siri Xiaomi 15Ultra

iPhone 18 didedahkan menggunakan sensor Samsung

Jul 25, 2024 pm 10:42 PM

iPhone 18 didedahkan menggunakan sensor Samsung

Jul 25, 2024 pm 10:42 PM

Dilaporkan bahawa siri iPhone 18 akan datang Apple dijangka menggunakan penderia imej yang dibuat oleh Samsung Perubahan ini dijangka memecahkan monopoli Sony dalam rantaian bekalan Apple. 1. Menurut laporan, Samsung telah menubuhkan pasukan khusus untuk memenuhi keperluan Apple. Samsung akan menyediakan Apple dengan penderia imej sudut ultra lebar 48-megapiksel, 1/2.6-inci bermula pada 2026, menunjukkan bahawa Apple tidak lagi bergantung sepenuhnya pada bekalan sensor Sony. Apple mempunyai hampir seribu pembekal dan strategi pengurusan rantaian bekalannya adalah fleksibel dan boleh diubah. Apple biasanya memperuntukkan sekurang-kurangnya dua pembekal untuk setiap komponen untuk mempromosikan persaingan pembekal dan mendapatkan harga yang lebih baik. Memperkenalkan Samsung sebagai pembekal sensor boleh mengoptimumkan struktur kos Apple dan boleh menjejaskan kedudukan pasaran Sony. Kekuatan teknologi penderia imej Samsung

Bagaimana untuk menilai keberkesanan kos sokongan komersial untuk rangka kerja Java

Jun 05, 2024 pm 05:25 PM

Bagaimana untuk menilai keberkesanan kos sokongan komersial untuk rangka kerja Java

Jun 05, 2024 pm 05:25 PM

Menilai kos/prestasi sokongan komersial untuk rangka kerja Java melibatkan langkah-langkah berikut: Tentukan tahap jaminan yang diperlukan dan jaminan perjanjian tahap perkhidmatan (SLA). Pengalaman dan kepakaran pasukan sokongan penyelidikan. Pertimbangkan perkhidmatan tambahan seperti peningkatan, penyelesaian masalah dan pengoptimuman prestasi. Timbang kos sokongan perniagaan terhadap pengurangan risiko dan peningkatan kecekapan.

OPPO Find X7 ialah karya agung! Abadikan setiap detik anda dengan imej

Aug 07, 2024 pm 07:19 PM

OPPO Find X7 ialah karya agung! Abadikan setiap detik anda dengan imej

Aug 07, 2024 pm 07:19 PM

Dalam era yang pantas ini, OPPO Find X7 boleh menggunakan kuasa pengimejannya untuk membolehkan kita menikmati setiap detik indah dalam hidup. Sama ada gunung yang indah, sungai, tasik atau laut, pertemuan keluarga yang mesra atau pertemuan dan kejutan di jalanan, ini boleh membantu anda merakamnya dengan kualiti gambar yang "tidak dapat ditandingi". Dari luar, reka bentuk Deco kamera Find It kelihatan sangat dikenali dan mempunyai rasa mewah. Bahagian dalam juga unik, bermula dengan konfigurasi perkakasan asas. FindX7 mengekalkan yang sebelumnya

Bagaimanakah keluk pembelajaran rangka kerja PHP berbanding rangka kerja bahasa lain?

Jun 06, 2024 pm 12:41 PM

Bagaimanakah keluk pembelajaran rangka kerja PHP berbanding rangka kerja bahasa lain?

Jun 06, 2024 pm 12:41 PM

Keluk pembelajaran rangka kerja PHP bergantung pada kecekapan bahasa, kerumitan rangka kerja, kualiti dokumentasi dan sokongan komuniti. Keluk pembelajaran rangka kerja PHP adalah lebih tinggi jika dibandingkan dengan rangka kerja Python dan lebih rendah jika dibandingkan dengan rangka kerja Ruby. Berbanding dengan rangka kerja Java, rangka kerja PHP mempunyai keluk pembelajaran yang sederhana tetapi masa yang lebih singkat untuk bermula.

Spesifikasi reka bentuk telefon 100 yuan Xiaomi Redmi 14C didedahkan, akan dikeluarkan pada 31 Ogos

Aug 23, 2024 pm 09:31 PM

Spesifikasi reka bentuk telefon 100 yuan Xiaomi Redmi 14C didedahkan, akan dikeluarkan pada 31 Ogos

Aug 23, 2024 pm 09:31 PM

Jenama Redmi Xiaomi sedang bersiap sedia untuk menambah telefon bajet lain pada portfolionya - Redmi 14C. Peranti itu disahkan akan dikeluarkan di Vietnam pada 31 Ogos. Bagaimanapun, menjelang pelancaran, spesifikasi telefon itu telah didedahkan melalui peruncit Vietnam. Redmi14CR Redmi sering membawakan reka bentuk baharu dalam siri baharu, dan Redmi14C tidak terkecuali. Telefon ini mempunyai modul kamera bulat besar di bahagian belakang, yang sama sekali berbeza daripada reka bentuk pendahulunya. Versi warna biru juga menggunakan reka bentuk kecerunan untuk menjadikannya kelihatan lebih mewah. Walau bagaimanapun, Redmi14C sebenarnya adalah telefon bimbit yang menjimatkan. Modul kamera terdiri daripada empat cincin; satu menempatkan sensor 50 megapiksel utama, dan satu lagi mungkin menempatkan kamera untuk maklumat kedalaman.