Peranti teknologi

Peranti teknologi

AI

AI

Untuk melindungi privasi pelanggan, jalankan model AI sumber terbuka secara tempatan menggunakan Ruby

Untuk melindungi privasi pelanggan, jalankan model AI sumber terbuka secara tempatan menggunakan Ruby

Untuk melindungi privasi pelanggan, jalankan model AI sumber terbuka secara tempatan menggunakan Ruby

Penterjemah |. Memandangkan Party A memegang maklumat pelanggan yang sangat sensitif, atas sebab keselamatan kami tidak boleh menyampaikannya kepada

OpenAI atau model proprietari lain. Oleh itu, kami memuat turun dan menjalankan model AI sumber terbuka dalam mesin maya AWS, memastikannya berada di bawah kawalan kami sepenuhnya. Pada masa yang sama, aplikasi

Rails boleh membuat

API panggilan ke AI dalam persekitaran yang selamat. Sudah tentu, jika isu keselamatan tidak perlu dipertimbangkan, kami lebih suka untuk bekerjasama secara langsung dengan OpenAI. Di bawah, saya akan berkongsi dengan anda cara memuat turun model AI sumber terbuka secara tempatan, biarkan ia berjalan, dan cara menjalankan skrip Ruby terhadapnya.

Mengapa menyesuaikan?

Motivasi untuk projek ini adalah mudah: keselamatan data. Apabila mengendalikan maklumat pelanggan yang sensitif, pendekatan yang paling boleh dipercayai biasanya melakukannya dalam syarikat. Oleh itu, kami memerlukan model AI tersuai untuk memainkan peranan dalam menyediakan tahap kawalan keselamatan dan perlindungan privasi yang lebih tinggi. Model sumber terbuka

Pada masa lalu

6 bulan telah ada produk baru di pasaran seperti:

dan Lamadsb. Sebilangan besar model AI sumber terbuka. Walaupun mereka tidak sekuat GPT-4, prestasi kebanyakan mereka telah melebihi GPT-3.5, dan mereka akan menjadi lebih dan lebih berkuasa seiring dengan berlalunya masa. Sudah tentu, model yang anda pilih bergantung sepenuhnya pada keupayaan pemprosesan anda dan perkara yang perlu anda capai. Memandangkan kami akan menjalankan model AI secara tempatan, kami memilih Mistral iaitu lebih kurang 4GB. Ia mengatasi prestasi GPT-3.5

pada kebanyakan metrik. Walaupun Mixtral berprestasi lebih baik daripada Mistral, ia adalah model besar yang memerlukan sekurang-kurangnya 48GB memori untuk dijalankan. ParameterApabila bercakap tentang model bahasa besar (LLM), kita cenderung untuk memikirkan tentang menyebut saiz parameternya. Di sini, model

Mistral yang akan kami jalankan secara tempatan ialah model parameter 7 bilion (sudah tentu,

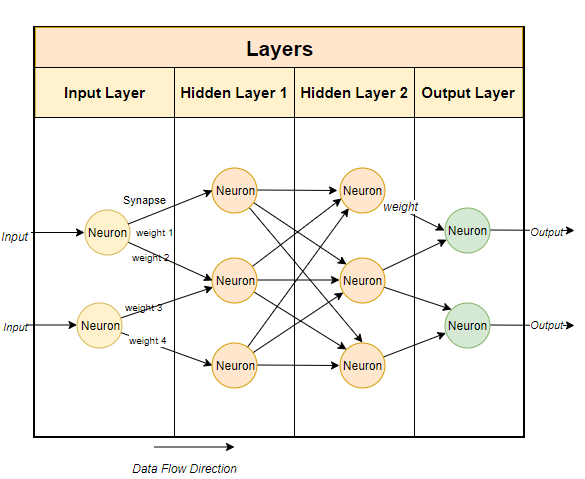

Mixtral mempunyai 700 bilion parameter, dan GP-T, dan lebih kurang GP-T 1750 bilion parameter). Lazimnya, model bahasa besar menggunakan teknik berasaskan rangkaian saraf. Rangkaian saraf terdiri daripada neuron, dan setiap neuron disambungkan kepada semua neuron lain dalam lapisan seterusnya.

Seperti yang ditunjukkan dalam gambar di atas, setiap sambungan mempunyai berat, biasanya dinyatakan sebagai peratusan. Setiap neuron juga mempunyai bias, yang membetulkan data semasa ia melalui nod.Tujuan rangkaian saraf adalah untuk "mempelajari" algoritma lanjutan, algoritma padanan corak. Dengan dilatih mengenai jumlah teks yang banyak, ia akan mempelajari secara beransur-ansur keupayaan untuk meramal corak teks dan bertindak balas dengan bermakna kepada isyarat yang kami berikan. Ringkasnya, parameter ialah bilangan berat dan berat sebelah dalam model. Ia memberi kita gambaran tentang berapa banyak neuron yang terdapat dalam rangkaian saraf. Contohnya, untuk model parameter

7 bilion, terdapat kira-kira  100

100

Jalankan model secara setempat

Untuk menjalankan model sumber terbuka secara setempat, anda mesti memuat turun aplikasi yang berkaitan terlebih dahulu. Walaupun terdapat banyak pilihan di pasaran, yang saya dapati paling mudah dan paling mudah untuk dijalankan pada Intel Mac ialah Ollama.

Walaupun

Ollama pada masa ini hanya berjalan pada Mac dan Linux pada masa hadapan, ia akan dijalankan pada masa hadapan Sudah tentu, anda boleh menggunakan WSL

(Windows Subsystem for Linux) pada Windows untuk menjalankan Linux shell.

Ollama bukan sahaja membenarkan anda memuat turun dan menjalankan pelbagai model sumber terbuka, tetapi juga membuka model pada port tempatan, membolehkan anda membuat API panggilan melalui Rubykod. Ini memudahkan Ruby pembangun menulis Ruby aplikasi yang boleh disepadukan dengan model tempatan. . sistem. Anda hanya perlu memuat turun Ollama melalui pautan

https://www.php.cn/link/04c7f37f2420f0532d7f0e062ff2d5b5, luangkan masa 5, dan kemudian jalankan perisian itu. . Ini bermakna ia berjalan di latar belakang dan boleh menjalankan model anda. Untuk memuat turun model, anda boleh membuka terminal dan menjalankan arahan berikut:

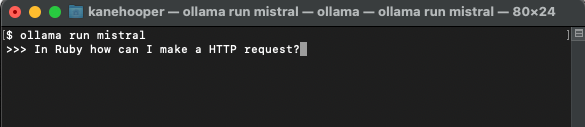

ollama run mistral

mistral melalui Ollama, anda boleh menjalankan model yang sepadan secara terus. . Di sini kita hanya boleh membuat model tersuai. Untuk kes yang lebih terperinci, sila rujuk dokumentasi dalam talian Ollama.

Pertama, anda boleh mencipta Modelfile (fail model) dan menambah teks berikut di dalamnya:

FROM mistral# Set the temperature set the randomness or creativity of the responsePARAMETER temperature 0.3# Set the system messageSYSTEM ”””You are an excerpt Ruby developer. You will be asked questions about the Ruby Programminglanguage. You will provide an explanation along with code examples.”””

Mesej sistem AI yang muncul di atas adalah asas untuk respons khusus bagi model. Seterusnya, anda boleh menjalankan arahan berikut pada terminal untuk mencipta model baharu: ollama create <model-name> -f './Modelfile</model-name>

ollama create ruby -f './Modelfile'

Pada masa yang sama, anda boleh menggunakan arahan berikut untuk menyenaraikan dan memaparkan model sedia ada anda: ollama list

anda boleh jalankan arahan berikut model tersuai:

Ollama run ruby

Integrated dengan Ruby

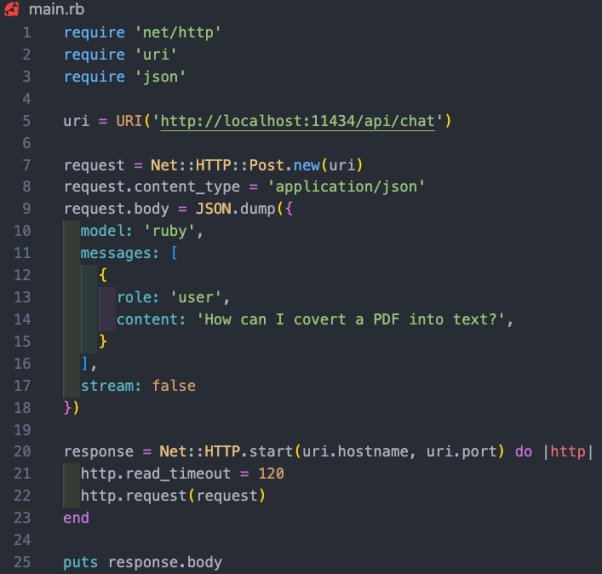

sementara Ollama tidak mempunyai gem yang berdedikasi lagi, ruby pemaju boleh menggunakan kaedah http http http http http http http untuk berinteraksi dengan model. Ollama berjalan di latar belakang boleh membuka model melalui port 11434

, jadi anda boleh mengaksesnya melalui "https://www.php.cn/link/dcd3f83c96576c0fd437286a1ff6f1f0". Selain itu, dokumentasi untuk OllamaAPI juga menyediakan titik akhir yang berbeza untuk arahan asas seperti perbualan sembang dan mencipta benaman. Dalam kes projek ini, kami mahu menggunakan titik akhir

/api/chat

Ruby asas untuk berinteraksi dengan model:

- Kefungsian di atas Rubykod termasuk: snippet: snippet net /http", "uri" dan "json" tiga perpustakaan masing-masing melaksanakan HTTP permintaan, menghuraikan json

- " masing-masing melaksanakan permintaan HTTP, menghuraikan URI URI

- data masing-masing. . ) objek URI. Gunakan kaedah Net::HTTP::Post.new dengan URI sebagai parameter untuk membuat permintaan

- HTTP POST baharu

- Isi permintaan ditetapkan kepada rentetan

- JSON yang mewakili nilai cincang. Cincang mengandungi tiga kunci: "model", "mesej" dan "strim". Antaranya, kunci model ditetapkan kepada "

- ruby", yang merupakan model kami; mewakili mesej pengguna. Nilai cincang;

- Sistem ini membimbing model tentang cara bertindak balas terhadap maklumat. Kami telah menetapkannya dalam Modelfile. Maklumat pengguna ialah gesaan standard kami.

- Model akan bertindak balas dengan maklumat tambahan.

- Pencincangan mesej mengikut corak yang bersilang dengan model AI. Ia datang dengan watak dan kandungan. Peranan di sini boleh menjadi Sistem, Pengguna dan Pembantu. Antaranya, permintaan

- HTTP

- dihantar menggunakan kaedah Net::HTTP.start . Kaedah ini membuka sambungan rangkaian ke nama hos dan port yang ditentukan dan kemudian menghantar permintaan. Tamat masa bacaan sambungan ditetapkan kepada

- 120 saat, lagipun saya sedang menjalankan 2019 IntelMac, jadi respons mungkin agak perlahan. Ini tidak akan menjadi masalah apabila berjalan pada pelayan AWS yang sepadan. Respons pelayan disimpan dalam pembolehubah "respons".

- Ringkasan Kes

CRM). Daripada ini, pengguna boleh bertanya apa-apa soalan yang mereka ada tentang pelanggan mereka tanpa perlu menyaring ratusan rekod.

Pengenalan penterjemah

Julian Chen, editor komuniti 51CTO, mempunyai lebih sepuluh tahun pengalaman pelaksanaan projek IT, pandai mengawal sumber komunikasi dalaman dan luaran serta risiko dan pengetahuan dan pengalaman keselamatan maklumat. .

Atas ialah kandungan terperinci Untuk melindungi privasi pelanggan, jalankan model AI sumber terbuka secara tempatan menggunakan Ruby. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

Bytedance Cutting melancarkan keahlian super SVIP: 499 yuan untuk langganan tahunan berterusan, menyediakan pelbagai fungsi AI

Jun 28, 2024 am 03:51 AM

Bytedance Cutting melancarkan keahlian super SVIP: 499 yuan untuk langganan tahunan berterusan, menyediakan pelbagai fungsi AI

Jun 28, 2024 am 03:51 AM

Laman web ini melaporkan pada 27 Jun bahawa Jianying ialah perisian penyuntingan video yang dibangunkan oleh FaceMeng Technology, anak syarikat ByteDance Ia bergantung pada platform Douyin dan pada asasnya menghasilkan kandungan video pendek untuk pengguna platform tersebut Windows , MacOS dan sistem pengendalian lain. Jianying secara rasmi mengumumkan peningkatan sistem keahliannya dan melancarkan SVIP baharu, yang merangkumi pelbagai teknologi hitam AI, seperti terjemahan pintar, penonjolan pintar, pembungkusan pintar, sintesis manusia digital, dsb. Dari segi harga, yuran bulanan untuk keratan SVIP ialah 79 yuan, yuran tahunan ialah 599 yuan (nota di laman web ini: bersamaan dengan 49.9 yuan sebulan), langganan bulanan berterusan ialah 59 yuan sebulan, dan langganan tahunan berterusan ialah 499 yuan setahun (bersamaan dengan 41.6 yuan sebulan) . Di samping itu, pegawai yang dipotong juga menyatakan bahawa untuk meningkatkan pengalaman pengguna, mereka yang telah melanggan VIP asal

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Editor |ScienceAI Question Answering (QA) set data memainkan peranan penting dalam mempromosikan penyelidikan pemprosesan bahasa semula jadi (NLP). Set data QA berkualiti tinggi bukan sahaja boleh digunakan untuk memperhalusi model, tetapi juga menilai dengan berkesan keupayaan model bahasa besar (LLM), terutamanya keupayaan untuk memahami dan menaakul tentang pengetahuan saintifik. Walaupun pada masa ini terdapat banyak set data QA saintifik yang meliputi bidang perubatan, kimia, biologi dan bidang lain, set data ini masih mempunyai beberapa kekurangan. Pertama, borang data adalah agak mudah, kebanyakannya adalah soalan aneka pilihan. Ia mudah dinilai, tetapi mengehadkan julat pemilihan jawapan model dan tidak dapat menguji sepenuhnya keupayaan model untuk menjawab soalan saintifik. Sebaliknya, Soal Jawab terbuka

SK Hynix akan memaparkan produk berkaitan AI baharu pada 6 Ogos: HBM3E 12 lapisan, NAND 321 tinggi, dsb.

Aug 01, 2024 pm 09:40 PM

SK Hynix akan memaparkan produk berkaitan AI baharu pada 6 Ogos: HBM3E 12 lapisan, NAND 321 tinggi, dsb.

Aug 01, 2024 pm 09:40 PM

Menurut berita dari laman web ini pada 1 Ogos, SK Hynix mengeluarkan catatan blog hari ini (1 Ogos), mengumumkan bahawa ia akan menghadiri Global Semiconductor Memory Summit FMS2024 yang akan diadakan di Santa Clara, California, Amerika Syarikat dari 6 hingga 8 Ogos, mempamerkan banyak produk penjanaan teknologi baru. Pengenalan kepada Sidang Kemuncak Memori dan Penyimpanan Masa Depan (FutureMemoryandStorage), dahulunya Sidang Kemuncak Memori Flash (FlashMemorySummit) terutamanya untuk pembekal NAND, dalam konteks peningkatan perhatian kepada teknologi kecerdasan buatan, tahun ini dinamakan semula sebagai Sidang Kemuncak Memori dan Penyimpanan Masa Depan (FutureMemoryandStorage) kepada jemput vendor DRAM dan storan serta ramai lagi pemain. Produk baharu SK hynix dilancarkan tahun lepas

Prestasi SOTA, kaedah AI ramalan pertalian protein-ligan pelbagai mod Xiamen, menggabungkan maklumat permukaan molekul buat kali pertama

Jul 17, 2024 pm 06:37 PM

Prestasi SOTA, kaedah AI ramalan pertalian protein-ligan pelbagai mod Xiamen, menggabungkan maklumat permukaan molekul buat kali pertama

Jul 17, 2024 pm 06:37 PM

Editor |. KX Dalam bidang penyelidikan dan pembangunan ubat, meramalkan pertalian pengikatan protein dan ligan dengan tepat dan berkesan adalah penting untuk pemeriksaan dan pengoptimuman ubat. Walau bagaimanapun, kajian semasa tidak mengambil kira peranan penting maklumat permukaan molekul dalam interaksi protein-ligan. Berdasarkan ini, penyelidik dari Universiti Xiamen mencadangkan rangka kerja pengekstrakan ciri berbilang mod (MFE) novel, yang buat pertama kalinya menggabungkan maklumat mengenai permukaan protein, struktur dan jujukan 3D, dan menggunakan mekanisme perhatian silang untuk membandingkan ciri modaliti yang berbeza penjajaran. Keputusan eksperimen menunjukkan bahawa kaedah ini mencapai prestasi terkini dalam meramalkan pertalian mengikat protein-ligan. Tambahan pula, kajian ablasi menunjukkan keberkesanan dan keperluan maklumat permukaan protein dan penjajaran ciri multimodal dalam rangka kerja ini. Penyelidikan berkaitan bermula dengan "S

Meletakkan pasaran seperti AI, GlobalFoundries memperoleh teknologi gallium nitrida Tagore Technology dan pasukan berkaitan

Jul 15, 2024 pm 12:21 PM

Meletakkan pasaran seperti AI, GlobalFoundries memperoleh teknologi gallium nitrida Tagore Technology dan pasukan berkaitan

Jul 15, 2024 pm 12:21 PM

Menurut berita dari laman web ini pada 5 Julai, GlobalFoundries mengeluarkan kenyataan akhbar pada 1 Julai tahun ini, mengumumkan pemerolehan teknologi power gallium nitride (GaN) Tagore Technology dan portfolio harta intelek, dengan harapan dapat mengembangkan bahagian pasarannya dalam kereta dan Internet of Things dan kawasan aplikasi pusat data kecerdasan buatan untuk meneroka kecekapan yang lebih tinggi dan prestasi yang lebih baik. Memandangkan teknologi seperti AI generatif terus berkembang dalam dunia digital, galium nitrida (GaN) telah menjadi penyelesaian utama untuk pengurusan kuasa yang mampan dan cekap, terutamanya dalam pusat data. Laman web ini memetik pengumuman rasmi bahawa semasa pengambilalihan ini, pasukan kejuruteraan Tagore Technology akan menyertai GLOBALFOUNDRIES untuk membangunkan lagi teknologi gallium nitride. G

Iyo One: Bahagian fon kepala, sebahagian komputer audio

Aug 08, 2024 am 01:03 AM

Iyo One: Bahagian fon kepala, sebahagian komputer audio

Aug 08, 2024 am 01:03 AM

Pada bila-bila masa, tumpuan adalah satu kebaikan. Pengarang |. Editor Tang Yitao |. AIPin yang paling popular telah menemui ulasan negatif yang belum pernah terjadi sebelumnya. Marques Brownlee (MKBHD) menyifatkannya sebagai produk terburuk yang pernah dia semak; Editor The Verge, David Pierce berkata dia tidak akan mengesyorkan sesiapa pun membeli peranti ini. Pesaingnya, RabbitR1, tidak jauh lebih baik. Keraguan terbesar tentang peranti AI ini ialah ia jelas hanya sebuah aplikasi, tetapi Arnab telah membina perkakasan bernilai $200. Ramai orang melihat inovasi perkakasan AI sebagai peluang untuk menumbangkan era telefon pintar dan menumpukan diri mereka kepadanya.

Sistem AI penemuan saintifik automatik sepenuhnya yang pertama, pengarang Transformer permulaan Sakana AI melancarkan AI Scientist

Aug 13, 2024 pm 04:43 PM

Sistem AI penemuan saintifik automatik sepenuhnya yang pertama, pengarang Transformer permulaan Sakana AI melancarkan AI Scientist

Aug 13, 2024 pm 04:43 PM

Editor |. ScienceAI Setahun yang lalu, Llion Jones, pengarang terakhir kertas Transformer Google, meninggalkan untuk memulakan perniagaan dan mengasaskan syarikat kecerdasan buatan SakanaAI dengan bekas penyelidik Google, David Ha. SakanaAI mendakwa mencipta model asas baharu berdasarkan kecerdasan yang diilhamkan oleh alam semula jadi! Kini, SakanaAI telah menyerahkan kertas jawapannya. SakanaAI mengumumkan pelancaran AIScientist, sistem AI pertama di dunia untuk penyelidikan saintifik automatik dan penemuan terbuka! Daripada mengandung, menulis kod, menjalankan eksperimen dan meringkaskan hasil, kepada menulis keseluruhan kertas kerja dan menjalankan ulasan rakan sebaya, AIScientist membuka kunci penyelidikan saintifik dan pecutan AI

Bagaimana cara menukar fail XML ke PDF di telefon anda?

Apr 02, 2025 pm 10:12 PM

Bagaimana cara menukar fail XML ke PDF di telefon anda?

Apr 02, 2025 pm 10:12 PM

Tidak mustahil untuk menyelesaikan penukaran XML ke PDF secara langsung di telefon anda dengan satu aplikasi. Ia perlu menggunakan perkhidmatan awan, yang boleh dicapai melalui dua langkah: 1. Tukar XML ke PDF di awan, 2. Akses atau muat turun fail PDF yang ditukar pada telefon bimbit.