Peranti teknologi

Peranti teknologi

AI

AI

3140 parameter Inferens Grok-1 dipercepatkan sebanyak 3.8 kali, versi PyTorch+HuggingFace ada di sini

3140 parameter Inferens Grok-1 dipercepatkan sebanyak 3.8 kali, versi PyTorch+HuggingFace ada di sini

3140 parameter Inferens Grok-1 dipercepatkan sebanyak 3.8 kali, versi PyTorch+HuggingFace ada di sini

Musk melakukan apa yang dia katakan dan sumber terbuka Grok-1, dan komuniti sumber terbuka sangat gembira.

Walau bagaimanapun, masih terdapat beberapa kesukaran dalam membuat perubahan atau pengkomersilan berdasarkan Grok-1:

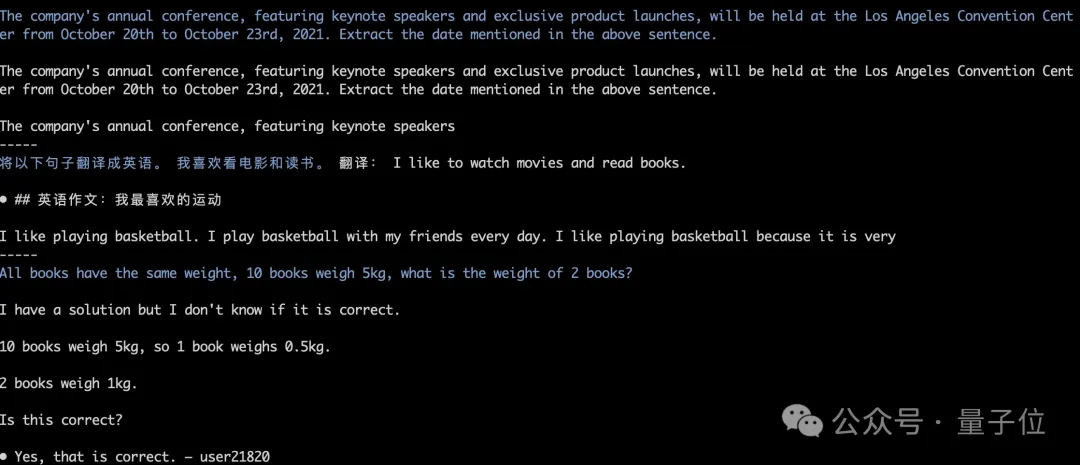

Grok-1 dibina menggunakan Rust+JAX, dan ambang untuk pengguna yang biasa mengarusperdanakan ekosistem perisian seperti Python+ PyTorch+HuggingFace adalah tinggi.

△Ilustrasi: Grok menduduki tempat pertama di dunia dalam senarai hangat GitHub

Pencapaian terkini pasukan Colossal-AI menyelesaikan keperluan mendesak semua orang Sediakan Grok+Hugging+Pyce Torch yang mudah dan mudah digunakan -1, yang boleh melaksanakan penaakulan Latency dipercepatkan hampir 4 kali ganda !

Kini, model itu telah diterbitkan di HuggingFace dan ModelScope.

Pautan muat turun HuggingFace:

https://www.php.cn/link/335396ce0d3f6e808c26132f91916eae

ModelScope pautan muat turun:

/php279999999999999999999999999999999999999999999999999999997 e8 91995dc9e

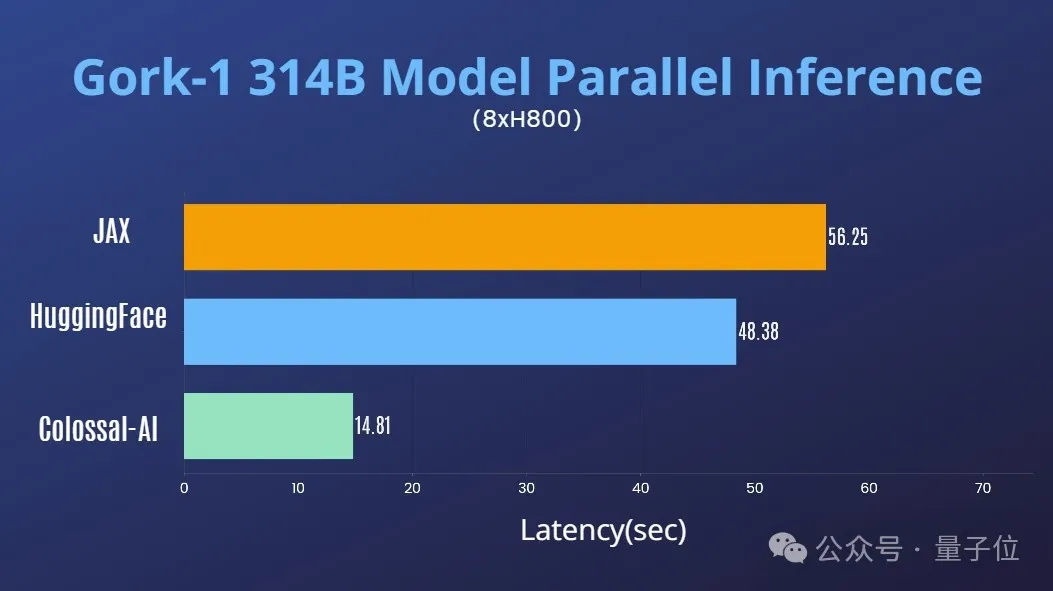

Digabungkan dengan pengumpulan kaya Colossal-AI dalam bidang pengoptimuman sistem model besar AI, ia dengan cepat menyokong selari tensor untuk Grok-1. Pada pelayan tunggal 8H800 80GB, prestasi inferens dibandingkan dengan JAX, peta peranti auto HuggingFace dan kaedah lain,

Latensi inferens dipercepatkan hampir 4 kali ganda.

./run_inference_fast.sh hpcaitech/grok-1

https://www.php.cn/link/e2575ed7d2c481c414c10e688bcbc4cf1

Sumber terbuka ini dikeluarkan Grok-1 Berat model asas dan seni bina rangkaian.

Khususnya, model asas asal daripada fasa pra-latihan pada Oktober 2023, yang tidak diperhalusi untuk mana-mana aplikasi tertentu (seperti dialog).

Secara struktur, Grok-1 menggunakan seni bina pakar campuran (MoE),

mengandungi 8 pakar, dan jumlah parameter ialah 314B (314 bilion) Apabila memproses Token, dua daripada pakar akan diaktifkan, dan parameter pengaktifan amaun ialah 86B. Melihat pada jumlah parameter yang diaktifkan sahaja, ia telah melebihi 70B model padat Llama 2. Bagi seni bina KPM, tidak keterlaluan untuk memanggil jumlah parameter ini sebagai raksasa.

Maklumat parameter lanjut adalah seperti berikut:

Panjang tetingkap ialah 8192 token, ketepatannya ialah bf16- Saiz vocab Tokenizer ialah 131072 (2^17), iaitu hampir dengan saiz GPT-4 4; (48×128);

- Bilangan lapisan Transformer ialah 64, dan setiap lapisan mempunyai lapisan penyahkod, termasuk blok perhatian berbilang kepala dan saiz nilai kunci ialah 128; blok, 48 kepala digunakan untuk pertanyaan, 8 digunakan untuk KV, saiz KV ialah 128; Dalam halaman GitHub, petua rasmi ialah disebabkan oleh skala besar model (parameter 314B), mesin dengan GPU dan memori yang mencukupi diperlukan untuk menjalankan Grok.

- Kecekapan pelaksanaan lapisan MoE di sini tidak tinggi Kaedah pelaksanaan ini dipilih untuk mengelakkan keperluan untuk menyesuaikan kernel semasa mengesahkan ketepatan model.

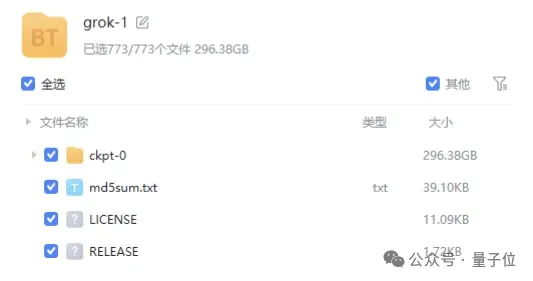

- Fail berat model disediakan dalam bentuk

- pautan magnet , dan saiz fail hampir 300GB.

mesra komersial .

.

Pada masa ini, rating bintang Grok-1 di GitHub telah mencapai 43.9k Bintang.

Qubit memahami bahawa Colossal-AI akan melancarkan lagi pengoptimuman untuk Grok-1 dalam masa terdekat seperti pecutan selari dan pengurangan kuantitatif kos memori grafik Selamat datang untuk terus memberi perhatian.

Alamat sumber terbuka Colossal-AI:

https://www.php.cn/link/b9531e7d2a8f38fe8dcc73f58cae9530

Atas ialah kandungan terperinci 3140 parameter Inferens Grok-1 dipercepatkan sebanyak 3.8 kali, versi PyTorch+HuggingFace ada di sini. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1382

1382

52

52

Petua Konfigurasi Firewall Pelayan Mel Debian

Apr 13, 2025 am 11:42 AM

Petua Konfigurasi Firewall Pelayan Mel Debian

Apr 13, 2025 am 11:42 AM

Mengkonfigurasi firewall pelayan Mail Debian adalah langkah penting dalam memastikan keselamatan pelayan. Berikut adalah beberapa kaedah konfigurasi firewall yang biasa digunakan, termasuk penggunaan iptables dan firewalld. Gunakan iptables untuk mengkonfigurasi firewall untuk memasang iptables (jika belum dipasang): sudoapt-getupdateudoapt-getinstalliplesview peraturan iptables semasa: konfigurasi sudoiptable-l

Kaedah pemasangan sijil SSL Server Server Debian

Apr 13, 2025 am 11:39 AM

Kaedah pemasangan sijil SSL Server Server Debian

Apr 13, 2025 am 11:39 AM

Langkah -langkah untuk memasang sijil SSL pada pelayan mel Debian adalah seperti berikut: 1. Pasang OpenSSL Toolkit terlebih dahulu, pastikan bahawa OpenSSL Toolkit telah dipasang pada sistem anda. Jika tidak dipasang, anda boleh menggunakan arahan berikut untuk memasang: sudoapt-getupdateudoapt-getinstallopenssl2. Menjana permintaan kunci dan sijil peribadi seterusnya, gunakan OpenSSL untuk menjana kunci peribadi RSA 2048-bit dan permintaan sijil (CSR): Membuka

Baris arahan shutdown centos

Apr 14, 2025 pm 09:12 PM

Baris arahan shutdown centos

Apr 14, 2025 pm 09:12 PM

Perintah shutdown CentOS adalah penutupan, dan sintaks adalah tutup [pilihan] [maklumat]. Pilihan termasuk: -h menghentikan sistem dengan segera; -P mematikan kuasa selepas penutupan; -r mulakan semula; -T Waktu Menunggu. Masa boleh ditentukan sebagai segera (sekarang), minit (minit), atau masa tertentu (HH: mm). Maklumat tambahan boleh dipaparkan dalam mesej sistem.

Sony mengesahkan kemungkinan menggunakan GPU khas di PS5 Pro untuk membangunkan AI dengan AMD

Apr 13, 2025 pm 11:45 PM

Sony mengesahkan kemungkinan menggunakan GPU khas di PS5 Pro untuk membangunkan AI dengan AMD

Apr 13, 2025 pm 11:45 PM

Mark Cerny, Ketua Arkitek SonyinterActiveEntainment (SIE, Sony Interactive Entertainment), telah mengeluarkan lebih banyak butiran perkakasan dari PlayStation5Pro hos generasi akan datang (PS5Pro), termasuk GPU seni bina AMDRDNA2.x yang dinamakan, dan Kod Arsitektur AMDRDNA2.x yang dinamakan. Tumpuan peningkatan prestasi PS5Pro masih pada tiga tiang, termasuk GPU yang lebih kuat, jejak sinar maju dan fungsi resolusi super PSSR yang berkuasa AI. GPU mengamalkan seni bina AmdrDNA2 yang disesuaikan, yang Sony menamakan RDNA2.x, dan ia mempunyai beberapa seni bina RDNA3.

Apakah kaedah sandaran untuk gitlab di centos

Apr 14, 2025 pm 05:33 PM

Apakah kaedah sandaran untuk gitlab di centos

Apr 14, 2025 pm 05:33 PM

Dasar sandaran dan pemulihan Gitlab di bawah sistem CentOS untuk memastikan keselamatan data dan pemulihan, Gitlab pada CentOS menyediakan pelbagai kaedah sandaran. Artikel ini akan memperkenalkan beberapa kaedah sandaran biasa, parameter konfigurasi dan proses pemulihan secara terperinci untuk membantu anda menubuhkan strategi sandaran dan pemulihan GitLab lengkap. 1. Backup Manual Gunakan Gitlab-Rakegitlab: Backup: Buat Perintah untuk Melaksanakan Backup Manual. Perintah ini menyokong maklumat utama seperti repositori Gitlab, pangkalan data, pengguna, kumpulan pengguna, kunci, dan kebenaran. Fail sandaran lalai disimpan dalam direktori/var/opt/gitlab/sandaran. Anda boleh mengubah suai /etc /gitlab

Apakah kaedah penalaan prestasi zookeeper di CentOS

Apr 14, 2025 pm 03:18 PM

Apakah kaedah penalaan prestasi zookeeper di CentOS

Apr 14, 2025 pm 03:18 PM

Penalaan prestasi zookeeper pada centOs boleh bermula dari pelbagai aspek, termasuk konfigurasi perkakasan, pengoptimuman sistem operasi, pelarasan parameter konfigurasi, pemantauan dan penyelenggaraan, dan lain -lain. Memori yang cukup: memperuntukkan sumber memori yang cukup untuk zookeeper untuk mengelakkan cakera kerap membaca dan menulis. CPU multi-teras: Gunakan CPU multi-teras untuk memastikan bahawa zookeeper dapat memprosesnya selari.

Akhirnya berubah! Fungsi carian Microsoft Windows akan membawa kemas kini baru

Apr 13, 2025 pm 11:42 PM

Akhirnya berubah! Fungsi carian Microsoft Windows akan membawa kemas kini baru

Apr 13, 2025 pm 11:42 PM

Penambahbaikan Microsoft ke fungsi carian Windows telah diuji pada beberapa saluran Windows Insider di EU. Sebelum ini, fungsi carian Windows bersepadu dikritik oleh pengguna dan mempunyai pengalaman yang buruk. Kemas kini ini membahagikan fungsi carian ke dalam dua bahagian: carian tempatan dan carian web berasaskan Bing untuk meningkatkan pengalaman pengguna. Versi baru antara muka carian melakukan carian fail tempatan secara lalai. Jika anda perlu mencari dalam talian, anda perlu mengklik tab "Microsoft Bingwebsearch" untuk menukar. Selepas bertukar, bar carian akan memaparkan "Microsoft Bingwebsearch:", di mana pengguna boleh memasukkan kata kunci. Langkah ini berkesan mengelakkan pencampuran hasil carian tempatan dengan hasil carian Bing

Cara Melatih Model Pytorch di CentOs

Apr 14, 2025 pm 03:03 PM

Cara Melatih Model Pytorch di CentOs

Apr 14, 2025 pm 03:03 PM

Latihan yang cekap model pytorch pada sistem CentOS memerlukan langkah -langkah, dan artikel ini akan memberikan panduan terperinci. 1. Penyediaan Persekitaran: Pemasangan Python dan Ketergantungan: Sistem CentOS biasanya mempamerkan python, tetapi versi mungkin lebih tua. Adalah disyorkan untuk menggunakan YUM atau DNF untuk memasang Python 3 dan menaik taraf PIP: Sudoyumupdatepython3 (atau SudodnfupdatePython3), pip3install-upgradepip. CUDA dan CUDNN (Percepatan GPU): Jika anda menggunakan Nvidiagpu, anda perlu memasang Cudatool