Peranti teknologi

Peranti teknologi

AI

AI

Penjelasan terperinci tentang pengekodan kedudukan putaran RoPE yang biasa digunakan dalam model bahasa besar: mengapa ia lebih baik daripada pengekodan kedudukan mutlak atau relatif?

Penjelasan terperinci tentang pengekodan kedudukan putaran RoPE yang biasa digunakan dalam model bahasa besar: mengapa ia lebih baik daripada pengekodan kedudukan mutlak atau relatif?

Penjelasan terperinci tentang pengekodan kedudukan putaran RoPE yang biasa digunakan dalam model bahasa besar: mengapa ia lebih baik daripada pengekodan kedudukan mutlak atau relatif?

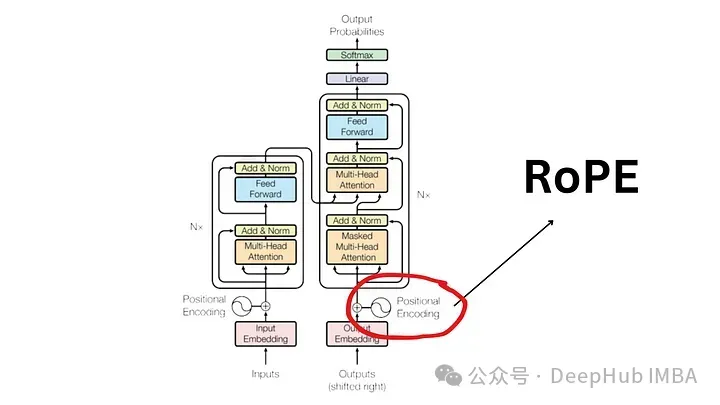

Sejak kertas "Attention Is All You Need" diterbitkan pada 2017, seni bina Transformer telah menjadi asas kepada bidang pemprosesan bahasa semula jadi (NLP). Reka bentuknya sebahagian besarnya kekal tidak berubah selama bertahun-tahun, dengan 2022 menandakan perkembangan besar dalam bidang dengan pengenalan Pengekodan Kedudukan Putar (RoPE).

Pembenaman kedudukan diputar ialah teknologi pembenaman kedudukan NLP yang paling canggih. Model bahasa berskala besar yang paling popular seperti Llama, Llama2, PaLM dan CodeGen sudah menggunakannya. Dalam artikel ini, kita akan menyelami apa itu pengekodan kedudukan bergilir dan cara ia menggabungkan dengan kemas kelebihan benam kedudukan mutlak dan relatif.

Keperluan untuk pengekodan kedudukan

Untuk memahami kepentingan RoPE, mari kita semak dahulu mengapa pengekodan kedudukan adalah penting. Model pengubah, dengan reka bentuk yang wujud, tidak mengambil kira susunan token input.

Sebagai contoh, frasa seperti "anjing mengejar babi" dan "babi mengejar anjing", walaupun ia mempunyai makna yang berbeza, dianggap tidak dapat dibezakan kerana ia dilihat sebagai set token yang tidak tertib. Untuk mengekalkan maklumat jujukan dan maksudnya, perwakilan diperlukan untuk menyepadukan maklumat kedudukan ke dalam model.

Pengekodan Kedudukan Mutlak

Untuk mengekod kedudukan dalam ayat, alat lain diperlukan menggunakan vektor dengan dimensi yang sama, di mana setiap vektor mewakili kedudukan dalam ayat. Sebagai contoh, nyatakan vektor khusus untuk perkataan kedua dalam ayat. Oleh itu, setiap kedudukan ayat mempunyai vektor yang unik. Input kepada lapisan Transformer kemudiannya dibentuk dengan menggabungkan perkataan embeddings dengan embeddings kedudukan sepadannya.

Terdapat dua cara utama untuk menjana benam ini:

- Belajar daripada data: Di sini, vektor kedudukan dipelajari semasa latihan, sama seperti parameter model lain. Kami mempelajari vektor unik untuk setiap kedudukan (mis. dari 1 hingga 512). Ini memperkenalkan had - panjang jujukan maksimum adalah terhad. Jika model hanya mempelajari kedudukan 512, ia tidak boleh mewakili jujukan lebih lama daripada kedudukan itu.

- Fungsi Sinus: Kaedah ini melibatkan penggunaan fungsi sinus untuk membina benam unik untuk setiap kedudukan. Walaupun butiran pembinaan ini rumit, ia pada asasnya menyediakan pembenaman kedudukan yang unik untuk setiap kedudukan dalam jujukan. Kajian empirikal menunjukkan bahawa pembelajaran dan menggunakan fungsi sinus daripada data boleh memberikan prestasi yang setanding dalam model dunia sebenar. . vektor kedudukan, yang sememangnya tidak boleh mewakili kedudukan melebihi had ini.

Kebebasan benaman lokasi: Setiap benaman lokasi adalah bebas daripada benaman lokasi lain. Ini bermakna dari perspektif model, perbezaan antara kedudukan 1 dan 2 adalah sama dengan perbezaan antara kedudukan 2 dan 500. Tetapi sebenarnya, kedudukan 1 dan 2 sepatutnya lebih berkait rapat daripada kedudukan 500, yang jauh lebih jauh. Kekurangan kedudukan relatif ini mungkin menghalang keupayaan model untuk memahami nuansa struktur bahasa.

Pengekodan kedudukan relatif

- Kedudukan relatif tidak menumpukan pada kedudukan mutlak nota dalam ayat, tetapi pada jarak antara pasangan not. Kaedah ini tidak menambah vektor kedudukan terus kepada vektor perkataan. Sebaliknya, mekanisme perhatian diubah untuk memasukkan maklumat kedudukan relatif.

- T5 (Pengubah Pemindahan Teks ke Teks) ialah model terkenal yang menggunakan pembenaman kedudukan relatif. T5 memperkenalkan cara yang halus untuk mengendalikan maklumat kedudukan:

T5 menggunakan pincang (nombor titik terapung) untuk mewakili setiap pengimbangan kedudukan yang mungkin. Sebagai contoh, bias B1 mungkin mewakili jarak relatif antara mana-mana dua token yang berselang satu kedudukan, tanpa mengira kedudukan mutlaknya dalam ayat.

Integrasi dalam lapisan perhatian kendiri: Matriks bias kedudukan relatif ini ditambahkan pada hasil darab matriks pertanyaan dan matriks kunci dalam lapisan perhatian kendiri. Ini memastikan bahawa penanda pada jarak relatif yang sama sentiasa diwakili oleh berat sebelah yang sama, tanpa mengira kedudukannya dalam jujukan.

Skalabilitas:

- Kelebihan ketara pendekatan ini ialah kebolehskalaannya. Ia boleh dilanjutkan kepada urutan panjang sewenang-wenangnya, yang mempunyai kelebihan yang jelas berbanding pembenaman kedudukan mutlak.

- Had pengekodan kedudukan relatif

Walaupun ia menarik secara teori, pengekodan kedudukan relatif amat bermasalah

- Tidak cekap pengiraan: matriks pengekodan kedudukan berpasangan mesti dibuat dan kemudian sejumlah besar operasi tensor dilakukan untuk mendapatkan pengekodan kedudukan relatif setiap langkah. Terutama untuk urutan yang lebih panjang. Ini disebabkan terutamanya oleh langkah pengiraan tambahan dalam lapisan perhatian kendiri, di mana matriks kedudukan ditambahkan pada matriks kunci pertanyaan.

- Kerumitan penggunaan cache nilai kunci: Memandangkan setiap token tambahan mengubah pembenaman setiap token lain, ini merumitkan penggunaan berkesan cache nilai kunci dalam Transformer. Satu keperluan untuk menggunakan cache KV ialah pengekodan kedudukan bagi perkataan yang telah dijana tidak berubah apabila menjana perkataan baharu (pengekodan kedudukan mutlak menyediakan) jadi pengekodan kedudukan relatif tidak sesuai untuk inferens kerana pembenaman setiap token akan berubah dengan setiap perubahan baharu dengan langkah masa.

Disebabkan kerumitan kejuruteraan ini, pengekodan kedudukan belum diterima pakai secara meluas, terutamanya dalam model bahasa yang lebih besar.

Pengekodan Kedudukan Putaran (RoPE)?

RoPE mewakili cara baharu pengekodan maklumat lokasi. Kedua-dua kaedah mutlak dan kaedah relatif dalam kaedah tradisional mempunyai batasannya. Pengekodan kedudukan mutlak memberikan vektor unik kepada setiap kedudukan, yang mudah tetapi tidak berskala dengan baik dan tidak dapat menangkap kedudukan relatif secara berkesan memfokuskan pada jarak antara penanda, meningkatkan pemahaman model tentang hubungan penanda, tetapi menjadikan reka bentuk model menjadi rumit; .

RoPE bijak menggabungkan kelebihan kedua-duanya. Mengekodkan maklumat lokasi dengan cara yang membolehkan model memahami lokasi mutlak penanda dan jarak relatifnya. Ini dicapai melalui mekanisme putaran, di mana setiap kedudukan dalam urutan diwakili oleh putaran dalam ruang benam. Keanggunan RoPE terletak pada kesederhanaan dan kecekapannya, yang membolehkan model memahami dengan lebih baik nuansa sintaks dan semantik bahasa.

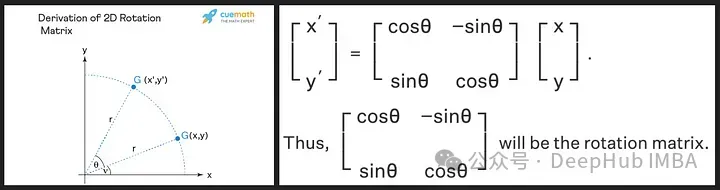

Matriks putaran diperoleh daripada sifat trigonometri sinus dan kosinus yang kita pelajari di sekolah menengah, menggunakan matriks 2D sepatutnya cukup untuk mendapatkan teori matriks putaran seperti yang ditunjukkan di bawah!

Kita lihat bahawa matriks putaran mengekalkan saiz (atau panjang) vektor asal, seperti yang ditunjukkan oleh "r" dalam imej di atas, satu-satunya perkara yang berubah ialah sudut dengan paksi-x.

RoPE memperkenalkan konsep baru. Daripada menambah vektor kedudukan, ia menggunakan putaran pada vektor perkataan. Sudut putaran (θ) adalah berkadar dengan kedudukan perkataan dalam ayat. Vektor pada kedudukan pertama diputarkan oleh θ, vektor pada kedudukan kedua diputar sebanyak 2θ, dan seterusnya. Pendekatan ini mempunyai beberapa faedah:

- Kestabilan vektor: Menambah penanda pada akhir ayat tidak menjejaskan vektor perkataan permulaan, yang bermanfaat untuk caching yang cekap.

- Pemeliharaan kedudukan relatif: Jika dua perkataan mengekalkan jarak relatif yang sama dalam konteks yang berbeza, vektornya akan diputar dengan jumlah yang sama. Ini memastikan bahawa sudut, serta hasil darab titik antara vektor ini, kekal malar

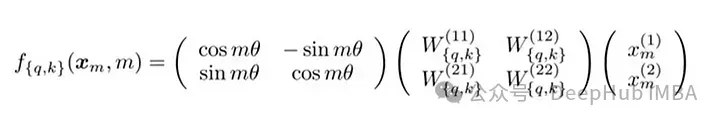

Formula matriks RoPE

Pelaksanaan teknikal RoPE melibatkan matriks putaran. Dalam kes 2D, persamaan dalam kertas mengandungi matriks putaran yang memutarkan vektor sebanyak Mθ darjah, di mana M ialah kedudukan mutlak dalam ayat. Putaran ini digunakan pada vektor pertanyaan dan vektor kunci dalam mekanisme perhatian kendiri Transformer.

Untuk dimensi yang lebih tinggi, vektor dibahagikan kepada blok 2D, dan setiap pasangan diputar secara berasingan. Ini boleh dianggap sebagai dimensi n berputar dalam ruang. Nampaknya kaedah ini rumit untuk dilaksanakan, tetapi ini tidak boleh dilaksanakan dengan cekap dalam perpustakaan seperti PyTorch dengan hanya kira-kira sepuluh baris kod.

import torch import torch.nn as nn class RotaryPositionalEmbedding(nn.Module): def __init__(self, d_model, max_seq_len): super(RotaryPositionalEmbedding, self).__init__() # Create a rotation matrix. self.rotation_matrix = torch.zeros(d_model, d_model, device=torch.device("cuda")) for i in range(d_model): for j in range(d_model): self.rotation_matrix[i, j] = torch.cos(i * j * 0.01) # Create a positional embedding matrix. self.positional_embedding = torch.zeros(max_seq_len, d_model, device=torch.device("cuda")) for i in range(max_seq_len): for j in range(d_model): self.positional_embedding[i, j] = torch.cos(i * j * 0.01) def forward(self, x): """Args:x: A tensor of shape (batch_size, seq_len, d_model). Returns:A tensor of shape (batch_size, seq_len, d_model).""" # Add the positional embedding to the input tensor. x += self.positional_embedding # Apply the rotation matrix to the input tensor. x = torch.matmul(x, self.rotation_matrix) return xSalin selepas log masuk

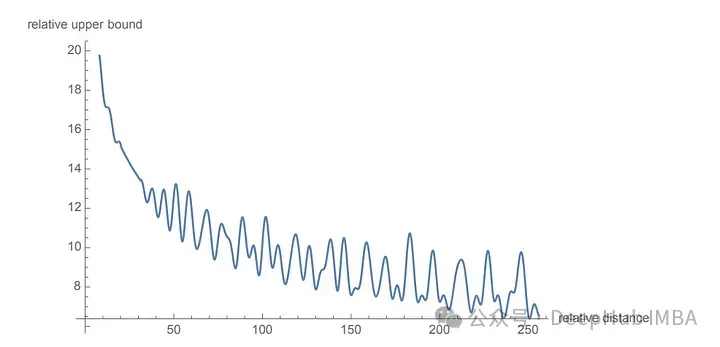

为了旋转是通过简单的向量运算而不是矩阵乘法来执行。距离较近的单词更有可能具有较高的点积,而距离较远的单词则具有较低的点积,这反映了它们在给定上下文中的相对相关性。

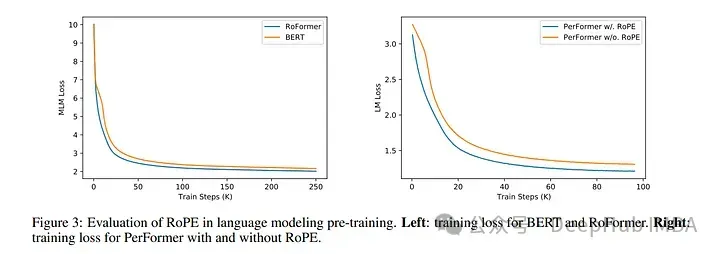

使用 RoPE 对 RoBERTa 和 Performer 等模型进行的实验表明,与正弦嵌入相比,它的训练时间更快。并且该方法在各种架构和训练设置中都很稳健。

最主要的是RoPE是可以外推的,也就是说可以直接处理任意长的问题。在最早的llamacpp项目中就有人通过线性插值RoPE扩张,在推理的时候直接通过线性插值将LLAMA的context由2k拓展到4k,并且性能没有下降,所以这也可以证明RoPE的有效性。

代码如下:

import transformers old_init = transformers.models.llama.modeling_llama.LlamaRotaryEmbedding.__init__ def ntk_scaled_init(self, dim, max_position_embeddings=2048, base=10000, device=None): #The method is just these three linesmax_position_embeddings = 16384a = 8 #Alpha valuebase = base * a ** (dim / (dim-2)) #Base change formula old_init(self, dim, max_position_embeddings, base, device) transformers.models.llama.modeling_llama.LlamaRotaryEmbedding.__init__ = ntk_scaled_init

Salin selepas log masuk总结

旋转位置嵌入代表了 Transformer 架构的范式转变,提供了一种更稳健、直观和可扩展的位置信息编码方式。

RoPE不仅解决了LLM context过长之后引起的上下文无法关联问题,并且还提高了训练和推理的速度。这一进步不仅增强了当前的语言模型,还为 NLP 的未来创新奠定了基础。随着我们不断解开语言和人工智能的复杂性,像 RoPE 这样的方法将有助于构建更先进、更准确、更类人的语言处理系统。

Atas ialah kandungan terperinci Penjelasan terperinci tentang pengekodan kedudukan putaran RoPE yang biasa digunakan dalam model bahasa besar: mengapa ia lebih baik daripada pengekodan kedudukan mutlak atau relatif?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1379

1379

52

52

Panduan langkah demi langkah untuk menggunakan Groq Llama 3 70B secara tempatan

Jun 10, 2024 am 09:16 AM

Panduan langkah demi langkah untuk menggunakan Groq Llama 3 70B secara tempatan

Jun 10, 2024 am 09:16 AM

Penterjemah |. Tinjauan Bugatti |. Chonglou Artikel ini menerangkan cara menggunakan enjin inferens GroqLPU untuk menjana respons sangat pantas dalam JanAI dan VSCode. Semua orang sedang berusaha membina model bahasa besar (LLM) yang lebih baik, seperti Groq yang memfokuskan pada bahagian infrastruktur AI. Sambutan pantas daripada model besar ini adalah kunci untuk memastikan model besar ini bertindak balas dengan lebih cepat. Tutorial ini akan memperkenalkan enjin parsing GroqLPU dan cara mengaksesnya secara setempat pada komputer riba anda menggunakan API dan JanAI. Artikel ini juga akan menyepadukannya ke dalam VSCode untuk membantu kami menjana kod, kod refactor, memasukkan dokumentasi dan menjana unit ujian. Artikel ini akan mencipta pembantu pengaturcaraan kecerdasan buatan kami sendiri secara percuma. Pengenalan kepada enjin inferens GroqLPU Groq

Tujuh Soalan Temuduga Teknikal GenAI & LLM yang Cool

Jun 07, 2024 am 10:06 AM

Tujuh Soalan Temuduga Teknikal GenAI & LLM yang Cool

Jun 07, 2024 am 10:06 AM

Untuk mengetahui lebih lanjut tentang AIGC, sila layari: 51CTOAI.x Komuniti https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou berbeza daripada bank soalan tradisional yang boleh dilihat di mana-mana sahaja di Internet memerlukan pemikiran di luar kotak. Model Bahasa Besar (LLM) semakin penting dalam bidang sains data, kecerdasan buatan generatif (GenAI) dan kecerdasan buatan. Algoritma kompleks ini meningkatkan kemahiran manusia dan memacu kecekapan dan inovasi dalam banyak industri, menjadi kunci kepada syarikat untuk kekal berdaya saing. LLM mempunyai pelbagai aplikasi Ia boleh digunakan dalam bidang seperti pemprosesan bahasa semula jadi, penjanaan teks, pengecaman pertuturan dan sistem pengesyoran. Dengan belajar daripada sejumlah besar data, LLM dapat menjana teks

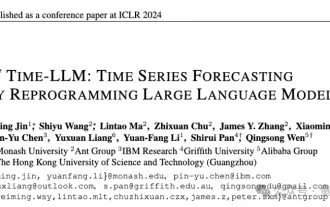

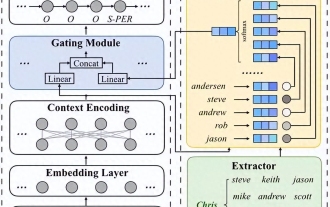

Model besar juga sangat berkuasa dalam ramalan siri masa! Pasukan China mengaktifkan keupayaan baharu LLM dan mencapai SOTA melebihi model tradisional

Apr 11, 2024 am 09:43 AM

Model besar juga sangat berkuasa dalam ramalan siri masa! Pasukan China mengaktifkan keupayaan baharu LLM dan mencapai SOTA melebihi model tradisional

Apr 11, 2024 am 09:43 AM

Potensi model bahasa besar dirangsang - ramalan siri masa berketepatan tinggi boleh dicapai tanpa melatih model bahasa besar, mengatasi semua model siri masa tradisional. Monash University, Ant dan IBM Research bersama-sama membangunkan rangka kerja umum yang berjaya mempromosikan keupayaan model bahasa besar untuk memproses data jujukan merentas modaliti. Rangka kerja telah menjadi inovasi teknologi yang penting. Ramalan siri masa bermanfaat untuk membuat keputusan dalam sistem kompleks biasa seperti bandar, tenaga, pengangkutan, penderiaan jauh, dsb. Sejak itu, model besar dijangka merevolusikan perlombongan data siri masa/spatiotemporal. Pasukan penyelidikan rangka kerja pengaturcaraan semula model bahasa besar am mencadangkan rangka kerja umum untuk menggunakan model bahasa besar dengan mudah untuk ramalan siri masa umum tanpa sebarang latihan. Dua teknologi utama dicadangkan terutamanya: pengaturcaraan semula input masa; Masa-

Adakah kedudukan melekit terlepas daripada aliran dokumen?

Feb 20, 2024 pm 05:24 PM

Adakah kedudukan melekit terlepas daripada aliran dokumen?

Feb 20, 2024 pm 05:24 PM

Adakah kedudukan melekit menjauhkan diri daripada aliran dokumen Contoh kod khusus diperlukan dalam pembangunan web, reka letak adalah topik yang sangat penting. Antaranya, positioning merupakan salah satu teknik susun atur yang biasa digunakan. Dalam CSS, terdapat tiga kaedah penentududukan biasa: kedudukan statik, kedudukan relatif dan kedudukan mutlak. Selain ketiga-tiga kaedah penentududukan ini, terdapat juga kaedah penentududukan yang lebih istimewa iaitu pelekatan kedudukan. Jadi, adakah kedudukan melekit terlepas daripada aliran dokumen? Mari bincangkannya secara terperinci di bawah dan berikan beberapa contoh kod untuk membantu memahami. Pertama, kita perlu memahami apa itu aliran dokumen

Sebarkan model bahasa besar secara setempat dalam OpenHarmony

Jun 07, 2024 am 10:02 AM

Sebarkan model bahasa besar secara setempat dalam OpenHarmony

Jun 07, 2024 am 10:02 AM

Artikel ini akan membuka sumber hasil "Pengedaran Tempatan Model Bahasa Besar dalam OpenHarmony" yang ditunjukkan pada Persidangan Teknologi OpenHarmony ke-2 alamat sumber terbuka: https://gitee.com/openharmony-sig/tpc_c_cplusplus/blob/master/thirdparty/. InferLLM/docs/ hap_integrate.md. Idea dan langkah pelaksanaan adalah untuk memindahkan rangka kerja inferens model LLM ringan InferLLM kepada sistem standard OpenHarmony dan menyusun produk binari yang boleh dijalankan pada OpenHarmony. InferLLM ialah L yang mudah dan cekap

Hongmeng Smart Travel S9 dan persidangan pelancaran produk baharu senario penuh, beberapa produk baharu blockbuster dikeluarkan bersama-sama

Aug 08, 2024 am 07:02 AM

Hongmeng Smart Travel S9 dan persidangan pelancaran produk baharu senario penuh, beberapa produk baharu blockbuster dikeluarkan bersama-sama

Aug 08, 2024 am 07:02 AM

Petang ini, Hongmeng Zhixing secara rasmi mengalu-alukan jenama baharu dan kereta baharu. Pada 6 Ogos, Huawei mengadakan persidangan pelancaran produk baharu Hongmeng Smart Xingxing S9 dan senario penuh Huawei, membawakan sedan perdana pintar panoramik Xiangjie S9, M7Pro dan Huawei novaFlip baharu, MatePad Pro 12.2 inci, MatePad Air baharu, Huawei Bisheng With banyak produk pintar semua senario baharu termasuk pencetak laser siri X1, FreeBuds6i, WATCHFIT3 dan skrin pintar S5Pro, daripada perjalanan pintar, pejabat pintar kepada pakaian pintar, Huawei terus membina ekosistem pintar senario penuh untuk membawa pengguna pengalaman pintar Internet Segala-galanya. Hongmeng Zhixing: Pemerkasaan mendalam untuk menggalakkan peningkatan industri kereta pintar Huawei berganding bahu dengan rakan industri automotif China untuk menyediakan

Pemprosesan bahasa semula jadi: membolehkan komputer memahami dan memproses bahasa manusia

Sep 21, 2023 pm 03:53 PM

Pemprosesan bahasa semula jadi: membolehkan komputer memahami dan memproses bahasa manusia

Sep 21, 2023 pm 03:53 PM

Natural Language Processing (NLP) ialah teknologi penting dan menarik dalam bidang kecerdasan buatan Matlamatnya adalah untuk membolehkan komputer memahami, menghuraikan dan menjana bahasa manusia. Pembangunan NLP telah mencapai kemajuan yang luar biasa, membolehkan komputer berinteraksi dengan lebih baik dengan manusia dan mencapai rangkaian aplikasi yang lebih luas. Artikel ini akan meneroka konsep, teknologi, aplikasi dan prospek pemprosesan bahasa semula jadi pada masa hadapan Konsep pemprosesan bahasa semula jadi ialah satu disiplin yang mengkaji bagaimana untuk membolehkan komputer memahami dan memproses bahasa manusia. Kerumitan dan kekaburan bahasa manusia menjadikan komputer menghadapi cabaran besar dalam memahami dan memproses. Matlamat NLP adalah untuk membangunkan algoritma dan model yang membolehkan komputer mengekstrak maklumat daripada teks

Bagaimanakah penggunaan fungsi Java dalam pemprosesan bahasa semula jadi memudahkan interaksi perbualan?

Apr 30, 2024 am 08:03 AM

Bagaimanakah penggunaan fungsi Java dalam pemprosesan bahasa semula jadi memudahkan interaksi perbualan?

Apr 30, 2024 am 08:03 AM

Fungsi Java digunakan secara meluas dalam NLP untuk mencipta penyelesaian tersuai yang meningkatkan pengalaman interaksi perbualan. Fungsi ini boleh digunakan untuk prapemprosesan teks, analisis sentimen, pengecaman niat dan pengekstrakan entiti. Contohnya, dengan menggunakan fungsi Java untuk analisis sentimen, aplikasi boleh memahami nada pengguna dan bertindak balas dengan sewajarnya, meningkatkan pengalaman perbualan.