Peranti teknologi

Peranti teknologi

AI

AI

Mengapakah model bahasa besar menggunakan SwiGLU sebagai fungsi pengaktifan?

Mengapakah model bahasa besar menggunakan SwiGLU sebagai fungsi pengaktifan?

Mengapakah model bahasa besar menggunakan SwiGLU sebagai fungsi pengaktifan?

Jika anda telah memberi perhatian kepada seni bina model bahasa besar, anda mungkin pernah melihat istilah "SwiGLU" dalam model dan kertas penyelidikan terkini. SwiGLU boleh dikatakan sebagai fungsi pengaktifan yang paling biasa digunakan dalam model bahasa besar Kami akan memperkenalkannya secara terperinci dalam artikel ini. SwiGLU sebenarnya adalah fungsi pengaktifan yang dicadangkan oleh Google pada tahun 2020, yang menggabungkan ciri-ciri SWISH dan GLU. Nama penuh Cina SwiGLU ialah "unit linear berpagar dua arah". Ia mengoptimumkan dan menggabungkan dua fungsi pengaktifan, SWISH dan GLU, untuk meningkatkan keupayaan ekspresi tak linear model. SWISH ialah fungsi pengaktifan yang sangat biasa yang digunakan secara meluas dalam model bahasa besar, manakala GLU berfungsi dengan baik dalam tugas pemprosesan bahasa semula jadi. Kelebihan SwiGLU ialah ia boleh memperoleh ciri pelicinan SWISH dan ciri gating GLU pada masa yang sama, sekali gus menjadikan ekspresi tak linear model lebih

Kami akan memperkenalkannya satu persatu:

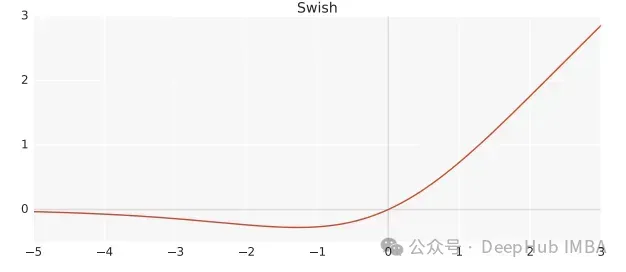

Swish

Swish ialah fungsi pengaktifan tak linear, ditakrifkan seperti berikut:

Swish(x) = x*sigmoid(ßx)

di mana, ß ialah parameter yang boleh dipelajari. Swish boleh menjadi lebih baik daripada fungsi pengaktifan ReLU kerana ia memberikan peralihan yang lebih lancar yang boleh membawa kepada pengoptimuman yang lebih baik.

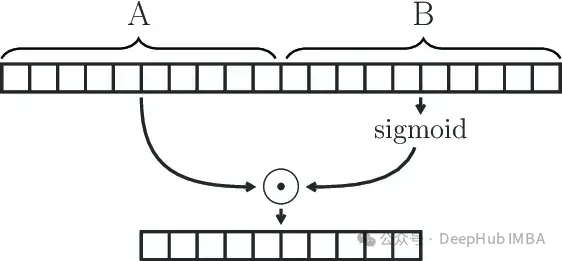

Unit Linear Berpagar

GLU (Unit Linear Berpagar) ditakrifkan sebagai produk komponen dua transformasi linear, satu daripadanya diaktifkan oleh sigmoid.

GLU(x) = sigmoid(W1x+b)⊗(Vx+c)

Modul GLU secara berkesan boleh menangkap kebergantungan jarak jauh dalam jujukan sambil mengelakkan beberapa masalah kecerunan yang lenyap yang dikaitkan dengan mekanisme gating lain seperti LSTM dan GRU.

SwiGLU

Kami telah pun mengatakan bahawa SwiGLU adalah gabungan kedua-duanya. Ia adalah GLU, tetapi daripada menggunakan sigmoid sebagai fungsi pengaktifan, kami menggunakan swish dengan ß=1, jadi kami berakhir dengan formula berikut:

SwiGLU(x) = Swish(W1x+b)⊗(Vx+c)

Kami menggunakan fungsi SwiGLU untuk membina rangkaian feedforward

FFNSwiGLU(x) = (Swish1(xW)⊗xV)W2

Pelaksanaan mudah Pytorch

Jika prinsip matematik di atas kelihatan menyusahkan dan membosankan, kami akan menerangkannya terus menggunakan kod di bawah.

class SwiGLU(nn.Module): def __init__(self, w1, w2, w3) -> None:super().__init__()self.w1 = w1self.w2 = w2self.w3 = w3 def forward(self, x):x1 = F.linear(x, self.w1.weight)x2 = F.linear(x, self.w2.weight)hidden = F.silu(x1) * x2return F.linear(hidden, self.w3.weight)

Fungsi F.silu yang digunakan dalam kod kami adalah sama seperti swish apabila ß=1, jadi kami menggunakannya secara langsung.

Anda boleh lihat dari kod tersebut terdapat 3 pemberat dalam fungsi pengaktifan kami yang boleh dilatih iaitu parameter dari formula GLU.

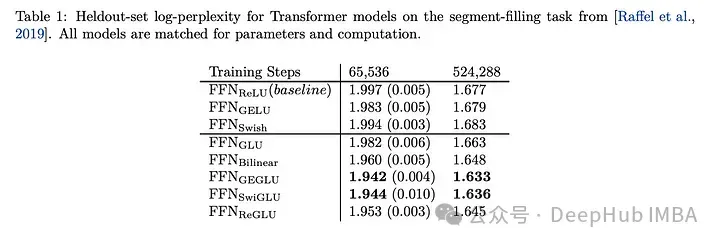

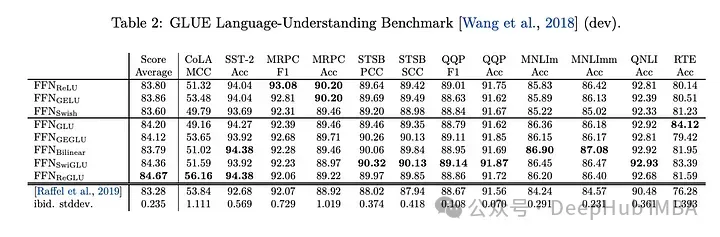

Perbandingan Kesan SwiGLU

Membandingkan SwiGLU dengan varian GLU yang lain, kita dapat melihat bahawa SwiGLU menunjukkan prestasi yang lebih baik semasa kedua-dua tempoh pra-latihan.

Tugas hiliran

mempunyai prestasi terbaik, jadi sekarang llm, seperti LLAMA, OLMO dan PALM semuanya menggunakan SwiGLU dalam pelaksanaannya. Tetapi mengapa SwiGLU lebih baik daripada yang lain?

Kertas itu hanya memberikan keputusan ujian dan tidak menjelaskan sebab sebaliknya, ia berkata:

Kami tidak memberikan penjelasan mengapa seni bina ini nampaknya berkesan, seperti yang lain. kepada ihsan ilahi.

Penulis berkata bahawa alkimia itu berjaya.

Tetapi sekarang sudah 2024 dan kami boleh menerangkannya dengan tegas:

1 Respons Swish yang agak kecil terhadap nilai negatif mengatasi kekurangan ReLU bahawa output pada sesetengah neuron sentiasa sifar

. Ciri-ciri gating GLU, yang bermaksud bahawa ia boleh memutuskan maklumat mana yang harus diluluskan dan maklumat mana yang harus ditapis berdasarkan situasi input. Mekanisme ini membolehkan rangkaian mempelajari perwakilan berguna dengan lebih berkesan dan membantu meningkatkan keupayaan generalisasi model. Dalam model bahasa yang besar, ini amat berguna untuk memproses jujukan teks yang panjang dengan kebergantungan jarak jauh.3 Parameter W1, W2, W3, b1, b2, b3 dalam SwiGLU boleh dipelajari melalui latihan, supaya model boleh melaraskan parameter ini secara dinamik mengikut tugasan dan set data yang dipertingkatkan.

4. Kecekapan pengiraan adalah lebih tinggi daripada beberapa fungsi pengaktifan yang lebih kompleks (seperti GELU), sambil mengekalkan prestasi yang baik. Ini merupakan pertimbangan penting untuk latihan dan inferens model bahasa berskala besar.

Pilih SwiGLU sebagai fungsi pengaktifan model bahasa besar, terutamanya kerana ia menggabungkan kelebihan keupayaan tak linear, ciri gating, kestabilan kecerunan dan parameter yang boleh dipelajari. SwiGLU diterima pakai secara meluas kerana prestasi cemerlangnya dalam mengendalikan hubungan semantik yang kompleks dan masalah pergantungan yang lama dalam model bahasa, serta mengekalkan kestabilan latihan dan kecekapan pengiraan.

Alamat kertas

Atas ialah kandungan terperinci Mengapakah model bahasa besar menggunakan SwiGLU sebagai fungsi pengaktifan?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1378

1378

52

52

Mengapakah model bahasa besar menggunakan SwiGLU sebagai fungsi pengaktifan?

Apr 08, 2024 pm 09:31 PM

Mengapakah model bahasa besar menggunakan SwiGLU sebagai fungsi pengaktifan?

Apr 08, 2024 pm 09:31 PM

Jika anda telah memberi perhatian kepada seni bina model bahasa yang besar, anda mungkin pernah melihat istilah "SwiGLU" dalam model dan kertas penyelidikan terkini. SwiGLU boleh dikatakan sebagai fungsi pengaktifan yang paling biasa digunakan dalam model bahasa besar Kami akan memperkenalkannya secara terperinci dalam artikel ini. SwiGLU sebenarnya adalah fungsi pengaktifan yang dicadangkan oleh Google pada tahun 2020, yang menggabungkan ciri-ciri SWISH dan GLU. Nama penuh Cina SwiGLU ialah "unit linear berpagar dua arah". Ia mengoptimumkan dan menggabungkan dua fungsi pengaktifan, SWISH dan GLU, untuk meningkatkan keupayaan ekspresi tak linear model. SWISH ialah fungsi pengaktifan yang sangat biasa yang digunakan secara meluas dalam model bahasa besar, manakala GLU telah menunjukkan prestasi yang baik dalam tugas pemprosesan bahasa semula jadi.

Bolehkah penalaan halus benar-benar membolehkan LLM mempelajari perkara baharu: memperkenalkan pengetahuan baharu boleh menjadikan model menghasilkan lebih banyak halusinasi

Jun 11, 2024 pm 03:57 PM

Bolehkah penalaan halus benar-benar membolehkan LLM mempelajari perkara baharu: memperkenalkan pengetahuan baharu boleh menjadikan model menghasilkan lebih banyak halusinasi

Jun 11, 2024 pm 03:57 PM

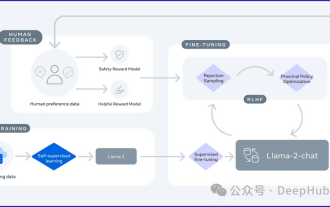

Model Bahasa Besar (LLM) dilatih pada pangkalan data teks yang besar, di mana mereka memperoleh sejumlah besar pengetahuan dunia sebenar. Pengetahuan ini dibenamkan ke dalam parameter mereka dan kemudiannya boleh digunakan apabila diperlukan. Pengetahuan tentang model ini "diperbaharui" pada akhir latihan. Pada akhir pra-latihan, model sebenarnya berhenti belajar. Selaraskan atau perhalusi model untuk mempelajari cara memanfaatkan pengetahuan ini dan bertindak balas dengan lebih semula jadi kepada soalan pengguna. Tetapi kadangkala pengetahuan model tidak mencukupi, dan walaupun model boleh mengakses kandungan luaran melalui RAG, ia dianggap berfaedah untuk menyesuaikan model kepada domain baharu melalui penalaan halus. Penalaan halus ini dilakukan menggunakan input daripada anotasi manusia atau ciptaan LLM lain, di mana model menemui pengetahuan dunia sebenar tambahan dan menyepadukannya

Visualisasikan ruang vektor FAISS dan laraskan parameter RAG untuk meningkatkan ketepatan hasil

Mar 01, 2024 pm 09:16 PM

Visualisasikan ruang vektor FAISS dan laraskan parameter RAG untuk meningkatkan ketepatan hasil

Mar 01, 2024 pm 09:16 PM

Memandangkan prestasi model bahasa berskala besar sumber terbuka terus bertambah baik, prestasi dalam penulisan dan analisis kod, pengesyoran, ringkasan teks dan pasangan menjawab soalan (QA) semuanya bertambah baik. Tetapi apabila ia berkaitan dengan QA, LLM sering gagal dalam isu yang berkaitan dengan data yang tidak terlatih, dan banyak dokumen dalaman disimpan dalam syarikat untuk memastikan pematuhan, rahsia perdagangan atau privasi. Apabila dokumen ini disoal, LLM boleh berhalusinasi dan menghasilkan kandungan yang tidak relevan, rekaan atau tidak konsisten. Satu teknik yang mungkin untuk menangani cabaran ini ialah Retrieval Augmented Generation (RAG). Ia melibatkan proses meningkatkan respons dengan merujuk pangkalan pengetahuan berwibawa di luar sumber data latihan untuk meningkatkan kualiti dan ketepatan penjanaan. Sistem RAG termasuk sistem mendapatkan semula untuk mendapatkan serpihan dokumen yang berkaitan daripada korpus

Pengoptimuman LLM menggunakan teknologi SPIN untuk latihan penalaan halus permainan sendiri

Jan 25, 2024 pm 12:21 PM

Pengoptimuman LLM menggunakan teknologi SPIN untuk latihan penalaan halus permainan sendiri

Jan 25, 2024 pm 12:21 PM

2024 ialah tahun pembangunan pesat untuk model bahasa besar (LLM). Dalam latihan LLM, kaedah penjajaran ialah cara teknikal yang penting, termasuk penyeliaan penalaan halus (SFT) dan pembelajaran pengukuhan dengan maklum balas manusia (RLHF) yang bergantung pada pilihan manusia. Kaedah ini telah memainkan peranan penting dalam pembangunan LLM, tetapi kaedah penjajaran memerlukan sejumlah besar data beranotasi secara manual. Menghadapi cabaran ini, penalaan halus telah menjadi bidang penyelidikan yang rancak, dengan para penyelidik giat berusaha untuk membangunkan kaedah yang boleh mengeksploitasi data manusia dengan berkesan. Oleh itu, pembangunan kaedah penjajaran akan menggalakkan lagi kejayaan dalam teknologi LLM. Universiti California baru-baru ini menjalankan kajian yang memperkenalkan teknologi baharu yang dipanggil SPIN (SelfPlayfInetuNing). S

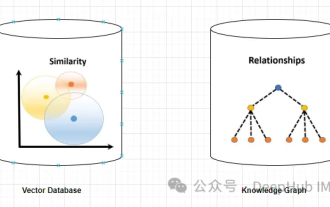

Menggunakan graf pengetahuan untuk meningkatkan keupayaan model RAG dan mengurangkan tanggapan palsu model besar

Jan 14, 2024 pm 06:30 PM

Menggunakan graf pengetahuan untuk meningkatkan keupayaan model RAG dan mengurangkan tanggapan palsu model besar

Jan 14, 2024 pm 06:30 PM

Halusinasi adalah masalah biasa apabila bekerja dengan model bahasa besar (LLM). Walaupun LLM boleh menjana teks yang lancar dan koheren, maklumat yang dijananya selalunya tidak tepat atau tidak konsisten. Untuk mengelakkan LLM daripada halusinasi, sumber pengetahuan luaran, seperti pangkalan data atau graf pengetahuan, boleh digunakan untuk memberikan maklumat fakta. Dengan cara ini, LLM boleh bergantung pada sumber data yang boleh dipercayai ini, menghasilkan kandungan teks yang lebih tepat dan boleh dipercayai. Pangkalan Data Vektor dan Graf Pengetahuan Pangkalan Data Vektor Pangkalan data vektor ialah satu set vektor berdimensi tinggi yang mewakili entiti atau konsep. Ia boleh digunakan untuk mengukur persamaan atau korelasi antara entiti atau konsep yang berbeza, dikira melalui perwakilan vektornya. Pangkalan data vektor boleh memberitahu anda, berdasarkan jarak vektor, bahawa "Paris" dan "Perancis" lebih dekat daripada "Paris" dan

RoSA: Kaedah baharu untuk penalaan halus parameter model besar yang cekap

Jan 18, 2024 pm 05:27 PM

RoSA: Kaedah baharu untuk penalaan halus parameter model besar yang cekap

Jan 18, 2024 pm 05:27 PM

Apabila model bahasa berskala ke skala yang belum pernah berlaku sebelum ini, penalaan halus menyeluruh untuk tugas hiliran menjadi sangat mahal. Bagi menyelesaikan masalah ini, penyelidik mula memberi perhatian dan mengamalkan kaedah PEFT. Idea utama kaedah PEFT adalah untuk mengehadkan skop penalaan halus kepada set kecil parameter untuk mengurangkan kos pengiraan sambil masih mencapai prestasi terkini dalam tugas pemahaman bahasa semula jadi. Dengan cara ini, penyelidik boleh menjimatkan sumber pengkomputeran sambil mengekalkan prestasi tinggi, membawa tempat tumpuan penyelidikan baharu ke bidang pemprosesan bahasa semula jadi. RoSA ialah teknik PEFT baharu yang, melalui eksperimen pada satu set penanda aras, didapati mengatasi prestasi penyesuaian peringkat rendah (LoRA) sebelumnya dan kaedah penalaan halus tulen yang jarang menggunakan belanjawan parameter yang sama. Artikel ini akan pergi secara mendalam

Penjelasan terperinci tentang GQA, mekanisme perhatian yang biasa digunakan dalam model besar, dan pelaksanaan kod Pytorch

Apr 03, 2024 pm 05:40 PM

Penjelasan terperinci tentang GQA, mekanisme perhatian yang biasa digunakan dalam model besar, dan pelaksanaan kod Pytorch

Apr 03, 2024 pm 05:40 PM

Perhatian Pertanyaan Berkumpulan (GroupedQueryAttention) ialah kaedah perhatian berbilang pertanyaan dalam model bahasa besar Matlamatnya adalah untuk mencapai kualiti MHA sambil mengekalkan kelajuan MQA. GroupedQueryAttention kumpulan pertanyaan, dan pertanyaan dalam setiap kumpulan berkongsi berat perhatian yang sama, yang membantu mengurangkan kerumitan pengiraan dan meningkatkan kelajuan inferens. Dalam artikel ini, kami akan menerangkan idea GQA dan cara menterjemahkannya ke dalam kod. GQA ada dalam kertas GQA:TrainingGeneralizedMulti-QueryTransformerModelsfromMulti-HeadCheckpoint

LLMLingua: Sepadukan LlamaIndex, mampatkan petunjuk dan menyediakan perkhidmatan inferens model bahasa besar yang cekap

Nov 27, 2023 pm 05:13 PM

LLMLingua: Sepadukan LlamaIndex, mampatkan petunjuk dan menyediakan perkhidmatan inferens model bahasa besar yang cekap

Nov 27, 2023 pm 05:13 PM

Kemunculan model bahasa besar (LLM) telah merangsang inovasi dalam pelbagai bidang. Walau bagaimanapun, peningkatan kerumitan gesaan, didorong oleh strategi seperti gesaan rantaian pemikiran (CoT) dan pembelajaran kontekstual (ICL), menimbulkan cabaran pengiraan. Gesaan yang panjang ini memerlukan sumber yang besar untuk membuat penaakulan dan oleh itu memerlukan penyelesaian yang cekap. Artikel ini akan memperkenalkan penyepaduan LLMLingua dan LlamaIndex proprietari untuk melaksanakan penaakulan yang cekap ialah kertas kerja yang diterbitkan oleh penyelidik Microsoft di EMNLP2023 LongLLMLingua ialah kaedah yang meningkatkan keupayaan llm untuk melihat maklumat penting dalam senario konteks yang panjang melalui pemampatan pantas. LLMLingua dan llamindex