Daripada mengambil laluan biasa Transformer, kami mengubah suai seni bina domestik baharu RNN RWKV dan membuat kemajuan baharu:

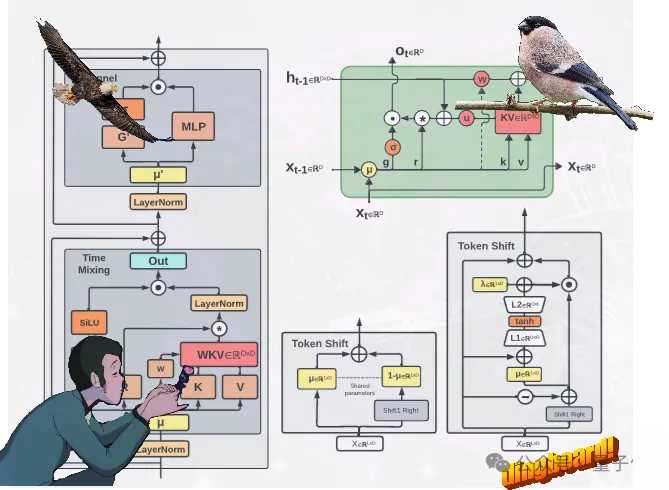

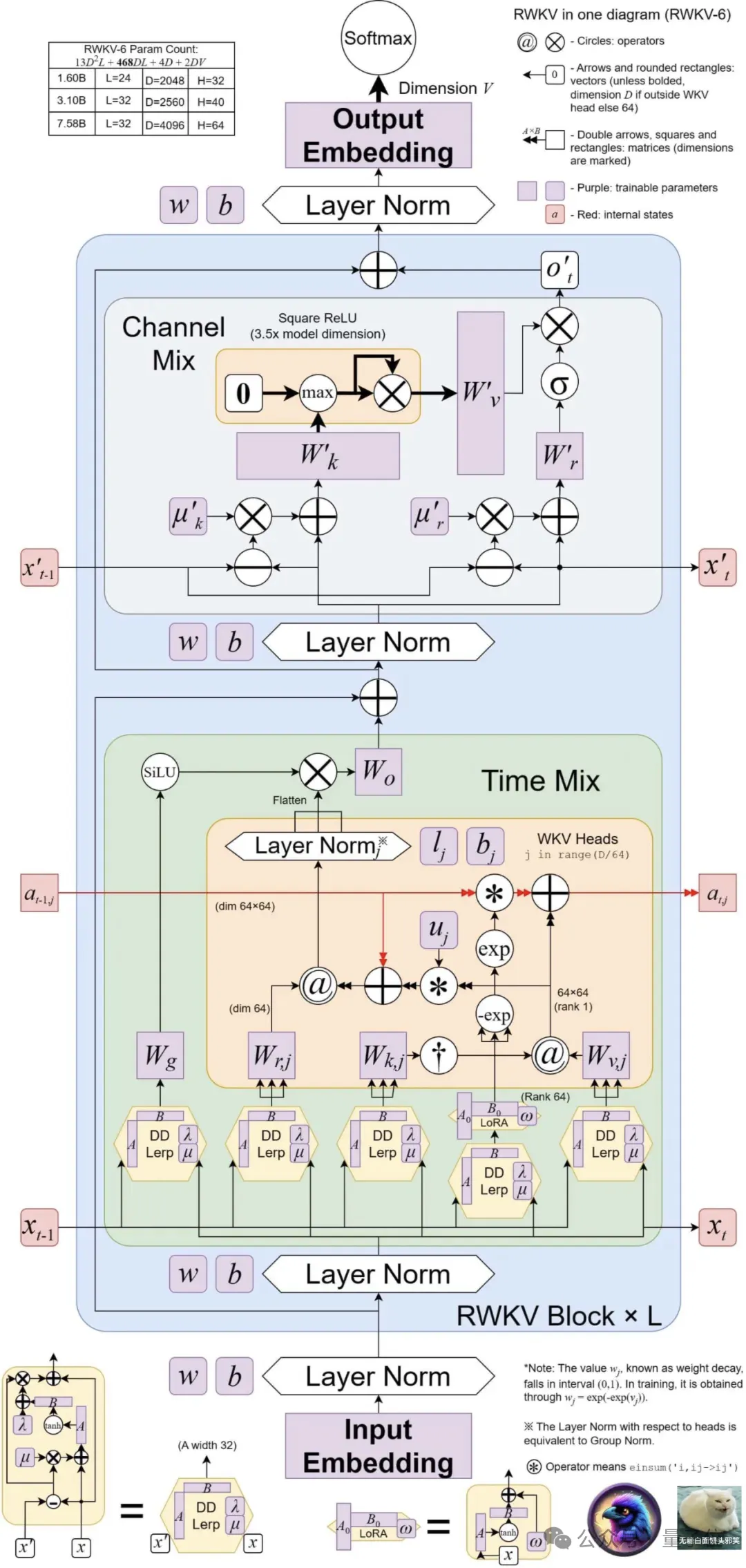

mencadangkan dua seni bina RWKV baharu, iaitu Eagle (RWKV-5)

RWKV-6). Dua model jujukan ini adalah berdasarkan seni bina RWKV-4 dan kemudian dipertingkatkan. Kemajuan reka bentuk dalam seni bina baharu termasuk keadaan bernilai matriks berbilang kepala(keadaan bernilai matriks berbilang kepala) dan

mekanisme pengulangan dinamik(mekanisme pengulangan dinamik)meningkatkan keupayaan ekspresif ini model RWKV, manakala Mengekalkan ciri kecekapan inferens RNN. Pada masa yang sama, seni bina baharu memperkenalkan korpus berbilang bahasa baharu yang mengandungi 1.12 trilion token.

Pasukan ini juga membangunkan tokenizer pantas berdasarkan padanan tamak

untuk meningkatkan kepelbagaian bahasa RWKV. Pada masa ini, 4 model Eagle dan 2 model Finch telah dikeluarkan pada Huo Hua Face~

Pada masa ini, 4 model Eagle dan 2 model Finch telah dikeluarkan pada Huo Hua Face~

RWKV yang dikemas kini ini mengandungi sejumlah 6 model iaitu : (RWKV-5)Model

: 0.4B, 1.5B, 3B, 7B saiz parameter masing-masing 2 Finch(RWKV-6)Model

: Saiz parameter masing-masing ialah 1.B6.

Eagle menambah baik seni bina dan pereputan pembelajaran yang dipelajari daripada RWKV-4 dengan menggunakan keadaan bernilai matriks berbilang kepala

(bukannya keadaan bernilai vektor), keadaan penerimaan yang distruktur semula dan jadual penerimaan tambahan. Finch meningkatkan lagi keupayaan prestasi dan fleksibiliti seni bina dengan memperkenalkan fungsi berkaitan data baharu

untuk modul pencampuran masa dan anjakan token, termasuk interpolasi linear berparameter.

Selain itu, Finch mencadangkan penggunaan baharu fungsi penyesuaian peringkat rendah untuk membolehkan matriks berat boleh dilatih untuk menambah vektor pereputan data yang dipelajari secara berkesan dalam cara yang sensitif konteks. Akhirnya, seni bina RWKV baharu memperkenalkan tokenizer baharu RWKV World Tokenizer, dan set data baharu

RWKV World v2, yang kedua-duanya digunakan untuk meningkatkan prestasi data RWKV dan pada model berbilang bahasa . Tokenizer baharu RWKV World Tokenizer mengandungi perkataan daripada bahasa luar biasa, dan melakukan tokenisasi pantas melalui padanan tamak berasaskan Trie

(padanan tamak).

Dataset baharu RWKV World v2 ialah set data token 1.12T berbilang bahasa baharu, diambil daripada pelbagai sumber data yang tersedia secara terbuka yang dipilih sendiri.

Apakah keputusan penanda aras?

Inovasi seni bina sahaja tidak mencukupi, kuncinya terletak pada prestasi sebenar model.

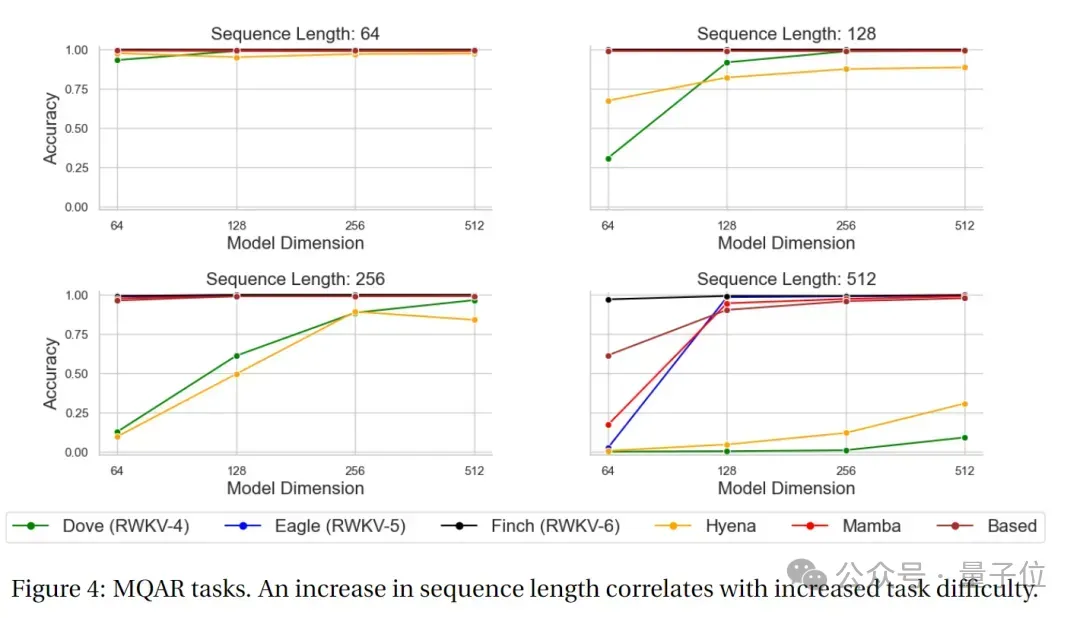

Keputusan ujian MQARMQAR

(Model Menilai Tugasan Berbilang Tugasan), direka untuk menguji keupayaan ingatan bersekutu model di bawah berbilang pertanyaan.

Dalam jenis tugasan ini, model perlu mendapatkan semula maklumat yang berkaitan diberikan berbilang pertanyaan.

Matlamat tugas MQAR adalah untuk mengukur keupayaan model untuk mendapatkan maklumat di bawah pelbagai pertanyaan, serta kebolehsuaian dan ketepatannya kepada pertanyaan yang berbeza.

Gambar di bawah menunjukkan keputusan ujian tugasan MQAR bagi seni bina bukan Transformer RWKV-4, Eagle, Finch dan lain-lain.

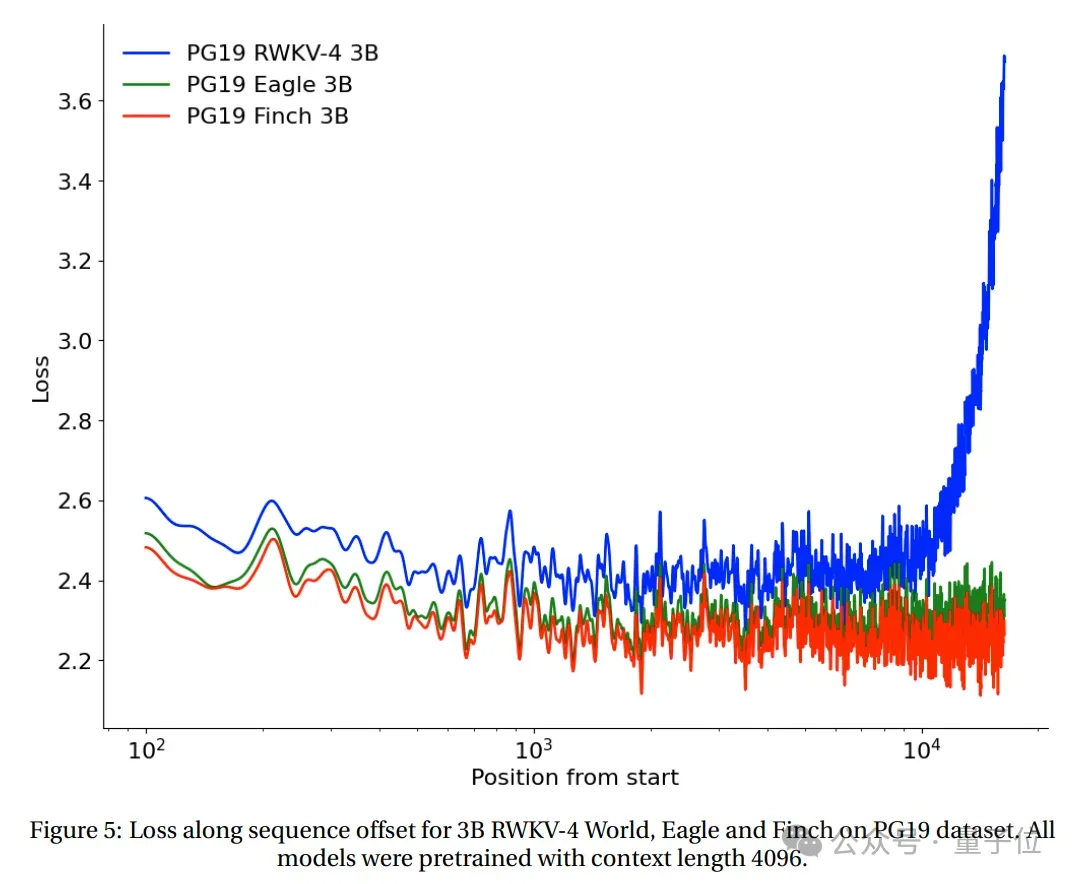

Eksperimen konteks panjang

Kedudukan kehilangan dan urutan RWKV-4, Eagle dan Finch bermula dari 2048 token telah diuji pada set ujian PG19.

(Semua model adalah pra-latihan berdasarkan panjang konteks 4096).

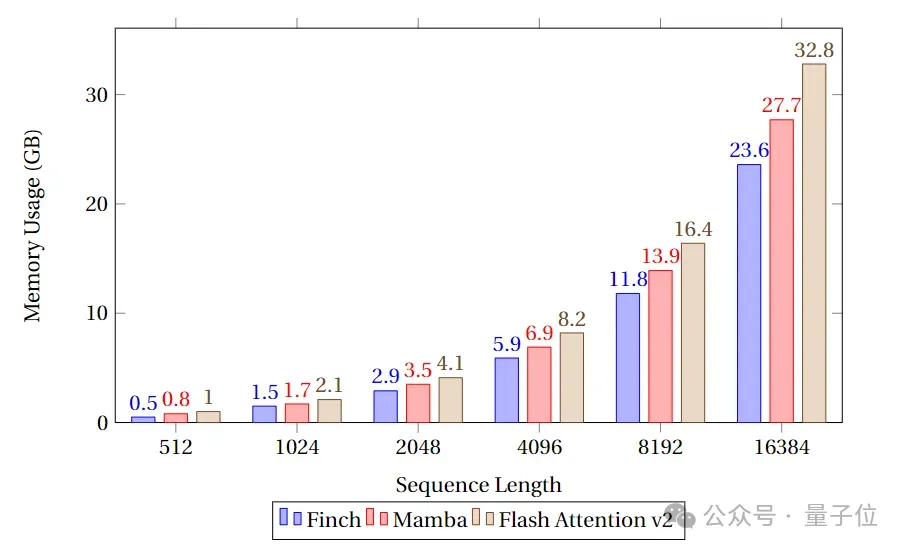

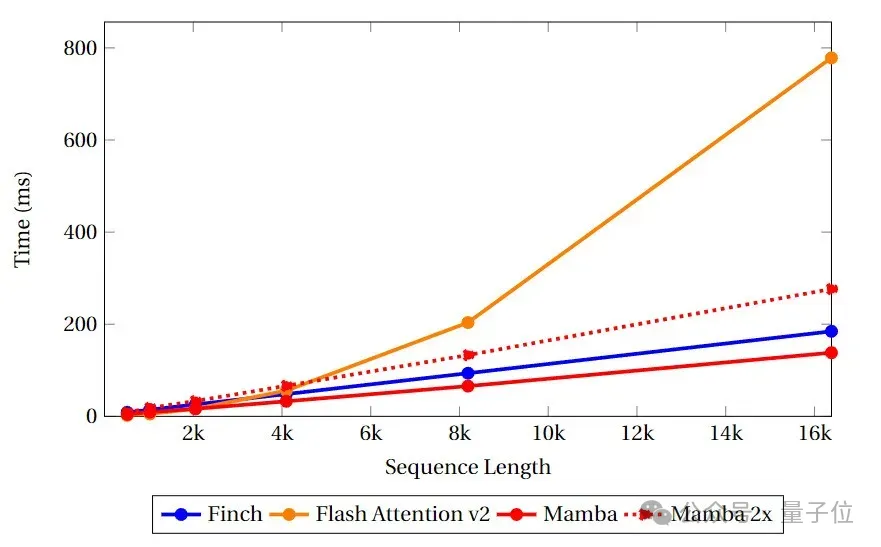

Tanda Aras Kelajuan dan Memori

🎜Dalam tanda aras kelajuan dan ingatan, pasukan membandingkan kelajuan dan penggunaan memori inti seperti Perhatian Finch, Mamba dan Flash Attention. 🎜

Dapat dilihat bahawa Finch sentiasa lebih baik daripada Mamba dan Flash Attention dari segi penggunaan memori, dan penggunaan memori masing-masing adalah 40% dan 17% kurang daripada Flash Attention dan Mamba.

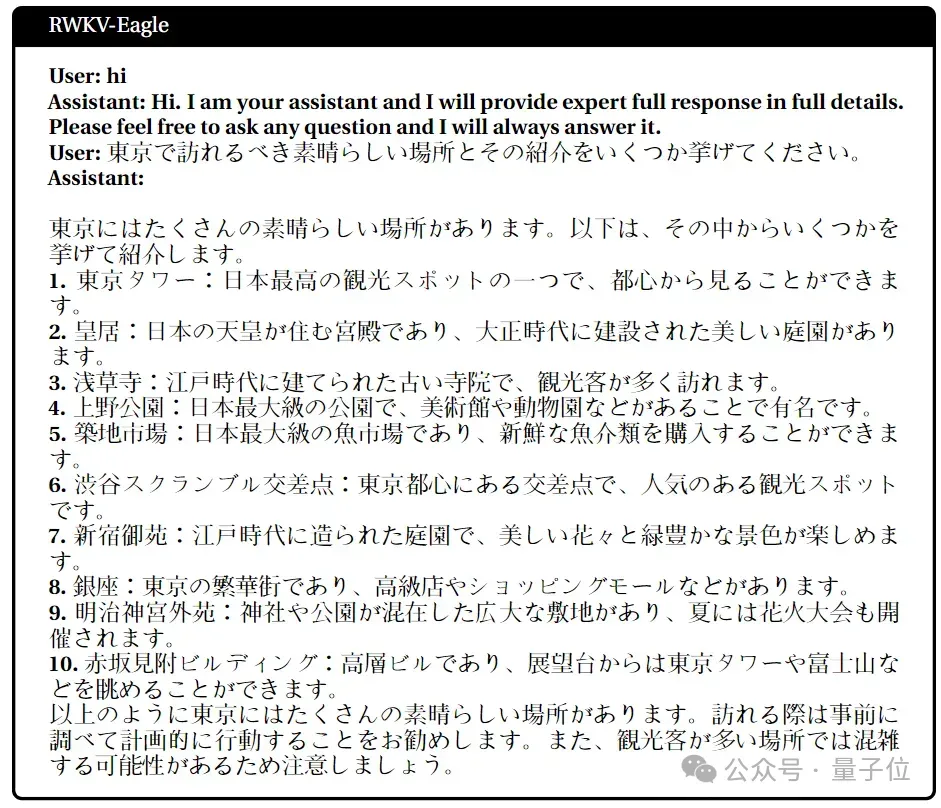

Japanese

Japanese

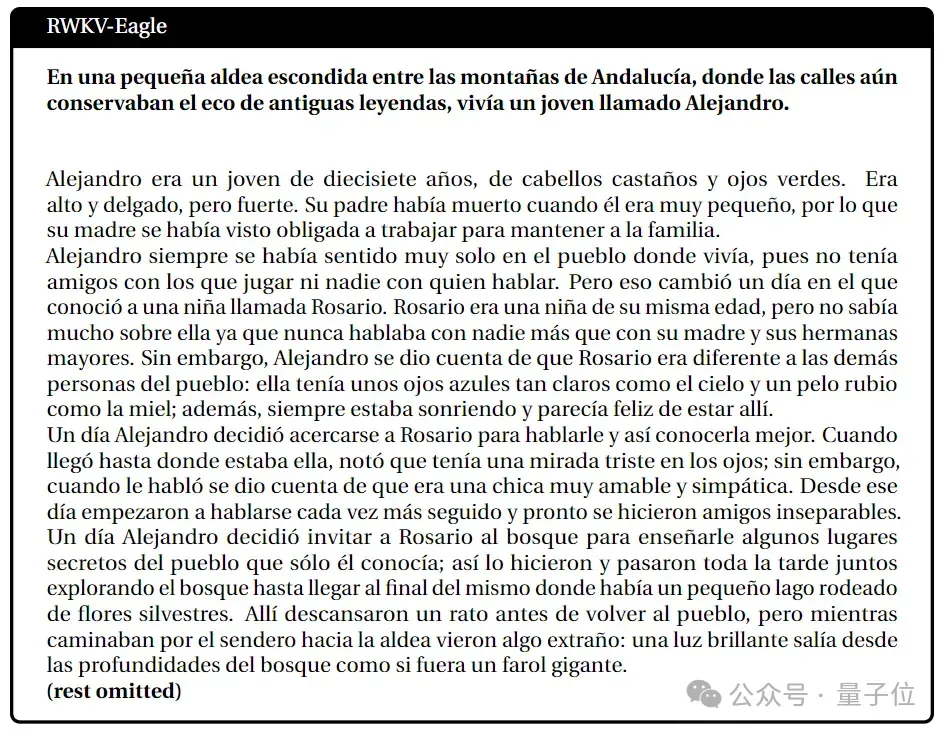

spanish

spanish

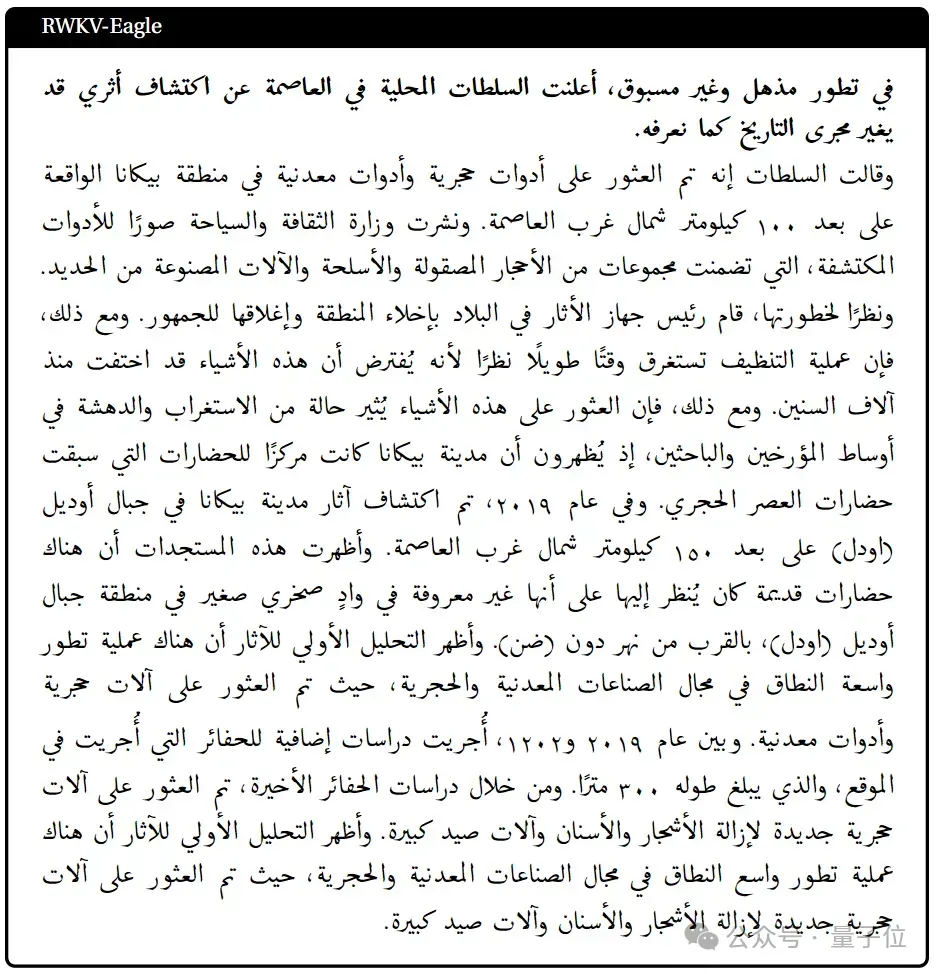

arabic

arabic

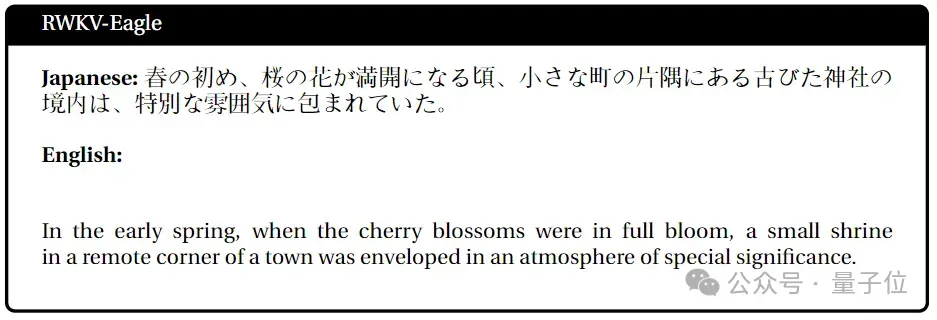

japanese-english

japanese-english

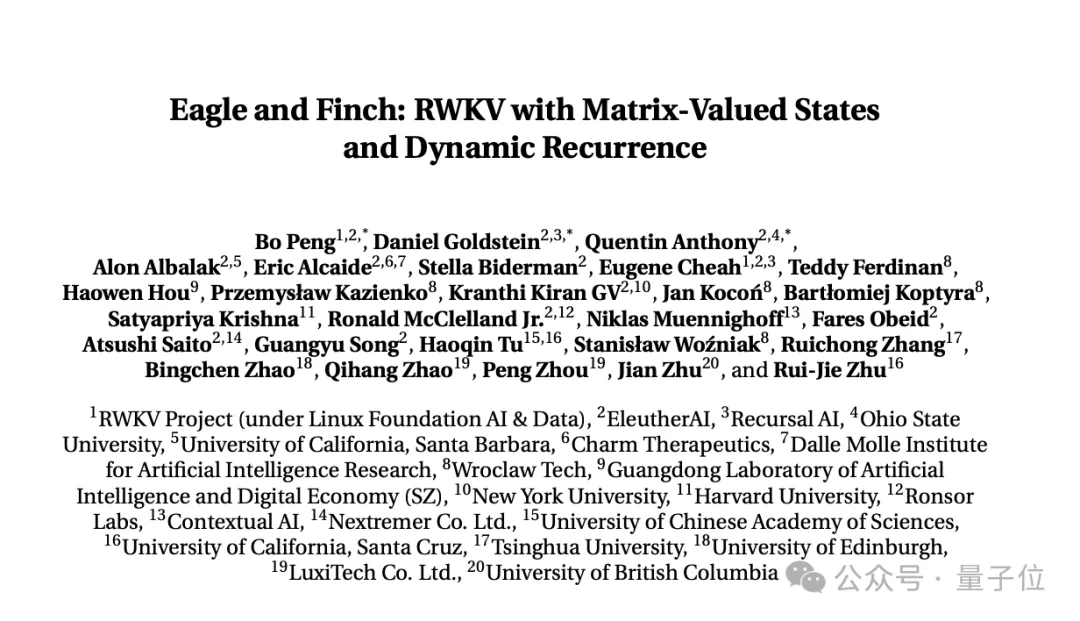

next workabove content penyelidikan, diterbitkan oleh RWKV Foundation The Paper terbaru

"Eagle and Finch: RWKV dengan Negeri Bernilai Matriks dan Ulangan Dinamik".

Kertas kerja itu disiapkan bersama oleh pengasas RWKV Bo PENG (Bloomberg)  dan ahli komuniti sumber terbuka RWKV.

dan ahli komuniti sumber terbuka RWKV.

co-pengarang Bloomberg, lulus dari

Hong Kong University-Jabatan Fizik, dengan 20+ tahun pengalaman pengaturcaraan. untuk dagangan kuantitatif frekuensi tinggi.

Juga menerbitkan buku tentang rangkaian konvolusi yang mendalam "Rangkaian Konvolusi Dalam · Prinsip dan Amalan".

Fokus dan minat utamanya terletak pada pembangunan perisian dan perkakasan dalam temu bual awam sebelum ini, dia telah menjelaskan bahawa AIGC adalah minatnya, terutamanya generasi novel.

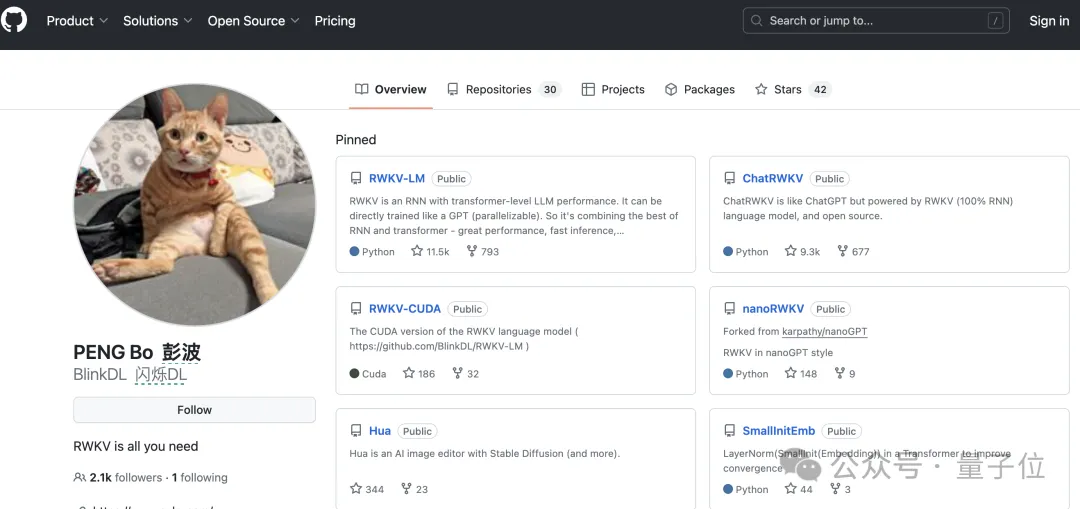

Pada masa ini, Bloomberg mempunyai 2.1k pengikut di Github.

Tetapi identiti awamnya yang paling penting ialah pengasas bersama syarikat pencahayaan, Xinlin Technology, yang kebanyakannya membuat lampu matahari, lampu siling, lampu meja mudah alih dan sebagainya.

Dan dia sepatutnya menjadi pencinta kucing senior Terdapat kucing oren pada avatar Github, Zhihu dan WeChat, serta pada laman web rasmi syarikat pencahayaan dan Weibo.

Qubit mengetahui bahawa kerja berbilang modal semasa RWKV termasuk RWKV Music (arah muzik) dan VisualRWKV

(arah imej).

Pautan kertas:

https://arxiv.org/pdf/2404.05892.pdf

Atas ialah kandungan terperinci Cabaran RNN yang diubah suai secara ajaib Transformer, RWKV adalah baharu: melancarkan dua model seni bina baharu. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!