Peranti teknologi

Peranti teknologi

AI

AI

Dalam beberapa jam selepas dikeluarkan, Microsoft memadamkan model sumber terbuka yang besar setanding dengan GPT-4 dalam beberapa saat! Terlupa mengambil ujian racun

Dalam beberapa jam selepas dikeluarkan, Microsoft memadamkan model sumber terbuka yang besar setanding dengan GPT-4 dalam beberapa saat! Terlupa mengambil ujian racun

Dalam beberapa jam selepas dikeluarkan, Microsoft memadamkan model sumber terbuka yang besar setanding dengan GPT-4 dalam beberapa saat! Terlupa mengambil ujian racun

Minggu lepas, Microsoft melancarkan model sumber terbuka yang dipanggil WizardLM-2 yang boleh dipanggil tahap GPT-4.

Tanpa disangka, ia dipadamkan serta-merta beberapa jam selepas ia disiarkan.

Sesetengah netizen tiba-tiba mendapati bahawa berat model WizardLM dan siaran pengumuman semuanya telah dipadamkan dan tidak lagi berada dalam koleksi Microsoft Selain daripada sebutan tapak, tiada bukti boleh ditemui untuk membuktikan projek rasmi Microsoft ini.

Laman utama projek GitHub telah menjadi 404.

Alamat projek: https://wizardlm.github.io/

Termasuk berat model pada HF, semuanya hilang...

Keseluruhan rangkaian

Keseluruhan rangkaian

penuh kekeliruan, mengapa WizardLM hilang?

Tetapi, Microsoft melakukan ini kerana pasukan terlupa untuk "menguji" model tersebut.

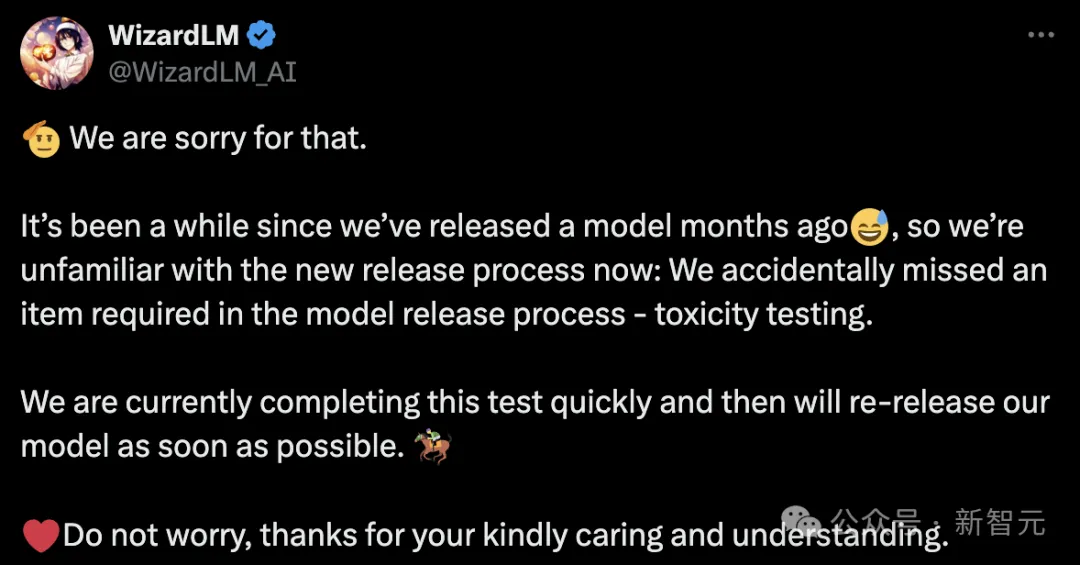

Kemudian, pasukan Microsoft muncul untuk memohon maaf dan menjelaskan bahawa sudah agak lama sejak WizardLM dikeluarkan beberapa bulan yang lalu, jadi kami tidak biasa dengan proses keluaran baharu sekarang.

Kami secara tidak sengaja terlepas salah satu perkara yang diperlukan dalam proses keluaran model: ujian keracunan

Microsoft WizardLM dinaik taraf kepada generasi kedua telah dipertingkatkan kepada generasi kedua

berdasarkan LlaMA Sebaik sahaja generasi pertama WizardLM dikeluarkan, ia menarik banyak perhatian daripada komuniti sumber terbuka.

Alamat kertas: https://arxiv.org/pdf/2304.12244.pdf

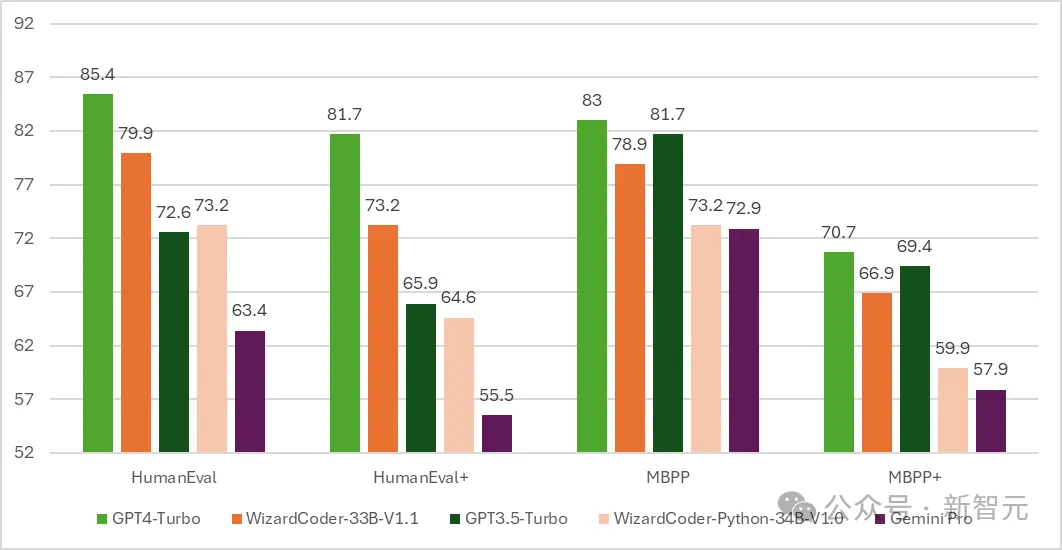

Seterusnya, versi kod WizardCoder telah dilahirkan - model berdasarkan Kod Llama yang diselaraskan dengan baik Mengarahkan.

Hasil ujian menunjukkan bahawa pas WizardCoder@1 pada HumanEval mencapai 73.2% yang menakjubkan, mengatasi GPT-4 yang asal.

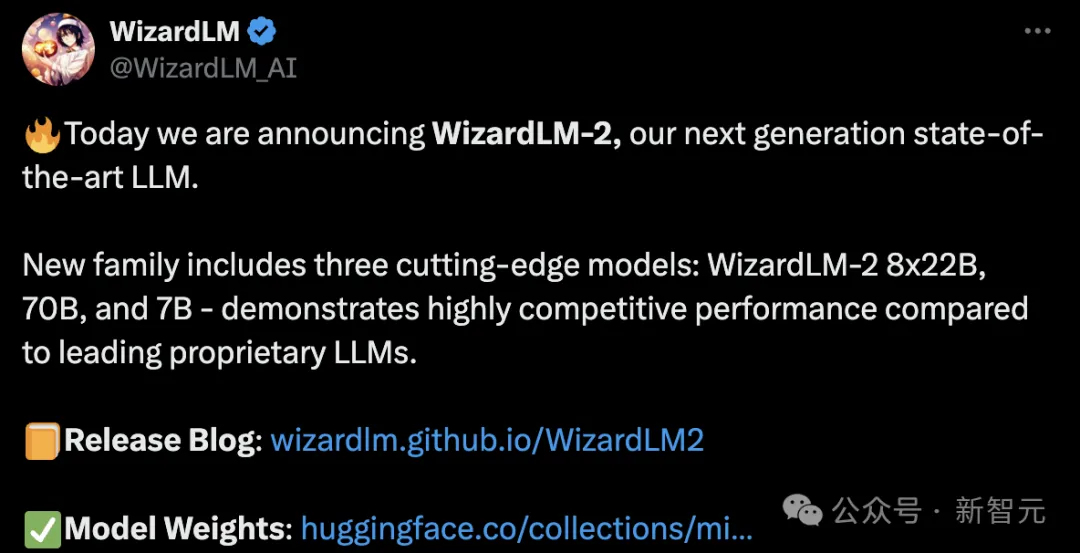

Memandangkan masa berlalu ke 15 April, pembangun Microsoft secara rasmi mengumumkan generasi baharu WizardLM, kali ini ia diperhalusi daripada Mixtral 8x22B.

Ia mengandungi tiga versi parameter iaitu 8x22B, 70B dan 7B.

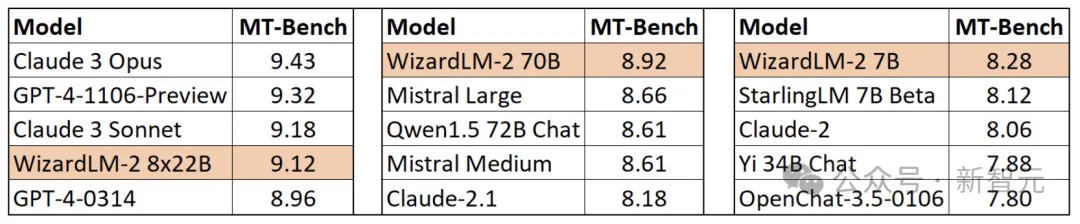

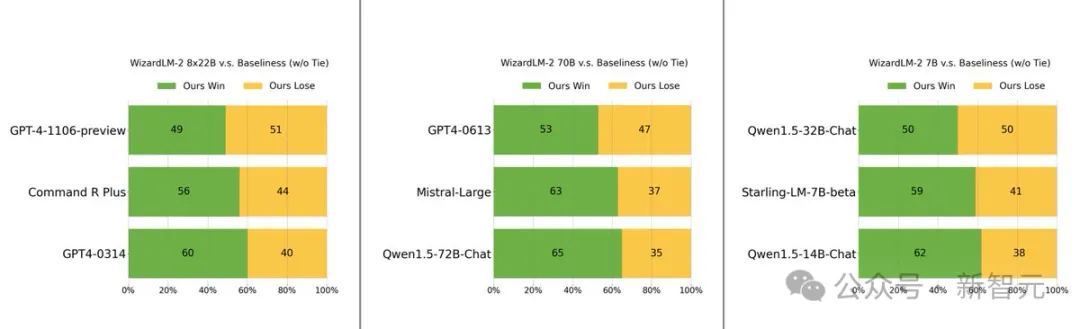

Yang paling patut disebut ialah dalam ujian penanda aras MT-Bench, model baharu itu mencapai kelebihan utama.

Secara khusus, prestasi versi parameter terbesar model WizardLM 8x22B hampir hampir dengan GPT-4 dan Claude 3.

Di bawah skala parameter yang sama, versi 70B berada di kedudukan pertama.

Versi 7B adalah yang terpantas malah boleh mencapai prestasi yang setara dengan model terkemuka dengan skala parameter yang 10 kali lebih besar.

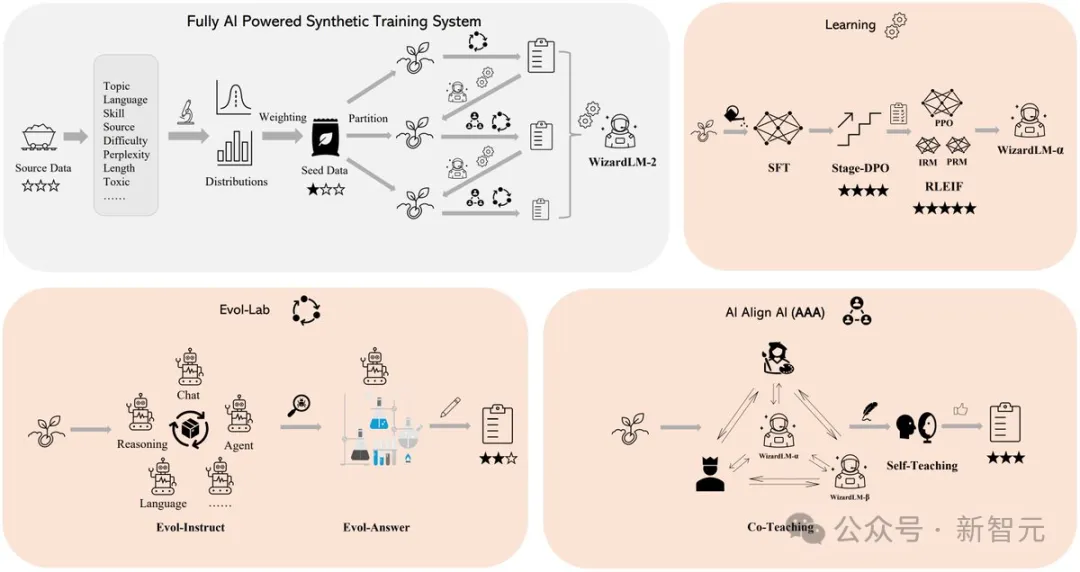

Rahsia di sebalik prestasi cemerlang WizardLM 2 terletak pada metodologi latihan revolusioner Evol-Instruct yang dibangunkan oleh Microsoft.

Evol-Instruct memanfaatkan model bahasa yang besar untuk menulis semula set arahan awal secara berulang ke dalam varian yang semakin kompleks. Data arahan yang berkembang ini kemudiannya digunakan untuk memperhalusi model asas, dengan ketara meningkatkan keupayaannya untuk mengendalikan tugas yang kompleks.

Yang lain ialah rangka kerja pembelajaran pengukuhan RLEIF, yang juga memainkan peranan penting dalam proses pembangunan WizardLM 2.

Dalam latihan WizardLM 2, kaedah AI Align AI (AAA) juga diguna pakai, yang membolehkan berbilang model besar terkemuka untuk membimbing dan menambah baik satu sama lain.

Rangka kerja AAA terdiri daripada dua komponen utama iaitu "co-teaching" dan "self-study".

Mengajar bersama peringkat ini, WizardLM dan pelbagai model lanjutan sumber terbuka dan proprietari berlesen menjalankan sembang simulasi, pertimbangan kualiti, cadangan untuk penambahbaikan dan menutup jurang kemahiran.

Dengan berkomunikasi antara satu sama lain dan memberikan maklum balas, model boleh belajar daripada rakan sebaya mereka dan meningkatkan keupayaan mereka.

Untuk pembelajaran kendiri, WizardLM boleh menjana data latihan evolusi baharu untuk pembelajaran diselia dan data keutamaan untuk pembelajaran pengukuhan melalui pembelajaran kendiri aktif.

Mekanisme pembelajaran kendiri ini membolehkan model meningkatkan prestasi secara berterusan dengan belajar daripada data dan maklumat maklum balas yang dijana sendiri.

Selain itu, model WizardLM 2 telah dilatih menggunakan data sintetik yang dihasilkan.

Pada pandangan penyelidik, data latihan untuk model besar semakin berkurangan, dan dipercayai bahawa data yang dicipta dengan teliti oleh AI dan model yang diselia secara beransur-ansur oleh AI akan menjadi satu-satunya cara untuk mendapatkan kecerdasan buatan yang lebih berkuasa.

Jadi mereka mencipta sistem latihan sintetik dipacu AI sepenuhnya untuk menambah baik WizardLM-2. .

Sebelum model itu dialih keluar, beberapa pengguna turut mengujinya pada beberapa penanda aras tambahan.

Sebelum model itu dialih keluar, beberapa pengguna turut mengujinya pada beberapa penanda aras tambahan.

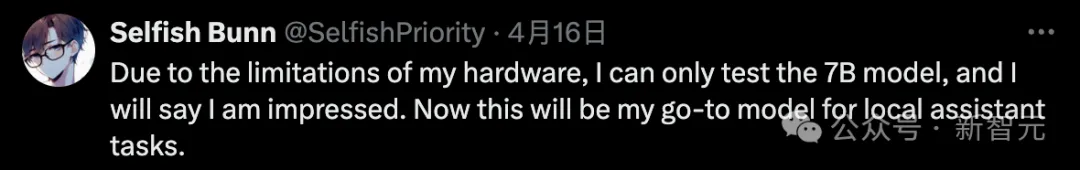

Nasib baik netizen yang mengujinya kagum dengan model 7B dan berkata ia akan menjadi pilihan pertama mereka untuk melaksanakan tugas pembantu tempatan.

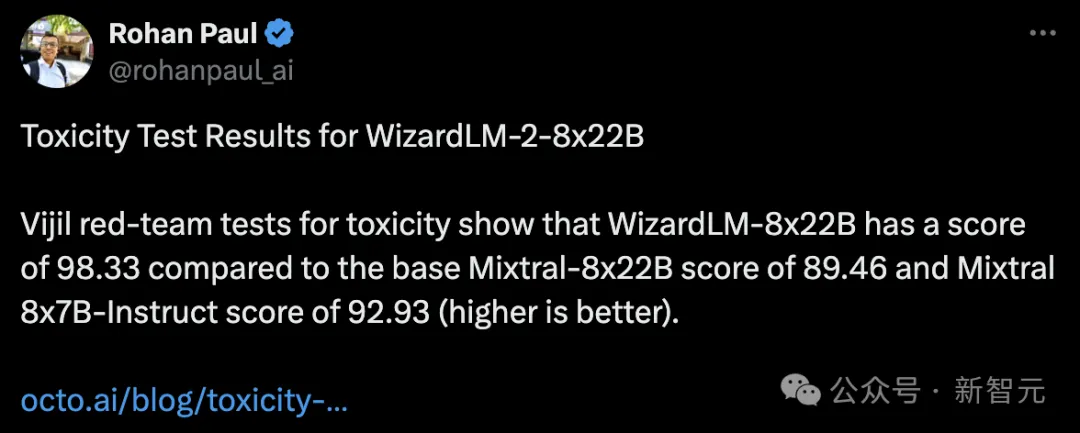

Seseorang juga melakukan ujian racun ke atasnya dan mendapati WizardLM-8x22B mendapat 98.33, manakala asas Mixtral-8x22B mendapat 89.46, dan Mixtral 8x7B-Indict93 mendapat markah.

Semakin tinggi markah, lebih baik, bermakna WizardLM-8x22B masih sangat kuat.

Jika tiada ujian keracunan, adalah mustahil untuk menghantar model tersebut.

Semua orang tahu bahawa model besar mudah mengalami halusinasi.

Jika WizardLM 2 mengeluarkan kandungan "toksik, berat sebelah dan tidak betul" dalam jawapan, ia tidak akan mesra kepada model besar.

Jika WizardLM 2 mengeluarkan kandungan "toksik, berat sebelah dan tidak betul" dalam jawapan, ia tidak akan mesra kepada model besar.

Secara khususnya, ralat ini telah menarik perhatian seluruh rangkaian, dan juga akan menyebabkan kritikan terhadap Microsoft sendiri, malah mungkin akan disiasat oleh pihak berkuasa.

Sesetengah netizen keliru dan mengatakan bahawa anda boleh mengemas kini penunjuk melalui "ujian keracunan". Mengapa memadamkan keseluruhan repositori dan berat?

Pengarang Microsoft menyatakan bahawa mengikut peraturan dalaman terkini, ini hanya boleh dilakukan.

Ada juga yang kata kita nak model tanpa "lobotomi".

Walau bagaimanapun, pembangun masih perlu menunggu dengan sabar, dan pasukan Microsoft berjanji bahawa ia akan kembali dalam talian selepas ujian selesai.

Atas ialah kandungan terperinci Dalam beberapa jam selepas dikeluarkan, Microsoft memadamkan model sumber terbuka yang besar setanding dengan GPT-4 dalam beberapa saat! Terlupa mengambil ujian racun. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1377

1377

52

52

Cara Menjalankan Projek H5

Apr 06, 2025 pm 12:21 PM

Cara Menjalankan Projek H5

Apr 06, 2025 pm 12:21 PM

Menjalankan projek H5 memerlukan langkah -langkah berikut: memasang alat yang diperlukan seperti pelayan web, node.js, alat pembangunan, dan lain -lain. Membina persekitaran pembangunan, membuat folder projek, memulakan projek, dan menulis kod. Mulakan pelayan pembangunan dan jalankan arahan menggunakan baris arahan. Pratonton projek dalam penyemak imbas anda dan masukkan URL Server Pembangunan. Menerbitkan projek, mengoptimumkan kod, menggunakan projek, dan menyediakan konfigurasi pelayan web.

GITEE PAGES PENYEDIAAN LAMAN WEB STATIC Gagal: Bagaimana menyelesaikan masalah dan menyelesaikan kesilapan fail tunggal 404?

Apr 04, 2025 pm 11:54 PM

GITEE PAGES PENYEDIAAN LAMAN WEB STATIC Gagal: Bagaimana menyelesaikan masalah dan menyelesaikan kesilapan fail tunggal 404?

Apr 04, 2025 pm 11:54 PM

Giteepages Statik Laman Web Penggunaan Gagal: 404 Penyelesaian Masalah dan Resolusi Ralat Semasa Menggunakan Gitee ...

Bagaimana cara menentukan pangkalan data yang berkaitan dengan model dalam beego orm?

Apr 02, 2025 pm 03:54 PM

Bagaimana cara menentukan pangkalan data yang berkaitan dengan model dalam beego orm?

Apr 02, 2025 pm 03:54 PM

Di bawah rangka kerja beegoorm, bagaimana untuk menentukan pangkalan data yang berkaitan dengan model? Banyak projek beego memerlukan pelbagai pangkalan data untuk dikendalikan secara serentak. Semasa menggunakan beego ...

Perpustakaan mana yang dibangunkan oleh syarikat besar atau disediakan oleh projek sumber terbuka yang terkenal?

Apr 02, 2025 pm 04:12 PM

Perpustakaan mana yang dibangunkan oleh syarikat besar atau disediakan oleh projek sumber terbuka yang terkenal?

Apr 02, 2025 pm 04:12 PM

Perpustakaan mana yang dibangunkan oleh syarikat besar atau projek sumber terbuka yang terkenal? Semasa pengaturcaraan di GO, pemaju sering menghadapi beberapa keperluan biasa, ...

Bagaimana menyelesaikan masalah penukaran jenis user_id semasa menggunakan aliran redis untuk melaksanakan beratur mesej dalam bahasa Go?

Apr 02, 2025 pm 04:54 PM

Bagaimana menyelesaikan masalah penukaran jenis user_id semasa menggunakan aliran redis untuk melaksanakan beratur mesej dalam bahasa Go?

Apr 02, 2025 pm 04:54 PM

Masalah menggunakan redisstream untuk melaksanakan beratur mesej dalam bahasa Go menggunakan bahasa Go dan redis ...

Adakah pengeluaran halaman H5 memerlukan penyelenggaraan berterusan?

Apr 05, 2025 pm 11:27 PM

Adakah pengeluaran halaman H5 memerlukan penyelenggaraan berterusan?

Apr 05, 2025 pm 11:27 PM

Halaman H5 perlu dikekalkan secara berterusan, kerana faktor -faktor seperti kelemahan kod, keserasian pelayar, pengoptimuman prestasi, kemas kini keselamatan dan peningkatan pengalaman pengguna. Kaedah penyelenggaraan yang berkesan termasuk mewujudkan sistem ujian lengkap, menggunakan alat kawalan versi, kerap memantau prestasi halaman, mengumpul maklum balas pengguna dan merumuskan pelan penyelenggaraan.

Bagaimana untuk mengimport pakej tersuai dengan betul di bawah modul GO?

Apr 02, 2025 pm 03:42 PM

Bagaimana untuk mengimport pakej tersuai dengan betul di bawah modul GO?

Apr 02, 2025 pm 03:42 PM

Dalam pembangunan bahasa Go, dengan betul memperkenalkan pakej tersuai adalah langkah penting. Artikel ini akan menyasarkan "Golang ...

Dalam pengaturcaraan GO, bagaimana untuk menguruskan sambungan dan melepaskan sumber antara MySQL dan Redis dengan betul?

Apr 02, 2025 pm 05:03 PM

Dalam pengaturcaraan GO, bagaimana untuk menguruskan sambungan dan melepaskan sumber antara MySQL dan Redis dengan betul?

Apr 02, 2025 pm 05:03 PM

Pengurusan Sumber dalam Pemrograman GO: MySQL dan Redis Connect dan Lepaskan dalam Pembelajaran Cara Mengurus Sumber Sumber dengan betul, terutamanya dengan pangkalan data dan cache ...