Peranti teknologi

Peranti teknologi

AI

AI

Docker melengkapkan penggunaan tempatan model besar sumber terbuka LLama3 dalam masa tiga minit

Docker melengkapkan penggunaan tempatan model besar sumber terbuka LLama3 dalam masa tiga minit

Docker melengkapkan penggunaan tempatan model besar sumber terbuka LLama3 dalam masa tiga minit

Gambaran Keseluruhan

LLaMA-3 (Model Bahasa Besar Meta AI 3) ialah model kecerdasan buatan generatif sumber terbuka berskala besar yang dibangunkan oleh Syarikat Meta. Ia tidak mempunyai perubahan besar dalam struktur model berbanding LLaMA-2 generasi sebelumnya.

Model LLaMA-3 dibahagikan kepada versi skala yang berbeza, termasuk kecil, sederhana dan besar, untuk menyesuaikan diri dengan keperluan aplikasi dan sumber pengkomputeran yang berbeza. Saiz parameter model kecil ialah 8B, saiz parameter model sederhana ialah 70B, dan saiz parameter model besar mencapai 400B. Walau bagaimanapun, semasa latihan, matlamatnya adalah untuk mencapai kefungsian berbilang modal dan berbilang bahasa, dan hasilnya dijangka setanding dengan GPT 4/GPT 4V.

Pasang Ollama

Ollama ialah alat perkhidmatan model bahasa besar (LLM) sumber terbuka yang membolehkan pengguna menjalankan dan menggunakan model bahasa besar pada mesin tempatan mereka. Ollama direka bentuk sebagai rangka kerja yang memudahkan proses mengatur dan mengurus model bahasa besar dalam bekas Docker, menjadikan proses itu cepat dan mudah. Pengguna boleh menjalankan model bahasa berskala besar sumber terbuka dengan cepat seperti Llama 3 secara tempatan melalui operasi baris arahan yang mudah.

Alamat tapak web rasmi: https://ollama.com/download

Pictures

Pictures

Ollama ialah alat yang menyokong berbilang platform, termasuk Mac dan Linux, dan menyediakan imej Docker untuk memudahkan proses pemasangan. Pengguna boleh mengimport dan menyesuaikan lebih banyak model dengan menulis Modelfile, yang serupa dengan peranan Dockerfile. Ollama juga menampilkan API REST untuk menjalankan dan mengurus model, dan set alat baris perintah untuk interaksi model.

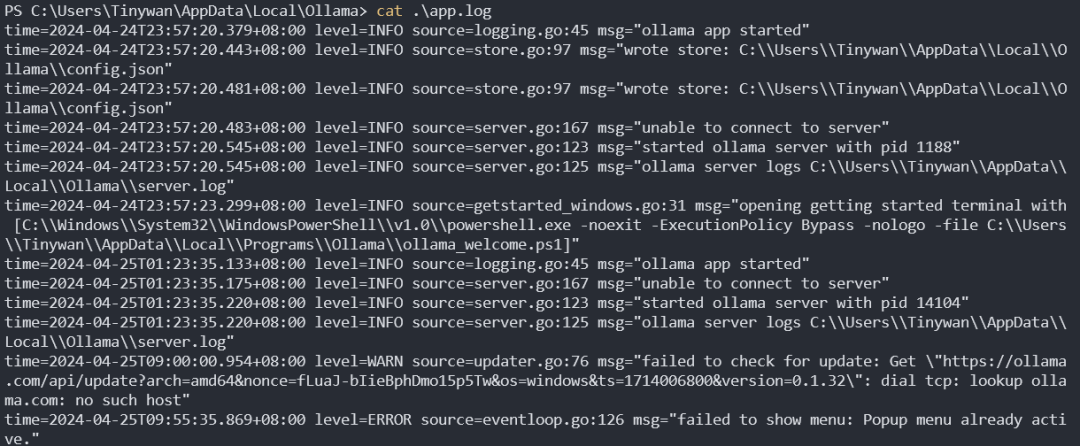

Log permulaan perkhidmatan Ollama

Gambar

Gambar

Pengurusan model

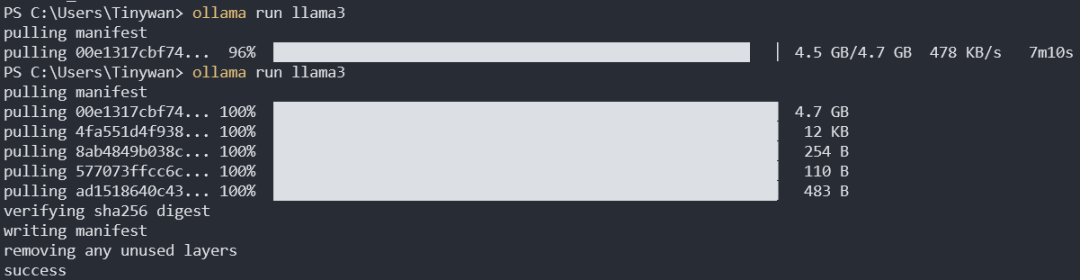

Muat turun model

ollama pull llama3:8b

Muat turun lalai ialah llama3:8b. Titik bertindih sebelum titik bertindih di sini mewakili nama model, dan bertindih bertindih selepas tag mewakili tag Anda boleh melihat semua tag llama3 dari sini

gambar

gambar

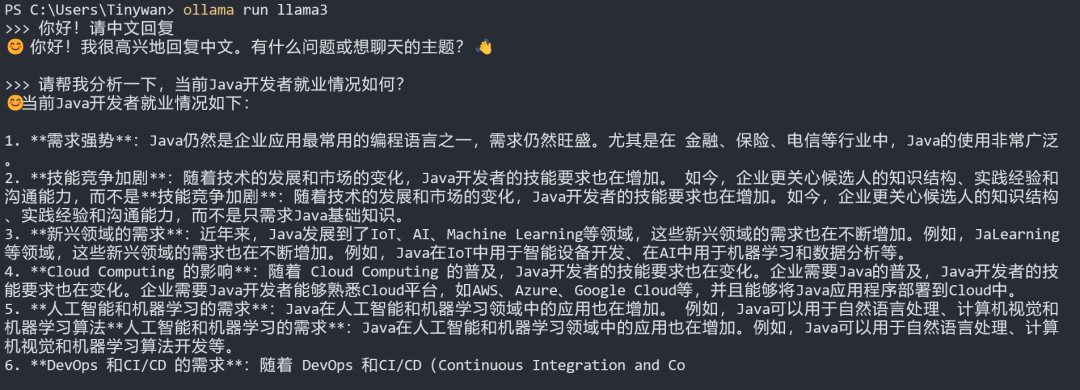

pengujian model

Nota: Jika anda mahu model itu. balas dalam bahasa Cina, sila masukkan dahulu: Hello! Sila balas dalam bahasa Cina

gambar

gambar

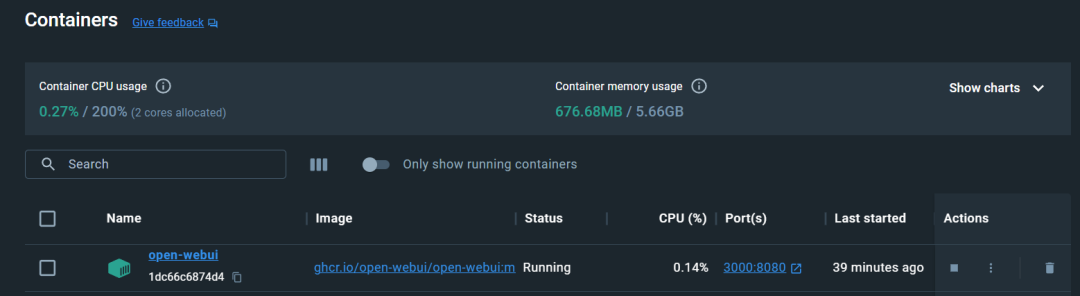

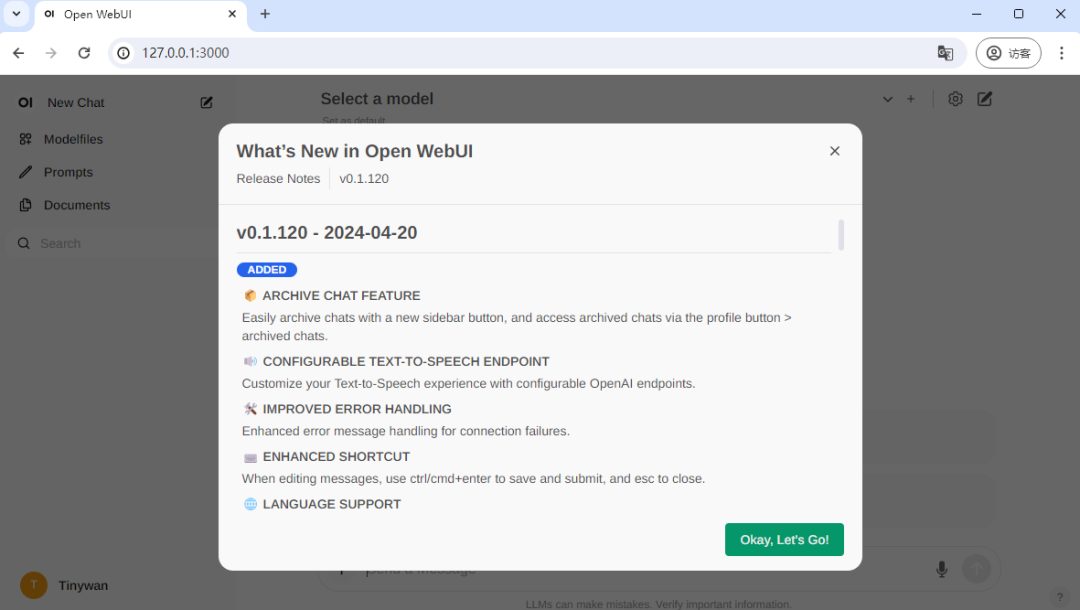

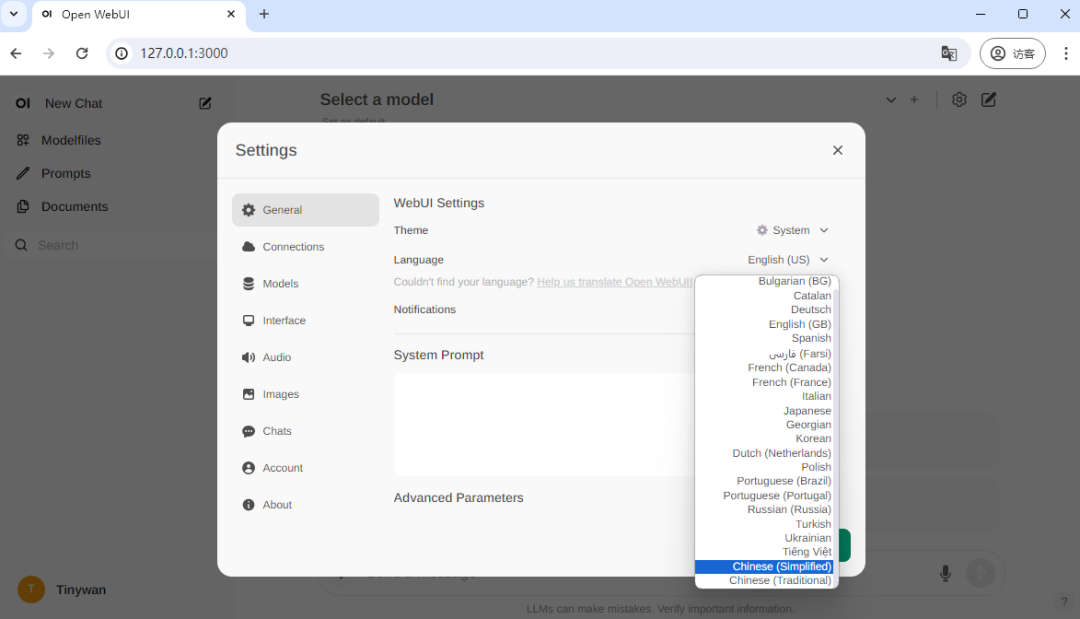

Konfigurasikan Open-WebUI

Jalankan di bawah CPU

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

gambar

gambar

gambar

Gambar

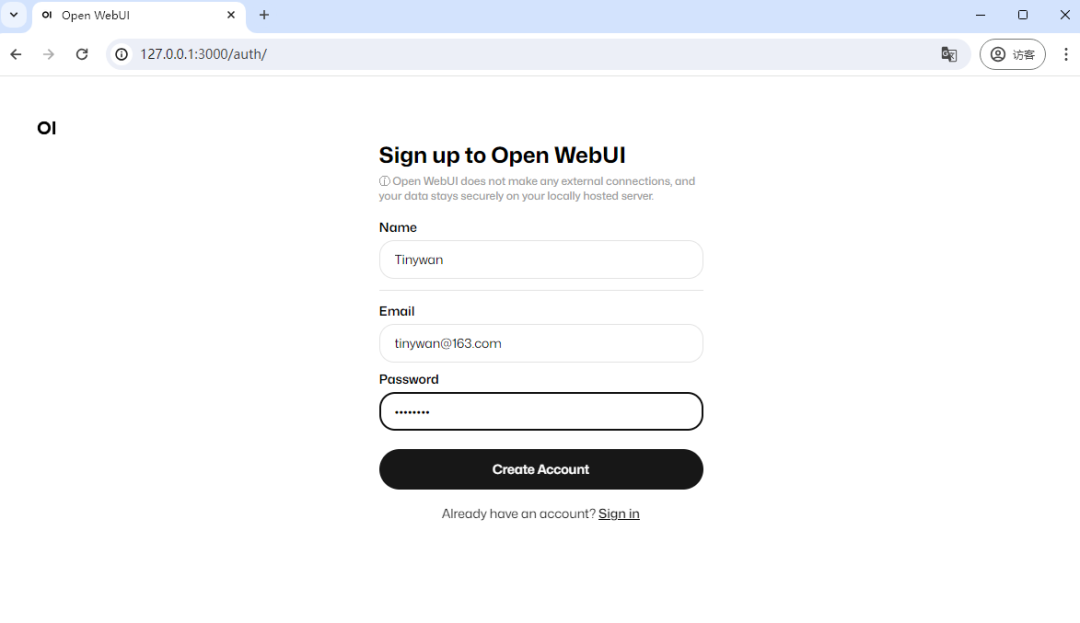

Anda perlu daftar untuk lawatan pertama, di sini saya daftar akaun, pendaftaran selesai dan login berjaya

Anda perlu daftar untuk lawatan pertama, di sini saya daftar akaun, pendaftaran selesai dan login berjaya

Gambar

Gambar

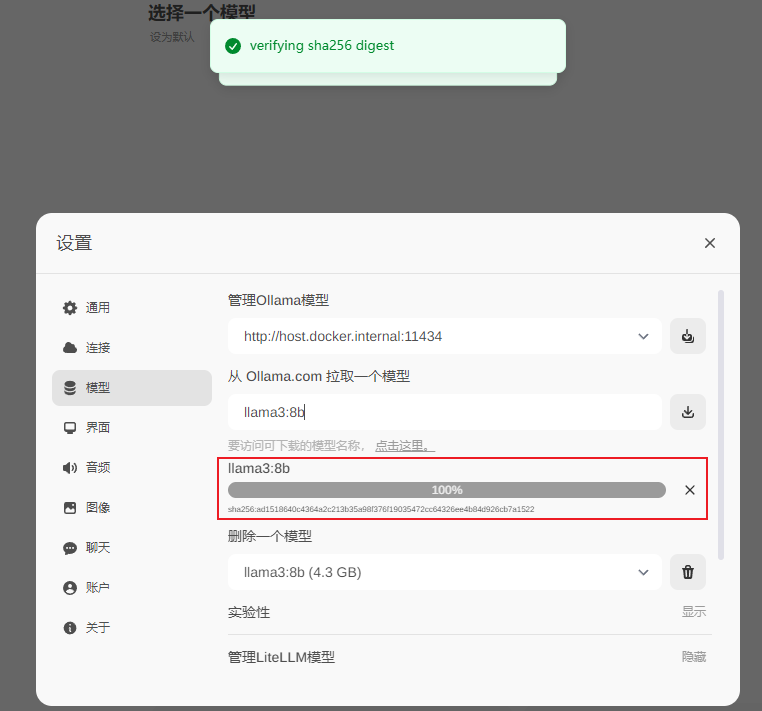

llama3:8b

gambar

gambar

Muat turun selesai

gambar

gambar

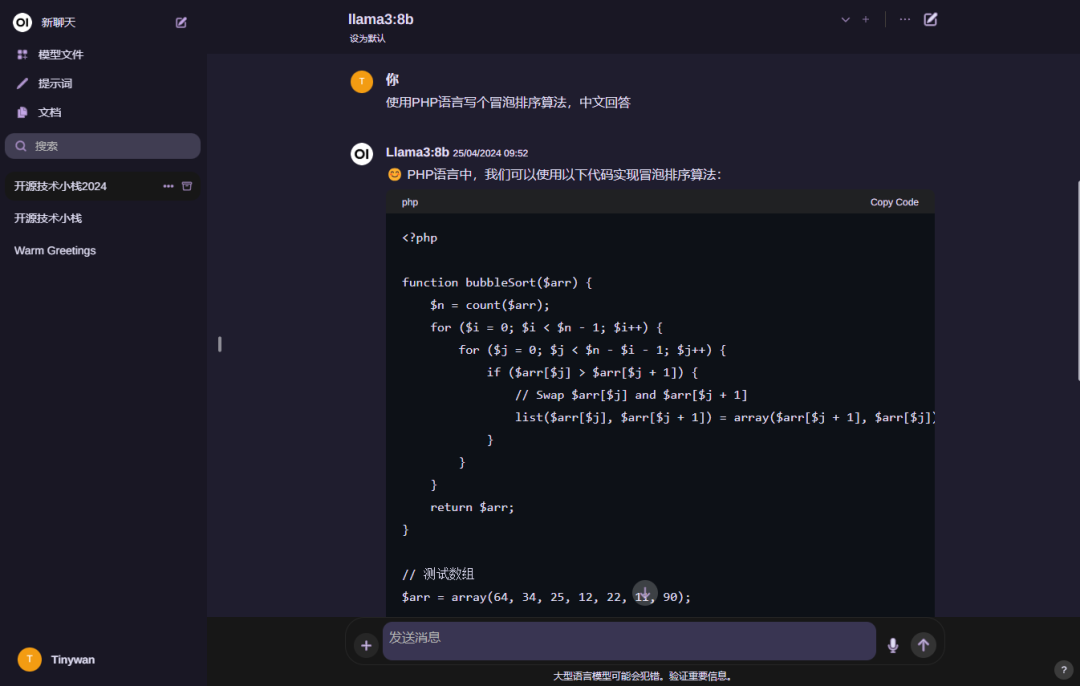

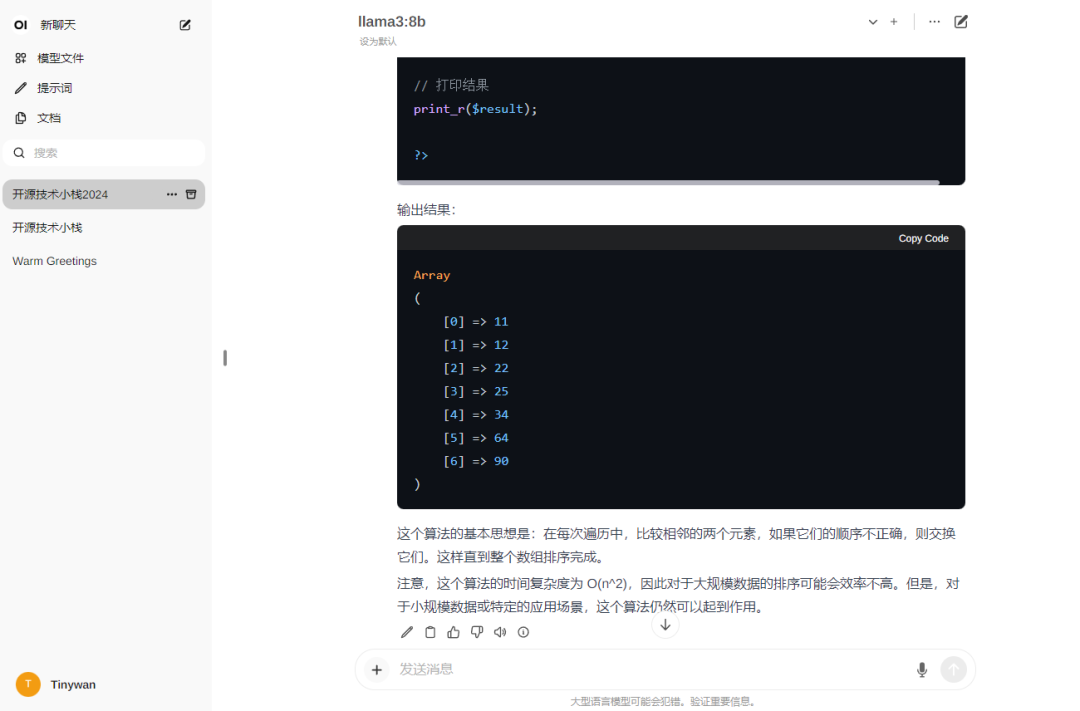

Gunakan

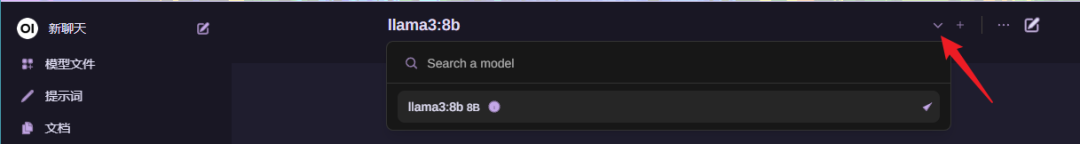

Pilih model

gambar anda

gambar anda

gambar

gambar

Nota: Jika anda mahu model membalas dalam bahasa Cina, Sila masukkan dahulu: Hello! Sila balas dalam bahasa cina

Atas ialah kandungan terperinci Docker melengkapkan penggunaan tempatan model besar sumber terbuka LLama3 dalam masa tiga minit. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1377

1377

52

52

Empat cara untuk melaksanakan multithreading dalam bahasa c

Apr 03, 2025 pm 03:00 PM

Empat cara untuk melaksanakan multithreading dalam bahasa c

Apr 03, 2025 pm 03:00 PM

Multithreading dalam bahasa dapat meningkatkan kecekapan program. Terdapat empat cara utama untuk melaksanakan multithreading dalam bahasa C: Buat proses bebas: Buat pelbagai proses berjalan secara bebas, setiap proses mempunyai ruang ingatan sendiri. Pseudo-Multithreading: Buat pelbagai aliran pelaksanaan dalam proses yang berkongsi ruang memori yang sama dan laksanakan secara bergantian. Perpustakaan multi-threaded: Gunakan perpustakaan berbilang threaded seperti PTHREADS untuk membuat dan mengurus benang, menyediakan fungsi operasi benang yang kaya. Coroutine: Pelaksanaan pelbagai threaded ringan yang membahagikan tugas menjadi subtask kecil dan melaksanakannya pada gilirannya.

Tidak dapat log masuk ke mysql sebagai akar

Apr 08, 2025 pm 04:54 PM

Tidak dapat log masuk ke mysql sebagai akar

Apr 08, 2025 pm 04:54 PM

Sebab utama mengapa anda tidak boleh log masuk ke MySQL sebagai akar adalah masalah kebenaran, ralat fail konfigurasi, kata laluan tidak konsisten, masalah fail soket, atau pemintasan firewall. Penyelesaiannya termasuk: periksa sama ada parameter pengikat di dalam fail konfigurasi dikonfigurasi dengan betul. Semak sama ada kebenaran pengguna root telah diubahsuai atau dipadam dan ditetapkan semula. Sahkan bahawa kata laluan adalah tepat, termasuk kes dan aksara khas. Semak tetapan dan laluan kebenaran fail soket. Semak bahawa firewall menyekat sambungan ke pelayan MySQL.

Libv adalah dua

Apr 03, 2025 pm 08:03 PM

Libv adalah dua

Apr 03, 2025 pm 08:03 PM

Saya membangunkan projek yang dipanggil Lua-Libuv dan gembira untuk berkongsi pengalaman saya. Hasrat asal projek ini adalah untuk meneroka cara menggunakan libuv (perpustakaan I/O yang tidak segerak yang ditulis dalam C) untuk membina pelayan HTTP yang mudah tanpa perlu mempelajari bahasa C secara mendalam. Dengan bantuan CHATGPT, saya menyelesaikan kod asas http.c. Apabila berurusan dengan sambungan yang berterusan, saya berjaya melaksanakan menutup sambungan dan membebaskan sumber pada masa yang tepat. Pada mulanya saya cuba membuat pelayan mudah yang mengakhiri program utama dengan menutup sambungan, tetapi saya mempunyai beberapa masalah. Saya telah cuba menghantar blok data menggunakan streaming, dan semasa ia berfungsi, ini menghalang benang utama. Pada akhirnya, saya memutuskan untuk berputus asa pada pendekatan ini kerana matlamat saya bukan untuk mempelajari bahasa C secara mendalam. Akhirnya, saya

C Language Compilation Compilation: Panduan terperinci untuk pemula ke aplikasi praktikal

Apr 04, 2025 am 10:48 AM

C Language Compilation Compilation: Panduan terperinci untuk pemula ke aplikasi praktikal

Apr 04, 2025 am 10:48 AM

C Language Conditional Compilation adalah mekanisme untuk selektif menyusun blok kod berdasarkan keadaan kompilasi masa. Kaedah pengenalan termasuk: menggunakan arahan #if dan #Else untuk memilih blok kod berdasarkan syarat. Ekspresi bersyarat yang biasa digunakan termasuk STDC, _WIN32 dan LINUX. Kes praktikal: Cetak mesej yang berbeza mengikut sistem operasi. Gunakan jenis data yang berbeza mengikut bilangan digit sistem. Fail header yang berbeza disokong mengikut pengkompil. Penyusunan bersyarat meningkatkan kebolehgunaan dan fleksibiliti kod, menjadikannya boleh disesuaikan dengan pengkompil, sistem operasi, dan perubahan seni bina CPU.

【Rust Sendiri belajar】 Pengenalan

Apr 04, 2025 am 08:03 AM

【Rust Sendiri belajar】 Pengenalan

Apr 04, 2025 am 08:03 AM

1.0.1 Preface Projek ini (termasuk kod dan komen) telah direkodkan semasa karat saya yang diajar sendiri. Mungkin ada kenyataan yang tidak tepat atau tidak jelas, sila minta maaf. Jika anda mendapat manfaat daripadanya, ia lebih baik. 1.0.2 Mengapa Rustrust boleh dipercayai dan cekap? Karat boleh menggantikan C dan C, dengan prestasi yang sama tetapi keselamatan yang lebih tinggi, dan tidak memerlukan rekompilasi yang kerap untuk memeriksa kesilapan seperti C dan C. Kelebihan utama termasuk: Keselamatan Memori (mencegah penunjuk null dari dereferences, penunjuk menggantung, dan perbalahan data). Thread-safe (pastikan kod multi-threaded selamat sebelum pelaksanaan). Elakkan tingkah laku yang tidak ditentukan (mis., Arus dari batas, pembolehubah yang tidak diinisialisasi, atau akses kepada memori yang dibebaskan). Karat menyediakan ciri bahasa moden seperti generik

Di manakah perpustakaan fungsi bahasa C? Bagaimana untuk menambah perpustakaan fungsi bahasa C?

Apr 03, 2025 pm 11:39 PM

Di manakah perpustakaan fungsi bahasa C? Bagaimana untuk menambah perpustakaan fungsi bahasa C?

Apr 03, 2025 pm 11:39 PM

Perpustakaan Fungsi Bahasa C adalah kotak alat yang mengandungi pelbagai fungsi, yang dianjurkan dalam fail perpustakaan yang berbeza. Menambah perpustakaan memerlukan menyatakannya melalui pilihan baris perintah pengkompil, contohnya, pengkompil GCC menggunakan pilihan -L diikuti dengan singkatan nama perpustakaan. Jika fail perpustakaan tidak berada di bawah laluan carian lalai, anda perlu menggunakan pilihan -L untuk menentukan laluan fail perpustakaan. Perpustakaan boleh dibahagikan kepada perpustakaan statik dan perpustakaan dinamik. Perpustakaan statik secara langsung dikaitkan dengan program pada masa kompilasi, manakala perpustakaan dinamik dimuatkan semasa runtime.

Cara menyelesaikan MySQL tidak dapat dimulakan

Apr 08, 2025 pm 02:21 PM

Cara menyelesaikan MySQL tidak dapat dimulakan

Apr 08, 2025 pm 02:21 PM

Terdapat banyak sebab mengapa permulaan MySQL gagal, dan ia boleh didiagnosis dengan memeriksa log ralat. Penyebab umum termasuk konflik pelabuhan (periksa penghunian pelabuhan dan ubah suai konfigurasi), isu kebenaran (periksa keizinan pengguna yang menjalankan perkhidmatan), ralat fail konfigurasi (periksa tetapan parameter), rasuah direktori data (memulihkan data atau membina semula ruang meja), isu ruang jadual InnoDB (semak fail ibdata1) Apabila menyelesaikan masalah, anda harus menganalisisnya berdasarkan log ralat, cari punca utama masalah, dan mengembangkan tabiat sandaran data secara teratur untuk mencegah dan menyelesaikan masalah.

Apakah 5 komponen asas Linux?

Apr 06, 2025 am 12:05 AM

Apakah 5 komponen asas Linux?

Apr 06, 2025 am 12:05 AM

Lima komponen asas Linux adalah: 1. Kernel, menguruskan sumber perkakasan; 2. Perpustakaan sistem, menyediakan fungsi dan perkhidmatan; 3. Shell, antara muka pengguna untuk berinteraksi dengan sistem; 4. Sistem fail, menyimpan dan menganjurkan data; 5. Aplikasi, menggunakan sumber sistem untuk melaksanakan fungsi.