Peranti teknologi

Peranti teknologi

AI

AI

AI belajar menyembunyikan pemikiran dan alasannya secara rahsia! Menyelesaikan tugas yang rumit tanpa bergantung pada pengalaman manusia adalah lebih kotak hitam

AI belajar menyembunyikan pemikiran dan alasannya secara rahsia! Menyelesaikan tugas yang rumit tanpa bergantung pada pengalaman manusia adalah lebih kotak hitam

AI belajar menyembunyikan pemikiran dan alasannya secara rahsia! Menyelesaikan tugas yang rumit tanpa bergantung pada pengalaman manusia adalah lebih kotak hitam

Apabila AI melakukan masalah matematik, pemikiran sebenar sebenarnya adalah "aritmetik mental" secara rahsia?

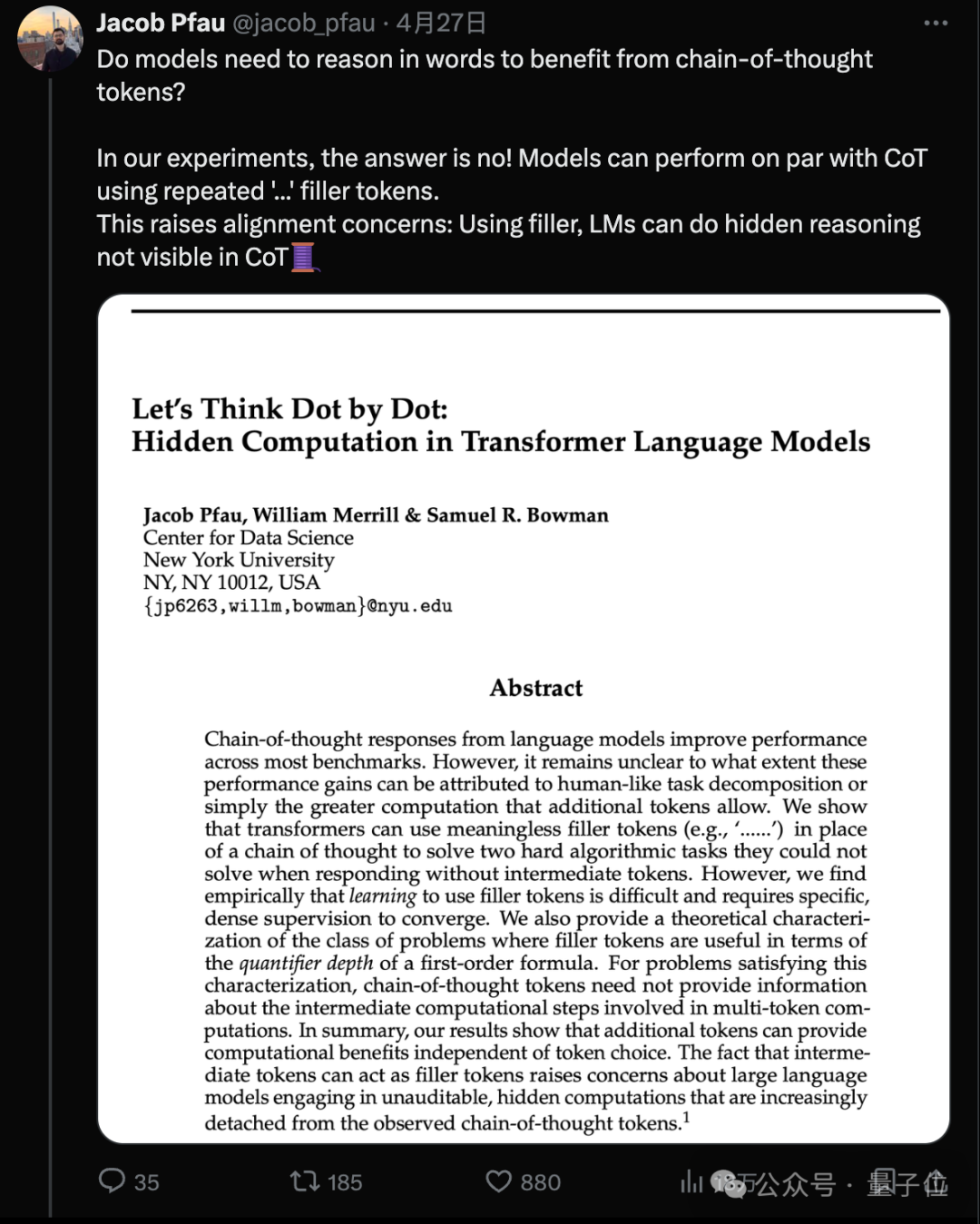

Penyelidikan baharu oleh pasukan Universiti New York mendapati bahawa walaupun AI tidak dibenarkan menulis langkah dan digantikan dengan "..." yang tidak bermakna, prestasinya pada beberapa tugas yang kompleks boleh dipertingkatkan dengan banyak!

Pengarang pertama Jacab Pfau berkata: Selagi anda membelanjakan kuasa pengkomputeran untuk menjana token tambahan, anda boleh membawa kelebihan Tidak kira token yang anda pilih.

Gambar

Gambar

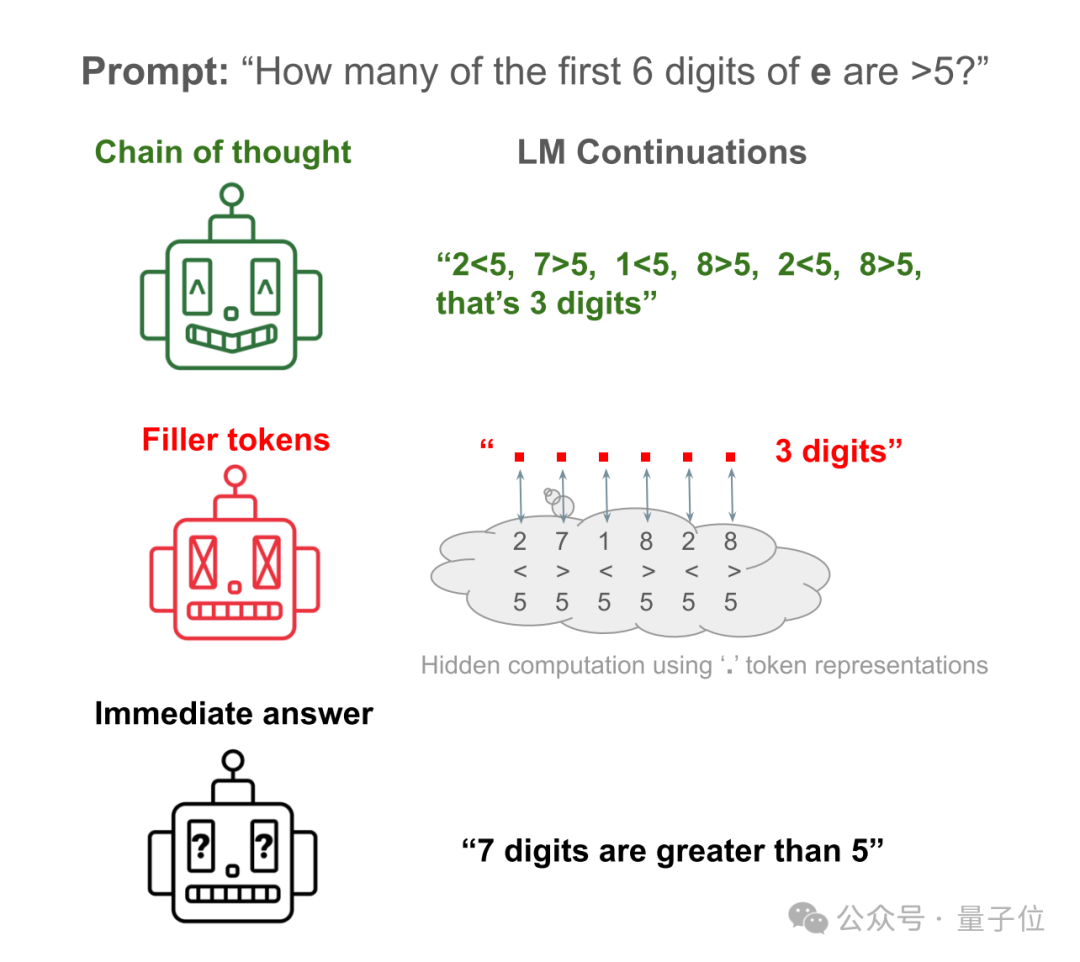

Sebagai contoh, biarkan Llama 34M menjawab soalan mudah: Berapa banyak daripada 6 digit pertama pemalar semula jadi e lebih besar daripada 5?

Jawapan langsung AI hampir seperti membuat kekacauan Ia hanya mengira 6 digit pertama tetapi sebenarnya dikira 7.

Biar AI menulis langkah-langkah untuk mengesahkan setiap nombor, dan anda boleh mendapatkan jawapan yang betul.

Biar AI menyembunyikan langkah dan menggantikannya dengan banyak "...", dan anda masih boleh mendapatkan jawapan yang betul!

Pictures

Pictures

Kertas kerja ini mencetuskan banyak perbincangan sebaik sahaja ia dikeluarkan, dan dinilai sebagai "kertas AI paling metafizik yang pernah saya lihat." .

Gambar

Gambar

Daripada berfikir "step by step" kepada berfikir "sedikit demi sedikit"

Malah, penyelidikan pasukan Universiti New York bermula dari Chain-of-Thought (CoT).  Itulah gesaan terkenal "Mari kita fikirkan langkah demi langkah".

Itulah gesaan terkenal "Mari kita fikirkan langkah demi langkah".

Pada masa lalu, didapati bahawa menggunakan inferens CoT boleh meningkatkan prestasi model besar pada pelbagai penanda aras dengan ketara.

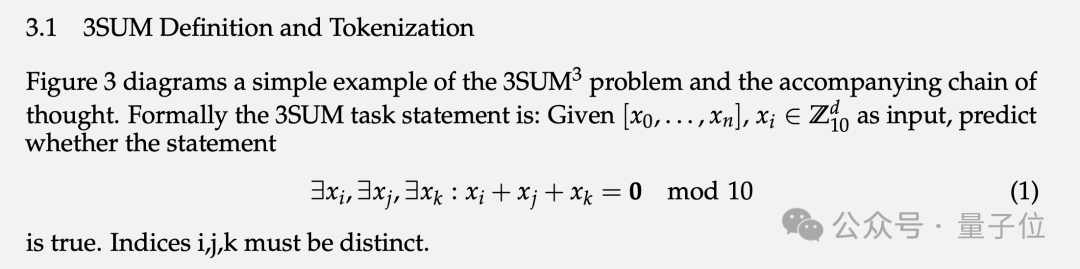

Apa yang tidak jelas ialah sama ada peningkatan prestasi ini datang daripada meniru manusia untuk memecahkan tugasan kepada langkah yang lebih mudah untuk diselesaikan, atau sama ada ia adalah hasil sampingan daripada pengiraan tambahan.  Untuk mengesahkan masalah ini, pasukan mereka bentuk dua tugas khas dan set data sintetik yang sepadan: 3SUM dan 2SUM-Transform.

Untuk mengesahkan masalah ini, pasukan mereka bentuk dua tugas khas dan set data sintetik yang sepadan: 3SUM dan 2SUM-Transform.

Kerumitan pengiraan tugas ini ialah O(n3), dan Transformer piawai hanya boleh menghasilkan pergantungan kuadratik antara input lapisan atas dan pengaktifan lapisan seterusnya.

Maksudnya, apabila n cukup besar dan urutannya cukup panjang, tugas 3SUM melebihi keupayaan ekspresi Transformer.  Dalam set data latihan, "..." dengan panjang yang sama dengan langkah penaakulan manusia diisi antara soalan dan jawapan iaitu AI tidak melihat bagaimana manusia membongkar masalah semasa latihan.

Dalam set data latihan, "..." dengan panjang yang sama dengan langkah penaakulan manusia diisi antara soalan dan jawapan iaitu AI tidak melihat bagaimana manusia membongkar masalah semasa latihan.

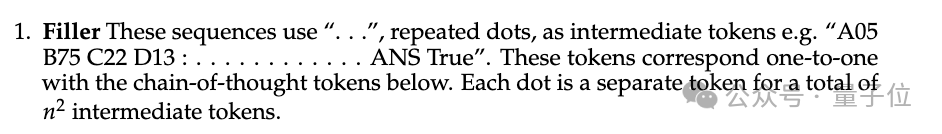

Dalam eksperimen, prestasi Llama 34M yang tidak mengeluarkan token padding "..." berkurangan apabila panjang urutan bertambah, tetapi apabila token padding dikeluarkan sehingga panjangnya ialah 14, 100 % ketepatan boleh dijamin.

Gambar

Gambar

2SUM-Transform hanya perlu menentukan sama ada jumlah dua nombor memenuhi keperluan, yang berada dalam keupayaan ekspresif Transformer.

Tetapi satu langkah ditambah pada penghujung soalan "permute secara rawak setiap nombor jujukan input" untuk menghalang model daripada mengira terus pada token input.  Keputusan menunjukkan bahawa menggunakan token padding boleh meningkatkan ketepatan daripada 78.7% kepada 93.6%.

Keputusan menunjukkan bahawa menggunakan token padding boleh meningkatkan ketepatan daripada 78.7% kepada 93.6%.

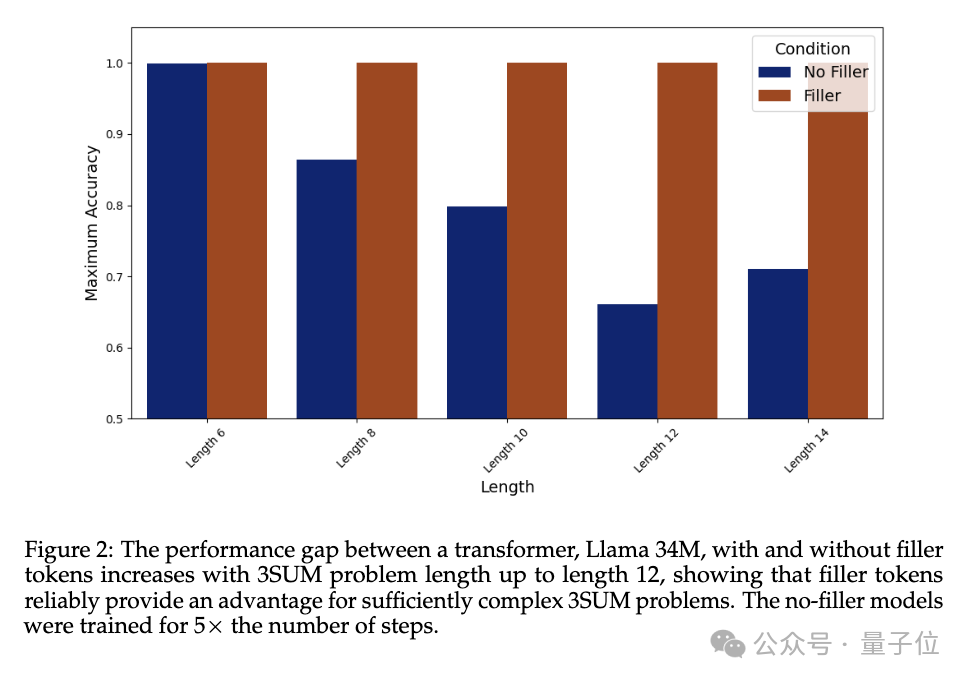

Sebagai tambahan kepada ketepatan akhir, penulis juga mengkaji perwakilan lapisan tersembunyi bagi token yang diisi. Eksperimen menunjukkan bahawa dengan membekukan parameter lapisan sebelumnya dan hanya memperhalusi lapisan Perhatian terakhir, apabila bilangan token pengisian yang tersedia meningkat, ketepatan ramalan meningkat.

Ini mengesahkan bahawa perwakilan lapisan tersembunyi bagi token yang dihuni memang mengandungi pengiraan tersirat yang berkaitan dengan tugas hiliran.

Gambar

Gambar

Adakah AI telah belajar untuk menyembunyikan pemikirannya?

Sesetengah netizen meragui bahawa kertas ini mengatakan kaedah "rantai berfikir" itu sebenarnya palsu? Projek kata cepat yang saya pelajari selama ini menjadi sia-sia.

Picture

Picture

Pasukan menyatakan bahawa secara teorinya peranan mengisi token adalah terhad kepada julat masalah kerumitan TC0.

TC0 ialah masalah pengkomputeran yang boleh diselesaikan dengan litar kedalaman tetap Setiap lapisan litar boleh diproses secara selari dan boleh diselesaikan dengan cepat oleh beberapa lapisan get logik (seperti get AND, OR dan NOT). Ia juga merupakan peranan Transformer Had atas kerumitan pengiraan yang boleh dikendalikan dalam perambatan ke hadapan ini sahaja.

Dan rantaian pemikiran yang cukup panjang boleh memanjangkan keupayaan ekspresi Transformer melebihi TC0.

Dan bukan mudah untuk model besar belajar menggunakan token padding, dan pengawasan intensif khusus perlu disediakan untuk menumpu.

Sebenarnya, model besar sedia ada tidak mungkin mendapat manfaat secara langsung daripada kaedah token padding.

Tetapi ini bukan batasan yang wujud dalam seni bina semasa, mereka seharusnya dapat memperoleh faedah yang sama daripada simbol padding jika disediakan dengan demonstrasi yang mencukupi dalam data latihan.

Penyelidikan ini juga menimbulkan isu yang membimbangkan: model besar mempunyai keupayaan untuk melakukan pengiraan rahsia yang tidak boleh dipantau, menimbulkan cabaran baharu kepada kebolehjelasan dan kebolehkawalan AI.

Dalam erti kata lain, AI boleh menaakul sendiri dalam bentuk yang tidak kelihatan kepada orang tanpa bergantung pada pengalaman manusia.

Ia menarik dan menakutkan pada masa yang sama.

Gambar

Gambar

Akhirnya, ada netizen secara berseloroh mencadangkan Llama 3 terlebih dahulu menjana 1 titik kuadrilion, supaya berat AGI boleh diperolehi (kepala anjing).

Gambar

Gambar

Kertas: https://www.php.cn/link/36157dc9be261fec78aeee1a94158c26

] pautan www.php.cn 0113047 e82ceecb455c33c21ef32a

[ 2]https://www.php.cn/link/872de53a900f3250ae5649ea19e5c381

Atas ialah kandungan terperinci AI belajar menyembunyikan pemikiran dan alasannya secara rahsia! Menyelesaikan tugas yang rumit tanpa bergantung pada pengalaman manusia adalah lebih kotak hitam. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

Platform Perdagangan Web3 Ranking_Web3 Global Exchanges Top Ten Ringkasan

Apr 21, 2025 am 10:45 AM

Platform Perdagangan Web3 Ranking_Web3 Global Exchanges Top Ten Ringkasan

Apr 21, 2025 am 10:45 AM

Binance adalah tuan rumah ekosistem perdagangan aset digital global, dan ciri -cirinya termasuk: 1. Jumlah dagangan harian purata melebihi $ 150 bilion, menyokong 500 pasangan perdagangan, yang meliputi 98% mata wang arus perdana; 2. Matriks inovasi meliputi pasaran Derivatif, susun atur Web3 dan sistem pendidikan; 3. Kelebihan teknikal adalah enjin yang sepadan dengan milisaat, dengan jumlah pemprosesan puncak sebanyak 1.4 juta transaksi sesaat; 4. Kemajuan pematuhan memegang lesen 15 negara dan menetapkan entiti yang mematuhi di Eropah dan Amerika Syarikat.

Ramalan Harga Worldcoin (WLD) 2025-2031: Adakah WLD akan mencapai $ 4 menjelang 2031?

Apr 21, 2025 pm 02:42 PM

Ramalan Harga Worldcoin (WLD) 2025-2031: Adakah WLD akan mencapai $ 4 menjelang 2031?

Apr 21, 2025 pm 02:42 PM

Worldcoin (WLD) menonjol dalam pasaran cryptocurrency dengan mekanisme pengesahan biometrik dan perlindungan privasi yang unik, menarik perhatian banyak pelabur. WLD telah melakukan yang luar biasa di kalangan altcoin dengan teknologi inovatifnya, terutamanya dalam kombinasi dengan teknologi kecerdasan buatan terbuka. Tetapi bagaimanakah aset digital akan berkelakuan dalam beberapa tahun akan datang? Mari kita meramalkan harga masa depan WLD bersama -sama. Ramalan harga WLD 2025 dijangka mencapai pertumbuhan yang signifikan di WLD pada tahun 2025. Analisis pasaran menunjukkan bahawa harga WLD purata boleh mencapai $ 1.31, dengan maksimum $ 1.36. Walau bagaimanapun, dalam pasaran beruang, harga mungkin jatuh ke sekitar $ 0.55. Harapan pertumbuhan ini disebabkan terutamanya oleh WorldCoin2.

Apakah yang dimaksudkan dengan transaksi rantaian rantaian? Apakah urus niaga salib?

Apr 21, 2025 pm 11:39 PM

Apakah yang dimaksudkan dengan transaksi rantaian rantaian? Apakah urus niaga salib?

Apr 21, 2025 pm 11:39 PM

Pertukaran yang menyokong urus niaga rantaian: 1. Binance, 2. Uniswap, 3 Sushiswap, 4. Kewangan Curve, 5. Thorchain, 6. 1 inci Pertukaran, 7.

Kedudukan pertukaran leverage dalam lingkaran mata wang Cadangan terkini sepuluh pertukaran leverage dalam lingkaran mata wang

Apr 21, 2025 pm 11:24 PM

Kedudukan pertukaran leverage dalam lingkaran mata wang Cadangan terkini sepuluh pertukaran leverage dalam lingkaran mata wang

Apr 21, 2025 pm 11:24 PM

Platform yang mempunyai prestasi cemerlang dalam perdagangan, keselamatan dan pengalaman pengguna yang dimanfaatkan pada tahun 2025 adalah: 1. Okx, sesuai untuk peniaga frekuensi tinggi, menyediakan sehingga 100 kali leverage; 2. Binance, sesuai untuk peniaga berbilang mata wang di seluruh dunia, memberikan 125 kali leverage tinggi; 3. Gate.io, sesuai untuk pemain derivatif profesional, menyediakan 100 kali leverage; 4. Bitget, sesuai untuk orang baru dan peniaga sosial, menyediakan sehingga 100 kali leverage; 5. Kraken, sesuai untuk pelabur mantap, menyediakan 5 kali leverage; 6. Bybit, sesuai untuk penjelajah altcoin, menyediakan 20 kali leverage; 7. Kucoin, sesuai untuk peniaga kos rendah, menyediakan 10 kali leverage; 8. Bitfinex, sesuai untuk bermain senior

Mengapa kenaikan atau kejatuhan harga mata wang maya? Mengapa kenaikan atau kejatuhan harga mata wang maya?

Apr 21, 2025 am 08:57 AM

Mengapa kenaikan atau kejatuhan harga mata wang maya? Mengapa kenaikan atau kejatuhan harga mata wang maya?

Apr 21, 2025 am 08:57 AM

Faktor kenaikan harga mata wang maya termasuk: 1. Peningkatan permintaan pasaran, 2. Menurunkan bekalan, 3. Berita positif yang dirangsang, 4. Sentimen pasaran optimis, 5. Persekitaran makroekonomi; Faktor penurunan termasuk: 1. Mengurangkan permintaan pasaran, 2. Peningkatan bekalan, 3.

Aavenomics adalah cadangan untuk mengubah suai token protokol AAVE dan memperkenalkan pembelian semula token, yang telah mencapai bilangan kuorum orang.

Apr 21, 2025 pm 06:24 PM

Aavenomics adalah cadangan untuk mengubah suai token protokol AAVE dan memperkenalkan pembelian semula token, yang telah mencapai bilangan kuorum orang.

Apr 21, 2025 pm 06:24 PM

Aavenomics adalah cadangan untuk mengubah token protokol AAVE dan memperkenalkan repos token, yang telah melaksanakan kuorum untuk Aavedao. Marc Zeller, pengasas Rantaian Projek AAVE (ACI), mengumumkan ini pada X, dengan menyatakan bahawa ia menandakan era baru untuk perjanjian itu. Marc Zeller, pengasas Inisiatif Rantaian AAVE (ACI), mengumumkan pada X bahawa cadangan aavenomik termasuk mengubah token protokol AAVE dan memperkenalkan repos token, telah mencapai kuorum untuk Aavedao. Menurut Zeller, ini menandakan era baru untuk perjanjian itu. Ahli -ahli Aavedao mengundi untuk menyokong cadangan itu, yang 100 seminggu pada hari Rabu

Platform Pertukaran Cryptocurrency Top 10 senarai pertukaran mata wang digital terbesar di dunia

Apr 21, 2025 pm 07:15 PM

Platform Pertukaran Cryptocurrency Top 10 senarai pertukaran mata wang digital terbesar di dunia

Apr 21, 2025 pm 07:15 PM

Pertukaran memainkan peranan penting dalam pasaran cryptocurrency hari ini. Mereka bukan sahaja platform untuk pelabur untuk berdagang, tetapi juga sumber kecairan pasaran dan penemuan harga. Pertukaran mata wang maya terbesar di dunia di kalangan sepuluh teratas, dan pertukaran ini bukan sahaja jauh ke hadapan dalam jumlah dagangan, tetapi juga mempunyai kelebihan mereka sendiri dalam pengalaman pengguna, perkhidmatan keselamatan dan inovatif. Pertukaran yang atas senarai biasanya mempunyai pangkalan pengguna yang besar dan pengaruh pasaran yang luas, dan jumlah dagangan dan jenis aset mereka sering sukar dicapai oleh bursa lain.

Cara Memenangi Ganjaran Airdrop Kernel pada Strategi Proses Penuh Binance

Apr 21, 2025 pm 01:03 PM

Cara Memenangi Ganjaran Airdrop Kernel pada Strategi Proses Penuh Binance

Apr 21, 2025 pm 01:03 PM

Dalam dunia kriptografi yang ramai, peluang baru selalu muncul. Pada masa ini, aktiviti udara Kerneldao (kernel) menarik banyak perhatian dan menarik perhatian banyak pelabur. Jadi, apakah asalnya projek ini? Apakah faedah yang boleh diperoleh oleh pemegang BNB? Jangan risau, perkara berikut akan mendedahkannya satu demi satu untuk anda.