Peranti teknologi

Peranti teknologi

AI

AI

Model MoE sumber terbuka paling berkuasa di dunia ada di sini, dengan keupayaan bahasa Cina setanding dengan GPT-4, dan harganya hanya hampir satu peratus daripada GPT-4-Turbo

Model MoE sumber terbuka paling berkuasa di dunia ada di sini, dengan keupayaan bahasa Cina setanding dengan GPT-4, dan harganya hanya hampir satu peratus daripada GPT-4-Turbo

Model MoE sumber terbuka paling berkuasa di dunia ada di sini, dengan keupayaan bahasa Cina setanding dengan GPT-4, dan harganya hanya hampir satu peratus daripada GPT-4-Turbo

May 07, 2024 pm 04:13 PMBayangkan model kecerdasan buatan yang bukan sahaja mempunyai keupayaan untuk mengatasi pengkomputeran tradisional, tetapi juga mencapai prestasi yang lebih cekap pada kos yang lebih rendah. Ini bukan fiksyen sains, DeepSeek-V2[1], model MoE sumber terbuka paling berkuasa di dunia ada di sini.

DeepSeek-V2 ialah gabungan model bahasa pakar (MoE) yang berkuasa dengan ciri-ciri latihan ekonomi dan inferens yang cekap. Ia terdiri daripada 236B parameter, 21B daripadanya digunakan untuk mengaktifkan setiap teg. Berbanding DeepSeek 67B, DeepSeek-V2 mempunyai prestasi yang lebih kukuh, sambil menjimatkan 42.5% kos latihan, mengurangkan cache KV sebanyak 93.3% dan meningkatkan daya pemprosesan penjanaan maksimum kepada 5.76 kali.

DeepSeek ialah sebuah syarikat yang meneroka sifat kecerdasan buatan am (AGI) dan komited untuk menyepadukan penyelidikan, kejuruteraan dan perniagaan.

Keupayaan komprehensif DeepSeek-V2

Dalam senarai arus perdana model besar semasa, DeepSeek-V2 berprestasi baik:

- Terkuat di kalangan keupayaan komprehensif Cina (AlignBench dengan) model sumber terbuka Gbo-4-Tur model sumber tertutup seperti Wenxin 4.0 berada dalam eselon yang sama dalam penilaian

- Keupayaan komprehensif Bahasa Inggeris (MT-Bench) berada dalam eselon pertama: Keupayaan komprehensif Inggeris (MT-Bench) berada dalam eselon yang sama dengan model sumber terbuka terkuat Llama3-70b, melebihi model sumber terbuka MOE yang paling kuat mixtral 8x22b

- ranking di antara bahagian atas pengetahuan, matematik, penalaran, pengaturcaraan dan senarai lain yang menyokong struktur model 128k. potensi AI sentiasa diterokai Menggali, kami tidak boleh tidak bertanya: Apakah kunci untuk mempromosikan kemajuan pintar? DeepSeek-V2 memberikan jawapan - gabungan sempurna seni bina inovatif dan keberkesanan kos

- .

Dengan perkembangan pesat teknologi AI. Hari ini, kemunculan DeepSeek-V2 bukan sahaja mewakili kejayaan teknologi, tetapi juga menandakan popularisasi aplikasi pintar. Ia merendahkan ambang untuk AI dan membolehkan lebih banyak syarikat dan individu menikmati faedah perkhidmatan pintar yang cekap. Pada masa yang sama, ia juga menandakan pempopularan aplikasi pintar. Ia merendahkan ambang untuk AI dan membolehkan lebih banyak syarikat dan individu menikmati faedah perkhidmatan pintar yang cekap.

Dengan perkembangan pesat teknologi AI. Hari ini, kemunculan DeepSeek-V2 bukan sahaja mewakili kejayaan teknologi, tetapi juga menandakan popularisasi aplikasi pintar. Ia merendahkan ambang untuk AI dan membolehkan lebih banyak syarikat dan individu menikmati faedah perkhidmatan pintar yang cekap. Pada masa yang sama, ia juga menandakan pempopularan aplikasi pintar. Ia merendahkan ambang untuk AI dan membolehkan lebih banyak syarikat dan individu menikmati faedah perkhidmatan pintar yang cekap.

Keupayaan Cina VS Harga

Dari segi keupayaan Cina, DeepSeek-V2 mendahului dunia dalam ranking AlignBench sambil memberikan harga API yang sangat kompetitif.

Model dan kertas kedua-duanya adalah sumber terbukaDeepSeek-V2 bukan sekadar model, ia adalah kunci kepada dunia yang lebih bijak. Ia membuka lembaran baharu dalam aplikasi AI dengan kos yang lebih rendah dan prestasi yang lebih tinggi. Sumber terbuka DeepSeek-V2 adalah bukti terbaik kepercayaan ini. Ia akan memberi inspirasi kepada lebih ramai orang semangat inovatif dan bersama-sama mempromosikan masa depan kecerdasan manusia.

Berat model: https://huggingface.co/deepseek-ai Alamat sumber terbuka: https://github.com/deepseek-ai/DeepSeek-V2

Alamat sumber terbuka: https://github.com/deepseek-ai/DeepSeek-V2

Hari ini apabila AI terus berkembang, apa yang perlu dilakukan anda fikir DeepSeek -Bagaimana V2 akan mengubah dunia kita? Mari tunggu dan lihat. Jika anda berminat, anda boleh layari

chat.deepseek.com- untuk merasai sendiri perubahan teknologi yang dibawa oleh DeepSeek-V2. .

Atas ialah kandungan terperinci Model MoE sumber terbuka paling berkuasa di dunia ada di sini, dengan keupayaan bahasa Cina setanding dengan GPT-4, dan harganya hanya hampir satu peratus daripada GPT-4-Turbo. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel Panas

Alat panas Tag

Artikel Panas

Tag artikel panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

Tiada data OpenAI diperlukan, sertai senarai model kod besar! UIUC mengeluarkan StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Tiada data OpenAI diperlukan, sertai senarai model kod besar! UIUC mengeluarkan StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Tiada data OpenAI diperlukan, sertai senarai model kod besar! UIUC mengeluarkan StarCoder-15B-Instruct

PRO |. Mengapa model besar berdasarkan MoE lebih patut diberi perhatian?

Aug 07, 2024 pm 07:08 PM

PRO |. Mengapa model besar berdasarkan MoE lebih patut diberi perhatian?

Aug 07, 2024 pm 07:08 PM

PRO |. Mengapa model besar berdasarkan MoE lebih patut diberi perhatian?

Ringkasan Soalan Lazim untuk Penggunaan DeepSeek

Feb 19, 2025 pm 03:45 PM

Ringkasan Soalan Lazim untuk Penggunaan DeepSeek

Feb 19, 2025 pm 03:45 PM

Ringkasan Soalan Lazim untuk Penggunaan DeepSeek

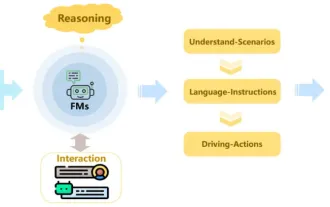

Semakan! Ringkaskan secara menyeluruh peranan penting model asas dalam mempromosikan pemanduan autonomi

Jun 11, 2024 pm 05:29 PM

Semakan! Ringkaskan secara menyeluruh peranan penting model asas dalam mempromosikan pemanduan autonomi

Jun 11, 2024 pm 05:29 PM

Semakan! Ringkaskan secara menyeluruh peranan penting model asas dalam mempromosikan pemanduan autonomi

Bagaimana untuk mendaftar untuk LBank Exchange?

Aug 21, 2024 pm 02:20 PM

Bagaimana untuk mendaftar untuk LBank Exchange?

Aug 21, 2024 pm 02:20 PM

Bagaimana untuk mendaftar untuk LBank Exchange?

Laporan teknikal Google Gemini 1.5: Buktikan soalan Olimpik Matematik dengan mudah, versi Flash adalah 5 kali lebih pantas daripada GPT-4 Turbo

Jun 13, 2024 pm 01:52 PM

Laporan teknikal Google Gemini 1.5: Buktikan soalan Olimpik Matematik dengan mudah, versi Flash adalah 5 kali lebih pantas daripada GPT-4 Turbo

Jun 13, 2024 pm 01:52 PM

Laporan teknikal Google Gemini 1.5: Buktikan soalan Olimpik Matematik dengan mudah, versi Flash adalah 5 kali lebih pantas daripada GPT-4 Turbo

Skandal tembakan membuatkan pengarah Stanford AI Lab marah! Dua ahli pasukan plagiarisme bertanggungjawab dan seorang hilang, dan rekod jenayahnya didedahkan Netizen: Fahami semula model sumber terbuka China

Jun 09, 2024 am 09:38 AM

Skandal tembakan membuatkan pengarah Stanford AI Lab marah! Dua ahli pasukan plagiarisme bertanggungjawab dan seorang hilang, dan rekod jenayahnya didedahkan Netizen: Fahami semula model sumber terbuka China

Jun 09, 2024 am 09:38 AM

Skandal tembakan membuatkan pengarah Stanford AI Lab marah! Dua ahli pasukan plagiarisme bertanggungjawab dan seorang hilang, dan rekod jenayahnya didedahkan Netizen: Fahami semula model sumber terbuka China