Jumlah kandungan berkaitan 10000

Maksud Saiz Kelompok dan kesannya terhadap latihan (berkaitan dengan model pembelajaran mesin)

Pengenalan Artikel:BatchSize merujuk kepada jumlah data yang digunakan oleh model pembelajaran mesin setiap kali semasa proses latihan. Ia membahagikan sejumlah besar data kepada kumpulan kecil data untuk latihan model dan pengemaskinian parameter. Kaedah pemprosesan kelompok ini membantu meningkatkan kecekapan latihan dan penggunaan memori. Data latihan biasanya dibahagikan kepada kelompok untuk latihan, dan setiap kelompok mengandungi berbilang sampel. Saiz kelompok (saiz kelompok) merujuk kepada bilangan sampel yang terkandung dalam setiap kelompok. Apabila melatih model, saiz kelompok mempunyai kesan penting ke atas proses latihan. 1. Kelajuan latihan Saiz kelompok (saiz kelompok) memberi kesan kepada kelajuan latihan model. Saiz kelompok yang lebih besar boleh memproses data latihan dengan lebih cepat kerana dalam setiap zaman, saiz kelompok yang lebih besar boleh memproses lebih banyak data secara serentak.

2024-01-23

komen 0

2211

Panduan latihan model ChatGPT Python: langkah untuk menyesuaikan chatbot

Pengenalan Artikel:Panduan latihan model ChatGPTPython: Gambaran keseluruhan langkah untuk menyesuaikan robot sembang: Dalam beberapa tahun kebelakangan ini, dengan peningkatan pembangunan teknologi NLP (pemprosesan bahasa semula jadi), robot sembang telah menarik lebih banyak perhatian. ChatGPT OpenAI ialah model bahasa pra-latihan yang berkuasa yang boleh digunakan untuk membina chatbot berbilang domain. Artikel ini akan memperkenalkan langkah-langkah untuk menggunakan Python untuk melatih model ChatGPT, termasuk penyediaan data, latihan model dan penjanaan sampel dialog. Langkah 1: Penyediaan, pengumpulan dan pembersihan data

2023-10-24

komen 0

1305

Perpustakaan sambungan latihan teragih sumber terbuka Ant AToch mencapai kadar penggunaan berkesan sebanyak 60% kuasa pengkomputeran latihan model besar

Pengenalan Artikel:Ant Group baru-baru ini mengumumkan pelancaran perpustakaan sambungan pecutan latihan teragih model besar yang dipanggil ATorch, alat sumber terbuka. Matlamat ATorch adalah untuk membantu meningkatkan kecerdasan pembelajaran mendalam melalui pengoptimuman dinamik sumber automatik dan peningkatan kestabilan latihan yang diedarkan. Difahamkan bahawa dalam latihan model besar, ATorch boleh meningkatkan kadar penggunaan kuasa pengkomputeran latihan tahap kilokalori ratusan bilion model kepada 60%, yang bersamaan dengan menambah enjin berkuasa pada kereta sport. Ini akan menjadi alat penting untuk penyelidik dan pembangun pembelajaran mendalam untuk membantu mereka melatih dan mengoptimumkan model besar dengan lebih cekap. Rajah: ATorch komited untuk menjadikan latihan model besar lebih cekap dan boleh dihasilkan semula Dengan letupan model besar generatif, skala set data dan parameter untuk latihan model telah meningkat secara eksponen.

2024-01-14

komen 0

1405

Bagaimana untuk melaksanakan algoritma yang diedarkan dan latihan model dalam perkhidmatan mikro PHP

Pengenalan Artikel:Cara melaksanakan algoritma teragih dan latihan model dalam perkhidmatan mikro PHP Pengenalan: Dengan perkembangan pesat pengkomputeran awan dan teknologi data besar, permintaan untuk pemprosesan data dan latihan model semakin meningkat. Algoritma dan latihan model yang diedarkan adalah kunci untuk mencapai kecekapan, kelajuan dan kebolehskalaan. Artikel ini akan memperkenalkan cara melaksanakan algoritma teragih dan latihan model dalam perkhidmatan mikro PHP dan menyediakan beberapa contoh kod khusus. 1. Apakah yang dimaksudkan dengan latihan algoritma dan model yang diedarkan ialah teknologi yang menggunakan pelbagai mesin atau sumber pelayan untuk melaksanakan pemprosesan data dan latihan model secara serentak.

2023-09-25

komen 0

1427

PHP培训模式是什么?

Pengenalan Artikel:PHP培训模式是:1、精细化教学,一般的模式是上午课堂授课,下午自我练习,有经验的讲师辅佐在侧;2、这些php培训都有与企业开展实际项目,在培人员可以参与其中,享受其中的就业资源,项目资源和经验教训。

2020-02-21

komen 0

2394

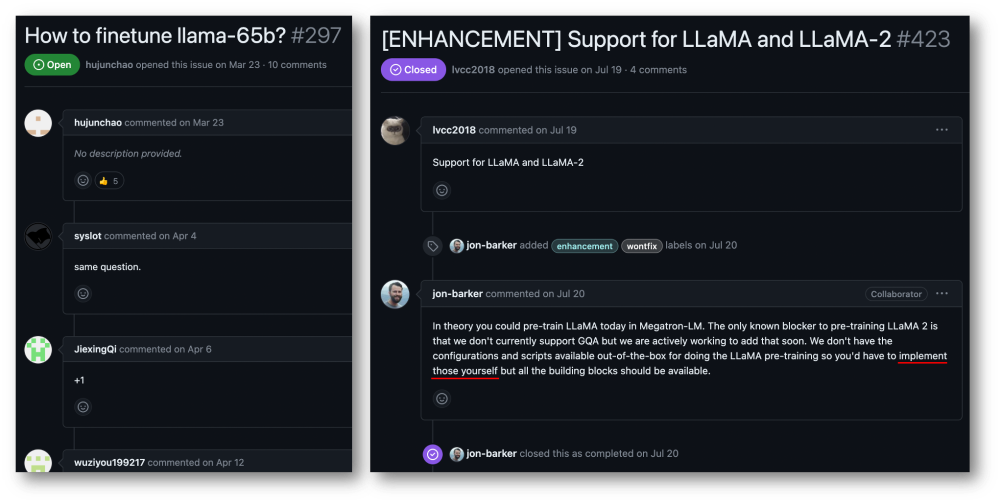

32-kad 176% pecutan latihan, rangka kerja latihan model besar sumber terbuka Megatron-LLaMA ada di sini

Pengenalan Artikel:Kumpulan Taotian dan Teknologi Aicheng secara rasmi mengeluarkan rangka kerja latihan model besar sumber terbuka - Megatron-LLaMA pada 12 September. Matlamat rangka kerja ini adalah untuk memudahkan pembangun teknologi meningkatkan prestasi latihan model bahasa besar, mengurangkan kos latihan dan mengekalkan keserasian dengan komuniti LLaMA. Keputusan ujian menunjukkan bahawa pada latihan 32-kad, Megatron-LLaMA boleh mencapai pecutan 176% berbanding dengan versi kod yang diperoleh secara langsung pada HuggingFace pada latihan berskala besar, Megatron-LLaMA berkembang hampir secara linear dan tidak stabil kepada rangkaian tahap toleransi yang tinggi. Pada masa ini, Megatron-LLaMA telah dilancarkan dalam komuniti sumber terbuka di alamat sumber terbuka: https:

2023-09-14

komen 0

613

Bagaimanakah rangka kerja Java mempercepatkan latihan model kecerdasan buatan?

Pengenalan Artikel:Rangka kerja Java boleh mempercepatkan latihan model kecerdasan buatan dengan: menggunakan TensorFlowServing untuk menggunakan model pra-latihan untuk inferens pantas menggunakan H2OAI DriverlessAI untuk mengautomasikan proses latihan dan menggunakan pengkomputeran teragih untuk memendekkan masa latihan menggunakan SparkMLlib untuk melaksanakan latihan teragih dan berskala besar; data pada pemprosesan Set seni bina Apache Spark.

2024-06-04

komen 0

882

Panduan latihan model ChatGPT Python: Menyuntik kemahiran baharu ke dalam chatbot anda

Pengenalan Artikel:Panduan latihan model ChatGPTPython: Menyuntik kemahiran baharu ke dalam chatbots memerlukan contoh kod khusus Pengenalan: Dalam beberapa tahun kebelakangan ini, perkembangan pesat teknologi kecerdasan buatan telah menjadikan chatbots digunakan secara meluas dalam pelbagai bidang. Walau bagaimanapun, model chatbot sedia ada selalunya hanya menyediakan fungsi perbualan asas dan tidak boleh mempunyai kemahiran yang lebih pintar, seperti menjawab soalan dan sistem pengesyoran. Untuk membolehkan chatbot mempunyai lebih banyak kemahiran, kita boleh menggunakan model ChatGPT dan melatih model tersebut melalui Python.

2023-10-24

komen 0

991

Menggunakan fungsi JavaScript untuk melaksanakan latihan model pembelajaran mesin

Pengenalan Artikel:Menggunakan fungsi JavaScript untuk melaksanakan latihan model pembelajaran mesin Dengan perkembangan pesat pembelajaran mesin, ramai pembangun telah mula memberi perhatian kepada cara menggunakan JavaScript untuk melaksanakan latihan model pembelajaran mesin di bahagian hadapan. Artikel ini akan memperkenalkan cara menggunakan fungsi JavaScript untuk melaksanakan latihan model pembelajaran mesin dan memberikan contoh kod khusus. Sebelum kita memulakan, kita perlu memahami beberapa konsep penting. Set Data: Latihan model pembelajaran mesin memerlukan set set data berlabel sebagai input. Set data terdiri daripada

2023-11-03

komen 0

1183

Memindahkan aplikasi pembelajaran dan teknologi biasa dalam latihan model bahasa besar

Pengenalan Artikel:Model bahasa besar merujuk kepada model pemprosesan bahasa semula jadi dengan lebih daripada 100 juta parameter. Oleh kerana saiz dan kerumitannya yang besar, latihan model sedemikian memerlukan sumber dan data pengkomputeran yang ketara. Oleh itu, pembelajaran pemindahan telah menjadi kaedah penting untuk melatih model bahasa besar Dengan menggunakan model dan data sedia ada, proses latihan dapat dipercepatkan dan prestasi dapat ditingkatkan. Memindahkan pembelajaran boleh memindahkan parameter dan pengetahuan model yang dilatih pada tugas lain kepada tugas sasaran, dengan itu mengurangkan keperluan data dan masa latihan. Pendekatan ini digunakan secara meluas dalam kedua-dua penyelidikan dan industri, meletakkan asas untuk membina model bahasa yang lebih berkuasa. Memindahkan pembelajaran ialah kaedah yang menggunakan model yang sudah terlatih untuk melaraskan parameternya atau beberapa komponen semasa menyelesaikan tugasan lain. Dalam bidang pemprosesan bahasa semula jadi, pembelajaran pemindahan boleh

2024-01-22

komen 0

922

Untuk $1,890, anda boleh melatih model penyebaran parameter 1.2 bilion yang baik dari awal.

Pengenalan Artikel:Dengan hanya $1,890 dan 37 juta imej, anda boleh melatih model penyebaran yang baik. Pada masa ini, model generatif penglihatan pandai mencipta kandungan visual yang realistik, namun kos dan usaha untuk melatih model ini dari awal kekal tinggi. Contohnya, StableDiffusion2.1 mengambil masa 200,000 jam A100GPU. Walaupun penyelidik menggunakan kaedah paling maju, ia masih mengambil masa lebih daripada sebulan untuk melatih pada GPU 8×H100. Selain itu, melatih model besar juga menimbulkan cabaran kepada set data Data ini pada asasnya dalam unit ratusan juta, yang juga membawa cabaran kepada model latihan. Kos latihan yang tinggi dan keperluan set data mewujudkan halangan yang tidak dapat diatasi kepada pembangunan model penyebaran berskala besar. Kini, daripada SonyAI dan banyak lagi

2024-07-29

komen 0

525

Latih model YOLOv7 dan bangunkan pengesanan kebakaran AI

Pengenalan Artikel:1. Sediakan set data Set data menggunakan imej sumber terbuka, dengan jumlah imej kebakaran 6k, ditandai dengan asap dan api. Projek Fire and Smoke menggunakan YOLO untuk latihan Saya telah menukar data ke dalam format YOLO dan membahagikannya kepada set latihan dan set pengesahan. Lihat direktori set data. 2. Untuk latihan, sila rujuk dokumentasi laman web rasmi YOLOv7 untuk proses latihan. Ubah suai fail data/coco.yaml dan konfigurasikan laluan dan kategori data latihan. Muat turun model pra-latihan yolov7.pt, dan kemudian anda boleh memulakan latihan 3. Selepas latihan pemantauan kebakaran selesai, cari fail model-best.pt yang dijana dalam direktori run di bawah direktori yolov7. saya berlatih

2023-05-11

komen 0

974

Teknologi Mininglamp mengeluarkan TensorBoard.cpp sumber terbuka percuma untuk mempromosikan pra-latihan model besar

Pengenalan Artikel:Baru-baru ini, Kumpulan Teknologi Mininglamp telah melaksanakan antara muka C++ TensorBoard, alat visualisasi pembelajaran mesin, yang memperkayakan lagi set alatan projek model besar berasaskan C++, menjadikan pemantauan proses pra-latihan model besar lebih mudah dan cekap, dan mempercepatkan besar. model pra-latihan dalam proses pemasaran. Alat ini adalah sumber terbuka pada Github. TensorBoard ialah alat visualisasi pembelajaran mesin yang dibangunkan oleh Google dan sering digunakan untuk memantau pelbagai penunjuk proses pembelajaran mesin. Zhao Liang, pengarah teknikal kanan Mininglamp Technology, berkata: "Dalam proses latihan model besar, pemantauan data adalah dimensi penting, dan TensorBoard menggambarkan pelbagai parameter dan keputusan dalam model, seperti merekodkan perubahan Kerugian dan set pengesahan semasa besar. proses latihan model.

2023-08-14

komen 0

794

Pemampatan pengetahuan: penyulingan model dan pemangkasan model

Pengenalan Artikel:Penyulingan dan pemangkasan model ialah teknologi pemampatan model rangkaian saraf yang mengurangkan parameter dan kerumitan pengiraan secara berkesan, serta meningkatkan kecekapan dan prestasi operasi. Penyulingan model meningkatkan prestasi dengan melatih model yang lebih kecil pada model yang lebih besar, memindahkan pengetahuan. Pemangkasan mengurangkan saiz model dengan mengalih keluar sambungan dan parameter yang berlebihan. Kedua-dua teknik ini sangat berguna untuk pemampatan dan pengoptimuman model. Penyulingan Model Penyulingan model ialah teknik yang mereplikasi kuasa ramalan model besar dengan melatih model yang lebih kecil. Model besar dipanggil "model guru" dan model kecil dipanggil "model pelajar". Model guru biasanya mempunyai lebih banyak parameter dan kerumitan dan oleh itu lebih mampu untuk menyesuaikan data latihan dan ujian. Dalam penyulingan model, model pelajar dilatih untuk meniru tingkah laku yang diramalkan oleh model guru untuk mencapai prestasi yang lebih baik pada model yang lebih kecil.

2024-01-23

komen 0

744

Kaedah penyesuaian untuk melatih model ML

Pengenalan Artikel:Kaedah penyesuaian merujuk kepada penggunaan teknologi pelarasan dinamik dalam model pembelajaran mesin untuk mencapai penyesuaian diri dan penambahbaikan model. Kaedah ini membolehkan model menyesuaikan berdasarkan data masa nyata dan perubahan persekitaran, dengan itu meningkatkan prestasi dan menyesuaikan diri dengan situasi baharu. Kaedah penyesuaian biasa termasuk penyesuaian parameter, pelarasan kadar pembelajaran, pemilihan ciri dan penyepaduan model. Kaedah ini boleh membantu model menyesuaikan diri dalam tugas dan persekitaran yang berbeza, dengan itu meningkatkan ketepatan dan keteguhan model. Pembelajaran tambahan ialah kaedah yang terus memperkenalkan sampel latihan baharu untuk mengemas kini parameter model. Berbanding dengan melatih semula keseluruhan model, pembelajaran tambahan mengelakkan pembaziran sumber dan masa pengkomputeran. Dengan menambah sampel baharu secara berterusan, model boleh menyesuaikan secara beransur-ansur kepada data baharu dan meningkatkan prestasi sambil mengekalkan keberkesanan parameter asal. kaedah ini

2024-01-23

komen 0

1120

Masalah masa latihan model pembelajaran mendalam

Pengenalan Artikel:Pengenalan kepada isu masa latihan model pembelajaran mendalam: Dengan pembangunan pembelajaran mendalam, model pembelajaran mendalam telah mencapai keputusan yang luar biasa dalam pelbagai bidang. Walau bagaimanapun, masa latihan model pembelajaran mendalam adalah masalah biasa. Dalam kes set data berskala besar dan struktur rangkaian yang kompleks, masa latihan model pembelajaran mendalam meningkat dengan ketara. Artikel ini akan membincangkan isu masa latihan model pembelajaran mendalam dan memberikan contoh kod khusus. Pengkomputeran Selari Mempercepatkan Masa Latihan Proses latihan model pembelajaran mendalam biasanya memerlukan sejumlah besar sumber dan masa pengkomputeran. Bagi mempercepatkan latihan

2023-10-09

komen 0

1712

Model pra-latihan Teks-ke-SQL dua peringkat berbilang tugas MIGA berdasarkan T5

Pengenalan Artikel:Semakin banyak kerja telah membuktikan bahawa model bahasa pra-latihan (PLM) mengandungi pengetahuan yang kaya Untuk tugasan yang berbeza, menggunakan kaedah latihan yang sesuai untuk memanfaatkan PLM boleh meningkatkan keupayaan model dengan lebih baik. Dalam tugas Text-to-SQL, penjana arus perdana semasa adalah berdasarkan pepohon sintaks dan perlu direka bentuk untuk sintaks SQL. Baru-baru ini, NetEase Interactive Entertainment AI Lab bekerjasama dengan Guangdong University of Foreign Studies dan Columbia University untuk mencadangkan dua peringkat model pra-latihan pelbagai tugas MIGA berdasarkan kaedah pra-latihan model bahasa pra-latihan T5. MIGA memperkenalkan tiga tugas tambahan dalam peringkat pra-latihan dan menyusunnya ke dalam paradigma tugas penjanaan bersatu, yang boleh menyepadukan semua set data Teks-ke-SQL

2023-04-13

komen 0

1297

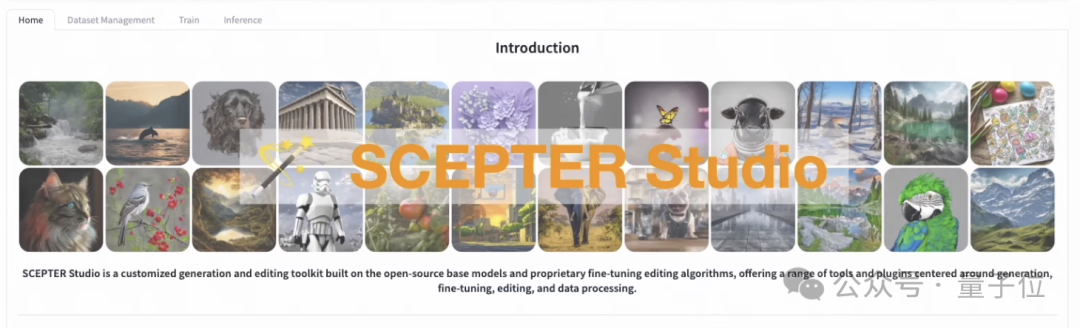

Latihan model lukisan AI kepada penaakulan boleh dilakukan dengan halaman web

Pengenalan Artikel:Anda boleh melatih model lukisan AI walaupun anda tidak tahu cara menulis kod! Dengan bantuan rangka kerja ini, segala-galanya daripada latihan kepada inferens boleh dikendalikan dalam satu hentian, dan berbilang model boleh diuruskan pada satu masa. Pasukan Alibaba melancarkan dan sumber terbuka SCEPTERStudio, meja kerja penjanaan imej universal. Dengan itu, anda boleh melengkapkan latihan model dan penalaan halus terus dalam antara muka web tanpa pengekodan dan mengurus data berkaitan. Pasukan itu juga melancarkan DEMO dengan tiga model terbina dalam, membolehkan anda mengalami fungsi inferens SCEPTER dalam talian. Jadi mari kita lihat apa yang SCEPTER boleh lakukan secara khusus! Pengurusan sehenti model lukisan Dengan SCEPTER, program menulis tidak lagi diperlukan. Latihan dan penalaan halus boleh diselesaikan hanya dengan memilih model dan melaraskan parameter pada halaman web.

2024-02-19

komen 0

1093