Jumlah kandungan berkaitan 10000

Penjelasan terperinci tentang model pra-latihan pembelajaran mendalam dalam Python

Pengenalan Artikel:Dengan perkembangan kecerdasan buatan dan pembelajaran mendalam, model pra-latihan telah menjadi teknologi popular dalam pemprosesan bahasa semula jadi (NLP), penglihatan komputer (CV), pengecaman pertuturan dan bidang lain. Sebagai salah satu bahasa pengaturcaraan yang paling popular pada masa ini, Python secara semula jadi memainkan peranan penting dalam penerapan model pra-latihan. Artikel ini akan menumpukan pada model pra-latihan pembelajaran mendalam dalam Python, termasuk definisi, jenis, aplikasi dan cara menggunakan model pra-latihan. Apakah model pralatihan? Kesukaran utama model pembelajaran mendalam adalah untuk menganalisis sejumlah besar model yang berkualiti tinggi

2023-06-11

komen 0

2012

CMU bergabung tenaga dengan Adobe: Model GAN menyambut era pra-latihan, hanya memerlukan 1% sampel latihan

Pengenalan Artikel:Selepas memasuki era pra-latihan, prestasi model pengecaman visual telah berkembang pesat, tetapi model penjanaan imej, seperti rangkaian musuh generatif (GAN), nampaknya telah ketinggalan. Biasanya latihan GAN dilakukan dari awal tanpa pengawasan, yang memakan masa dan memerlukan tenaga kerja "ilmu" yang dipelajari melalui data besar dalam pra-latihan berskala besar tidak digunakan. Selain itu, penjanaan imej itu sendiri perlu dapat menangkap dan mensimulasikan data statistik yang kompleks dalam fenomena visual dunia sebenar Jika tidak, imej yang dihasilkan tidak akan mematuhi undang-undang dunia fizikal dan akan dikenal pasti secara langsung sebagai "palsu" pada sesuatu. sepintas lalu. Model pra-latihan memberikan pengetahuan, dan model GAN menyediakan keupayaan penjanaan Gabungan kedua-duanya boleh menjadi perkara yang indah! Persoalannya, model pra-latihan manakah dan cara menggabungkannya boleh meningkatkan keupayaan penjanaan model GAN

2023-05-11

komen 0

1474

Kepentingan prapemprosesan data dalam latihan model

Pengenalan Artikel:Kepentingan prapemprosesan data dalam latihan model dan contoh kod khusus Pengenalan: Dalam proses melatih pembelajaran mesin dan model pembelajaran mendalam, prapemprosesan data ialah pautan yang sangat penting dan penting. Tujuan prapemprosesan data adalah untuk mengubah data mentah kepada bentuk yang sesuai untuk latihan model melalui satu siri langkah pemprosesan untuk meningkatkan prestasi dan ketepatan model. Artikel ini bertujuan untuk membincangkan kepentingan prapemprosesan data dalam latihan model dan memberikan beberapa contoh kod prapemprosesan data yang biasa digunakan. 1. Kepentingan prapemprosesan data Pembersihan data Pembersihan data ialah

2023-10-08

komen 0

1288

Apple menggunakan model bahasa autoregresif untuk pra-melatih model imej

Pengenalan Artikel:1. Latar Belakang Selepas kemunculan model besar seperti GPT, kaedah pemodelan Transformer + autoregressive model bahasa, yang merupakan tugas pra-latihan untuk meramal nexttoken, telah mencapai kejayaan besar. Jadi, bolehkah kaedah pemodelan autoregresif ini mencapai hasil yang lebih baik dalam model visual? Artikel yang diperkenalkan hari ini ialah artikel yang diterbitkan oleh Apple baru-baru ini tentang melatih model visual berdasarkan latihan pra-latihan Transformer+autoregressive Izinkan saya memperkenalkan karya ini kepada anda. Tajuk kertas gambar: ScalablePra-trainingofLargeAutoregressiveImageModels Alamat muat turun: https://ar

2024-01-29

komen 0

1020

Bagaimanakah rangka kerja Java mempercepatkan latihan model kecerdasan buatan?

Pengenalan Artikel:Rangka kerja Java boleh mempercepatkan latihan model kecerdasan buatan dengan: menggunakan TensorFlowServing untuk menggunakan model pra-latihan untuk inferens pantas menggunakan H2OAI DriverlessAI untuk mengautomasikan proses latihan dan menggunakan pengkomputeran teragih untuk memendekkan masa latihan menggunakan SparkMLlib untuk melaksanakan latihan teragih dan berskala besar; data pada pemprosesan Set seni bina Apache Spark.

2024-06-04

komen 0

906

Model pra-latihan Teks-ke-SQL dua peringkat berbilang tugas MIGA berdasarkan T5

Pengenalan Artikel:Semakin banyak kerja telah membuktikan bahawa model bahasa pra-latihan (PLM) mengandungi pengetahuan yang kaya Untuk tugasan yang berbeza, menggunakan kaedah latihan yang sesuai untuk memanfaatkan PLM boleh meningkatkan keupayaan model dengan lebih baik. Dalam tugas Text-to-SQL, penjana arus perdana semasa adalah berdasarkan pepohon sintaks dan perlu direka bentuk untuk sintaks SQL. Baru-baru ini, NetEase Interactive Entertainment AI Lab bekerjasama dengan Guangdong University of Foreign Studies dan Columbia University untuk mencadangkan dua peringkat model pra-latihan pelbagai tugas MIGA berdasarkan kaedah pra-latihan model bahasa pra-latihan T5. MIGA memperkenalkan tiga tugas tambahan dalam peringkat pra-latihan dan menyusunnya ke dalam paradigma tugas penjanaan bersatu, yang boleh menyepadukan semua set data Teks-ke-SQL

2023-04-13

komen 0

1311

Latih model YOLOv7 dan bangunkan pengesanan kebakaran AI

Pengenalan Artikel:1. Sediakan set data Set data menggunakan imej sumber terbuka, dengan jumlah imej kebakaran 6k, ditandai dengan asap dan api. Projek Fire and Smoke menggunakan YOLO untuk latihan Saya telah menukar data ke dalam format YOLO dan membahagikannya kepada set latihan dan set pengesahan. Lihat direktori set data. 2. Untuk latihan, sila rujuk dokumentasi laman web rasmi YOLOv7 untuk proses latihan. Ubah suai fail data/coco.yaml dan konfigurasikan laluan dan kategori data latihan. Muat turun model pra-latihan yolov7.pt, dan kemudian anda boleh memulakan latihan 3. Selepas latihan pemantauan kebakaran selesai, cari fail model-best.pt yang dijana dalam direktori run di bawah direktori yolov7. saya berlatih

2023-05-11

komen 0

996

Teknologi Mininglamp mengeluarkan TensorBoard.cpp sumber terbuka percuma untuk mempromosikan pra-latihan model besar

Pengenalan Artikel:Baru-baru ini, Kumpulan Teknologi Mininglamp telah melaksanakan antara muka C++ TensorBoard, alat visualisasi pembelajaran mesin, yang memperkayakan lagi set alatan projek model besar berasaskan C++, menjadikan pemantauan proses pra-latihan model besar lebih mudah dan cekap, dan mempercepatkan besar. model pra-latihan dalam proses pemasaran. Alat ini adalah sumber terbuka pada Github. TensorBoard ialah alat visualisasi pembelajaran mesin yang dibangunkan oleh Google dan sering digunakan untuk memantau pelbagai penunjuk proses pembelajaran mesin. Zhao Liang, pengarah teknikal kanan Mininglamp Technology, berkata: "Dalam proses latihan model besar, pemantauan data adalah dimensi penting, dan TensorBoard menggambarkan pelbagai parameter dan keputusan dalam model, seperti merekodkan perubahan Kerugian dan set pengesahan semasa besar. proses latihan model.

2023-08-14

komen 0

822

CVPR 2024 |. Pra-latihan ruang masa empat dimensi model dunia pemanduan autonomi

Pengenalan Artikel:Universiti Peking dan pasukan inovasi EVLO bersama-sama mencadangkan DriveWorld, algoritma pra-latihan ruang masa empat dimensi untuk pemanduan autonomi. Kaedah ini menggunakan model dunia untuk pra-latihan, mereka bentuk model ruang keadaan memori untuk pemodelan spatio-temporal empat dimensi, dan mengurangkan ketidakpastian rawak dan ketidakpastian pengetahuan yang dihadapi oleh pemanduan autonomi dengan meramalkan grid pekerjaan tempat kejadian. Kertas kerja ini telah diterima oleh CVPR2024. Tajuk kertas: DriveWorld: 4DPPre-trainedSceneUnderstandingviaWorldModelsforAutonomousDriving Paper pautan: https://arxiv.org/abs/2405.04390 1. Motion

2024-08-07

komen 0

846

Daripada BERT ke ChatGPT, tinjauan menyeluruh sembilan institusi penyelidikan terkemuka termasuk Universiti Beihang: 'model asas pra-latihan' yang telah kami usahakan bersama selama ini

Pengenalan Artikel:Prestasi menakjubkan ChatGPT dalam senario beberapa pukulan dan sifar pukulan telah menjadikan penyelidik lebih bertekad bahawa "pra-latihan" adalah laluan yang betul. Model asas pra-latihan (PretrainedFoundationModels,PFM) dianggap sebagai asas untuk pelbagai tugas hiliran di bawah mod data yang berbeza, iaitu, berdasarkan data berskala besar, model asas pra-latihan seperti BERT, GPT-3, MAE, DALLE- E dan ChatGPT dilatih, menyediakan permulaan parameter yang munasabah untuk aplikasi hiliran. Idea pra-latihan di sebalik PFM memainkan peranan penting dalam aplikasi model besar Berbeza daripada kaedah pengekstrakan ciri sebelum ini menggunakan modul konvolusi dan rekursif, yang baharu

2023-04-15

komen 0

1463

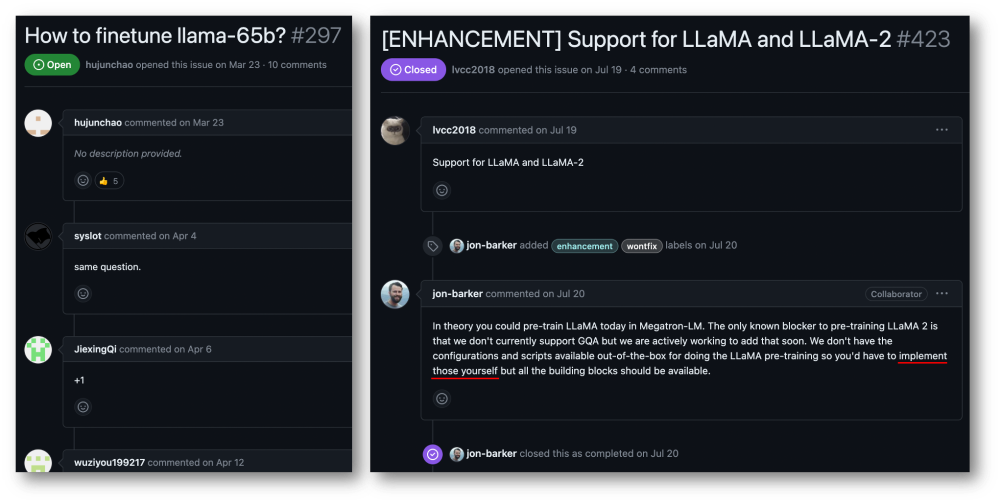

32-kad 176% pecutan latihan, rangka kerja latihan model besar sumber terbuka Megatron-LLaMA ada di sini

Pengenalan Artikel:Kumpulan Taotian dan Teknologi Aicheng secara rasmi mengeluarkan rangka kerja latihan model besar sumber terbuka - Megatron-LLaMA pada 12 September. Matlamat rangka kerja ini adalah untuk memudahkan pembangun teknologi meningkatkan prestasi latihan model bahasa besar, mengurangkan kos latihan dan mengekalkan keserasian dengan komuniti LLaMA. Keputusan ujian menunjukkan bahawa pada latihan 32-kad, Megatron-LLaMA boleh mencapai pecutan 176% berbanding dengan versi kod yang diperoleh secara langsung pada HuggingFace pada latihan berskala besar, Megatron-LLaMA berkembang hampir secara linear dan tidak stabil kepada rangkaian tahap toleransi yang tinggi. Pada masa ini, Megatron-LLaMA telah dilancarkan dalam komuniti sumber terbuka di alamat sumber terbuka: https:

2023-09-14

komen 0

633

Kesan kekurangan data terhadap latihan model

Pengenalan Artikel:Kesan kekurangan data pada latihan model memerlukan contoh kod khusus Dalam bidang pembelajaran mesin dan kecerdasan buatan, data ialah salah satu elemen teras untuk model latihan. Walau bagaimanapun, masalah yang sering kita hadapi dalam realiti adalah kekurangan data. Kekurangan data merujuk kepada jumlah data latihan yang tidak mencukupi atau kekurangan data beranotasi Dalam kes ini, ia akan memberi kesan tertentu pada latihan model. Masalah kekurangan data terutamanya dicerminkan dalam aspek-aspek berikut: Overfitting: Apabila jumlah data latihan tidak mencukupi, model terdedah kepada overfitting. Overfitting merujuk kepada model yang terlalu menyesuaikan diri dengan data latihan.

2023-10-08

komen 0

1413

Panduan latihan model ChatGPT Python: langkah untuk menyesuaikan chatbot

Pengenalan Artikel:Panduan latihan model ChatGPTPython: Gambaran keseluruhan langkah untuk menyesuaikan robot sembang: Dalam beberapa tahun kebelakangan ini, dengan peningkatan pembangunan teknologi NLP (pemprosesan bahasa semula jadi), robot sembang telah menarik lebih banyak perhatian. ChatGPT OpenAI ialah model bahasa pra-latihan yang berkuasa yang boleh digunakan untuk membina chatbot berbilang domain. Artikel ini akan memperkenalkan langkah-langkah untuk menggunakan Python untuk melatih model ChatGPT, termasuk penyediaan data, latihan model dan penjanaan sampel dialog. Langkah 1: Penyediaan, pengumpulan dan pembersihan data

2023-10-24

komen 0

1334

Adakah latihan model besar lebih sukar daripada mencapai langit? Perpustakaan model 'Li Bai' yang telah terlatih, mudah digunakan dan sangat cekap ada di sini!

Pengenalan Artikel:Pustaka model LiBai merangkumi kelebihan semua perpustakaan Transformer arus perdana seperti Hugging Face, Megatron-LM, DeepSpeed dan FairSeq, menjadikan latihan model besar boleh diakses oleh orang biasa. Terdapat begitu banyak model besar, beritahu saya bagaimana untuk mempercepatkannya? Sejak kelahiran BERT pada 2018, model dengan ratusan juta parameter seperti GPT-3 dan ViT terus muncul. rasa kebas. Pada masa yang sama, model besar menimbulkan cabaran besar kepada sumber pengkomputeran dan ingatan. Kos latihan meningkat dengan mendadak, seperti menggunakan NVIDIA A yang sangat maju

2023-04-09

komen 0

1380

Prinsip dan aplikasi pensampelan penolakan dalam latihan model besar

Pengenalan Artikel:Persampelan penolakan ialah teknik biasa dalam latihan model bahasa besar. Ia mengambil sampel berdasarkan fungsi ketumpatan kebarangkalian taburan sasaran untuk menghasilkan sampel yang sesuai dengan taburan sasaran. Tujuan pensampelan penolakan adalah untuk meningkatkan kepelbagaian data latihan, dengan itu meningkatkan keupayaan generalisasi model. Kaedah ini amat penting dalam latihan model bahasa kerana ia dapat membantu model mempelajari ungkapan bahasa yang lebih kaya dan tepat. Dengan menolak pensampelan, model boleh menghasilkan teks daripada perspektif dan gaya yang berbeza, menjadikannya lebih mudah disesuaikan dan kreatif. Dengan cara ini, model boleh meramalkan perkataan atau frasa seterusnya dengan lebih tepat apabila memproses pelbagai jenis teks, dengan itu meningkatkan kualiti penjanaan keseluruhan. Penggunaan pensampelan penolakan juga dapat mengurangkan latihan pensampelan penolakan adalah asas

2024-01-22

komen 0

1296

Perpustakaan sambungan latihan teragih sumber terbuka Ant AToch mencapai kadar penggunaan berkesan sebanyak 60% kuasa pengkomputeran latihan model besar

Pengenalan Artikel:Ant Group baru-baru ini mengumumkan pelancaran perpustakaan sambungan pecutan latihan teragih model besar yang dipanggil ATorch, alat sumber terbuka. Matlamat ATorch adalah untuk membantu meningkatkan kecerdasan pembelajaran mendalam melalui pengoptimuman dinamik sumber automatik dan peningkatan kestabilan latihan yang diedarkan. Difahamkan bahawa dalam latihan model besar, ATorch boleh meningkatkan kadar penggunaan kuasa pengkomputeran latihan tahap kilokalori ratusan bilion model kepada 60%, yang bersamaan dengan menambah enjin berkuasa pada kereta sport. Ini akan menjadi alat penting untuk penyelidik dan pembangun pembelajaran mendalam untuk membantu mereka melatih dan mengoptimumkan model besar dengan lebih cekap. Rajah: ATorch komited untuk menjadikan latihan model besar lebih cekap dan boleh dihasilkan semula Dengan letupan model besar generatif, skala set data dan parameter untuk latihan model telah meningkat secara eksponen.

2024-01-14

komen 0

1432

Latihan tersuai bagi model pembelajaran mendalam menggunakan teknik pembelajaran pemindahan

Pengenalan Artikel:Penterjemah |. Pengulas oleh Zhu Xianzhong |. Sun Shujuan Transfer learning ialah satu kaedah yang digunakan pada rangkaian saraf yang telah dilatih atau dilatih, dan rangkaian saraf yang telah dilatih ini dibina menggunakan berjuta-juta data yang terlatih. mata. Penggunaan teknologi ini yang paling terkenal pada masa ini adalah untuk melatih rangkaian saraf dalam, kerana kaedah ini telah menunjukkan prestasi yang baik dalam melatih rangkaian saraf dalam menggunakan kurang data. Malah, teknik ini juga berguna dalam bidang sains data, kerana kebanyakan data dunia sebenar biasanya tidak mempunyai berjuta-juta titik data untuk melatih model pembelajaran mendalam yang mantap. Pada masa ini, banyak model wujud yang dilatih menggunakan berjuta-juta titik data dan boleh digunakan untuk melatih rangkaian saraf pembelajaran mendalam yang kompleks dengan ketepatan maksimum.

2023-04-23

komen 0

1701