Jumlah kandungan berkaitan 10000

Kepentingan prapemprosesan data dalam latihan model

Pengenalan Artikel:Kepentingan prapemprosesan data dalam latihan model dan contoh kod khusus Pengenalan: Dalam proses melatih pembelajaran mesin dan model pembelajaran mendalam, prapemprosesan data ialah pautan yang sangat penting dan penting. Tujuan prapemprosesan data adalah untuk mengubah data mentah kepada bentuk yang sesuai untuk latihan model melalui satu siri langkah pemprosesan untuk meningkatkan prestasi dan ketepatan model. Artikel ini bertujuan untuk membincangkan kepentingan prapemprosesan data dalam latihan model dan memberikan beberapa contoh kod prapemprosesan data yang biasa digunakan. 1. Kepentingan prapemprosesan data Pembersihan data Pembersihan data ialah

2023-10-08

komen 0

1234

Apple menggunakan model bahasa autoregresif untuk pra-melatih model imej

Pengenalan Artikel:1. Latar Belakang Selepas kemunculan model besar seperti GPT, kaedah pemodelan Transformer + autoregressive model bahasa, yang merupakan tugas pra-latihan untuk meramal nexttoken, telah mencapai kejayaan besar. Jadi, bolehkah kaedah pemodelan autoregresif ini mencapai hasil yang lebih baik dalam model visual? Artikel yang diperkenalkan hari ini ialah artikel yang diterbitkan oleh Apple baru-baru ini tentang melatih model visual berdasarkan latihan pra-latihan Transformer+autoregressive Izinkan saya memperkenalkan karya ini kepada anda. Tajuk kertas gambar: ScalablePra-trainingofLargeAutoregressiveImageModels Alamat muat turun: https://ar

2024-01-29

komen 0

976

Bagaimanakah rangka kerja Java mempercepatkan latihan model kecerdasan buatan?

Pengenalan Artikel:Rangka kerja Java boleh mempercepatkan latihan model kecerdasan buatan dengan: menggunakan TensorFlowServing untuk menggunakan model pra-latihan untuk inferens pantas menggunakan H2OAI DriverlessAI untuk mengautomasikan proses latihan dan menggunakan pengkomputeran teragih untuk memendekkan masa latihan menggunakan SparkMLlib untuk melaksanakan latihan teragih dan berskala besar; data pada pemprosesan Set seni bina Apache Spark.

2024-06-04

komen 0

870

CVPR 2024 |. Pra-latihan ruang masa empat dimensi model dunia pemanduan autonomi

Pengenalan Artikel:Universiti Peking dan pasukan inovasi EVLO bersama-sama mencadangkan DriveWorld, algoritma pra-latihan ruang masa empat dimensi untuk pemanduan autonomi. Kaedah ini menggunakan model dunia untuk pra-latihan, mereka bentuk model ruang keadaan memori untuk pemodelan spatio-temporal empat dimensi, dan mengurangkan ketidakpastian rawak dan ketidakpastian pengetahuan yang dihadapi oleh pemanduan autonomi dengan meramalkan grid pekerjaan tempat kejadian. Kertas kerja ini telah diterima oleh CVPR2024. Tajuk kertas: DriveWorld: 4DPPre-trainedSceneUnderstandingviaWorldModelsforAutonomousDriving Paper pautan: https://arxiv.org/abs/2405.04390 1. Motion

2024-08-07

komen 0

784

Teknologi Mininglamp mengeluarkan TensorBoard.cpp sumber terbuka percuma untuk mempromosikan pra-latihan model besar

Pengenalan Artikel:Baru-baru ini, Kumpulan Teknologi Mininglamp telah melaksanakan antara muka C++ TensorBoard, alat visualisasi pembelajaran mesin, yang memperkayakan lagi set alatan projek model besar berasaskan C++, menjadikan pemantauan proses pra-latihan model besar lebih mudah dan cekap, dan mempercepatkan besar. model pra-latihan dalam proses pemasaran. Alat ini adalah sumber terbuka pada Github. TensorBoard ialah alat visualisasi pembelajaran mesin yang dibangunkan oleh Google dan sering digunakan untuk memantau pelbagai penunjuk proses pembelajaran mesin. Zhao Liang, pengarah teknikal kanan Mininglamp Technology, berkata: "Dalam proses latihan model besar, pemantauan data adalah dimensi penting, dan TensorBoard menggambarkan pelbagai parameter dan keputusan dalam model, seperti merekodkan perubahan Kerugian dan set pengesahan semasa besar. proses latihan model.

2023-08-14

komen 0

766

Masalah masa latihan model pembelajaran mendalam

Pengenalan Artikel:Pengenalan kepada isu masa latihan model pembelajaran mendalam: Dengan pembangunan pembelajaran mendalam, model pembelajaran mendalam telah mencapai keputusan yang luar biasa dalam pelbagai bidang. Walau bagaimanapun, masa latihan model pembelajaran mendalam adalah masalah biasa. Dalam kes set data berskala besar dan struktur rangkaian yang kompleks, masa latihan model pembelajaran mendalam meningkat dengan ketara. Artikel ini akan membincangkan isu masa latihan model pembelajaran mendalam dan memberikan contoh kod khusus. Pengkomputeran Selari Mempercepatkan Masa Latihan Proses latihan model pembelajaran mendalam biasanya memerlukan sejumlah besar sumber dan masa pengkomputeran. Bagi mempercepatkan latihan

2023-10-09

komen 0

1693

Kesan kekurangan data terhadap latihan model

Pengenalan Artikel:Kesan kekurangan data pada latihan model memerlukan contoh kod khusus Dalam bidang pembelajaran mesin dan kecerdasan buatan, data ialah salah satu elemen teras untuk model latihan. Walau bagaimanapun, masalah yang sering kita hadapi dalam realiti adalah kekurangan data. Kekurangan data merujuk kepada jumlah data latihan yang tidak mencukupi atau kekurangan data beranotasi Dalam kes ini, ia akan memberi kesan tertentu pada latihan model. Masalah kekurangan data terutamanya dicerminkan dalam aspek-aspek berikut: Overfitting: Apabila jumlah data latihan tidak mencukupi, model terdedah kepada overfitting. Overfitting merujuk kepada model yang terlalu menyesuaikan diri dengan data latihan.

2023-10-08

komen 0

1345

Panduan latihan model ChatGPT Python: langkah untuk menyesuaikan chatbot

Pengenalan Artikel:Panduan latihan model ChatGPTPython: Gambaran keseluruhan langkah untuk menyesuaikan robot sembang: Dalam beberapa tahun kebelakangan ini, dengan peningkatan pembangunan teknologi NLP (pemprosesan bahasa semula jadi), robot sembang telah menarik lebih banyak perhatian. ChatGPT OpenAI ialah model bahasa pra-latihan yang berkuasa yang boleh digunakan untuk membina chatbot berbilang domain. Artikel ini akan memperkenalkan langkah-langkah untuk menggunakan Python untuk melatih model ChatGPT, termasuk penyediaan data, latihan model dan penjanaan sampel dialog. Langkah 1: Penyediaan, pengumpulan dan pembersihan data

2023-10-24

komen 0

1284

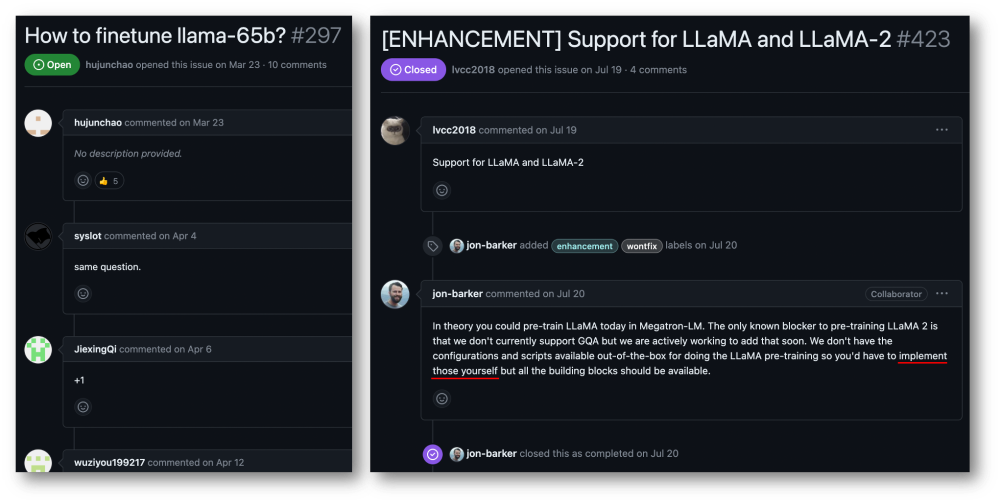

32-kad 176% pecutan latihan, rangka kerja latihan model besar sumber terbuka Megatron-LLaMA ada di sini

Pengenalan Artikel:Kumpulan Taotian dan Teknologi Aicheng secara rasmi mengeluarkan rangka kerja latihan model besar sumber terbuka - Megatron-LLaMA pada 12 September. Matlamat rangka kerja ini adalah untuk memudahkan pembangun teknologi meningkatkan prestasi latihan model bahasa besar, mengurangkan kos latihan dan mengekalkan keserasian dengan komuniti LLaMA. Keputusan ujian menunjukkan bahawa pada latihan 32-kad, Megatron-LLaMA boleh mencapai pecutan 176% berbanding dengan versi kod yang diperoleh secara langsung pada HuggingFace pada latihan berskala besar, Megatron-LLaMA berkembang hampir secara linear dan tidak stabil kepada rangkaian tahap toleransi yang tinggi. Pada masa ini, Megatron-LLaMA telah dilancarkan dalam komuniti sumber terbuka di alamat sumber terbuka: https:

2023-09-14

komen 0

590

Latihan Llama3 ranap setiap 3 jam? Model pundi kacang besar dan pasukan HKU meningkatkan latihan Wanka yang rangup

Pengenalan Artikel:Apabila kelajuan lelaran model besar menjadi lebih pantas dan lebih pantas, skala kluster latihan menjadi lebih besar dan lebih besar, dan kegagalan perisian dan perkakasan frekuensi tinggi telah menjadi titik kesakitan yang menghalang peningkatan kecekapan latihan selanjutnya penyimpanan dan pemulihan keadaan semasa proses latihan , telah menjadi kunci untuk mengatasi kegagalan latihan, memastikan kemajuan latihan dan meningkatkan kecekapan latihan. Baru-baru ini, pasukan model ByteDance Beanbao dan Universiti Hong Kong bersama-sama mencadangkan ByteCheckpoint. Ini ialah sistem Checkpointing model besar yang berasal dari PyTorch, serasi dengan pelbagai rangka kerja latihan, dan menyokong pembacaan dan penulisan Checkpoint yang cekap dan pembahagian semula automatik Berbanding dengan kaedah sedia ada, ia mempunyai peningkatan prestasi yang ketara dan kelebihan kemudahan penggunaan. Artikel ini memperkenalkan latihan model besar

2024-08-08

komen 0

570

Perpustakaan sambungan latihan teragih sumber terbuka Ant AToch mencapai kadar penggunaan berkesan sebanyak 60% kuasa pengkomputeran latihan model besar

Pengenalan Artikel:Ant Group baru-baru ini mengumumkan pelancaran perpustakaan sambungan pecutan latihan teragih model besar yang dipanggil ATorch, alat sumber terbuka. Matlamat ATorch adalah untuk membantu meningkatkan kecerdasan pembelajaran mendalam melalui pengoptimuman dinamik sumber automatik dan peningkatan kestabilan latihan yang diedarkan. Difahamkan bahawa dalam latihan model besar, ATorch boleh meningkatkan kadar penggunaan kuasa pengkomputeran latihan tahap kilokalori ratusan bilion model kepada 60%, yang bersamaan dengan menambah enjin berkuasa pada kereta sport. Ini akan menjadi alat penting untuk penyelidik dan pembangun pembelajaran mendalam untuk membantu mereka melatih dan mengoptimumkan model besar dengan lebih cekap. Rajah: ATorch komited untuk menjadikan latihan model besar lebih cekap dan boleh dihasilkan semula Dengan letupan model besar generatif, skala set data dan parameter untuk latihan model telah meningkat secara eksponen.

2024-01-14

komen 0

1386

Bagaimana untuk melaksanakan algoritma yang diedarkan dan latihan model dalam perkhidmatan mikro PHP

Pengenalan Artikel:Cara melaksanakan algoritma teragih dan latihan model dalam perkhidmatan mikro PHP Pengenalan: Dengan perkembangan pesat pengkomputeran awan dan teknologi data besar, permintaan untuk pemprosesan data dan latihan model semakin meningkat. Algoritma dan latihan model yang diedarkan adalah kunci untuk mencapai kecekapan, kelajuan dan kebolehskalaan. Artikel ini akan memperkenalkan cara melaksanakan algoritma teragih dan latihan model dalam perkhidmatan mikro PHP dan menyediakan beberapa contoh kod khusus. 1. Apakah yang dimaksudkan dengan latihan algoritma dan model yang diedarkan ialah teknologi yang menggunakan pelbagai mesin atau sumber pelayan untuk melaksanakan pemprosesan data dan latihan model secara serentak.

2023-09-25

komen 0

1399

Model pra-latihan khusus untuk domain NLP bioperubatan: PubMedBERT

Pengenalan Artikel:Perkembangan pesat model bahasa besar tahun ini telah menyebabkan model seperti BERT kini dipanggil model "kecil". Dalam pertandingan peperiksaan sains LLM Kaggle, pemain yang menggunakan deberta mencapai tempat keempat, yang merupakan keputusan yang cemerlang. Oleh itu, dalam domain atau keperluan tertentu, model bahasa yang besar tidak semestinya diperlukan sebagai penyelesaian terbaik, dan model kecil juga mempunyai tempatnya. Oleh itu, apa yang akan kami perkenalkan hari ini ialah PubMedBERT, sebuah kertas kerja yang diterbitkan oleh Microsoft Research di ACM pada tahun 2022. Model ini melatih BERT dari awal dengan menggunakan korpora khusus domain Berikut adalah perkara utama kertas kerja: Untuk pengguna dengan domain khusus dengan sejumlah besar teks tidak berlabel, seperti bioperubatan, pra-latihan dari awal

2023-11-27

komen 0

1194

Prinsip dan aplikasi pensampelan penolakan dalam latihan model besar

Pengenalan Artikel:Persampelan penolakan ialah teknik biasa dalam latihan model bahasa besar. Ia mengambil sampel berdasarkan fungsi ketumpatan kebarangkalian taburan sasaran untuk menghasilkan sampel yang sesuai dengan taburan sasaran. Tujuan pensampelan penolakan adalah untuk meningkatkan kepelbagaian data latihan, dengan itu meningkatkan keupayaan generalisasi model. Kaedah ini amat penting dalam latihan model bahasa kerana ia dapat membantu model mempelajari ungkapan bahasa yang lebih kaya dan tepat. Dengan menolak pensampelan, model boleh menghasilkan teks daripada perspektif dan gaya yang berbeza, menjadikannya lebih mudah disesuaikan dan kreatif. Dengan cara ini, model boleh meramalkan perkataan atau frasa seterusnya dengan lebih tepat apabila memproses pelbagai jenis teks, dengan itu meningkatkan kualiti penjanaan keseluruhan. Penggunaan pensampelan penolakan juga dapat mengurangkan latihan pensampelan penolakan adalah asas

2024-01-22

komen 0

1188

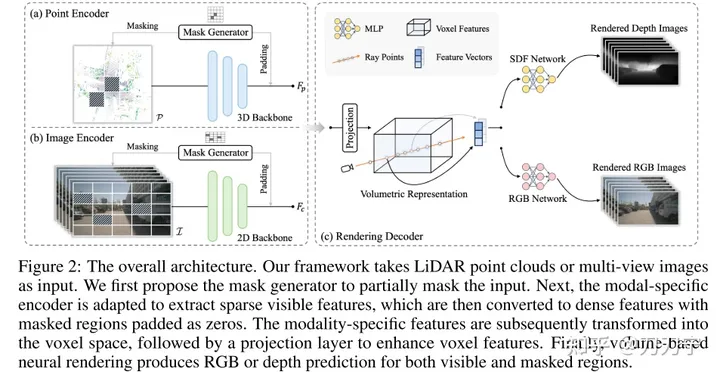

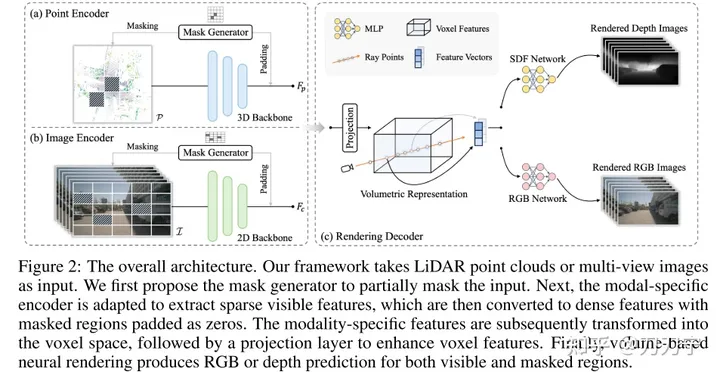

UniPAD: Mod pra-latihan pemanduan autonomi universal! Pelbagai tugas persepsi boleh disokong

Pengenalan Artikel:Baru-baru ini, kelajuan kertas baharu diterbitkan begitu pantas sehingga saya rasa seperti tidak boleh membacanya. Apa yang dapat dilihat ialah gabungan model besar berbilang modal untuk bahasa dan visi telah menjadi konsensus industri Artikel tentang UniPad ini lebih representatif, dengan input berbilang modal dan model asas pra-terlatih model seperti dunia. , dan pada masa yang sama ia mudah dikembangkan kepada pelbagai aplikasi penglihatan tradisional. Ia juga menyelesaikan masalah menggunakan kaedah pra-latihan model bahasa besar pada adegan 3D, sekali gus menyediakan kemungkinan model besar asas persepsi bersatu. UniPAD ialah kaedah pembelajaran diselia sendiri berdasarkan pemaparan MAE dan 3D Ia boleh melatih model asas dengan prestasi cemerlang dan kemudian memperhalusi dan melatih tugas hiliran pada model, seperti anggaran kedalaman, pengesanan sasaran dan pembahagian. Kajian ini mereka bentuk kaedah perwakilan spatial 3D bersatu

2023-11-10

komen 0

901

Menggunakan fungsi JavaScript untuk melaksanakan latihan model pembelajaran mesin

Pengenalan Artikel:Menggunakan fungsi JavaScript untuk melaksanakan latihan model pembelajaran mesin Dengan perkembangan pesat pembelajaran mesin, ramai pembangun telah mula memberi perhatian kepada cara menggunakan JavaScript untuk melaksanakan latihan model pembelajaran mesin di bahagian hadapan. Artikel ini akan memperkenalkan cara menggunakan fungsi JavaScript untuk melaksanakan latihan model pembelajaran mesin dan memberikan contoh kod khusus. Sebelum kita memulakan, kita perlu memahami beberapa konsep penting. Set Data: Latihan model pembelajaran mesin memerlukan set set data berlabel sebagai input. Set data terdiri daripada

2023-11-03

komen 0

1163

Memindahkan aplikasi pembelajaran dan teknologi biasa dalam latihan model bahasa besar

Pengenalan Artikel:Model bahasa besar merujuk kepada model pemprosesan bahasa semula jadi dengan lebih daripada 100 juta parameter. Oleh kerana saiz dan kerumitannya yang besar, latihan model sedemikian memerlukan sumber dan data pengkomputeran yang ketara. Oleh itu, pembelajaran pemindahan telah menjadi kaedah penting untuk melatih model bahasa besar Dengan menggunakan model dan data sedia ada, proses latihan dapat dipercepatkan dan prestasi dapat ditingkatkan. Memindahkan pembelajaran boleh memindahkan parameter dan pengetahuan model yang dilatih pada tugas lain kepada tugas sasaran, dengan itu mengurangkan keperluan data dan masa latihan. Pendekatan ini digunakan secara meluas dalam kedua-dua penyelidikan dan industri, meletakkan asas untuk membina model bahasa yang lebih berkuasa. Memindahkan pembelajaran ialah kaedah yang menggunakan model yang sudah terlatih untuk melaraskan parameternya atau beberapa komponen semasa menyelesaikan tugasan lain. Dalam bidang pemprosesan bahasa semula jadi, pembelajaran pemindahan boleh

2024-01-22

komen 0

880

Maksud Saiz Kelompok dan kesannya terhadap latihan (berkaitan dengan model pembelajaran mesin)

Pengenalan Artikel:BatchSize merujuk kepada jumlah data yang digunakan oleh model pembelajaran mesin setiap kali semasa proses latihan. Ia membahagikan sejumlah besar data kepada kumpulan kecil data untuk latihan model dan pengemaskinian parameter. Kaedah pemprosesan kelompok ini membantu meningkatkan kecekapan latihan dan penggunaan memori. Data latihan biasanya dibahagikan kepada kelompok untuk latihan, dan setiap kelompok mengandungi berbilang sampel. Saiz kelompok (saiz kelompok) merujuk kepada bilangan sampel yang terkandung dalam setiap kelompok. Apabila melatih model, saiz kelompok mempunyai kesan penting ke atas proses latihan. 1. Kelajuan latihan Saiz kelompok (saiz kelompok) memberi kesan kepada kelajuan latihan model. Saiz kelompok yang lebih besar boleh memproses data latihan dengan lebih cepat kerana dalam setiap zaman, saiz kelompok yang lebih besar boleh memproses lebih banyak data secara serentak.

2024-01-23

komen 0

2164

Tajuk yang ditulis semula: Byte melancarkan program pra-latihan visual Vi-PRoM untuk meningkatkan kadar dan kesan kejayaan operasi robot

Pengenalan Artikel:Dalam beberapa tahun kebelakangan ini, pra-latihan visual pada data dunia sebenar berskala besar telah mencapai kemajuan yang ketara, menunjukkan potensi besar dalam pembelajaran robot berasaskan pemerhatian piksel. Walau bagaimanapun, kajian ini berbeza dari segi data pra-latihan, kaedah dan model. Oleh itu, jenis data, kaedah dan model pra-latihan yang boleh membantu kawalan robot dengan lebih baik masih menjadi persoalan terbuka Berdasarkan ini, penyelidik dari pasukan Penyelidikan ByteDance melihat tiga perspektif asas: set data pra-latihan, seni bina model dan latihan. Kaedah-kaedah ini mengkaji secara menyeluruh impak strategi pra-latihan visual ke atas tugasan pengendalian robot, dan menyediakan beberapa keputusan eksperimen penting yang bermanfaat kepada pembelajaran robot. Di samping itu, mereka mencadangkan skim pra-latihan visi untuk operasi robot yang dipanggil Vi-PRoM, yang menggabungkan

2023-09-13

komen 0

849