- Bahagian hadapan

- HTML| CSS| JavaScript| Vue.js

Syor Terkini

-

Php8, saya datang juga

84669 orang belajar

- asas asli

- HTML| CSS| HTML5| CSS3| JavaScript

Syor Terkini

-

Ketahui reka letak tapak web dalam masa 30 minit

152542 orang belajar

- Pengenalan kepada Asas

- MySQL| SQL Server

Syor Terkini

-

Tutorial Video Permulaan Shangguan Oracle kepada Mahir

20005 orang belajar

Syor Terkini

-

Baris pertama kod UNI-APP anda

5487 orang belajar

-

Berkibar dari awal ke pelancaran apl

7821 orang belajar

Syor Terkini

-

-

Tutorial Video PS Kemahiran Asas Sifar

180660 orang belajar

-

Tutorial video UI 16 hari untuk anda bermula

48569 orang belajar

-

Tutorial Video Teknik PS dan Teknik Menghiris

18603 orang belajar

- Klasifikasi Perpustakaan Kelas

- HTTP| TCP/IP| pengaturcaraan asas

Syor Terkini

-

Tutorial Video Pembinaan Persekitaran Awan Alibaba dan Pelancaran Projek

40936 orang belajar

-

-

Tutorial Penting untuk Pengaturcara - Penjelasan Protokol HTTP

1183 orang belajar

-

Tutorial Video Websocket

32909 orang belajar

![[Web front-end] Permulaan pantas Node.js](https://img.php.cn/upload/course/000/000/067/662b5d34ba7c0227.png)

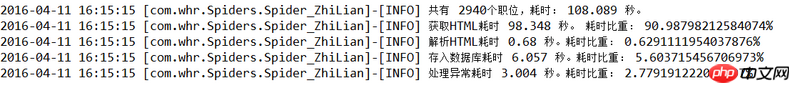

你的耗时分析里已经指出了问题,“获取HTML耗时”占的比重是90%,再看你的代码,业务逻辑是

并不清楚SSH框架中如何处理这个'''getJobs()'''这个函数,但看起来是单线程的,耗时这么久也就不足为奇了。

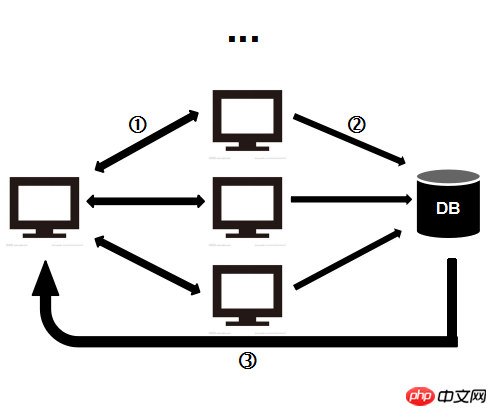

所以,应该把下载页面和处理内容两部分的工作分开来。这就是一个生产者-消费者问题了啊:页面下载的功能是生产者,网络IO明显比处理页慢,可以多开几个线程来进行下载页面工作,放入队列里;内容的分析处理部分是消费者,从队列里拿出页面解析就好,看情况要不要多线程。