手动安装cloudera cdh4.2 hadoop + hbase + hive(一)

安装版本 hadoop-2.0.0-cdh4.2.0hbase-0.94.2-cdh4.2.0hive-0.10.0-cdh4.2.0jdk1.6.0_38 安装前说明 安装目录为/opt 检查hosts文件 关闭防火墙 设置时钟同步 使用说明 安装hadoop、hbase、hive成功之后启动方式为: 启动dfs和mapreduce desktop1上执行start-

安装版本

<code>hadoop-2.0.0-cdh4.2.0 hbase-0.94.2-cdh4.2.0 hive-0.10.0-cdh4.2.0 jdk1.6.0_38 </code>

安装前说明

- 安装目录为/opt

- 检查hosts文件

- 关闭防火墙

- 设置时钟同步

使用说明

安装hadoop、hbase、hive成功之后启动方式为:

- 启动dfs和mapreduce desktop1上执行start-dfs.sh和start-yarn.sh

- 启动hbase desktop3上执行start-hbase.xml

- 启动hive desktop1上执行hive

规划

<code> 192.168.0.1 NameNode、Hive、ResourceManager

192.168.0.2 SSNameNode

192.168.0.3 DataNode、HBase、NodeManager

192.168.0.4 DataNode、HBase、NodeManager

192.168.0.6 DataNode、HBase、NodeManager

192.168.0.7 DataNode、HBase、NodeManager

192.168.0.8 DataNode、HBase、NodeManager

</code>部署过程

系统和网络配置

-

修改每台机器的名称

[root@desktop1 ~]# cat /etc/sysconfig/network NETWORKING=yes HOSTNAME=desktop1

登入後複製 -

在各个节点上修改/etc/hosts增加以下内容:

[root@desktop1 ~]# cat /etc/hosts 127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4 ::1 localhost localhost.localdomain localhost6 localhost6.localdomain6 192.168.0.1 desktop1 192.168.0.2 desktop2 192.168.0.3 desktop3 192.168.0.4 desktop4 192.168.0.6 desktop6 192.168.0.7 desktop7 192.168.0.8 desktop8

登入後複製 -

配置ssh无密码登陆 以下是设置desktop1上可以无密码登陆到其他机器上。

[root@desktop1 ~]# ssh-keygen

[root@desktop1 ~]# ssh-copy-id -i .ssh/id_rsa.pub desktop2

[root@desktop1 ~]# ssh-copy-id -i .ssh/id_rsa.pub desktop3

[root@desktop1 ~]# ssh-copy-id -i .ssh/id_rsa.pub desktop4

[root@desktop1 ~]# ssh-copy-id -i .ssh/id_rsa.pub desktop6

[root@desktop1 ~]# ssh-copy-id -i .ssh/id_rsa.pub desktop7

[root@desktop1 ~]# ssh-copy-id -i .ssh/id_rsa.pub desktop8

- 每台机器上关闭防火墙:

<code> [root@desktop1 ~]# service iptables stop </code>

安装Hadoop

配置Hadoop

将jdk1.6.0_38.zip上传到/opt,并解压缩。 将hadoop-2.0.0-cdh4.2.0.zip上传到/opt,并解压缩。

在NameNode上配置以下文件:

<code>core-site.xml fs.defaultFS指定NameNode文件系统,开启回收站功能。

hdfs-site.xml

dfs.namenode.name.dir指定NameNode存储meta和editlog的目录,

dfs.datanode.data.dir指定DataNode存储blocks的目录,

dfs.namenode.secondary.http-address指定Secondary NameNode地址。

开启WebHDFS。

slaves 添加DataNode节点主机

</code>- core-site.xml 该文件指定fs.defaultFS连接desktop1,即NameNode节点。

<code>[root@desktop1 hadoop]# pwd

/opt/hadoop-2.0.0-cdh4.2.0/etc/hadoop

[root@desktop1 hadoop]# cat core-site.xml

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<!--fs.default.name for MRV1 ,fs.defaultFS for MRV2(yarn) -->

<property>

<name>fs.defaultFS</name>

<!--这个地方的值要和hdfs-site.xml文件中的dfs.federation.nameservices一致-->

<value>hdfs://desktop1</value>

</property>

<property>

<name>fs.trash.interval</name>

<value>10080</value>

</property>

<property>

<name>fs.trash.checkpoint.interval</name>

<value>10080</value>

</property>

</configuration>

</code>- hdfs-site.xml 该文件主要设置数据副本保存份数,以及namenode、datanode数据保存路径以及http-address。

<code>[root@desktop1 hadoop]# cat hdfs-site.xml

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/data/hadoop-${user.name}</value>

</property>

<property>

<name>dfs.namenode.http-address</name>

<value>desktop1:50070</value>

</property>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>desktop2:50090</value>

</property>

<property>

<name>dfs.webhdfs.enabled</name>

<value>true</value>

</property>

</configuration>

</code>- masters 设置namenode和secondary namenode节点。

<code>[root@desktop1 hadoop]# cat masters desktop1 desktop2 </code>

- slaves 设置哪些机器上安装datanode节点。

<code>[root@desktop1 hadoop]# cat slaves desktop3 desktop4 desktop6 desktop7 desktop8 </code>

配置MapReduce

- mapred-site.xml 配置使用yarn计算框架,以及jobhistory的地址。

<code>[root@desktop1 hadoop]# cat mapred-site.xml <?xml version="1.0"?> <?xml-stylesheet type="text/xsl" href="configuration.xsl"?> <configuration> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> <property> <name>mapreduce.jobhistory.address</name> <value>desktop1:10020</value> </property> <property> <name>mapreduce.jobhistory.webapp.address</name> <value>desktop1:19888</value> </property> </configuration> </code>

- yarn-site.xml 主要配置resourcemanager地址以及

yarn.application.classpath(这个路径很重要,要不然集成hive时候会提示找不到class)

<code>[root@desktop1 hadoop]# cat yarn-site.xml

<?xml version="1.0"?>

<configuration>

<property>

<name>yarn.resourcemanager.resource-tracker.address</name>

<value>desktop1:8031</value>

</property>

<property>

<name>yarn.resourcemanager.address</name>

<value>desktop1:8032</value>

</property>

<property>

<name>yarn.resourcemanager.scheduler.address</name>

<value>desktop1:8030</value>

</property>

<property>

<name>yarn.resourcemanager.admin.address</name>

<value>desktop1:8033</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>desktop1:8088</value>

</property>

<property>

<description>Classpath for typical applications.</description>

<name>yarn.application.classpath</name>

<value>$HADOOP_CONF_DIR,$HADOOP_COMMON_HOME/share/hadoop/common/*,

$HADOOP_COMMON_HOME/share/hadoop/common/lib/*,

$HADOOP_HDFS_HOME/share/hadoop/hdfs/*,$HADOOP_HDFS_HOME/share/hadoop/hdfs/lib/*,

$YARN_HOME/share/hadoop/yarn/*,$YARN_HOME/share/hadoop/yarn/lib/*,

$YARN_HOME/share/hadoop/mapreduce/*,$YARN_HOME/share/hadoop/mapreduce/lib/*</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce.shuffle</value>

</property>

<property>

<name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

<property>

<name>yarn.nodemanager.local-dirs</name>

<value>/opt/data/yarn/local</value>

</property>

<property>

<name>yarn.nodemanager.log-dirs</name>

<value>/opt/data/yarn/logs</value>

</property>

<property>

<description>Where to aggregate logs</description>

<name>yarn.nodemanager.remote-app-log-dir</name>

<value>/opt/data/yarn/logs</value>

</property>

<property>

<name>yarn.app.mapreduce.am.staging-dir</name>

<value>/user</value>

</property>

</configuration>

</code>同步配置文件

修改.bashrc环境变量,并将其同步到其他几台机器,并且source .bashrc

<code>[root@desktop1 ~]# cat .bashrc

# .bashrc

alias rm='rm -i'

alias cp='cp -i'

alias mv='mv -i'

# Source global definitions

if [ -f /etc/bashrc ]; then

. /etc/bashrc

fi

# User specific environment and startup programs

export LANG=zh_CN.utf8

export JAVA_HOME=/opt/jdk1.6.0_38

export JRE_HOME=$JAVA_HOME/jre

export CLASSPATH=./:$JAVA_HOME/lib:$JRE_HOME/lib:$JRE_HOME/lib/tools.jar

export HADOOP_HOME=/opt/hadoop-2.0.0-cdh4.2.0

export HIVE_HOME=/opt/hive-0.10.0-cdh4.2.0

export HBASE_HOME=/opt/hbase-0.94.2-cdh4.2.0

export HADOOP_MAPRED_HOME=${HADOOP_HOME}

export HADOOP_COMMON_HOME=${HADOOP_HOME}

export HADOOP_HDFS_HOME=${HADOOP_HOME}

export YARN_HOME=${HADOOP_HOME}

export HADOOP_YARN_HOME=${HADOOP_HOME}

export HADOOP_CONF_DIR=${HADOOP_HOME}/etc/hadoop

export HDFS_CONF_DIR=${HADOOP_HOME}/etc/hadoop

export YARN_CONF_DIR=${HADOOP_HOME}/etc/hadoop

export PATH=$PATH:$HOME/bin:$JAVA_HOME/bin:$HADOOP_HOME/sbin:$HBASE_HOME/bin:$HIVE_HOME/bin

</code>修改配置文件之后,使其生效。

<code>[root@desktop1 ~]# source .bashrc </code>

将desktop1上的/opt/hadoop-2.0.0-cdh4.2.0拷贝到其他机器上

启动脚本

第一次启动hadoop需要先格式化NameNode,该操作只做一次。当修改了配置文件时,需要重新格式化

<code>[root@desktop1 hadoop]hadoop namenode -format </code>

在desktop1上启动hdfs:

<code>[root@desktop1 hadoop]#start-dfs.sh </code>

在desktop1上启动mapreduce:

<code>[root@desktop1 hadoop]#start-yarn.sh </code>

在desktop1上启动historyserver:

<code>[root@desktop1 hadoop]#mr-jobhistory-daemon.sh start historyserver </code>

查看MapReduce:

<code>http://desktop1:8088/cluster </code>

查看节点:

<code>http://desktop2:8042/ http://desktop2:8042/node </code>

检查集群进程

<code>[root@desktop1 ~]# jps 5389 NameNode 5980 Jps 5710 ResourceManager 7032 JobHistoryServer [root@desktop2 ~]# jps 3187 Jps 3124 SecondaryNameNode [root@desktop3 ~]# jps 3187 Jps 3124 DataNode 5711 NodeManager</code>

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

Win11系統無法安裝中文語言套件的解決方法

Mar 09, 2024 am 09:48 AM

Win11系統無法安裝中文語言套件的解決方法

Mar 09, 2024 am 09:48 AM

Win11系統無法安裝中文語言包的解決方法隨著Windows11系統的推出,許多用戶開始升級他們的作業系統以體驗新的功能和介面。然而,一些用戶在升級後發現他們無法安裝中文語言包,這給他們的使用體驗帶來了困擾。在本文中,我們將探討Win11系統無法安裝中文語言套件的原因,並提供一些解決方法,幫助使用者解決這個問題。原因分析首先,讓我們來分析一下Win11系統無法

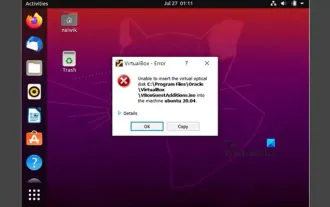

無法在VirtualBox中安裝來賓添加

Mar 10, 2024 am 09:34 AM

無法在VirtualBox中安裝來賓添加

Mar 10, 2024 am 09:34 AM

您可能無法在OracleVirtualBox中將來賓新增安裝到虛擬機器。當我們點擊Devices>;InstallGuestAdditionsCDImage時,它只會拋出一個錯誤,如下所示:VirtualBox-錯誤:無法插入虛擬光碟C:將FilesOracleVirtualBoxVBoxGuestAdditions.iso編程到ubuntu機器中在這篇文章中,我們將了解當您無法在VirtualBox中安裝來賓新增元件時該怎麼辦。無法在VirtualBox中安裝來賓添加如果您無法在Virtua

百度網盤下載成功但是安裝不了怎麼辦?

Mar 13, 2024 pm 10:22 PM

百度網盤下載成功但是安裝不了怎麼辦?

Mar 13, 2024 pm 10:22 PM

如果你已經成功下載了百度網盤的安裝文件,但是無法正常安裝,可能是軟體文件的完整性發生了錯誤或者是殘留文件和註冊表項的問題,下面就讓本站來為用戶們來仔細的介紹一下百度網盤下載成功但是安裝不了問題解析吧。 百度網盤下載成功但是安裝不了問題解析 1、檢查安裝檔完整性:確保下載的安裝檔完整且沒有損壞。你可以重新下載一次,或者嘗試使用其他可信任的來源下載安裝檔。 2、關閉防毒軟體和防火牆:某些防毒軟體或防火牆程式可能會阻止安裝程式的正常運作。嘗試將防毒軟體和防火牆停用或退出,然後重新執行安裝

如何在Linux上安裝安卓應用程式?

Mar 19, 2024 am 11:15 AM

如何在Linux上安裝安卓應用程式?

Mar 19, 2024 am 11:15 AM

在Linux上安裝安卓應用程式一直是許多用戶所關心的問題,尤其是對於喜歡使用安卓應用程式的Linux用戶來說,掌握如何在Linux系統上安裝安卓應用程式是非常重要的。雖然在Linux系統上直接運行安卓應用程式並不像在Android平台上那麼簡單,但是透過使用模擬器或第三方工具,我們依然可以在Linux上愉快地享受安卓應用程式的樂趣。以下將為大家介紹在Linux系統上安裝安卓應

如何在Ubuntu 24.04上安裝Podman

Mar 22, 2024 am 11:26 AM

如何在Ubuntu 24.04上安裝Podman

Mar 22, 2024 am 11:26 AM

如果您使用過Docker,則必須了解守護程式、容器及其功能。守護程序是在容器已在任何系統中使用時在背景執行的服務。 Podman是一個免費的管理工具,用於管理和建立容器,而不依賴任何守護程序,例如Docker。因此,它在管理貨櫃方面具有優勢,而不需要長期的後台服務。此外,Podman不需要使用根級別的權限。本指南詳細討論如何在Ubuntu24上安裝Podman。更新系統我們先進行系統更新,開啟Ubuntu24的Terminalshell。在安裝和升級過程中,我們都需要使用命令列。一種簡單的

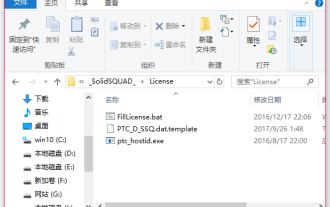

creo怎麼安裝-creo安裝教程

Mar 04, 2024 pm 10:30 PM

creo怎麼安裝-creo安裝教程

Mar 04, 2024 pm 10:30 PM

很多新手夥伴還不了解creo怎麼安裝,所以下面小編就帶來了creo安裝的相關教程,有需要的小伙伴趕緊來看一下吧,希望可以幫助大家。 1.打開下載好的安裝包,找到License資料夾,如下圖:2、然後把它複製到C盤的目錄裡面,如下圖所示:3、雙擊進入,看看有沒有許可文件,如下圖所示:4.接著把授權檔案複製到這個檔案中,如下圖所示:5、在C盤的PROGRAMFILES檔案中,新建一個PLC資料夾,如下圖所示:6、把授權檔案也複製一份進來,如下圖:7.雙擊主程式的安裝檔。進行安裝,勾選安裝新軟

在Ubuntu 24.04上安裝和執行Ubuntu筆記應用程式的方法

Mar 22, 2024 pm 04:40 PM

在Ubuntu 24.04上安裝和執行Ubuntu筆記應用程式的方法

Mar 22, 2024 pm 04:40 PM

在高中學習的時候,有些學生做的筆記非常清晰準確,比同一個班級的其他人都做得更多。對某些人來說,記筆記是一種愛好,而對其他人來說,當他們很容易忘記任何重要事情的小資訊時,則是一種必需品。 Microsoft的NTFS應用程式對於那些希望保存常規講座以外的重要筆記的學生特別有用。在這篇文章中,我們將描述Ubuntu24上的Ubuntu應用程式的安裝。更新Ubuntu系統在安裝Ubuntu安裝程式之前,在Ubuntu24上我們需要確保新設定的系統已經更新。我們可以使用Ubuntu系統中最著名的「a

Win7電腦上安裝Go語言的詳細步驟

Mar 27, 2024 pm 02:00 PM

Win7電腦上安裝Go語言的詳細步驟

Mar 27, 2024 pm 02:00 PM

在 Win7電腦上安裝Go語言的詳細步驟Go(又稱Golang)是一種由Google開發的開源程式語言,其簡潔、高效和並發效能優秀,適合用於開發雲端服務、網路應用和後端系統等領域。在Win7電腦上安裝Go語言,可以讓您快速入門這門語言並開始編寫Go程式。以下將會詳細介紹在Win7電腦上安裝Go語言的步驟,並附上具體的程式碼範例。步驟一:下載Go語言安裝套件訪問Go官