BigData-09-Greenplum概述及架构

0.写在前面: 0.1. 此笔记是参考《Greenplum企业应用实战》、《PostgreSQL8.2.3 中文文档》和《Getting Started with Greenplum for Big Data Analytics》整理; 0.2. 《Greenplum企业应用实战》购买地址:【京东商城】 【 当当网】 0.3.参考网页(持续更新)

0.写在前面:

0.1. 此笔记是参考《Greenplum企业应用实战》、《PostgreSQL8.2.3 中文文档》和《Getting Started with Greenplum for Big Data Analytics》整理;

0.2. 《Greenplum企业应用实战》购买地址:【京东商城】 【 当当网】

0.3.参考网页(持续更新)

1) Shared Disk VS Shared Nothing分布式架构1. Greenplum概述及架构

1.1. 什么是Greenplum

1) 为全球大型企业用户提供新型企业级数据仓库(EDW)、企业级数据云(EDC)和商务智能(BI)提供解决方案和咨询服务,专注于OLAP系统数据引擎开发;

2) 海量并行处理(Massively Parallel Processing) DBMS:

Greenplum的架构采用了MPP(大规模并行处理),在 MPP 系统中,每个 SMP节点也可以运行自己的操作系统、数据库等。换言之,每个节点内的 CPU 不能访问另一个节点的内存。节点之间的信息交互是通过节点互联网络实现的,这个过程一般称为数据重分配(Data Redistribution) 。

SMP(SymmetricMulti-Processing),对称多处理结构的简称,是指在一个计算机上汇集了一组处理器(多CPU),各CPU之间共享内存子系统以及总线结构。在这种技术的支持下,一个服务器系统可以同时运行多个处理器,并共享内存和其他的主机资源。传统的ORACLE和DB2均是此种类型,ORACLE RAC 是半共享状态;

与传统的SMP架构明显不同,通常情况下,MPP系统因为要在不同处理单元之间传送信息,所以它的效率要比SMP要差一点,但是这也不是绝对的,因为 MPP系统不共享资源,因此对它而言,资源比SMP要多,当需要处理的事务达到一定规模时,MPP的效率要比SMP好。这就是看通信时间占用计算时间的比例而定,如果通信时间比较多,那MPP系统就不占优势了,相反,如果通信时间比较少,那MPP系统可以充分发挥资源的优势,达到高效率。

3) 基于PostgreSQL 8.2开源版本,具有相同的客户端功能,增加支持并行处理的技术,增加支持数据仓库和BI的特性;

4) 外部表(external tables)/并行加载(parallel loading):外部表是指数据库可以直接使用操作系统中的数据文件,在Greenplum 4.2版本中支持对外部表的读写操作;

5) 资源管理:基于PostgreSQL增加了并行度的处理;

6) 查询优化器增强(query optimizer enhancements):增加对分布式的支持,空间的回收和分析,不需要进行多方面的调优。

1.2. Greenplum 体系架构

图一

Greenplum是一种基于ProstgreSQL的分布式数据库,其采用Shared-Nothing架构、主机、操作系统、内存、存储都是自我控制的,不存在共享。

补充:SharedDisk与Shared Nothing介绍

图二

图三

|

比较事项 |

概述 |

优点 |

缺点 |

使用场景 |

|

Shared Disk |

如图二所示,所有节点共享一份数据 |

只要有一个节点就可以访问所有数据 |

内存融合限制水平扩展能力 |

Oracle RAC,24*7的高可用性核心业务 |

|

Shared Nothing |

如图三所示,数据和节点有一一对应关系 |

每个节点交互少,很容易扩展 |

如果需要访问所有数据,需要所有节点都可用 |

SQL Server、DB2、Hadoop以及Greenplum |

1.2.1.Master Host

1) 建立与客户端的会话连接和管理;

2) SQL的解析并形成分布式的执行计划;

3) 将生成好的执行计划分发到每个Segment上执行;

4) 收集Segment的执行结果;

5) 不存储业务数据,只存储数据字典;

6) 可以一主一备,分布在两台机器上,为了提高性能,最好单独占用一台机器。

1.2.2.Segment Host

1) 业务数据的存储和存取;

2) 执行由Master分发的SQL语句;

3) 对于Master来说,每个Segment都是对等的,负责对应数据的存储和计算;

4) 每一台机器上可以配置一到多个Segment,因此建议采用相同的机器配置。

1.2.3.Interconnect

1) 是GP数据库的网络层,在每个Segment中起到一个IPC作用;

2) 推荐使用千兆以太网交换机做Interconnect;

3) 支持UDP和TCP两种协议,推荐使用UDP协议,因为其高可靠性、高性能以及可扩展性;而TCP协议最高只能使用1000个Segment实例。

1.3.网络配置示例

图四

图四显示一个常见的网络配置示例,其中X4200是主节点,X4500(Segment host1)是主从节点,当主节点宕机后会主节点服务切换到此节点上,X4500(Segment host2)是从节点。

每个网络接口对应不同的网口,隔离到独立网络,保证不会竞争其他端口的网络带宽,提高网络的可靠性;串口连接到交换机是管理员管理的窗口。

1.4.Greenplum 高可用性体系架构

图五

图五中显示高可用性体系的示例图,其中按照从左到右且从上到下依次是主从节点,主节点,客户端,私有局域网以及从节点集群,实现功能和图一基本一致。

1.5.Master/Standby 镜像保护

图六

图六说明:Standby 节点用于当 Master 节点损坏时提供 Master服务,Standby 实时与Master 节点的Catalog 和事务日志保持同步,确保系统的变更信息不会丢失,提升系统的健壮性。

1.6.数据冗余-Segment 镜像保护

图七

图七说明:

1) 当GP配置了镜像节点之后,主节点不可用时会自动切换到镜像节点,集群仍然保持可用状态。当主节点恢复并启动之后,主节点会自动恢复期间的变更;

2) 只要Master不能连接上Segment实例时,就会在系统表中将此实例标识为不可用,并用镜像节点来代替,一般需要和主节点位于不同的服务器上,当Primary Segment失败时,Mirror Segment将自动提供服务,Primary Segment恢复正常后,使用gprecoverseg –F 同步数据

1.7.Segment 主机硬件配置示例

图八

1.8.网络冗余

图九

图九说明:

1) 数据之间存在冗余,网络也存在冗余;

2) 公共网络连接到主节点,主节点通过一台或者多台交换机连接到子节点。

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

深度學習架構的比較分析

May 17, 2023 pm 04:34 PM

深度學習架構的比較分析

May 17, 2023 pm 04:34 PM

深度學習的概念源自於人工神經網路的研究,含有多個隱藏層的多層感知器是一種深度學習結構。深度學習透過組合低層特徵形成更抽象的高層表示,以表徵資料的類別或特徵。它能夠發現資料的分佈式特徵表示。深度學習是機器學習的一種,而機器學習是實現人工智慧的必經之路。那麼,各種深度學習的系統架構之間有哪些差異呢? 1.全連接網路(FCN)完全連接網路(FCN)由一系列完全連接的層組成,每個層中的每個神經元都連接到另一層中的每個神經元。其主要優點是“結構不可知”,即不需要對輸入做出特殊的假設。雖然這種結構不可知使得完

1.3ms耗時!清華最新開源行動裝置神經網路架構 RepViT

Mar 11, 2024 pm 12:07 PM

1.3ms耗時!清華最新開源行動裝置神經網路架構 RepViT

Mar 11, 2024 pm 12:07 PM

论文地址:https://arxiv.org/abs/2307.09283代码地址:https://github.com/THU-MIG/RepViTRepViT在移动端ViT架构中表现出色,展现出显著的优势。接下来,我们将探讨本研究的贡献所在。文中提到,轻量级ViTs通常比轻量级CNNs在视觉任务上表现得更好,这主要归功于它们的多头自注意力模块(MSHA)可以让模型学习全局表示。然而,轻量级ViTs和轻量级CNNs之间的架构差异尚未得到充分研究。在这项研究中,作者们通过整合轻量级ViTs的有效

Spring Data JPA 的架構和工作原理是什麼?

Apr 17, 2024 pm 02:48 PM

Spring Data JPA 的架構和工作原理是什麼?

Apr 17, 2024 pm 02:48 PM

SpringDataJPA基於JPA架構,透過映射、ORM和事務管理與資料庫互動。其儲存庫提供CRUD操作,派生查詢簡化了資料庫存取。此外,它使用延遲加載,僅在必要時檢索數據,從而提高了效能。

多路徑多領域通吃! GoogleAI發布多領域學習通用模型MDL

May 28, 2023 pm 02:12 PM

多路徑多領域通吃! GoogleAI發布多領域學習通用模型MDL

May 28, 2023 pm 02:12 PM

面向視覺任務(如影像分類)的深度學習模型,通常使用單一視覺域(如自然影像或電腦生成的影像)的資料進行端到端的訓練。一般情況下,一個為多個領域完成視覺任務的應用程式需要為每個單獨的領域建立多個模型,分別獨立訓練,不同領域之間不共享數據,在推理時,每個模型將處理特定領域的輸入資料。即使是面向不同領域,這些模型之間的早期層的有些特徵都是相似的,所以,對這些模型進行聯合訓練的效率更高。這能減少延遲和功耗,降低儲存每個模型參數的記憶體成本,這種方法稱為多領域學習(MDL)。此外,MDL模型也可以優於單

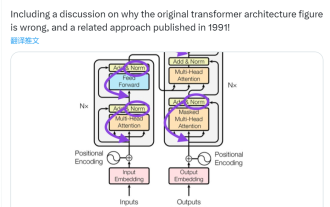

此「錯」並非真的錯:從四篇經典論文入手,理解Transformer架構圖「錯」在何處

Jun 14, 2023 pm 01:43 PM

此「錯」並非真的錯:從四篇經典論文入手,理解Transformer架構圖「錯」在何處

Jun 14, 2023 pm 01:43 PM

前段時間,一則指出Google大腦團隊論文《AttentionIsAllYouNeed》中Transformer架構圖與程式碼不一致的推文引發了大量的討論。對於Sebastian的這項發現,有人認為屬於無心之過,但同時也會令人感到奇怪。畢竟,考慮到Transformer論文的流行程度,這個不一致問題早就該被提及1000次。 SebastianRaschka在回答網友評論時說,「最最原始」的程式碼確實與架構圖一致,但2017年提交的程式碼版本進行了修改,但同時沒有更新架構圖。這也是造成「不一致」討論的根本原因。

AI基礎架構:IT和資料科學團隊協作的重要性

May 18, 2023 pm 11:08 PM

AI基礎架構:IT和資料科學團隊協作的重要性

May 18, 2023 pm 11:08 PM

人工智慧(AI)已經改變了許多行業的遊戲規則,使企業能夠提高效率、決策和客戶體驗。隨著人工智慧的不斷發展和變得越來越複雜,企業投資於合適的基礎設施來支援其開發和部署至關重要。這個基礎設施的一個關鍵方面是IT和數據科學團隊之間的協作,因為兩者在確保人工智慧計畫的成功方面都發揮著關鍵作用。人工智慧的快速發展導致對運算能力、儲存和網路能力的需求不斷增加。這種需求為傳統IT基礎架構帶來了壓力,而傳統IT基礎架構並非設計用於處理AI所需的複雜和資源密集型工作負載。因此,企業現在正在尋求建構能夠支持AI工作負

2023年值得了解的幾個前端格式化工具【總結】

Sep 30, 2022 pm 02:17 PM

2023年值得了解的幾個前端格式化工具【總結】

Sep 30, 2022 pm 02:17 PM

eslint 使用eslint的生態鏈來規範開發者對js/ts基本語法的規格。防止團隊的成員亂寫. 這裡主要使用到的eslint的套件有以下幾個: 使用的以下語句來按照依賴: 接下來需要對eslint的

手撕Llama3第1層: 從零開始實現llama3

Jun 01, 2024 pm 05:45 PM

手撕Llama3第1層: 從零開始實現llama3

Jun 01, 2024 pm 05:45 PM

一、Llama3的架構在本系列文章中,我們從頭開始實作llama3。 Llama3的整體架構:圖片Llama3的模型參數:讓我們來看看這些參數在LlaMa3模型中的實際數值。圖片[1]上下文視窗(context-window)在實例化LlaMa類別時,變數max_seq_len定義了context-window。類別中還有其他參數,但這個參數與transformer模型的關係最為直接。這裡的max_seq_len是8K。圖片[2]字彙量(Vocabulary-size)和注意力層(AttentionL