Hadoop Tmp Dir

今天早上的报表没有出来,报表是从用 hadoop 进行跑的 一看 hadoop 相关日志,报如下错误 Message: org.apache.hadoop.ipc.RemoteException: java.io.IOException: org.apache.hadoop.fs.FSError: java.io.IOException: No space left on device 咋一看, 以为

今天早上的报表没有出来,报表是从用 hadoop 进行跑的

一看 hadoop 相关日志,报如下错误

<code>Message: org.apache.hadoop.ipc.RemoteException: java.io.IOException: org.apache.hadoop.fs.FSError: java.io.IOException: No space left on device </code>

咋一看, 以为是 hdfs没空间了,运行如下命令

<code> hadoop dfsadmin -report

Configured Capacity: 44302785945600 (40.29 TB)

Present Capacity: 42020351946752 (38.22 TB)

DFS Remaining: 8124859072512 (7.39 TB)

DFS Used: 33895492874240 (30.83 TB)

DFS Used%: 80.66%

Under replicated blocks: 1687

Blocks with corrupt replicas: 0

Missing blocks: 0

</code>从输出的结果来看,dfs的空间还很大,所以”No space left on device”这样的错误应该不是hdfs的问题

应该是本地磁盘的问题,发现hadoop运行时,要用到一个临时目录,可以在core-site.xml文件中配置

<code>hadoop.tmp.dir </code>

默认的路径是 /tmp/hadoop-${user.name}

看了一下 /tmp/的空间,确实很小了,把hadoop.tmp.dir挂到一个大一点的盘上就可以了

hadoop.tmp.dir是其它临时目录的父目录

但是一个问题还没有解决, hadoop.tmp.dir到底需要多大空间呢?怎么样计算呢?

common-question-and-requests-from-our-users

原文地址:Hadoop Tmp Dir, 感谢原作者分享。

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

/tmp/資料夾在Linux系統中的清理原理及tmp檔案的作用

Dec 21, 2023 pm 05:36 PM

/tmp/資料夾在Linux系統中的清理原理及tmp檔案的作用

Dec 21, 2023 pm 05:36 PM

.tmp檔案大部分都是因為不正常關機、或死機後所留下的文件,這些臨時的暫存盤,在你重新開機後,已經沒有任何的用途,可以放心刪除。大家在使用Windows作業系統的時候,可能會常在C盤根目錄發現一些後綴名為TMP的文件,也會在Windows目錄裡發現一個TEMP的目錄,TMP檔案是各種軟體或系統產生的暫存文件,也就是常說的垃圾檔案。 Windows產生的臨時文件,本質上和虛擬記憶體沒什麼兩樣,只不過臨時文件比虛擬記憶體更具針對性,單獨為某個程式服務而已。而它的專一性導致了許多新手對他望而生畏,不刪佔

如何在CentOS 7中存取並清理/tmp目錄中的垃圾檔案?

Dec 27, 2023 pm 09:10 PM

如何在CentOS 7中存取並清理/tmp目錄中的垃圾檔案?

Dec 27, 2023 pm 09:10 PM

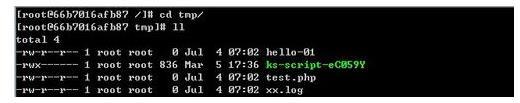

centos7系統中tmp目錄下有很多垃圾,想要清除垃圾,該怎麼清除呢?下面我們就來看看詳細的教學。查看tmp檔案目錄下檔案列表,執行指令cdtmp/切換到tmp目前檔案目錄,執行ll指令,查看目前目錄下檔列表。如下圖所示。使用rm刪除檔案指令,需要注意的是rm指令是將檔案永遠從系統中刪除,因此建議在使用rm指令時,最好是在刪除檔案前給予提示。使用指令rm-i檔名,等用戶確認刪除(y)或跳過刪除(n),系統進行對應的操作。如下圖所示。

linux中tmp什麼意思

Mar 10, 2023 am 09:26 AM

linux中tmp什麼意思

Mar 10, 2023 am 09:26 AM

linux中tmp指的是儲存臨時檔案的資料夾,該資料夾包含系統和使用者建立的暫存檔案;tmp資料夾的預設時限是30天,30天不存取的tmp下的檔案會被系統自動刪除的。

Java錯誤:Hadoop錯誤,如何處理與避免

Jun 24, 2023 pm 01:06 PM

Java錯誤:Hadoop錯誤,如何處理與避免

Jun 24, 2023 pm 01:06 PM

Java錯誤:Hadoop錯誤,如何處理和避免使用Hadoop處理大數據時,常常會遇到一些Java異常錯誤,這些錯誤可能會影響任務的執行,導致資料處理失敗。本文將介紹一些常見的Hadoop錯誤,並提供處理和避免這些錯誤的方法。 Java.lang.OutOfMemoryErrorOutOfMemoryError是Java虛擬機器記憶體不足的錯誤。當Hadoop任

TmP是什麼檔案?

Dec 25, 2023 pm 03:39 PM

TmP是什麼檔案?

Dec 25, 2023 pm 03:39 PM

「tmp」檔案是臨時文件,通常由作業系統或程式在運行過程中產生,用於儲存臨時資料或程式運行時的中間結果。這些檔案主要用於幫助程式順利執行,但它們在程式執行完畢後通常會自動刪除。 tmp檔案通常可以在Windows系統的C盤根目錄下找到。然而,tmp檔案與特定應用程式或系統有關,因此它們的具體內容和用途可能因應用程式而異。

tmp是什麼文件

Feb 22, 2023 pm 02:35 PM

tmp是什麼文件

Feb 22, 2023 pm 02:35 PM

tmp是各種軟體或系統產生的臨時文件,也就是常說的垃圾文件。通常,建立臨時檔案的程式會在完成時將其刪除,但有時這些檔案會被保留。臨時文件被保留的原因可能有多種:程式可能在完成安裝前被中斷,或在重新啟動時崩潰;對於這些文件,一般沒有什麼使用價值,我們可以直接將其刪除。

在Beego中使用Hadoop和HBase進行大數據儲存和查詢

Jun 22, 2023 am 10:21 AM

在Beego中使用Hadoop和HBase進行大數據儲存和查詢

Jun 22, 2023 am 10:21 AM

隨著大數據時代的到來,資料處理和儲存變得越來越重要,如何有效率地管理和分析大量的資料也成為企業面臨的挑戰。 Hadoop和HBase作為Apache基金會的兩個項目,為大數據儲存和分析提供了一個解決方案。本文將介紹如何在Beego中使用Hadoop和HBase進行大數據儲存和查詢。一、Hadoop和HBase簡介Hadoop是一個開源的分散式儲存和運算系統,它可

如何使用PHP和Hadoop進行大數據處理

Jun 19, 2023 pm 02:24 PM

如何使用PHP和Hadoop進行大數據處理

Jun 19, 2023 pm 02:24 PM

隨著資料量的不斷增大,傳統的資料處理方式已經無法處理大數據時代所帶來的挑戰。 Hadoop是開源的分散式運算框架,它透過分散式儲存和處理大量的數據,解決了單節點伺服器在大數據處理中帶來的效能瓶頸問題。 PHP是一種腳本語言,廣泛應用於Web開發,而且具有快速開發、易於維護等優點。本文將介紹如何使用PHP和Hadoop進行大數據處理。什麼是HadoopHadoop是