生成式AI模型大PK-GPT-4、Claude 2.1和Claude 3.0 Opus

想了解更多AIGC的內容,請造訪:

51CTO AI.x社群

https ://www.51cto.com/aigc/

簡介

目前,RAG(檢索增強生成)系統的新評估似乎每天都在發布,其中許多都集中在有關框架的檢索階段。然而,生成方面——模型如何合成和表達這些檢索到的信息,在實踐中可能具有同等重要的意義。許多實際應用中的案例證明,系統不僅要求從上下文中返回數據,還需將這些資訊轉化為更複雜的回應。

為此,我們先後進行了幾個實驗,對GPT-4、Claude 2.1和Claude 3 Opus進行了三種模型的生成能力進行了評估和比較。本文將詳細介紹我們的研究方法、結果和在過程中遇到的這些模型的細微差別,並說明為什麼這些內容對使用生成式人工智慧進行建構的人來說非常重要。

有興趣的讀者如果想重現上述實驗的結果,那麼實驗中所需的一切都可以從GitHub儲存庫(https://github.com/Arize-ai/LLMTest_NeedleInAHaystack)中找到。

補充說明

- 儘管最初的發現表明Claude的表現優於GPT-4,但隨後的測試表明,隨著策略提示工程技術的出現,GPT-4在更廣泛的評估中表現出了卓越的性能。總之,RAG系統中固有的模型行為和提示工程當中還存在著許多的問題。

- 只需在提示範本中簡單地添加一句“請解釋自己,然後回答問題”,即可顯著提高(超過兩倍)GPT-4的性能。很明顯,當LLM說出答案時,這似乎有助於進一步展開有關想法。透過解釋,模型有可能在嵌入/注意力空間中重新執行正確的答案。

RAG階段與生成的重要性

#圖1:作者創建的圖表

雖然在一個檢索增強生成系統中檢索部分負責識別和檢索最相關的訊息,但正是生成階段獲取這些原始數據,並將其轉換為連貫、有意義和符合上下文的回應。生成步驟的任務是合成檢索到的信息,填補空白信息,並以易於理解和用戶查詢相關的方式呈現。 生成步驟的任務是合成檢索到的信息,填補空白信息,並以易於理解和用戶查詢相關的方式呈現。透過生成階段,空白資訊被填充,以便實現對相關資訊的完整性和易於理解的解釋。同時,使用者可以根據需要查詢相關的方式呈現的資訊。 透過生成階段的處理,透過填充空白訊息,使得最終產生的結果更加完整且易於理解。這提供了一種理解和查詢相關資訊的方式,有助於使用者進行更深入的探索和研究。

在許多現實世界的應用中,RAG系統的價值不僅在於它們定位特定事實或資訊的能力,還在於它們在更廣泛的框架內整合和情境化資訊的能力。生成階段使RAG系統能夠超越簡單的事實檢索,並提供真正智慧和自適應的回應。

測試#1:日期映射

我們執行的初始測試包括從兩個隨機檢索的數字中產生一個日期字串:一個表示月份,另一個表示日期。模型的任務是:

- 檢索隨機數#1

- 隔離最後一位並遞增1

- 根據結果為我們的日期字串產生一個月

- 檢索隨機數字#2

- 從隨機數2產生日期字串的日期

#例如,隨機數4827143和17表示4月17日。

這些數字被放置在不同深度的不同長度的上下文中。模型最初在完成這項任務時經歷了相當困難的時期。

圖2:初始測試結果

雖然這兩個模型都表現不佳,但在我們的初步測試中,Claude 2.1的表現明顯優於GPT-4,成功率幾乎翻了四倍。正是在這裡,Claude模型的冗長本性——提供詳細、解釋性的回答——似乎給了它一個明顯的優勢,與GPT-4最初簡潔的回答相比,結果更準確。

在這些意想不到的實驗結果的推動下,我們在實驗中引入了一個新的變數。我們指示GPT-4“解釋自己,然後回答問題”,這一提示鼓勵了類似於Claude模型自然輸出的更詳細的響應。因此,這微小調整的影響還是深遠的。

图3:有针对性提示结果的初始测试

GPT-4模型的性能显著提高,在随后的测试中取得了完美的结果。Claude模型的成绩也有所改善。

这个实验不仅突出了语言模型处理生成任务的方式的差异,还展示了提示工程对其性能的潜在影响。Claude的优势似乎是冗长,事实证明这是GPT-4的一种可复制策略,这表明模型处理和呈现推理的方式会显著影响其在生成任务中的准确性。总的来说,在我们的所有实验中,包括看似微小的“解释自己”这句话,都在提高模型的性能方面发挥了作用。

进一步的测试和结果

图4:用于评估生成的四个进一步测试

我们又进行了四次测试,以评估主流模型将检索到的信息合成并转换为各种格式的能力:

- 字符串连接:将文本片段组合成连贯的字符串,测试模型的基本文本操作技能。

- 货币格式:将数字格式化为货币,四舍五入,并计算百分比变化,以评估模型的精度和处理数字数据的能力。

- 日期映射:将数字表示转换为月份名称和日期,需要混合检索和上下文理解。

- 模运算:执行复数运算以测试模型的数学生成能力。

不出所料,每个模型在字符串连接方面都表现出了强大的性能,这也重申了以前的理解,即文本操作是语言模型的基本优势。

图5:货币格式化测试结果

至于货币格式化测试,Claude 3和GPT-4的表现几乎完美无瑕。Claude 2.1的表现总体上较差。准确度在标记长度上变化不大,但当指针更接近上下文窗口的开头时,准确度通常会更低。

图6:正式的来自Haystack网站的测试结果

尽管在一代测试中取得了出色的结果,但Claude 3的准确性在一个仅用于检索的实验中有所下降。从理论上讲,简单地检索数字也应该比操纵数字更容易——这使得性能的下降令人惊讶,也是我们计划进一步测试的领域。如果有什么不同的话,这种违反直觉的下降只会进一步证实这样一种观点,即在使用RAG开发时,检索和生成都应该进行测试。

结论

通过测试各种生成任务,我们观察到,虽然Claude和GPT-4这两个模型都擅长字符串操作等琐碎任务,但在更复杂的场景中,它们的优势和劣势变得显而易见(https://arize.com/blog-course/research-techniques-for-better-retrieved-generation-rag/)。LLM在数学方面仍然不太好!另一个关键结果是,“自我解释”提示的引入显著提高了GPT-4的性能,强调了如何提示模型以及如何阐明其推理对实现准确结果的重要性。

这些发现对LLM的评估具有更广泛的意义。当比较像详细的Claude和最初不那么详细的GPT-4这样的模型时,很明显,RAG评估(https://arize.com/blog-course/rag-evaluation/)标准必须超越以前仅重视正确性这一点。模型响应的冗长引入了一个变量,该变量可以显著影响他们的感知性能。这种细微差别可能表明,未来的模型评估应将平均答复长度视为一个值得注意的因素,从而更好地了解模型的能力,并确保更公平的比较。

译者介绍

朱先忠,51CTO社区编辑,51CTO专家博客、讲师,潍坊一所高校计算机教师,自由编程界老兵一枚。

原文标题:Tips for Getting the Generation Part Right in Retrieval Augmented Generation,作者:Aparna Dhinakaran

链接:

nce.com/tips-for-getting-the-generation-part-right-in-retrieval-augmented-generation-7deaa26f28dc。

想了解更多AIGC的内容,请访问:

51CTO AI.x社区

https://www.51cto.com/aigc/

以上是生成式AI模型大PK-GPT-4、Claude 2.1和Claude 3.0 Opus的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

全球最強開源 MoE 模型來了,中文能力比肩 GPT-4,價格僅 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

全球最強開源 MoE 模型來了,中文能力比肩 GPT-4,價格僅 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

想像一下,一個人工智慧模型,不僅擁有超越傳統運算的能力,還能以更低的成本實現更有效率的效能。這不是科幻,DeepSeek-V2[1],全球最強開源MoE模型來了。 DeepSeek-V2是一個強大的專家混合(MoE)語言模型,具有訓練經濟、推理高效的特點。它由236B個參數組成,其中21B個參數用於啟動每個標記。與DeepSeek67B相比,DeepSeek-V2效能更強,同時節省了42.5%的訓練成本,減少了93.3%的KV緩存,最大生成吞吐量提高到5.76倍。 DeepSeek是一家探索通用人工智

大模型一對一戰鬥75萬輪,GPT-4奪冠,Llama 3位列第五

Apr 23, 2024 pm 03:28 PM

大模型一對一戰鬥75萬輪,GPT-4奪冠,Llama 3位列第五

Apr 23, 2024 pm 03:28 PM

關於Llama3,又有測試結果新鮮出爐-大模型評測社群LMSYS發布了一份大模型排行榜單,Llama3位列第五,英文單項與GPT-4並列第一。圖片不同於其他Benchmark,這份榜單的依據是模型一對一battle,由全網測評者自行命題並評分。最終,Llama3取得了榜單中的第五名,排在前面的是GPT-4的三個不同版本,以及Claude3超大杯Opus。而在英文單項榜單中,Llama3反超了Claude,與GPT-4打成了平手。對於這一結果,Meta的首席科學家LeCun十分高興,轉發了推文並

生成式AI為什麼受到各行業追捧?

Mar 30, 2024 pm 07:36 PM

生成式AI為什麼受到各行業追捧?

Mar 30, 2024 pm 07:36 PM

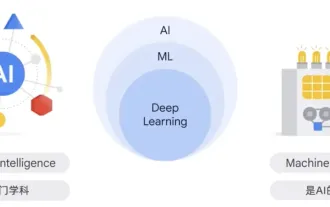

生成式AI是人類一種人工智慧技術,可以產生各種類型的內容,包括文字、圖像、音訊和合成資料。那什麼是人工智慧?人工智慧和機器學習之間的差異是什麼?人工智慧是學科,是電腦科學的一個分支,研究智慧代理的創建,這些智慧代理是可以推理、學習和自主執行動作的系統。從本質上講,人工智慧與建築像人類一樣思考和行動的機器的理論和方法有關。在這個學科中,機器學習ML是人工智慧的一個領域。它是根據輸入資料訓練模型的程序或系統,經過訓練的模型可以從新的或未見過的資料中做出有用的預測,這些資料來自於訓練模型的統一數據

第二代Ameca來了!和觀眾對答如流,臉部表情更逼真,會說幾十種語言

Mar 04, 2024 am 09:10 AM

第二代Ameca來了!和觀眾對答如流,臉部表情更逼真,會說幾十種語言

Mar 04, 2024 am 09:10 AM

人形機器人Ameca升級第二代了!最近,在世界行動通訊大會MWC2024上,世界上最先進機器人Ameca又現身了。會場周圍,Ameca引來一大波觀眾。得到GPT-4加持後,Ameca能夠對各種問題做出即時反應。 「來一段舞蹈」。當被問及是否有情感時,Ameca用一系列的面部表情做出回應,看起來非常逼真。就在前幾天,Ameca背後的英國機器人公司EngineeredArts剛剛示範了團隊最新的開發成果。影片中,機器人Ameca具備了視覺能力,能看見並描述房間整個狀況、描述具體物體。最厲害的是,她還能

全球最強模型一夜易主,GPT-4時代終結! Claude 3提前狙擊GPT-5,3秒讀懂萬字論文理解力接近人類

Mar 06, 2024 pm 12:58 PM

全球最強模型一夜易主,GPT-4時代終結! Claude 3提前狙擊GPT-5,3秒讀懂萬字論文理解力接近人類

Mar 06, 2024 pm 12:58 PM

卷瘋了卷瘋了,大模型又變天了。就在剛剛,全球最強AI模型一夜易主,GPT-4被拉下神壇。 Anthropic發布了最新的Claude3系列模型,一句話評價:真·全面碾壓GPT-4!在多模態和語言能力指標上,Claude3都贏麻了。用Anthropic的話來說,Claude3系列模型在推理、數學、編碼、多語言理解和視覺方面,都樹立了新的行業基準! Anthropic,就是曾因安全理念不合,而從OpenAI「叛逃」出的員工組成的新創公司,他們的產品一再給OpenAI暴擊。這次的Claude3,更是整了個大的

海爾與西門子生成式AI創新背後的科技巨頭是哪一家?

Nov 21, 2023 am 09:02 AM

海爾與西門子生成式AI創新背後的科技巨頭是哪一家?

Nov 21, 2023 am 09:02 AM

亞馬遜雲端科技大中華區戰略業務發展部總經理顧凡2023年,大語言模型和生成式AI在全球市場“狂飆”,不僅引發了AI和雲端運算產業的“排山倒海”式跟進,也在強力吸引製造業巨頭們的入局。海爾創新設計中心就打造了全國首個AIGC工業設計解決方案,大幅縮短設計週期,並降低概念設計成本,不僅將整體概念設計提速了83%、集成渲染效率也提升了約90%,高效解決了設計階段人力成本高、概念產出與通過效率低等問題。西門子中國基於自有模型的智慧知識庫暨智慧會話機器人“小禹”,具備自然語言處理、知識庫檢索、透過資料訓練大語言

騰訊混元升級模型矩陣,雲端推出256k長文模型

Jun 01, 2024 pm 01:46 PM

騰訊混元升級模型矩陣,雲端推出256k長文模型

Jun 01, 2024 pm 01:46 PM

大模型落地加速,「產業實用」成為發展共識。 2024年5月17日,騰訊雲生成式AI產業應用高峰會在北京召開,公佈大模型研發、應用產品的系列進度。騰訊混元大模型能力持續升級,多個版本模型hunyuan-pro、hunyuan-standard、hunyuan-lite透過騰訊雲對外開放,滿足企業客戶、開發者在不同場景下的模型需求,落地最優性價比模型方案。騰訊雲大模型知識引擎、影像創作引擎、影片創作引擎三大工具發布,打造大模型時代原生工具鏈,透過PaaS服務簡化資料存取、模式精調、應用開發流程,協助企業

20步內越獄任意大模型!更多「奶奶漏洞」全自動發現

Nov 05, 2023 pm 08:13 PM

20步內越獄任意大模型!更多「奶奶漏洞」全自動發現

Nov 05, 2023 pm 08:13 PM

不到一分鐘、不超過20步,任意繞過安全限制,成功越獄大型模型!而且不必知道模型內部細節-只需要兩個黑盒子模型互動,就能讓AI全自動攻陷AI,說出危險內容。聽說曾經紅極一時的“奶奶漏洞”已經被修復了:如今,面對“偵探漏洞”、“冒險家漏洞”和“作家漏洞”,人工智能應該採取何種應對策略呢?一波猛攻下來,GPT-4也遭不住,直接說出要給供水系統投毒只要…這樣那樣。關鍵這只是賓州大學研究團隊曬出的一小波漏洞,而用上他們最新開發的演算法,AI可以自動產生各種攻擊提示。研究人員表示,這種方法相比於現有的