Nvidia 推出了 Chat with RXT,這是一款可在您的 PC 上運行的 AI 聊天機器人,並提供與 ChatGPT 類似的功能等等!您只需要一個 Nvidia RTX GPU,就可以開始使用 Nvidia 的新 AI 聊天機器人了。

Nvidia Chat with RTX 是一款 AI 軟體,可讓您在電腦上本機執行大型語言模型 (LLM)。因此,您可以隨時離線使用 Chat with RTX,而不是在線使用 ChatGPT 等 AI 聊天機器人。

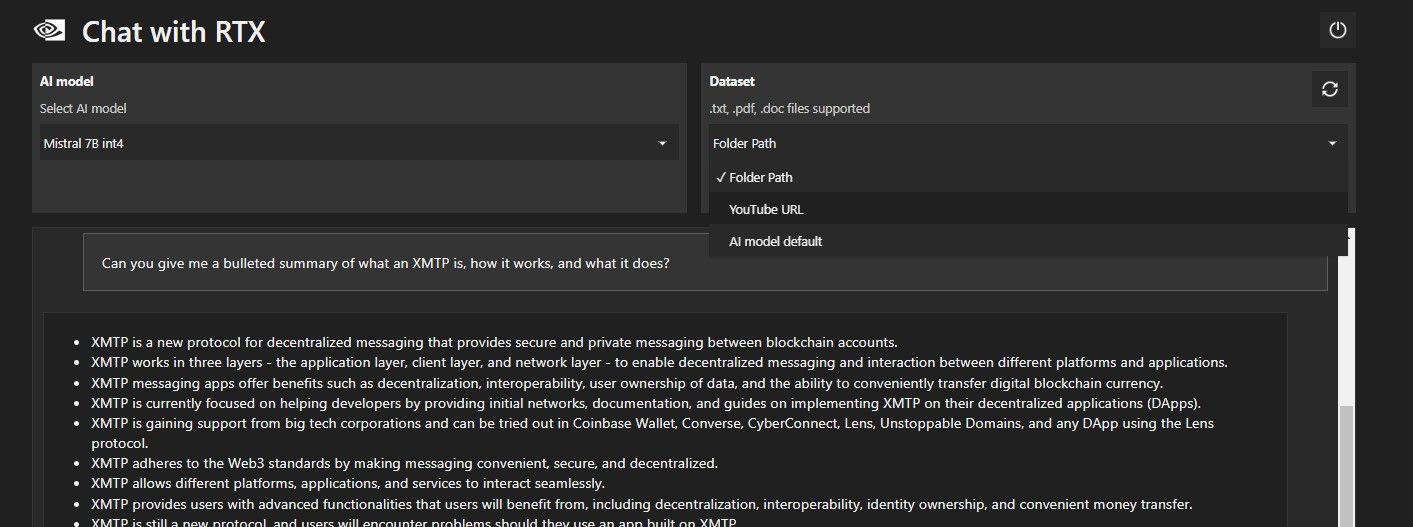

Chat with RTX 使用 TensorRT-LLM、RTX 加速和量化的 Mistral 7-B LLM 來提供與其他線上 AI 聊天機器人相同的快速效能和品質回應。它還提供檢索增強生成 (RAG),允許聊天機器人讀取您的檔案並根據您提供的資料啟用自訂答案。這允許您自訂聊天機器人以提供更個性化的體驗。

如果您想嘗試使用 RTX 進行 Nvidia Chat,請按照以下步驟在您的電腦上下載、安裝和設定它。

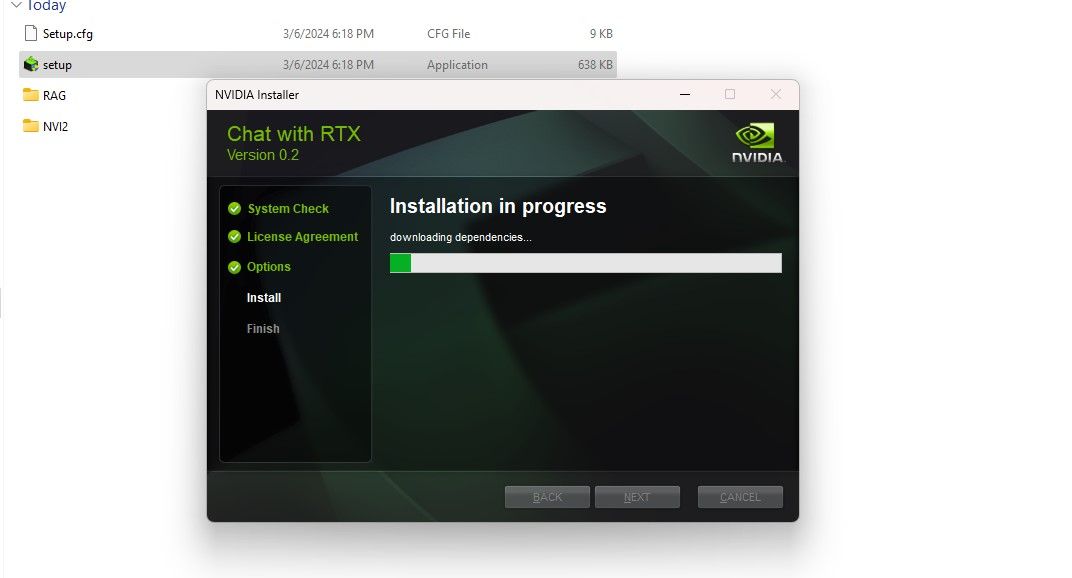

Nvidia 讓在電腦上本機執行 LLM 變得更加容易。要使用 RTX 運行 Chat,您只需下載並安裝該應用程序,就像使用任何其他軟體一樣。但是,Chat with RTX 確實有一些正確安裝和使用的最低規格要求。

RTX 30 系列或 40 系列 GPU 16GB RAM 100GB 可用記憶體空間 Windows 11如果您的電腦確實符合最低系統要求,您可以繼續安裝應用程式。

第1 步:下載Chat with RTX ZIP 檔案。 ZIP 檔案或雙擊該檔案並選擇全部提取。步驟3:開啟解壓縮的資料夾並雙擊setup.exe。請按照螢幕上的指示進行操作,並在自訂安裝過程中選取所有核取方塊。點擊「下一步」後,安裝程式將下載並安裝LLM 和所有依賴項。 。安裝過程完成後,點擊關閉,就完成了。現在,您可以試用該應用程式了。 如何使用Nvidia Chat with RTX

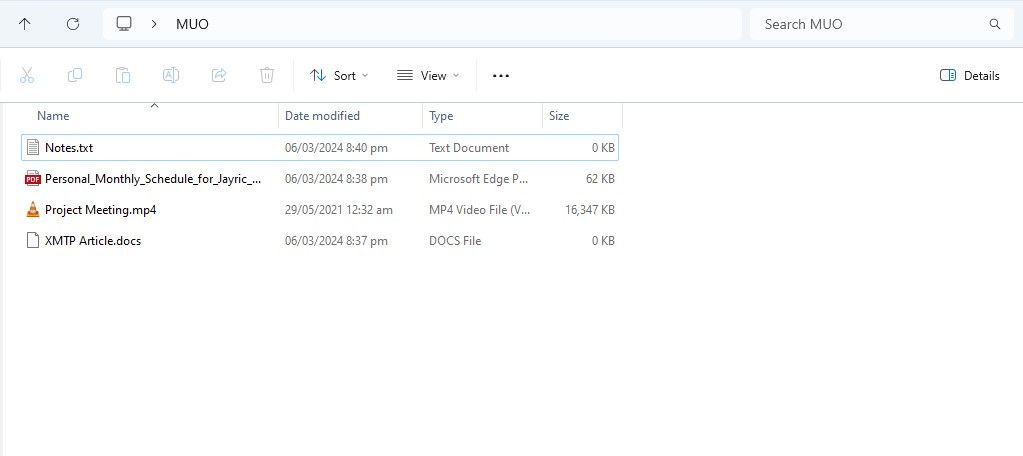

雖然您可以像常規在線AI 聊天機器人一樣使用Chat with RTX,但我強烈建議您檢查其RAG 功能,該功能使您能夠根據需要自訂其輸出在您授予存取權限的文件上。

若要開始在 Chat with RTX 上使用 RAG,請建立一個新資料夾來儲存您希望 AI 分析的檔案。

現在您的資料庫已準備就緒,您可以設定 Chat with RTX 並開始使用它來回答您的問題和疑問。 步驟 2:設定環境

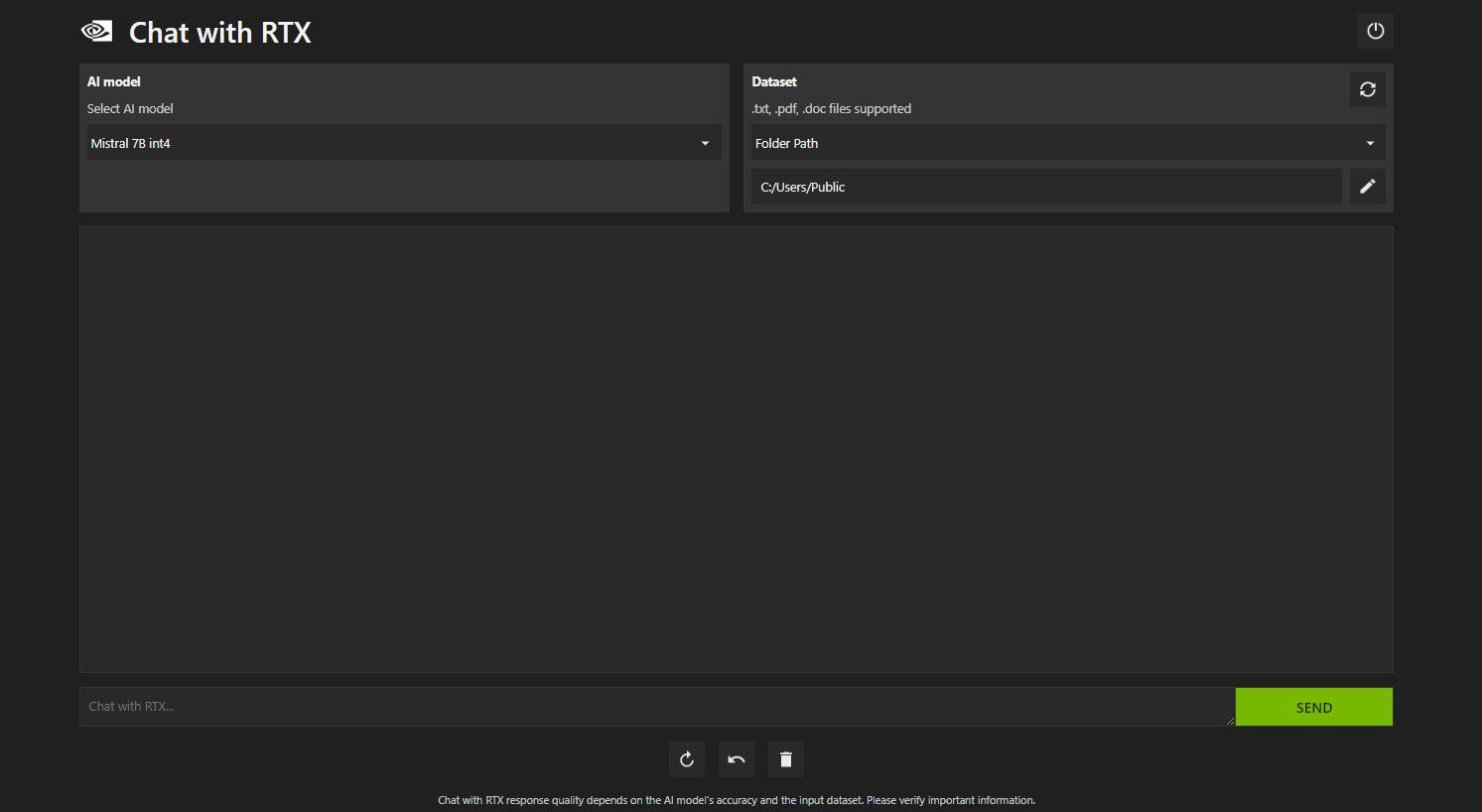

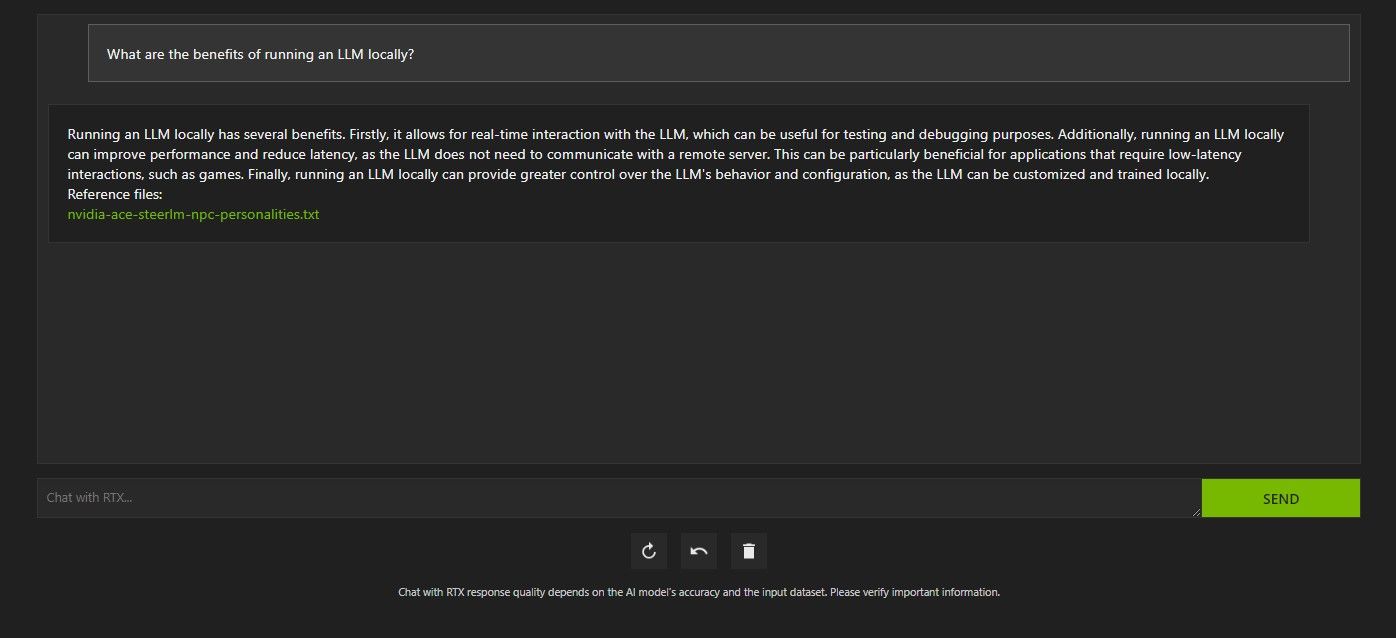

使用 RTX 開啟聊天。它應該如下圖所示。

第 3 步:透過 RTX 聊天詢問您的問題!

使用 RTX 查詢 Chat 的方法有多種。第一個是像常規人工智慧聊天機器人一樣使用它。我向 Chat with RTX 詢問使用本地法學碩士的好處,並對它的回答感到滿意。雖然不是很深入,但是足夠準確。

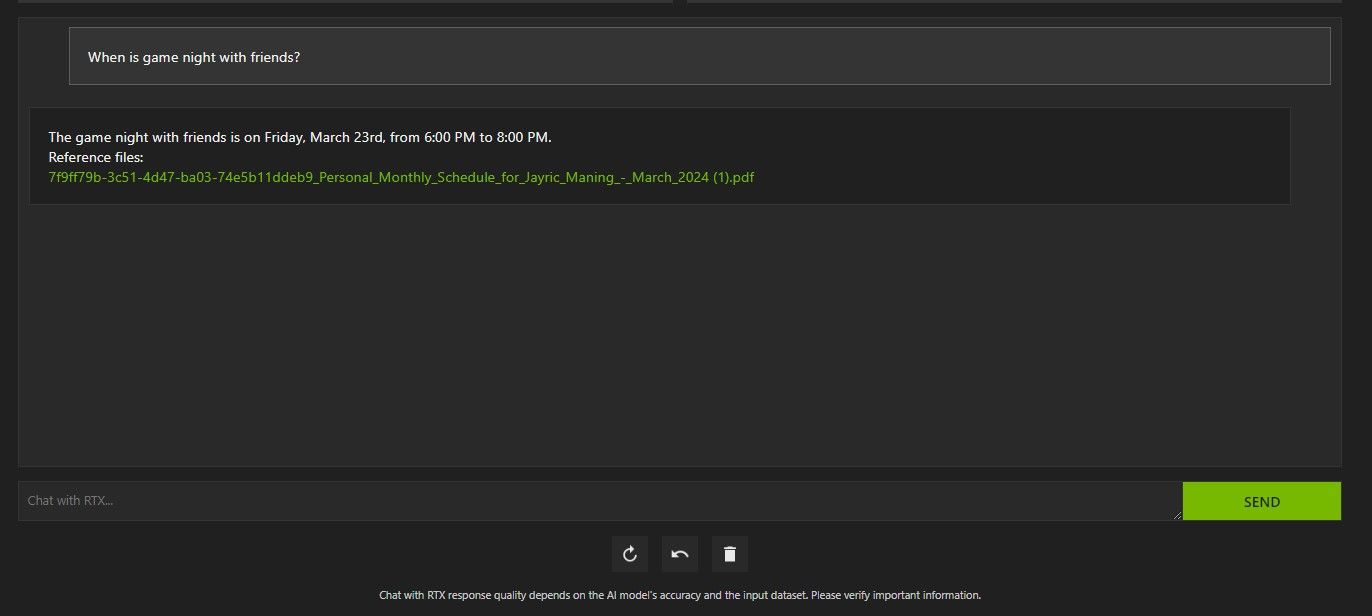

但由於 Chat with RTX 具有 RAG 功能,因此您也可以將其用作個人 AI 助理。

上面,我使用 RTX 聊天來詢問我的日程安排。數據來自一個 PDF 文件,其中包含我的日程安排、日曆、事件、工作等。在本例中,Chat with RTX 已從資料中提取了正確的日曆資料;您必須保持資料檔案和日曆日期更新,這樣的功能才能正常運作,直到與其他應用程式集成為止。

您可以透過多種方式使用 Chat with RTX 的 RAG 來發揮自己的優勢。例如,您可以使用它來閱讀法律文件並給出摘要,產生與您正在開發的程式相關的程式碼,以獲取有關您太忙而無法觀看的影片的要點,等等!

除了本機資料資料夾之外,您還可以使用 Chat with RTX 來分析 YouTube 影片。為此,請在資料集下將資料夾路徑變更為 YouTube URL。

複製您要分析的 YouTube URL 並將其貼到下拉式選單下方。那就問走吧!

Chat with RTX 的 YouTube 影片分析非常好,提供了準確的信息,因此可以方便地進行研究、快速分析等。

ChatGPT 提供 RAG 功能。一些本地人工智慧聊天機器人的系統需求明顯較低。那麼,Nvidia Chat with RTX 值得使用嗎?

答案是肯定的!儘管存在競爭,但與 RTX 聊天還是值得使用的。

使用 Nvidia Chat 與 RTX 的最大賣點之一是它能夠使用 RAG,而無需將檔案傳送到第三方伺服器。透過線上服務自訂 GPT 可能會暴露您的資料。但由於 Chat with RTX 在本地運行且無需互聯網連接,因此在 Chat with RTX 上使用 RAG 可確保您的敏感資料安全且只能在您的 PC 上存取。

對於其他運行 Mistral 7B 的本地運行的 AI 聊天機器人,Chat with RTX 的性能更好更快。儘管效能提升的很大一部分來自於使用更高階的GPU,但與執行聊天優化的LLM 的其他方式相比,Nvidia TensorRT-LLM 和RTX 加速的使用使得在Chat with RTX 上運行Mistral 7B 的速度更快。

值得注意的是,我們目前使用的 Chat with RTX 版本是試用版。 Chat with RTX 的後續版本可能會變得更加優化並帶來效能提升。

Chat with RTX 是一種在本地運行 LLM 的簡單、快速且安全的方式,無需網路連線。如果您也有興趣執行 LLM 或本地課程,但沒有 RTX 30 或 40 系列 GPU,則可以嘗試其他本地運行 LLM 的方法。其中最受歡迎的兩個是 GPT4ALL 和 Text Gen WebUI。如果您想在本地運行 LLM 獲得即插即用的體驗,請嘗試 GPT4ALL。但如果您更傾向於技術,透過 Text Gen WebUI 運行法學碩士將提供更好的微調和靈活性。

以上是如何在電腦上使用 Nvidia 的 RTX AI 聊天機器人聊天的詳細內容。更多資訊請關注PHP中文網其他相關文章!