如果 GPT-4 在模擬基於常識任務的狀態變化時準確率都只有約 60%,那麼我們還要考慮將大語言模型作為世界模擬器來使用嗎?

最近兩天,一篇入選ACL 2024 的論文《Can Language Models Serve as Text-Based World Simulators?》在社群媒體X 上引發了熱議,就連圖靈獎得主Yann LeCun 也參與了。 這篇論文探討的問題是:當前語言模型本身是否可以充當世界模擬器,並正確預測動作如何改變不同的世界狀態,從而避免大量手動編碼的需要呢? 針對這個問題,亞利桑那大學、紐約大學、約翰斯・霍普金斯大學、微軟研究院、艾倫人工智慧研究所等機構的研究者在「基於文字的模擬器」上下文中給出了他們的答案。 他們認為:語言模型並不能作為世界模擬器使用。例如,GPT-4 在模擬基於常識任務(如燒開水)的狀態變化時,準確率僅約 60%。  x ann LeCun 對這篇論文的發現表示了認同,認為「沒有世界模型,就沒有規劃。」

x ann LeCun 對這篇論文的發現表示了認同,認為「沒有世界模型,就沒有規劃。」

##不過也有人表達了不同的觀點:目前LLM(沒有進行針對性任務訓練)的準確率可以達到60%,這不就說明了它們至少是「某種程度上的世界模型」嗎?並且會隨著 LLM 的迭代而持續改進。 LeCun 又表示,世界模型不會是 LLM。

##不過也有人表達了不同的觀點:目前LLM(沒有進行針對性任務訓練)的準確率可以達到60%,這不就說明了它們至少是「某種程度上的世界模型」嗎?並且會隨著 LLM 的迭代而持續改進。 LeCun 又表示,世界模型不會是 LLM。

回到論文中,研究者建構並使用了一個全新的基準,他們稱為「ByteSized32-State-Prediction」,包含了一個文字遊戲狀態轉換和隨附遊戲任務組成的資料集。他們首次使用該基準來直接量化大語言模型(LLM)作為基於文字的世界模擬器的表現。

透過在這個資料集上測試GPT-4,研究者發現:儘管它的性能令人印象深刻,但如果沒有進一步的創新,它仍然是一個不可靠的世界模擬器。 因此,研究者認為,他們的工作既為當前LLM 的能力和弱點提供了新的見解,也為追蹤新模型出現時的未來進展提供了一個新的基準。 論文網址:https://arxiv.org/pdf/2406.06485 ##研究者探討了LLM 在基於文字的虛擬環境中充當世界模擬器的能力,在這種環境中,智能體接收觀察結果並以自然語言提出操作以完成某些目標。 每個文本環境都可以正式表示為具有7 元組(S,A,T,O,R,C,D) 的目標條件部分可觀察馬爾可夫決策過程(POMDP),S 表示狀態空間,A 表示動作空間,T : S×A→S 表示轉換函數,O 表示觀察函數,R : S×A→R 表示獎勵函數,C 表示描述目標和動作語意的自然語言「上下文訊息」,D : S×A→{0,1} 表示二元完成指示函數。 大模型模擬器(LLM-Sim)任務

LLM as-a-Simulator (LLM-Sim),用來定量評估語言模型作為可靠模擬器的能力

LLM-Sim 任務是將一個函數 F : C×S×A→S×R×{0,1} 當作世界模擬器來實現。在實踐中,完整狀態轉換模擬器 F 應該考慮兩種類型的狀態轉換:動作驅動轉換和環境驅動轉換

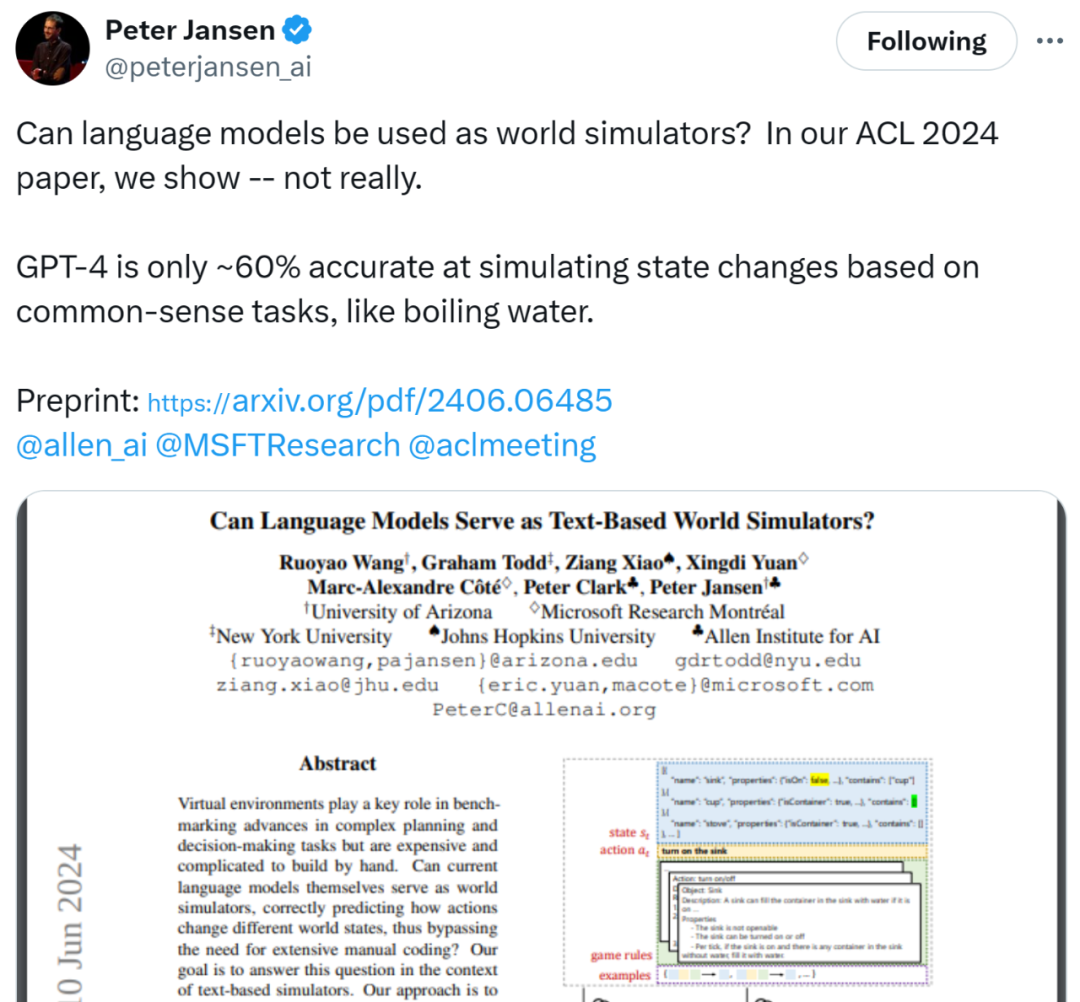

圖 1 為使用 LLM 作為文字遊戲模擬器的範例:開啟水槽後,水槽中的杯子被水填滿的過程。動作驅動轉換是採取打開水槽的動作後,水槽被打開(isOn=true);而環境驅動轉換是在水槽打開時,水填滿水槽中的杯子。

為了更好地理解LLM 對每個轉換進行建模的能力,研究者進一步將模擬器函數F 分解為三個步驟:

- #動作驅動轉換模擬器:給定c、s_t 和a_t, F_act:C×S×A→S 預測s^act_t+ 1,其中s^act_t+1 表示動作引起的直接狀態變化。

- 環境驅動轉換模擬器:給定c 和s^act_t+1,F_env:C×S→S 預測s_t+1,其中s_t+1是任何環境驅動轉換後產生的狀態。

遊戲進度模擬器

:給定c、s_t+1 和a_t, F_R:C×S×A→R×{0,1} 預測獎勵r_t+1 和遊戲完成狀態d_t+1。 此外,研究者考慮了LLM-Sim 任務的兩個變體

- ##完整狀態預測

狀態差異預測

#為了完成這項任務,研究者引入了一個新的文本遊戲狀態轉換資料集。此資料集為「BYTESIZED32-State-Prediction (BYTESIZED32-SP) ”,它

包含76,369 個轉換,表示為(c,s_t,rt,d_t,a_t,s^act_t+1,s_t+1,r_t +1,d_t+1) 元組。這些轉換是從 31 個不同的文字遊戲中收集的。

下表 1 總結了額外語料庫統計資料。 ############

LLM-Sim 上的效能由模型相對於測試樣本資料集上的真實標籤的預測準確性來決定。根據實驗條件,LLM 必須模擬物件屬性(模擬F_act、F_env 或F)和/ 或遊戲進度(模擬F_R 或F),定義如下:

- 物件屬性:遊戲中所有物件、每個物件的屬性(如溫度、大小),以及與其他物件的關係(如在另一個物件內或之上)。

- 遊戲進度:智能體相對於整體目標的狀態,包括目前累積的獎勵、遊戲是否已終止以及總體目標是否已實現。

研究者註意到,在每種情況下,LLM 都提供了ground truth 先前狀態(當函數為F_env 時,先前狀態為s^act_t+1 )以及整體任務脈絡。也就是說,LLM 始終執行單步預測。 #上圖1 示範了研究者使用上下文學習評估LLM -Sim 任務中模型的表現。他們評估了 GPT-4 在完整狀態和狀態差異預測機制中的準確性。此模型接收先前狀態(編碼為 JSON 物件)、先前操作和上下文訊息,並產生後續狀態(作為完整的 JSON 物件或差異)。 下表 2 展示了 GPT-4 模擬完整狀態轉換的準確性,以及單獨模擬動作驅動轉換和環境驅動轉換的準確性。

預測動作驅動轉換比預測環境驅動轉換更容易。在最好的情況下,GPT-4 能夠正確模擬 77.1% 的動態動作驅動轉換。相較之下,GPT-4 最多只能正確模擬 49.7% 的動態環境驅動轉換。 預測靜態轉換比動態轉換更容易。不出所料,在大多數情況下,對靜態轉換進行建模比對動態轉換進行建模要容易得多。 對於動態狀態,預測完整遊戲狀態更容易;而對於靜態狀態,預測狀態差異更容易。預測動態狀態的狀態差異可以顯著提高模擬靜態轉換的效能(>10%),而模擬動態轉換時的效能會降低。 遊戲規則很重要,LLM 能夠產生足夠好的遊戲規則。當上下文訊息中未提供遊戲規則時,GPT-4 在所有三個模擬任務上的效能在大多數情況下都會下降。 GPT-4 在大多數情況下都能預測遊戲進度。下表 3 展示了 GPT-4 預測遊戲進度的結果。在上下文中加入了遊戲規則資訊後,GPT-4 可以在 92.1% 的測試案例中正確預測遊戲進度。這些規則的存在在上下文中至關重要:如果沒有它們,GPT-4 的預測準確率會下降到 61.5%。

人類在 LLM-Sim 任務中的表現優於 GPT-4。研究者對 LLM-Sim 任務進行了初步的人類研究。結果見下表 4。 結果發現,人類的整體準確率為 80%,而取樣的 LLM 的準確率為 50%,且不同註釋者之間的差異很小。這表明,雖然任務對於人類來說總體上是直觀且相對容易的,但對於 LLM 來說仍有很大的改進空間。

GPT-4 在需要算術、常識或科學知識時更容易出錯。下圖 2 展示了在整體狀態轉換、動作驅動轉換和環境驅動轉換中,預測結果的正確比例、將屬性設為不正確值的比例或未能更改屬性值的比例。 我們可以觀察到,GPT-4 能夠很好地處理大多數簡單的布林值屬性。錯誤集中出現在需要算術(如溫度、timeAboveMaxTemp)、常識(如 current_aperture、current_focus)或科學知識(如 on)的非平凡屬性上。

以上是ACL 2024論文蓋棺定論:大語言模型≠世界模擬器,Yann LeCun:太對了的詳細內容。更多資訊請關注PHP中文網其他相關文章!

x ann LeCun 對這篇論文的發現表示了認同,認為「沒有世界模型,就沒有規劃。」

x ann LeCun 對這篇論文的發現表示了認同,認為「沒有世界模型,就沒有規劃。」 ##不過也有人表達了不同的觀點:目前LLM(沒有進行針對性任務訓練)的準確率可以達到60%,這不就說明了它們至少是「某種程度上的世界模型」嗎?並且會隨著 LLM 的迭代而持續改進。 LeCun 又表示,世界模型不會是 LLM。

##不過也有人表達了不同的觀點:目前LLM(沒有進行針對性任務訓練)的準確率可以達到60%,這不就說明了它們至少是「某種程度上的世界模型」嗎?並且會隨著 LLM 的迭代而持續改進。 LeCun 又表示,世界模型不會是 LLM。