英偉達對話模式ChatQA進化到2.0版本,上下文長度提到128K

開放LLM 社群正是百花齊放、競相爭鳴的時代,你能看到Llama-3-70B-Instruct、QWen2-72B-Instruct、Nemotron-4-340B-Instruct、Mixtral-8x22BInstruct-v0.1 等許多表現優良的模型。但是,相較於以 GPT-4-Turbo 為代表的專有大模型,開放模型在許多領域仍有明顯差距。

在通用模型之外,也有一些專精關鍵領域的開放模型已被開發出來,例如用於程式設計和數學的DeepSeek-Coder-V2、用於視覺- 語言任務的InternVL 1.5(其在某些領域可比肩GPT-4-Turbo-2024-04-09)。

作為「AI 淘金時代的賣鏟王」,英偉達本身也在為開放模型領域做出貢獻,例如其開發的ChatQA 系列模型,請參閱本站報道《英偉達新對話QA 模型準確度超GPT-4,卻遭吐槽:無權重代碼意義不大》。今年初,ChatQA 1.5 發布,其整合了檢索增強式生成(RAG)技術,在對話問答方面的表現超過了 GPT-4。

現在,ChatQA 已經進化到 2.0 版,這次改進的主要方向是擴展上下文視窗。

論文標題:ChatQA 2: Bridging the Gap to Proprietary LLMs in Long Context and RAG Capabilities

-

論文地址:https://arxiv.org/pdf/M ,擴展LLM 的上下文視窗長度是一大研究和開發熱點,例如本站曾報道過的

《直接擴展到無限長,谷歌Infini-Transformer 終結上下文長度之爭》 。

所有領先的專有 LLM 都支援非常大的上下文視窗 —— 你可以在單一 prompt 中向其灌輸數百頁文字。例如 GPT-4 Turbo 和 Claude 3.5 Sonnet 的上下文視窗大小分別為 128K 和 200K。而 Gemini 1.5 Pro 可支援 10M 長度的上下文,讓人嘆為觀止。 不過開源大模型也在加緊追趕。例如 QWen2-72B-Instruct 和 Yi-34B 各自支援 128K 和 200K 的上下文視窗。但是,這些模型的訓練資料和技術細節並未公開,因此很難去復現它們。此外,這些模型的評估大都基於合成任務,無法準確地代表在真實下游任務上的表現。例如,有多項研究顯示開放 LLM 和領先的專有模型在真實世界長上下文理解任務上依然差距明顯。

而英偉達的這個團隊成功讓開放的 Llama-3 在真實世界長上下文理解任務上的性能趕上了專有的 GPT-4 Turbo。

在 LLM 社群中,長上下文能力有時被認為是一種能與 RAG 競爭的技術。但實事求是地說,這些技術是可以互相增益的。

對於具有長上下文視窗的 LLM 來說,根據下游任務以及準確度和效率之間的權衡,可以考慮在 prompt 附帶大量文本,也可以使用檢索方法從大量文本中高效地提取出相關資訊。 RAG 具有明顯的效率優勢,可為基於查詢的任務輕鬆地從數十億 token 中檢索出相關資訊。這是長上下文模型無法具備的優勢。另一方面,長上下文模型卻非常擅長文件總結等 RAG 可能不擅長的任務。

因此,對於一個先進的 LLM 來說,這兩種能力都需要,如此才能根據下游任務以及準確度和效率需求來考慮使用哪一種。

此前,英偉達開源的 ChatQA 1.5 模型已經能在 RAG 任務上勝過 GPT-4-Turbo 了。但他們沒有止步於此,如今又開源了 ChatQA 2,將足以比肩 GPT-4-Turbo 的長上下文理解能力也整合了進來!

具體來說,他們基於 Llama-3 模型,將其上下文視窗擴展到了 128K(與 GPT-4-Turbo 同等水平),同時還為其配備了當前最佳的長上下文檢索器。

將上下文視窗擴展至 128K那麼,英偉達如何把 Llama-3 的上下文視窗從 8K 提升到了 128K?首先,他們基於 Slimpajama 準備了一個長上下文預訓練語料庫,使用的方法則來自 Fu et al. (2024) 的論文《Data engineering for scaling language models to 128k context》。 訓練過程中他們也得到了一個有趣發現:相比於使用原有的起始和結束 token

和,使用

這樣的特殊字符來分隔不同文檔的效果會更好。他們猜測,原因是 Llama-3 中的 和

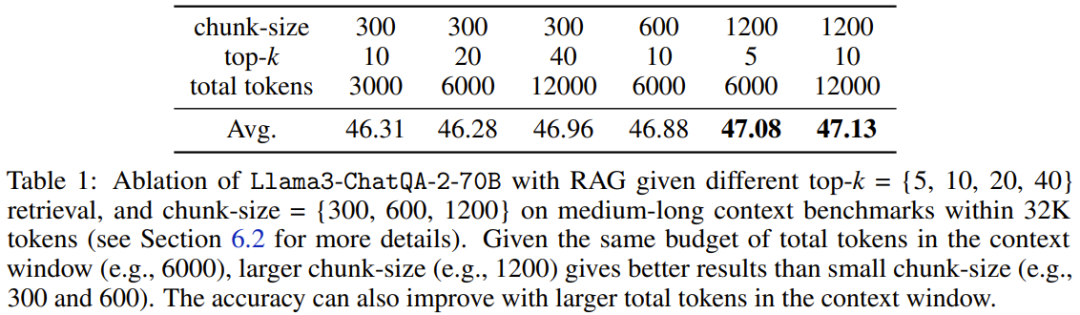

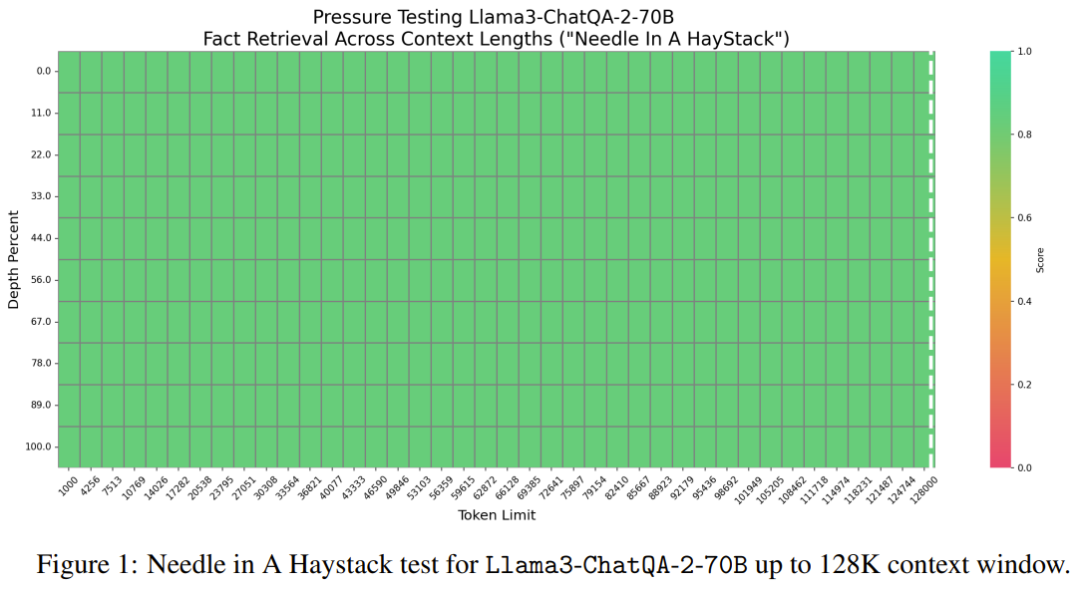

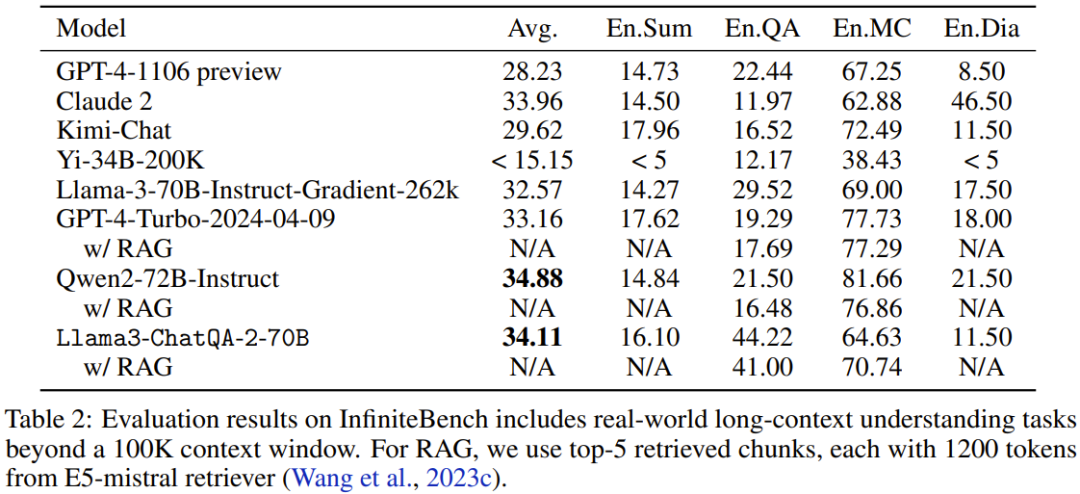

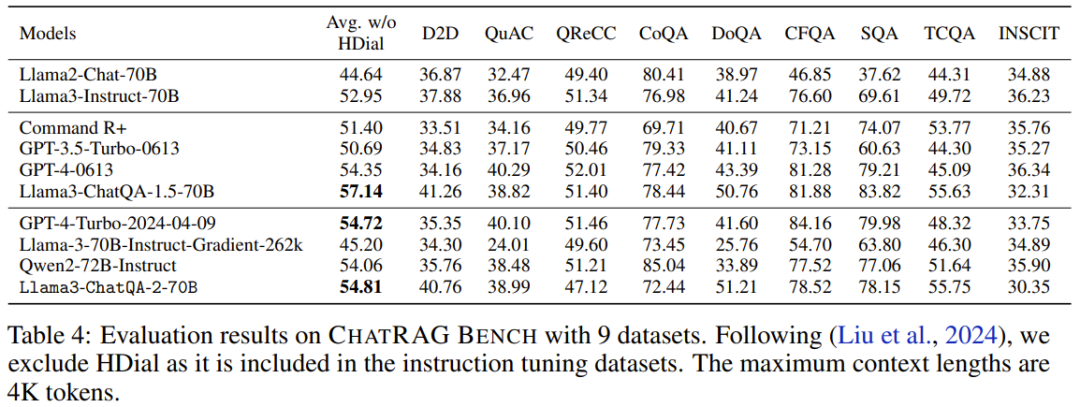

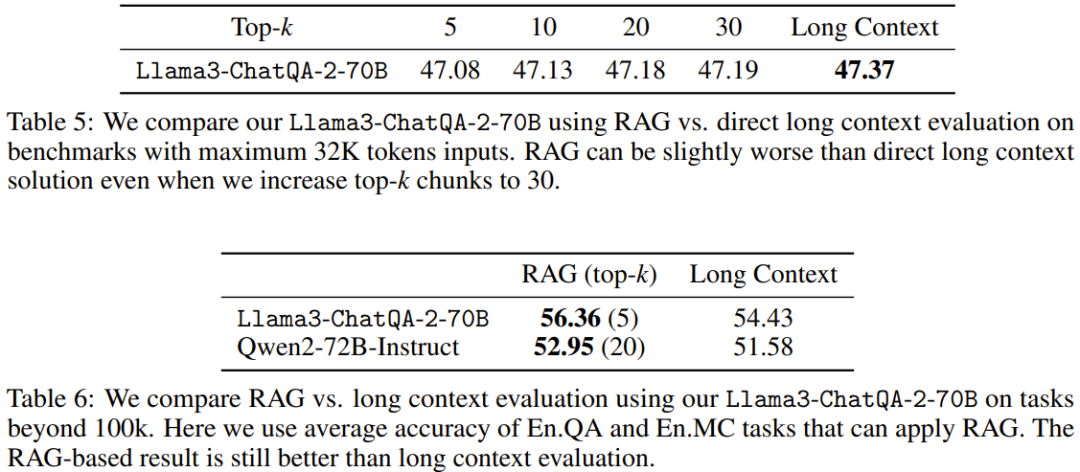

該團隊還設計了一種可同時提升模型的長上下文理解能力和 RAG 性能的指令微調方法。 具體來說,這種指令微調方法分為三個階段。前兩個階段與 ChatQA 1.5 一樣,即首先在 128K 高品質指令遵從資料集訓練模型,然後使用對話問答資料和所提供的上下文組成的混合資料進行訓練。但是,這兩個階段涉及的上下文都比較短 —— 序列長度最大也不過 4K token。為了將模型的上下文視窗大小提升到 128K token,團隊收集了一個長監督式微調(SFT)資料集。 其採用了兩種收集方式: 1. 對於短於 32k 的 SFT 資料序列:利用現有的基於 LongAlpaca12k 的長上下文資料集、來自 Open Orca 的 GPT-4 樣本、Long Data Collections。 2. 對於序列長度在 32k 到 128k 之間的資料:由於收集此類 SFT 樣本的難度很大,因此他們選擇了合成資料集。他們使用了 NarrativeQA,既包含真實的總結(ground truth),也包含語義相關的段落。他們將所有相關段落組裝到了一起,並隨機插入真實總結以模擬用於問答對的真實長文件。 然後,將前兩個階段得到的全長的 SFT 資料集和短 SFT 資料集組合在一起,再進行訓練。這裡學習率設定為 3e-5,批量大小為 32。 長上下文檢索器遇上長上下文 LLM 當前 LLM 使用的 RAG 流程存在一些問題: 1. 為了產生準確答案,top-k 逐塊檢索會引入不可忽略的上下文碎片。舉個例子,之前最佳的基於密集嵌入的檢索器僅支援 512 token。 2. 小top-k(例如5 或10)會導致召回率相對較低,而大top-k(例如100)則會導致產生結果變差,因為之前的LLM 無法很好地使用太多已分塊的上下文。 為了解決這個問題,該團隊提出使用最近期的長上下文檢索器,其支援成千上萬 token。具體來說,他們選擇使用 E5-mistral 嵌入模型作為檢索器。 表 1 比較了 top-k 檢索的不同區塊大小和上下文視窗中的 token 總數。 比較 token 數從 3000 到 12000 的變化情況,團隊發現 token 越多,結果越好,這就確認了新模型的長上下文能力確實不錯。他們還發現,如果總 token 數為 6000,則成本和效能之間會有比較好的權衡。當將總 token 數設定為 6000 後,他們又發現文字區塊越大,結果越好。因此,在實驗中,他們選擇的預設設定是區塊大小為 1200 以及 top-5 的文字區塊。 實驗 評估基準 為了進行全面的評估,分析不同的上下文長度,該團隊使用了三類評估基準: 1. 長上下文基準,超過100K token;中等長上下文基準,低於32K token; 3. 短上下文基準,低於4K token。 如果下游任務可以使用 RAG,就會使用 RAG。 該團隊首先進行了基於合成數據的 Needle in a Haystack(大海撈針)測試,然後測試了模型的真實世界長上下文理解和 RAG 能力。 1. 大海撈針測試 Llama3-ChatQA-2-70B 能否在文本之海中找到目標針?這是一個常用於測試 LLM 長上下文能力的合成任務,可看作是在評估 LLM 的閾值水準。圖 1 展示了新模型在 128K token 中的表現,可以看到新模型的準確度達到了 100%。此測試證實新模型具有堪稱完美的長上下文檢索能力。 在來自 InfiniteBench 的真實世界任務上,該團隊評估了模型在上下文長度超過 100K token 時的性能表現。結果見表 2。 3. token 數在 32K 以內的中等長上下文評估 表 3 給出了上下文的 token 數在 32K 以內時各模型的性能表現。 可以看到,GPT-4-Turbo-2024-04-09 的分數最高,為 51.93。新模型的分數為 47.37,比 Llama-3-70B-Instruct-Gradient-262k 高,但低於 Qwen2-72B-Instruct。原因可能是 Qwen2-72B-Instruct 的預訓練大量使用了 32K token,而團隊使用的持續預訓練語料庫小得多。此外,他們還發現所有 RAG 解決方案的表現都遜於長上下文解決方案,這表明所有這些當前最佳的長上下文 LLM 都可以在其上下文視窗內處理 32K token。 4. ChatRAG Bench:token 數低於 4K 的短上下文評估 在 ChatRAG Bench 上,該團隊評估了模型在上下文長度少於 4K token 時的性能表現,見表 4。 新模型的平均分數為 54.81。儘管這個成績不如 Llama3-ChatQA-1.5-70B,但依然優於 GPT-4-Turbo-2024-04-09 和 Qwen2-72B-Instruct。這證明了一點:將短上下文模型擴展成長上下文模型是有代價的。這也引出了一個值得探索的研究方向:如何進一步擴展上下文視窗同時又不影響其在短上下文任務上的表現? 5. 對比 RAG 與長上下文 表 5 和表 6 比較了使用不同的上下文長度時,RAG 與長上下文解決方案的表現。當序列長度超過 100K 時,僅報告了 En.QA 和 En.MC 的平均分數,因為 RAG 設定無法直接用於 En.Sum 和 En.Dia。 可以看到,當下游任務的序列長度低於 32K 時,新提出的長上下文解決方案優於 RAG。這意味著使用 RAG 可以節省成本,但準確度會下降。 另一方面,當上下文長度超過 100K 時,RAG(Llama3-ChatQA-2-70B 使用 top-5,Qwen2-72B-Instruct 使用 top-20)優於長上下文解決方案。這意味著當 token 數超過 128K 時,即使當前最佳的長上下文 LLM,也可能難以實現有效的理解和推理。團隊建議在這種情況下,能使用 RAG 就盡量使用 RAG,因為其能帶來更高的準確度和更低的推理成本。

2. 超過 100K token 的長上下文評估

2. 超過 100K token 的長上下文評估 可以看到,新模型的表現優於許多當前最佳模型,例如GPT4-Turbo-2024-04-09 (33.16)、GPT4-1106 preview (28.23)、Llama-3-70B-Instruct -Gradient-262k (32.57) 和Claude 2 (33.96)。此外,新模型的成績也已經非常接近 Qwen2-72B-Instruct 得到的最高分數 34.88。整體來看,英偉達的這個新模型頗具競爭力。

可以看到,新模型的表現優於許多當前最佳模型,例如GPT4-Turbo-2024-04-09 (33.16)、GPT4-1106 preview (28.23)、Llama-3-70B-Instruct -Gradient-262k (32.57) 和Claude 2 (33.96)。此外,新模型的成績也已經非常接近 Qwen2-72B-Instruct 得到的最高分數 34.88。整體來看,英偉達的這個新模型頗具競爭力。

以上是英偉達對話模式ChatQA進化到2.0版本,上下文長度提到128K的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

突破傳統缺陷檢測的界限,\'Defect Spectrum\'首次實現超高精度豐富語意的工業缺陷檢測。

Jul 26, 2024 pm 05:38 PM

突破傳統缺陷檢測的界限,\'Defect Spectrum\'首次實現超高精度豐富語意的工業缺陷檢測。

Jul 26, 2024 pm 05:38 PM

在現代製造業中,精準的缺陷檢測不僅是確保產品品質的關鍵,更是提升生產效率的核心。然而,現有的缺陷檢測資料集常常缺乏實際應用所需的精確度和語意豐富性,導致模型無法辨識特定的缺陷類別或位置。為了解決這個難題,由香港科技大學廣州和思謀科技組成的頂尖研究團隊,創新地開發了「DefectSpectrum」資料集,為工業缺陷提供了詳盡、語義豐富的大規模標註。如表一所示,相較於其他工業資料集,「DefectSpectrum」資料集提供了最多的缺陷標註(5438張缺陷樣本),最細緻的缺陷分類(125個缺陷類別

英偉達對話模式ChatQA進化到2.0版本,上下文長度提到128K

Jul 26, 2024 am 08:40 AM

英偉達對話模式ChatQA進化到2.0版本,上下文長度提到128K

Jul 26, 2024 am 08:40 AM

開放LLM社群正是百花齊放、競相爭鳴的時代,你能看到Llama-3-70B-Instruct、QWen2-72B-Instruct、Nemotron-4-340B-Instruct、Mixtral-8x22BInstruct-v0.1等許多表現優良的模型。但是,相較於以GPT-4-Turbo為代表的專有大模型,開放模型在許多領域仍有明顯差距。在通用模型之外,也有一些專精關鍵領域的開放模型已被開發出來,例如用於程式設計和數學的DeepSeek-Coder-V2、用於視覺-語言任務的InternVL

數百萬晶體資料訓練,解決晶體學相位問題,深度學習方法PhAI登Science

Aug 08, 2024 pm 09:22 PM

數百萬晶體資料訓練,解決晶體學相位問題,深度學習方法PhAI登Science

Aug 08, 2024 pm 09:22 PM

編輯|KX時至今日,晶體學所測定的結構細節和精度,從簡單的金屬到大型膜蛋白,是任何其他方法都無法比擬的。然而,最大的挑戰——所謂的相位問題,仍然是從實驗確定的振幅中檢索相位資訊。丹麥哥本哈根大學研究人員,開發了一種解決晶體相問題的深度學習方法PhAI,利用數百萬人工晶體結構及其相應的合成衍射數據訓練的深度學習神經網絡,可以產生準確的電子密度圖。研究表明,這種基於深度學習的從頭算結構解決方案方法,可以以僅2埃的分辨率解決相位問題,該分辨率僅相當於原子分辨率可用數據的10%到20%,而傳統的從頭算方

GoogleAI拿下IMO奧數銀牌,數學推理模型AlphaProof面世,強化學習 is so back

Jul 26, 2024 pm 02:40 PM

GoogleAI拿下IMO奧數銀牌,數學推理模型AlphaProof面世,強化學習 is so back

Jul 26, 2024 pm 02:40 PM

對AI來說,奧數不再是問題了。本週四,GoogleDeepMind的人工智慧完成了一項壯舉:用AI做出了今年國際數學奧林匹克競賽IMO的真題,並且距拿金牌僅一步之遙。上週剛結束的IMO競賽共有六道賽題,涉及代數、組合學、幾何和數論。谷歌提出的混合AI系統做對了四道,獲得28分,達到了銀牌水準。本月初,UCLA終身教授陶哲軒剛剛宣傳了百萬美元獎金的AI數學奧林匹克競賽(AIMO進步獎),沒想到7月還沒過,AI的做題水平就進步到了這種水平。 IMO上同步做題,做對了最難題IMO是歷史最悠久、規模最大、最負

PRO | 為什麼基於 MoE 的大模型更值得關注?

Aug 07, 2024 pm 07:08 PM

PRO | 為什麼基於 MoE 的大模型更值得關注?

Aug 07, 2024 pm 07:08 PM

2023年,幾乎AI的每個領域都在以前所未有的速度進化,同時,AI也不斷地推動著具身智慧、自動駕駛等關鍵賽道的技術邊界。在多模態趨勢下,Transformer作為AI大模型主流架構的局面是否會撼動?為何探索基於MoE(專家混合)架構的大模型成為業界新趨勢?大型視覺模型(LVM)能否成為通用視覺的新突破? ……我們從過去的半年發布的2023年本站PRO會員通訊中,挑選了10份針對以上領域技術趨勢、產業變革進行深入剖析的專題解讀,助您在新的一年裡為大展宏圖做好準備。本篇解讀來自2023年Week50

為大模型提供全新科學複雜問答基準與評估體系,UNSW、阿貢、芝加哥大學等多家機構共同推出SciQAG框架

Jul 25, 2024 am 06:42 AM

為大模型提供全新科學複雜問答基準與評估體系,UNSW、阿貢、芝加哥大學等多家機構共同推出SciQAG框架

Jul 25, 2024 am 06:42 AM

編輯|ScienceAI問答(QA)資料集在推動自然語言處理(NLP)研究中發揮著至關重要的作用。高品質QA資料集不僅可以用於微調模型,也可以有效評估大語言模型(LLM)的能力,尤其是針對科學知識的理解和推理能力。儘管目前已有許多科學QA數據集,涵蓋了醫學、化學、生物等領域,但這些數據集仍有一些不足之處。其一,資料形式較為單一,大多數為多項選擇題(multiple-choicequestions),它們易於進行評估,但限制了模型的答案選擇範圍,無法充分測試模型的科學問題解答能力。相比之下,開放式問答

準確率達60.8%,浙大基於Transformer的化學逆合成預測模型,登Nature子刊

Aug 06, 2024 pm 07:34 PM

準確率達60.8%,浙大基於Transformer的化學逆合成預測模型,登Nature子刊

Aug 06, 2024 pm 07:34 PM

編輯|KX逆合成是藥物發現和有機合成中的關鍵任務,AI越來越多地用於加快這一過程。現有AI方法性能不盡人意,多樣性有限。在實踐中,化學反應通常會引起局部分子變化,反應物和產物之間存在很大重疊。受此啟發,浙江大學侯廷軍團隊提出將單步逆合成預測重新定義為分子串編輯任務,迭代細化目標分子串以產生前驅化合物。並提出了基於編輯的逆合成模型EditRetro,該模型可以實現高品質和多樣化的預測。大量實驗表明,模型在標準基準資料集USPTO-50 K上取得了出色的性能,top-1準確率達到60.8%。

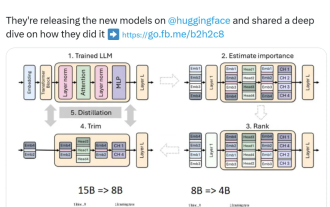

英偉達玩轉剪枝、蒸餾:把Llama 3.1 8B參數減半,性能同尺寸更強

Aug 16, 2024 pm 04:42 PM

英偉達玩轉剪枝、蒸餾:把Llama 3.1 8B參數減半,性能同尺寸更強

Aug 16, 2024 pm 04:42 PM

小模型崛起了。上個月,Meta發布了Llama3.1系列模型,其中包括Meta迄今為止最大的405B模型,以及兩個較小的模型,參數量分別為700億和80億。 Llama3.1被認為是引領了開源新時代。然而,新一代的模型雖然效能強大,但部署時仍需要大量運算資源。因此,業界出現了另一種趨勢,即開發小型語言模型(SLM),這種模型在許多語言任務中表現足夠出色,部署起來也非常便宜。最近,英偉達研究表明,結構化權重剪枝與知識蒸餾相結合,可以從初始較大的模型中逐步獲得較小的語言模型。圖靈獎得主、Meta首席A