ACM MM2024 | 網易伏羲多模態研究再獲國際認可,推動特定領域跨模態理解新突破

- 此論文研究方向涉及視覺語言預訓練(VLP)、跨模態圖文檢索(CMITR)等領域。此次入選標誌著網易伏羲實驗室多模態能力再受國際認可,目前相關技術已應用至網易伏羲自研多模態智能體助手「丹青約」。

- ACM MM由國際電腦協會(ACM)發起,是多媒體處理、分析與運算領域最具影響力的國際頂尖會議,也是中國電腦學會推薦的多媒體領域A類國際學術會議。作為領域內的頂級會議,ACM MM 受到國內外知名廠商和學者廣泛關注。本屆ACM MM共收到有效稿件4,385篇,其中1149篇由大會接收,接收率為26.20%。

作為國內領先的人工智慧研究機構,網易伏羲在大規模模型研究領域已有近六年的深厚積累,具備豐富的演算法和工程經驗,先後打造了數十個文本和多模態預訓練模型,包括文字理解和生成大模型、圖文理解大模型、圖文生成大模型等。這些成果不僅有效地推動了大模型在遊戲領域的應用,也為跨模態理解能力的發展奠定了堅實的基礎。跨模態理解能力有助於更好地融合多種領域知識,並對齊豐富的資料模態及資訊。

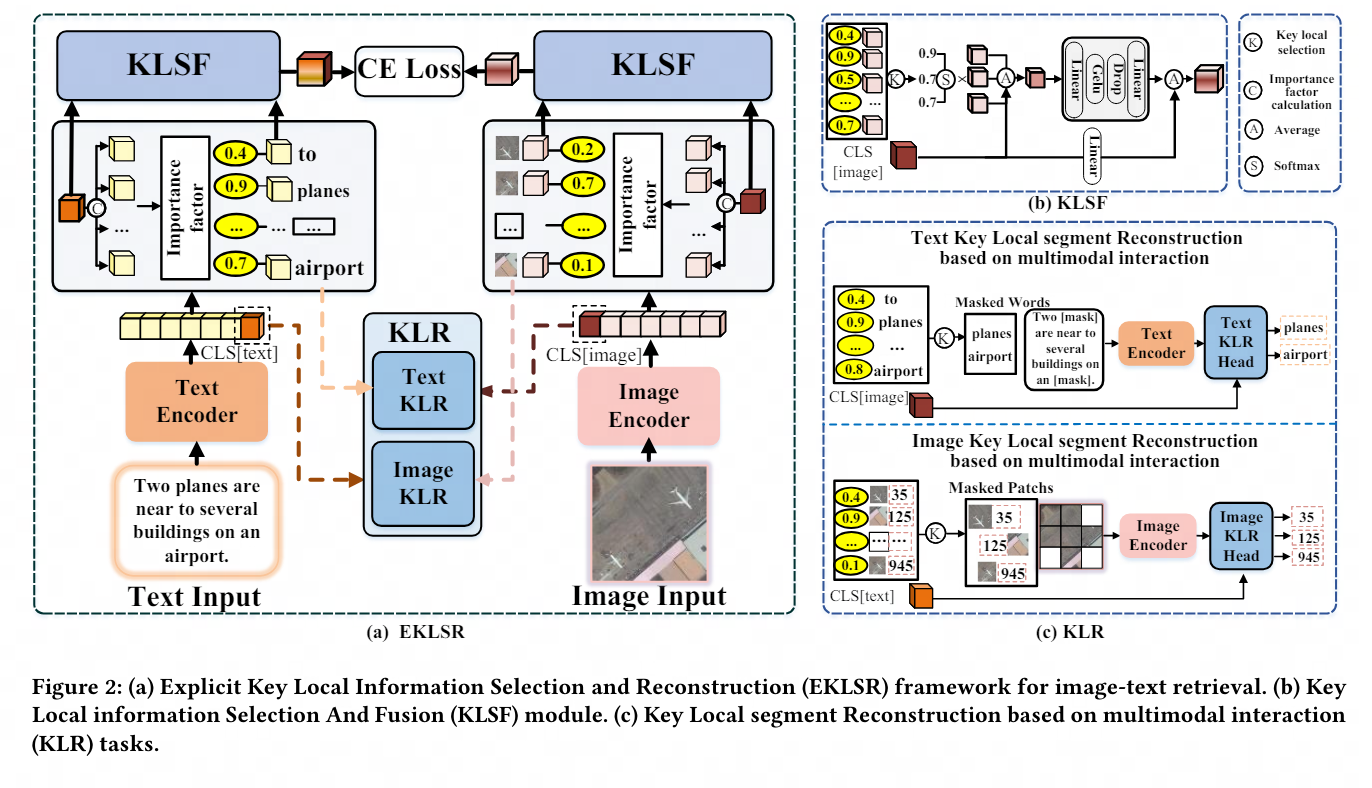

在此基礎上,網易伏羲基於圖文理解大模型進一步創新,提出一種基於關鍵局部信息的選取與重建的跨模態檢索方法,為多模態智能體解決特定領域下的圖像文本互動問題奠定技術基礎。

以下為本次入選論文概要:

《Selection and Reconstruction of Key Locals: A Novel Specific Domain Image-Text Retrieval Method》

關鍵局部資訊的選取與重建:一種新穎的特定領域圖文檢索方法

關鍵字:關鍵局部訊息,細微,可解釋

涉及領域:視覺語言預訓練(VLP),跨模態圖文檢索(CMITR)

近年來,隨著視覺語言預訓練(Vision- Language Pretraining, VLP) 模型的興起,跨模態影像文字檢索(Cross-Modal Image-Text Retrieval, CMITR) 領域取得了顯著進展。儘管像 CLIP 這樣的 VLP 模型在一般領域的 CMITR 任務中表現出色,但在特定領域影像文字擷取 (Specific Domain Image-Text Retrieval, SDITR) 中,其效能往往會不足。這是因為特定領域通常具有獨特的資料特徵,這些特徵區別於一般領域。

在特定領域內,圖像之間可能展現出高度的視覺相似性,而語義差異則往往集中在關鍵的局部細節上,例如圖像中的特定對象區域或文本中含義豐富的詞彙。即使是這些局部片段的細微變化也可能對整個內容產生顯著影響,從而凸顯了這些關鍵局部訊息的重要性。因此,SDITR 要求模型專注於關鍵的局部資訊片段,以增強影像與文字特徵在共享表示空間中的表達,進而改善影像與文字之間的對齊精確度。

本主題透過探討視覺語言預訓練模型在特定領域圖像-文字檢索任務中的應用,研究了特定領域圖像-文字檢索任務中的局部特徵利用問題。主要貢獻在於提出了一種利用具有判別性的細粒度局部資訊的方法,優化圖像與文字在共享表示空間中的對齊。

為此,我們設計了顯式關鍵局部資訊選擇和重建框架和基於多模態交互的關鍵局部段重構策略,這些方法有效地利用了具有判別性的細粒度局部信息,從而顯著提升了圖像與文本在共享空間中的對齊質量,廣泛和充分的實驗證明了所提出策略的先進性和有效性。

在此特別感謝西安電子科技大學IPIU實驗室對本論文的大力支持與重要研究貢獻。

現在、NetEase Fuxi のマルチモーダル理解機能は、NetEase Leihuo、NetEase Cloud Music、NetEase Yuanqi などを含む NetEase グループの複数の事業部門で広く使用されています。これらのアプリケーションは、ゲーム内の革新的なテキストベースの顔をつまむゲームプレイ、クロスモーダル リソース検索、パーソナライズされたコンテンツの推奨など、さまざまなシナリオをカバーしており、大きなビジネス価値を実証しています。

将来的には、研究の深化と技術の進歩に伴い、この成果により、教育、医療、電子商取引、その他の業界における人工知能技術の広範な適用が促進され、よりパーソナライズされたインテリジェントなサービス体験がユーザーに提供されることが期待されます。 NetEase Fuxiはまた、国内外のトップ学術機関との交流と協力を深め、より最先端の研究分野での深い探求を実施し、人工知能技術の開発を共同で推進し、より効率的でスマートな社会の構築に貢献していきます。社会。

下のQRコードをスキャンして「写真アポイントメント」をすぐに体験し、「よりよく理解できる」写真とテキストによるマルチモーダルなインタラクティブ体験をお楽しみください。

以上是ACM MM2024 | 網易伏羲多模態研究再獲國際認可,推動特定領域跨模態理解新突破的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

位元組跳動剪映推出 SVIP 超級會員:連續包年 499 元,提供多種 AI 功能

Jun 28, 2024 am 03:51 AM

位元組跳動剪映推出 SVIP 超級會員:連續包年 499 元,提供多種 AI 功能

Jun 28, 2024 am 03:51 AM

本站6月27日訊息,剪映是由位元組跳動旗下臉萌科技開發的一款影片剪輯軟體,依託於抖音平台且基本面向該平台用戶製作短影片內容,並相容於iOS、安卓、Windows 、MacOS等作業系統。剪映官方宣布會員體系升級,推出全新SVIP,包含多種AI黑科技,例如智慧翻譯、智慧劃重點、智慧包裝、數位人合成等。價格方面,剪映SVIP月費79元,年費599元(本站註:折合每月49.9元),連續包月則為59元每月,連續包年為499元每年(折合每月41.6元) 。此外,剪映官方也表示,為提升用戶體驗,向已訂閱了原版VIP

使用Rag和Sem-Rag提供上下文增強AI編碼助手

Jun 10, 2024 am 11:08 AM

使用Rag和Sem-Rag提供上下文增強AI編碼助手

Jun 10, 2024 am 11:08 AM

透過將檢索增強生成和語意記憶納入AI編碼助手,提升開發人員的生產力、效率和準確性。譯自EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG,作者JanakiramMSV。雖然基本AI程式設計助理自然有幫助,但由於依賴對軟體語言和編寫軟體最常見模式的整體理解,因此常常無法提供最相關和正確的程式碼建議。這些編碼助手產生的代碼適合解決他們負責解決的問題,但通常不符合各個團隊的編碼標準、慣例和風格。這通常會導致需要修改或完善其建議,以便將程式碼接受到應

七個很酷的GenAI & LLM技術性面試問題

Jun 07, 2024 am 10:06 AM

七個很酷的GenAI & LLM技術性面試問題

Jun 07, 2024 am 10:06 AM

想了解更多AIGC的內容,請造訪:51CTOAI.x社群https://www.51cto.com/aigc/譯者|晶顏審校|重樓不同於網路上隨處可見的傳統問題庫,這些問題需要跳脫常規思維。大語言模型(LLM)在數據科學、生成式人工智慧(GenAI)和人工智慧領域越來越重要。這些複雜的演算法提升了人類的技能,並在許多產業中推動了效率和創新性的提升,成為企業保持競爭力的關鍵。 LLM的應用範圍非常廣泛,它可以用於自然語言處理、文字生成、語音辨識和推薦系統等領域。透過學習大量的數據,LLM能夠產生文本

微調真的能讓LLM學到新東西嗎:引入新知識可能讓模型產生更多的幻覺

Jun 11, 2024 pm 03:57 PM

微調真的能讓LLM學到新東西嗎:引入新知識可能讓模型產生更多的幻覺

Jun 11, 2024 pm 03:57 PM

大型語言模型(LLM)是在龐大的文字資料庫上訓練的,在那裡它們獲得了大量的實際知識。這些知識嵌入到它們的參數中,然後可以在需要時使用。這些模型的知識在訓練結束時被「具體化」。在預訓練結束時,模型實際上停止學習。對模型進行對齊或進行指令調優,讓模型學習如何充分利用這些知識,以及如何更自然地回應使用者的問題。但是有時模型知識是不夠的,儘管模型可以透過RAG存取外部內容,但透過微調使用模型適應新的領域被認為是有益的。這種微調是使用人工標註者或其他llm創建的輸入進行的,模型會遇到額外的實際知識並將其整合

你所不知道的機器學習五大學派

Jun 05, 2024 pm 08:51 PM

你所不知道的機器學習五大學派

Jun 05, 2024 pm 08:51 PM

機器學習是人工智慧的重要分支,它賦予電腦從數據中學習的能力,並能夠在無需明確編程的情況下改進自身能力。機器學習在各個領域都有廣泛的應用,從影像辨識和自然語言處理到推薦系統和詐欺偵測,它正在改變我們的生活方式。機器學習領域存在著多種不同的方法和理論,其中最具影響力的五種方法被稱為「機器學習五大派」。這五大派分別為符號派、聯結派、進化派、貝葉斯派和類推學派。 1.符號學派符號學(Symbolism),又稱符號主義,強調利用符號進行邏輯推理和表達知識。該學派認為學習是一種逆向演繹的過程,透過現有的

為大模型提供全新科學複雜問答基準與評估體系,UNSW、阿貢、芝加哥大學等多家機構共同推出SciQAG框架

Jul 25, 2024 am 06:42 AM

為大模型提供全新科學複雜問答基準與評估體系,UNSW、阿貢、芝加哥大學等多家機構共同推出SciQAG框架

Jul 25, 2024 am 06:42 AM

編輯|ScienceAI問答(QA)資料集在推動自然語言處理(NLP)研究中發揮著至關重要的作用。高品質QA資料集不僅可以用於微調模型,也可以有效評估大語言模型(LLM)的能力,尤其是針對科學知識的理解和推理能力。儘管目前已有許多科學QA數據集,涵蓋了醫學、化學、生物等領域,但這些數據集仍有一些不足之處。其一,資料形式較為單一,大多數為多項選擇題(multiple-choicequestions),它們易於進行評估,但限制了模型的答案選擇範圍,無法充分測試模型的科學問題解答能力。相比之下,開放式問答

SOTA性能,廈大多模態蛋白質-配體親和力預測AI方法,首次結合分子表面訊息

Jul 17, 2024 pm 06:37 PM

SOTA性能,廈大多模態蛋白質-配體親和力預測AI方法,首次結合分子表面訊息

Jul 17, 2024 pm 06:37 PM

編輯|KX在藥物研發領域,準確有效地預測蛋白質與配體的結合親和力對於藥物篩選和優化至關重要。然而,目前的研究並沒有考慮到分子表面訊息在蛋白質-配體相互作用中的重要作用。基於此,來自廈門大學的研究人員提出了一種新穎的多模態特徵提取(MFE)框架,該框架首次結合了蛋白質表面、3D結構和序列的信息,並使用交叉注意機制進行不同模態之間的特徵對齊。實驗結果表明,該方法在預測蛋白質-配體結合親和力方面取得了最先進的性能。此外,消融研究證明了該框架內蛋白質表面資訊和多模態特徵對齊的有效性和必要性。相關研究以「S

SK 海力士 8 月 6 日將展示 AI 相關新品:12 層 HBM3E、321-high NAND 等

Aug 01, 2024 pm 09:40 PM

SK 海力士 8 月 6 日將展示 AI 相關新品:12 層 HBM3E、321-high NAND 等

Aug 01, 2024 pm 09:40 PM

本站8月1日消息,SK海力士今天(8月1日)發布博文,宣布將出席8月6日至8日,在美國加州聖克拉拉舉行的全球半導體記憶體峰會FMS2024,展示諸多新一代產品。未來記憶體和儲存高峰會(FutureMemoryandStorage)簡介前身是主要面向NAND供應商的快閃記憶體高峰會(FlashMemorySummit),在人工智慧技術日益受到關注的背景下,今年重新命名為未來記憶體和儲存高峰會(FutureMemoryandStorage),以邀請DRAM和儲存供應商等更多參與者。新產品SK海力士去年在