AIxiv專欄是本站發布學術、技術內容的欄位。過去數年,本站AIxiv專欄接收通報了2,000多篇內容,涵蓋全球各大專院校與企業的頂尖實驗室,有效促進了學術交流與傳播。如果您有優秀的工作想要分享,歡迎投稿或聯絡報道。投稿信箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

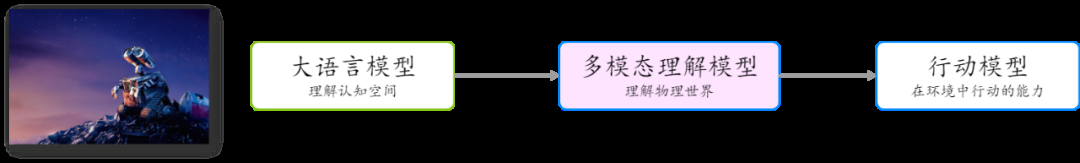

以 GPT 為代表的大型語言模型預示著數位認知空間中通用人工智慧的曙光。這些模型透過處理和產生自然語言,展現了強大的理解和推理能力,已經在多個領域展現出廣泛的應用前景。無論是在內容生成、自動化客服、生產力工具、AI 搜尋、還是在教育和醫療等領域,大型語言模型都在不斷推動科技的進步和應用的普及。 然而,要推動通用人工智慧朝向探索物理世界邁進,第一步是解決視覺理解問題,即多模態理解大模型。多模態理解讓人工智慧能夠像人類一樣,透過多種感官獲取和處理訊息,從而更全面地理解和互動世界。這一領域的突破將使人工智慧在機器人、自動駕駛等方面取得更大的進展,真正實現從數位世界到物理世界的跨越。 去年 6 月 GPT-4V 發布,但相較於大型語言模型,多模態理解模型的發展顯得較為緩慢,尤其是在中文領域。此外,不同於大語言模型的技術路線和選型相對確定,業界對於多模態模型的架構和訓練方法的選型還沒有完全形成共識。

大模式從認知空間邁向近期,騰訊混元推出了基於 MoE 架構的多模態理解大模型。該模型在架構、訓練方法和資料處理方面進行了創新和深度優化,顯著提升了其性能,並能支援任意長寬比及最高 7K 解析度圖片的理解。與大部分多模態模型主要在開源基準測試中進行調優不同,騰訊混元多模態模型更注重模型的通用性、實用性和可靠性,具備豐富的多模態場景理解能力。在近期發布的中文多模態大模型 SuperCLUE-V 基準評測中(2024 年 8 月),騰訊混元斬獲國內排名第一,超越了多個主流閉源模型。 騰訊混元語言大模型,在國內能力率先採用混合專家模型(MoE) 架構,模型整體性能相比一代上一代提昇50%,部分中文能力率先提升50%已追平GPT-4o,在「時新」 問題的回答表現上,數學、推理等能力上均有較大提升。早在今年年初,騰訊混元就將此模型應用於騰訊元寶。

騰訊混元認為,能夠解決海量通用任務的 MoE 架構,也是多模態理解場景的最佳選擇。 MoE 能夠更好地相容於更多模態和任務,確保不同模態和任務之間是互相促進而非競爭的關係。

依托騰訊混元語言大模型的能力,騰訊混元推出了基於MoE架構的多模態理解大模型,在架構、訓練方法和數據處理方面進行了創新和深度優化,性能得到顯著提升。這也是國內首個基於MoE架構的多模態大模型。

除了採用MoE 架構外,騰訊混元多模態模型的設計也遵循簡單、合理、可規模化的原則:

支援原生任意解析度:與業界主流的固定解析度或切子圖方法相比,騰訊混元多模態模型能夠處理原生任意解析度的圖片,實現了首個支援超過7K 解析度和任意長寬比(例如16:1,見下文範例)圖片理解的多模態模型。 採用簡單的 MLP 轉接器:相較於先前主流的 Q-former 轉接器,MLP 轉接器在訊息傳遞過程中損失較小。

這種力求簡單的設計,使得模型和數據更容易擴展和規模化。

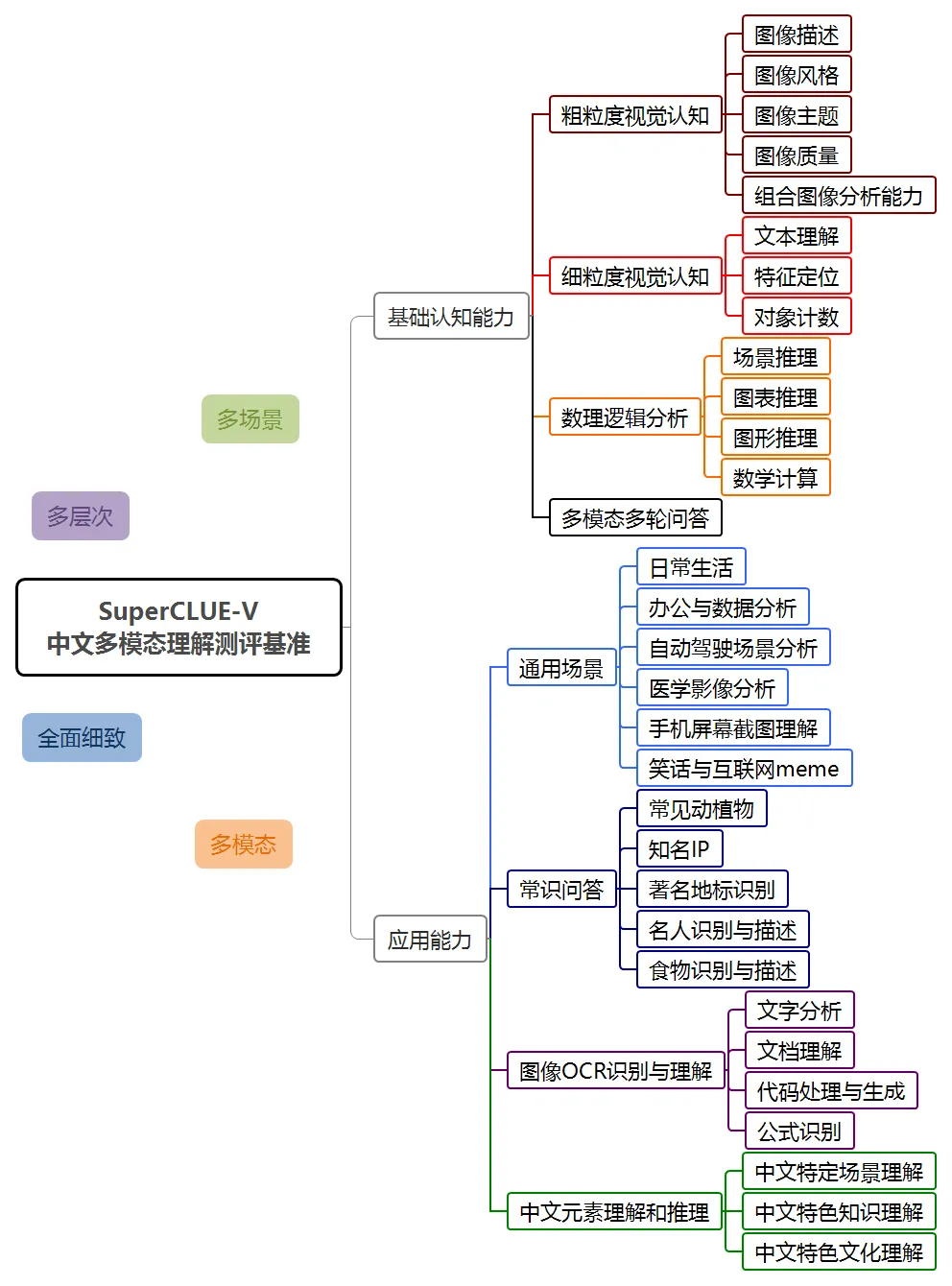

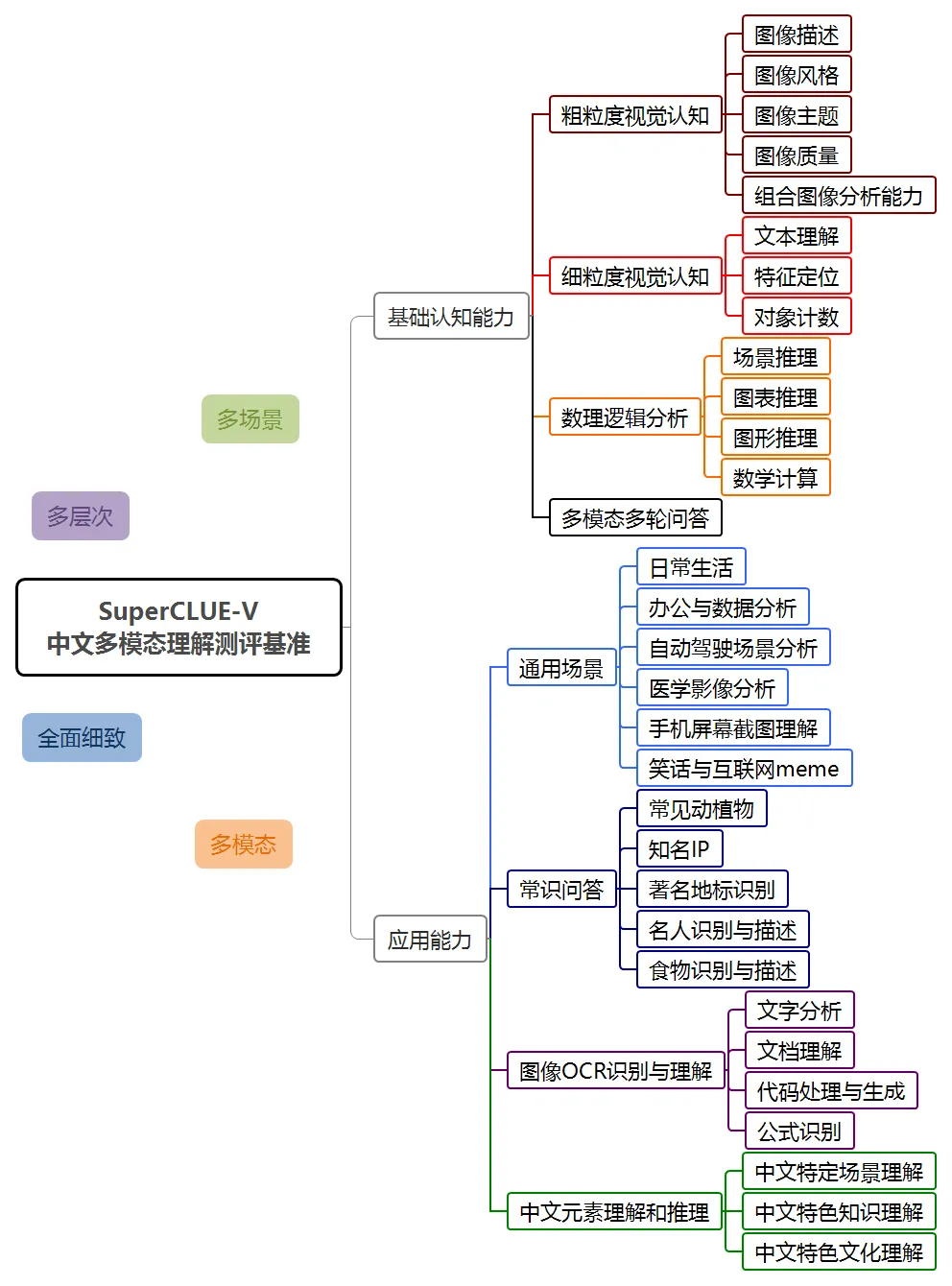

2024 年 8 月,SuperCLUE 首次發布了多模態榜單 ——理解評測榜單 -SuperClueVV。 SuperCLUE-V 基準包括基礎能力和應用能力兩個大方向,以開放式問題形式對多模態大模型進行評估,包含 8 個一級維度 30 個二級維度。

在此次評測中,混元多模態理解系統 hunyuan-vision 取得了 71.95 得分,僅次於 GPT-4o。在多模態應用方面,hunyuan-vision 領先 Claude3.5-Sonnet 和 Gemini-1.5-Pro。

值得注意的是,業界先前的多模態評測多集中於英文能力,評測題目類型多為選擇題或判斷題。而 SuperCLUE-V 評測則更著重於中文能力評測,聚焦在使用者的真實問題。此外,由於是首次發布,尚未出現擬合現象。

騰訊混元圖生文大模型在通用場景、圖像 OCR 識別理解和中文元素理解推理等多個維度上顯示了不錯的性能,也體現了模型在未來應用上的潛力。

面向通用應用場景

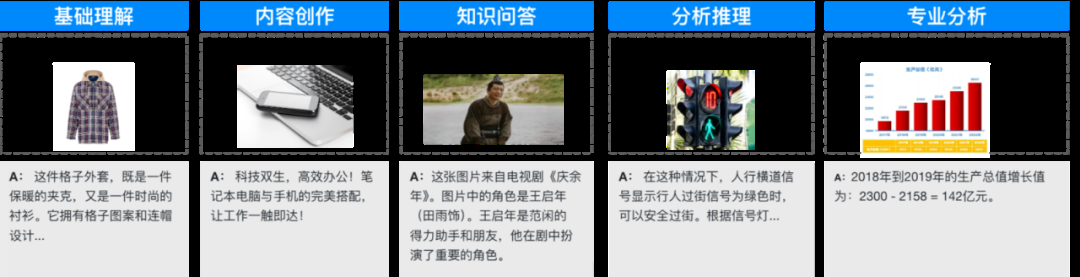

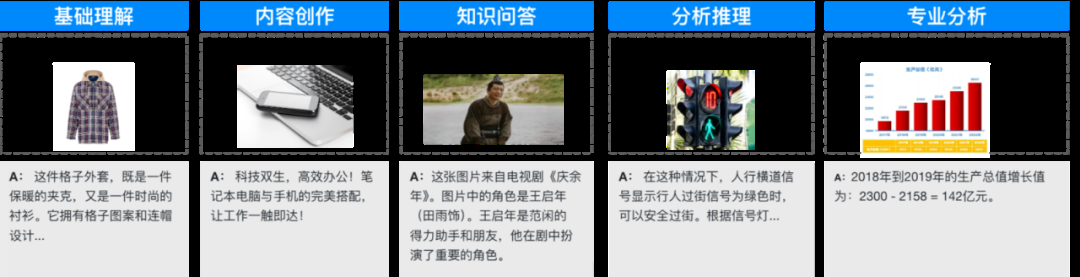

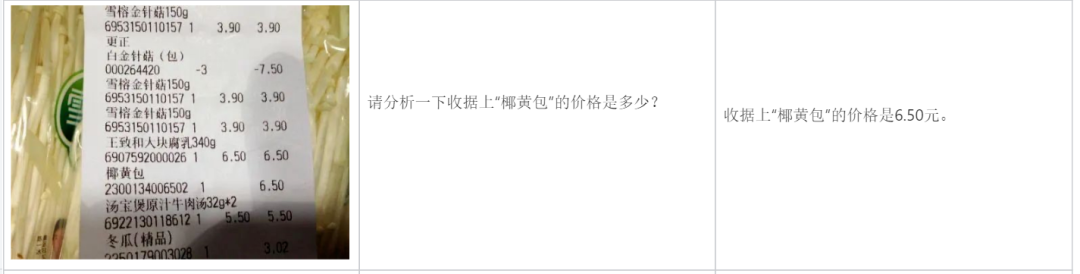

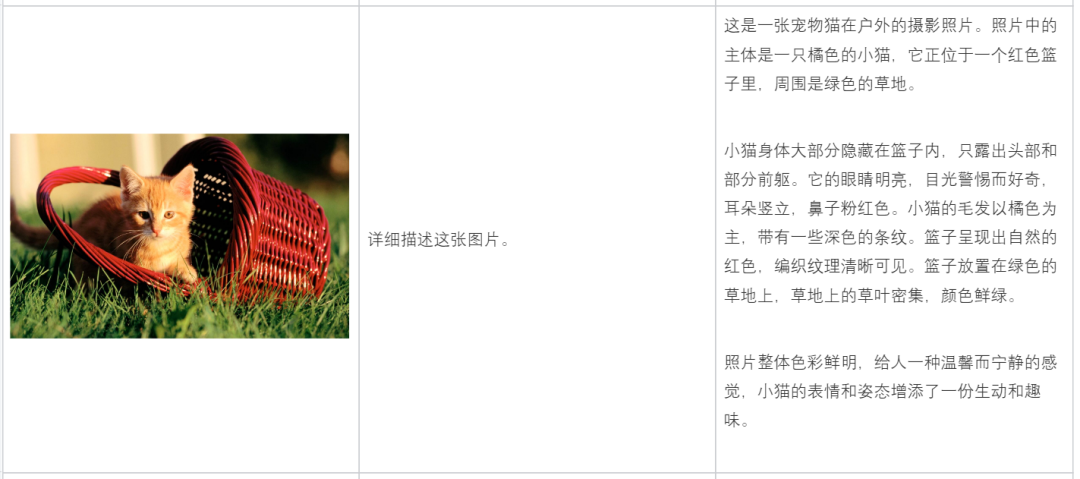

混元多模態理解模型面向通用場景和海量應用進行了最佳化,累積了數千萬相關問答語料,涵蓋圖片基礎理解內容創作、圖片基礎理解推理分析、知識問答、OCR 文件解析、學科答案等眾多場景。以下是一些典型應用實例。

混元多模態理解模型面向通用場景和海量應用進行了最佳化,累積了數千萬相關問答語料,涵蓋圖片基礎理解內容創作、圖片基礎理解推理分析、知識問答、OCR 文件解析、學科答案等眾多場景。以下是一些典型應用實例。

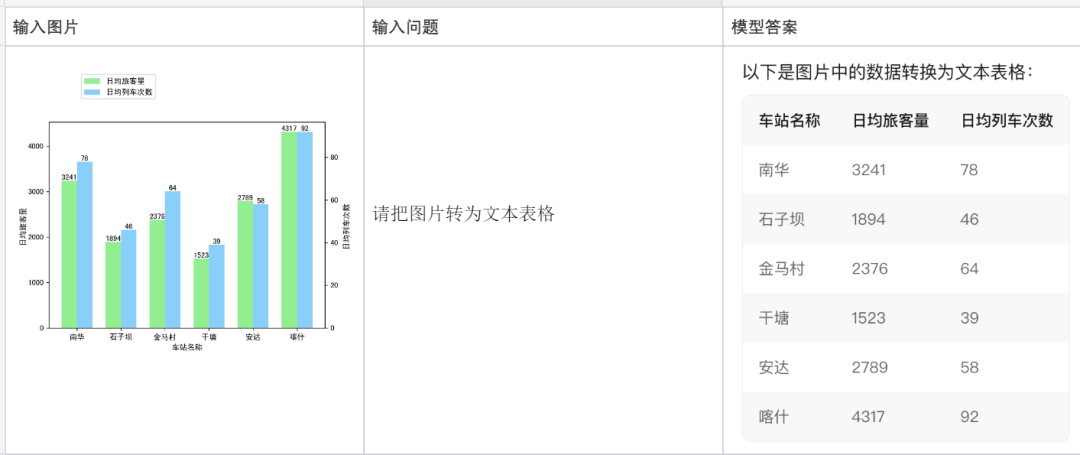

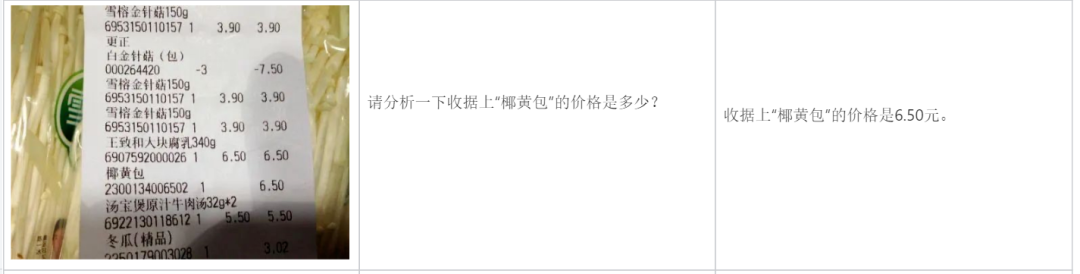

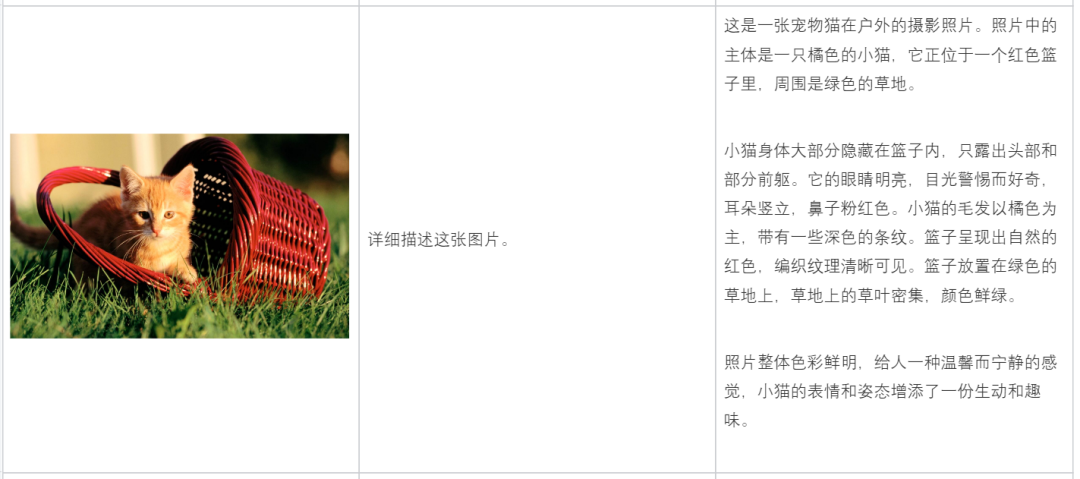

以下是更多典型例子:

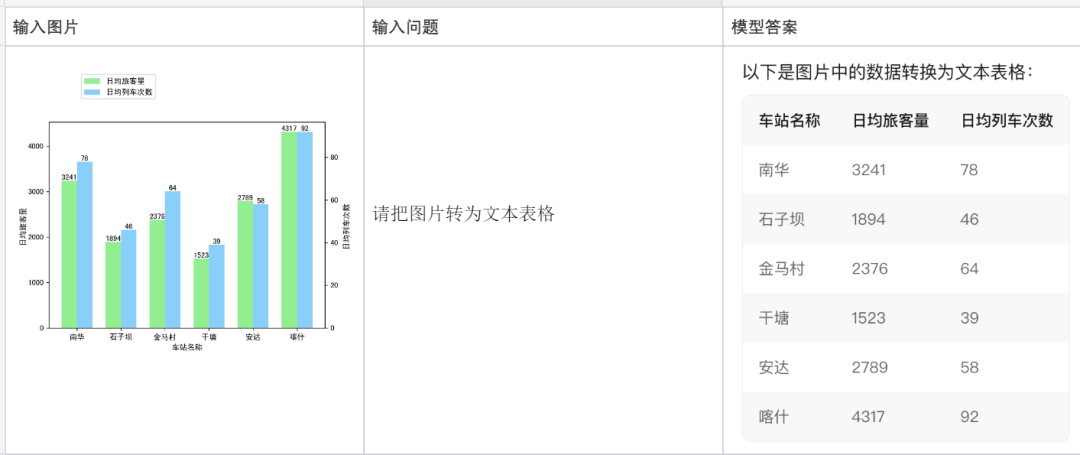

將圖片轉換成文字表格:

根據圖片內容,進行分析:

幫你寫文案:

幫你寫文案:

目前騰訊混元多模態理解大模型已在 AI 助手產品騰訊元寶上線,並透過騰訊雲面向企業及個人開發者開放。

騰訊元寶地址:https://yuanbao.tencent.com/chat

以上是國內首個自研MoE多模態大模型,揭密騰訊混元多模態理解的詳細內容。更多資訊請關注PHP中文網其他相關文章!

混元多模態理解模型面向通用場景和海量應用進行了最佳化,累積了數千萬相關問答語料,涵蓋圖片基礎理解內容創作、圖片基礎理解推理分析、知識問答、OCR 文件解析、學科答案等眾多場景。以下是一些典型應用實例。

混元多模態理解模型面向通用場景和海量應用進行了最佳化,累積了數千萬相關問答語料,涵蓋圖片基礎理解內容創作、圖片基礎理解推理分析、知識問答、OCR 文件解析、學科答案等眾多場景。以下是一些典型應用實例。