建構機器學習模型時的資料集

對於那些開始學習機器學習的人來說,最大的困難之一可能是工作、處理資料、做出小的推論,然後組合你的模型。

在本文中,我將舉例說明如何分析資料集以更好地建立機器學習模型:

- 簡單解釋什麼是機器學習

- 學習的類型和差異

- 理解並從資料集中提取重要資訊

- 處理資料集中的資料

- 模型演算法之間的差異

- 線性迴歸模型的建構

但是讓我們從頭開始,這樣我們就可以了解什麼是機器學習 (ML)?

機器學習是人工智慧 (AI) 的不同分支之一,還有神經網路或機器人技術等。機器學習的類型取決於資料的結構,因此可以將其分為不同的類型,然後建立模型。 ML 模型是使用處理輸入資料並學習預測或分類結果的演算法建立的。

資料集的重要性

要建立ML模型,我們需要一個資料集,資料集中必須有我們的輸入特徵,這基本上是我們的整個資料集,除了目標列,取決於我們的學習類型,如果是監督學習,資料集必須包含目標、標籤或正確答案,因為這些資訊將用於訓練和測試模型。

一些類型的學習及其資料集結構:

- 監督學習:這裡模型透過一組標記資料進行學習,並已提供正確的輸出,因此模型的目標是學習關聯輸入和輸出,以便能夠對新資料進行正確的預測。

- 無監督學習:模型訓練是使用未標記的資料完成的,沒有與輸入相關的正確輸出,因此模型的目標是識別資料中的模式和分組。

- 強化學習: 在這種情況下,模型從與環境的互動中學習。他將在環境中採取行動,並因正確行動而獲得獎勵或因錯誤行動而受到懲罰,其目標是透過最大化導致執行正確行動的行為來充分最大化長期獎勵。

因此,資料集基本上定義了機器產生的模型的整個行為和學習過程。

為了繼續這些範例,我將使用帶有標籤的資料集,舉例說明具有監督學習的模型,其目標是為特定受眾定義人壽保險的每月價值。

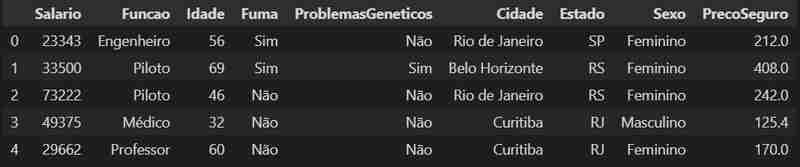

讓我們先載入資料集並查看它的第一行。

import pandas as pd

data = pd.read_csv('../dataset_seguro_vida.csv')

data.head()

讓我們更詳細地描述一下我們的數據,我們可以看到它的格式,並發現資料集中的行數和列數。

data.shape

我們這裡有一個 500 行 9 列的資料結構。

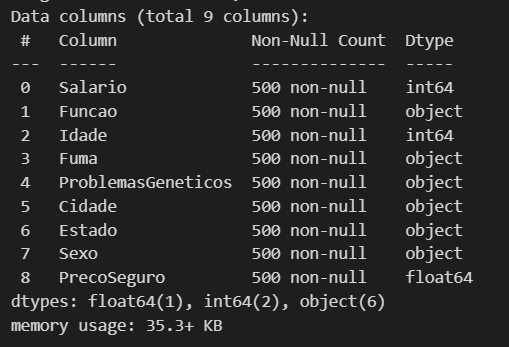

現在讓我們看看我們有哪些類型的資料以及是否缺少任何資料。

data.info()

這裡有3個數字列,包括2個int(整數)和1個float(有小數位的數字),其他6個是物件。所以我們可以繼續下一步處理資料。

處理資料集

改進資料集的一個很好的步驟是了解某些類型的資料比其他資料更容易被模型處理甚至理解。例如,物件類型的資料比較重,甚至限制了使用,因此最好將其轉換為類別,因為這使我們能夠從效能到記憶體使用效率方面獲得一些收益(在最後,我們甚至可以透過進行另一個轉換來改進這一點,但到時候我會更好地解釋).

object_columns = data.select_dtypes(include='object').columns

for col in object_columns:

data[col] = data[col].astype('category')

data.dtypes

Como o nosso objetivo é conseguir estipular o valor da mensalidade de um seguro de vida, vamos dar uma olhada melhor nas nossas variáveis numéricas usando a transposição.

data.describe().T

Podemos aqui ver alguns detalhes e valores dos nossos inputs numéricos, como a média aritmética, o valor mínimo e máximo. Através desses dados podemos fazer a separação desses valores em grupos baseados em algum input de categoria, por gênero, se fuma ou não, entre outros, como demonstração vamos fazer a separação por sexo, para visualizar a media aritmética das colunas divididas por sexo.

value_based_on_sex = data.groupby("Sexo").mean("PrecoSeguro")

value_based_on_sex

Como podemos ver que no nosso dataset os homens acabam pagando um preço maior de seguro (lembrando que esse dataset é fictício).

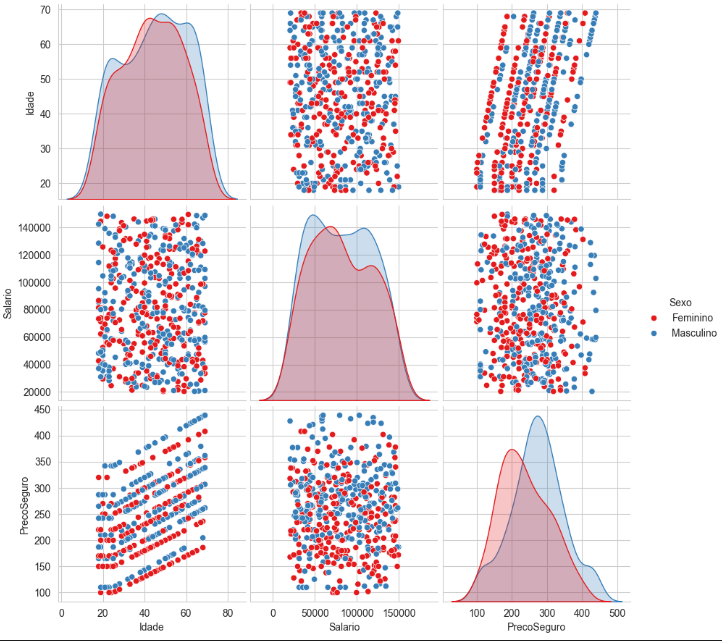

Podemos ter uma melhor visualização dos dados através do seaborn, é uma biblioteca construída com base no matplotlib usada especificamente para plotar gráficos estatísticos.

import seaborn as sns

sns.set_style("whitegrid")

sns.pairplot(

data[["Idade", "Salario", "PrecoSeguro", "Sexo"]],

hue = "Sexo",

height = 3,

palette = "Set1")

Aqui podemos visualizar a distribuição desses valores através dos gráficos ficando mais claro a separação do conjunto, com base no grupo que escolhemos, como um teste você pode tentar fazer um agrupamento diferente e ver como os gráficos vão ficar.

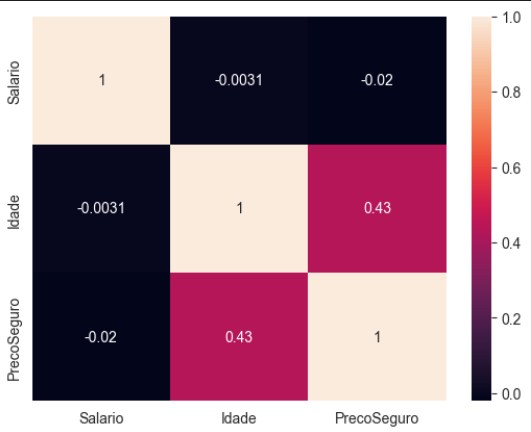

Vamos criar uma matriz de correlação, sendo essa uma outra forma de visualizar a relação das variáveis numéricas do dataset, com o auxilio visual de um heatmap.

numeric_data = data.select_dtypes(include=['float64', 'int64']) corr_matrix = numeric_data.corr() sns.heatmap(corr_matrix, annot= True)

Essa matriz transposta nos mostra quais variáveis numéricas influenciam mais no nosso modelo, é um pouco intuitivo quando você olha para a imagem, podemos observar que a idade é a que mais vai interferir no preço do seguro.

Basicamente essa matriz funciona assim:

Os valores variam entre -1 e 1:

1: Correlação perfeita positiva - Quando uma variável aumenta, a outra também aumenta proporcionalmente.

0: Nenhuma correlação - Não há relação linear entre as variáveis.

-1: Correlação perfeita negativa - Quando uma variável aumenta, a outra diminui proporcionalmente.

Lembra da transformada que fizemos de object para category nos dados, agora vem a outra melhoria comentada, com os dados que viraram category faremos mais uma transformada, dessa vez a ideia é transformar essa variáveis categóricas em representações numéricas, isso nos permitirá ter um ganho incrível com o desempenho do modelo já que ele entende muito melhor essas variáveis numéricas.

Conseguimos fazer isso facilmente com a lib do pandas, o que ele faz é criar nova colunas binarias para valores distintos, o pandas é uma biblioteca voltada principalmente para analise de dados e estrutura de dados, então ela já possui diversas funcionalidades que nos auxiliam nos processo de tratamento do dataset.

data = pd.get_dummies(data)

Pronto agora temos nossas novas colunas para as categorias.

Decidindo o Algoritmo

Para a construção do melhor modelo, devemos saber qual o algoritmo ideal para o propósito da ML, na tabela seguinte vou deixar um resumo simplificado de como analisar seu problema e fazer a melhor escolha.

Olhando a tabela podemos ver que o problema que temos que resolver é o de regressão. Aqui vai mais uma dica, sempre comesse simples e vá incrementando seu e fazendo os ajustes necessários até os valores de previsibilidade do modelo ser satisfatório.

Para o nosso exemplo vamos montar um modelo de Regressão Linear, já que temos uma linearidade entre os nossos inputs e temos como target uma variável numérica.

Sabemos que a nossa variável target é a coluna PrecoSeguro , as outras são nossos inputs. Os inputs em estatísticas são chamadas de variável independente e o target de variável dependente, pelos nomes fica claro que a ideia é que o nosso target é uma variável que depende dos nosso inputs, se os inputs variam nosso target tem que vai variar também.

Vamos definir nosso y com o target

y = data["PrecoSeguro"]

E para x vamos remover a coluna target e inserir todas as outras

X = data.drop("PrecoSeguro", axis = 1)

Antes de montarmos o modelo, nosso dataset precisa ser dividido uma parte para teste e outra para o treino, para fazer isso vamos usar do scikit-learn o método train_test_split.

from sklearn.model_selection import train_test_split

X_train,X_test,y_train,y_test=train_test_split(

X,y,

train_size = 0.80,

random_state = 1)

Aqui dividimos o nosso dataset em 80% para treino e 20% para testes. Agora podemos montar o nosso modelo.

from sklearn.linear_model import LinearRegression lr = LinearRegression() lr.fit(X_train,y_train)

Modelo montado agora podemos avaliar seu desempenho

lr.score(X_test, y_test). lr.score(X_train, y_train)

Aqui podemos analisar a o coeficiente de determinação do nosso modelo para testes e para o treinamento.

Podemos usar um outro método para poder descobrir o desvio padrão do nosso modelo, e entender a estabilidade e a confiabilidade do desempenho do modelo para a amostra

<p>from sklearn.metrics import mean_squared_error<br> import math</p> <p>y_pred = lr.predict(X_test)<br> math.sqrt(mean_squared_error(y_test, y_pred))</p>

Considerações

O valor perfeito do coeficiente de determinação é 1, quanto mais próximo desse valor, teoricamente melhor seria o nosso modelo, mas um ponto de atenção é basicamente impossível você conseguir um modelo perfeito, até mesmo algo acima de 0.95 é de se desconfiar.

Se você tiver trabalhando com dados reais e conseguir um valor desse é bom analisar o seu modelo, testar outras abordagens e até mesmo revisar seu dataset, pois seu modelo pode estar sofrendo um overfitting e por isso apresenta esse resultado quase que perfeitos.

Aqui como montamos um dataset com valores irreais e sem nenhum embasamento é normal termos esses valores quase que perfeitos.

Deixarei aqui um link para o github do código e dataset usados nesse post

- GitHub

以上是建構機器學習模型時的資料集的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

Python vs.C:申請和用例

Apr 12, 2025 am 12:01 AM

Python vs.C:申請和用例

Apr 12, 2025 am 12:01 AM

Python适合数据科学、Web开发和自动化任务,而C 适用于系统编程、游戏开发和嵌入式系统。Python以简洁和强大的生态系统著称,C 则以高性能和底层控制能力闻名。

2小時的Python計劃:一種現實的方法

Apr 11, 2025 am 12:04 AM

2小時的Python計劃:一種現實的方法

Apr 11, 2025 am 12:04 AM

2小時內可以學會Python的基本編程概念和技能。 1.學習變量和數據類型,2.掌握控制流(條件語句和循環),3.理解函數的定義和使用,4.通過簡單示例和代碼片段快速上手Python編程。

Python:遊戲,Guis等

Apr 13, 2025 am 12:14 AM

Python:遊戲,Guis等

Apr 13, 2025 am 12:14 AM

Python在遊戲和GUI開發中表現出色。 1)遊戲開發使用Pygame,提供繪圖、音頻等功能,適合創建2D遊戲。 2)GUI開發可選擇Tkinter或PyQt,Tkinter簡單易用,PyQt功能豐富,適合專業開發。

您可以在2小時內學到多少python?

Apr 09, 2025 pm 04:33 PM

您可以在2小時內學到多少python?

Apr 09, 2025 pm 04:33 PM

兩小時內可以學到Python的基礎知識。 1.學習變量和數據類型,2.掌握控制結構如if語句和循環,3.了解函數的定義和使用。這些將幫助你開始編寫簡單的Python程序。

Python與C:學習曲線和易用性

Apr 19, 2025 am 12:20 AM

Python與C:學習曲線和易用性

Apr 19, 2025 am 12:20 AM

Python更易學且易用,C 則更強大但複雜。 1.Python語法簡潔,適合初學者,動態類型和自動內存管理使其易用,但可能導致運行時錯誤。 2.C 提供低級控制和高級特性,適合高性能應用,但學習門檻高,需手動管理內存和類型安全。

Python和時間:充分利用您的學習時間

Apr 14, 2025 am 12:02 AM

Python和時間:充分利用您的學習時間

Apr 14, 2025 am 12:02 AM

要在有限的時間內最大化學習Python的效率,可以使用Python的datetime、time和schedule模塊。 1.datetime模塊用於記錄和規劃學習時間。 2.time模塊幫助設置學習和休息時間。 3.schedule模塊自動化安排每週學習任務。

Python:探索其主要應用程序

Apr 10, 2025 am 09:41 AM

Python:探索其主要應用程序

Apr 10, 2025 am 09:41 AM

Python在web開發、數據科學、機器學習、自動化和腳本編寫等領域有廣泛應用。 1)在web開發中,Django和Flask框架簡化了開發過程。 2)數據科學和機器學習領域,NumPy、Pandas、Scikit-learn和TensorFlow庫提供了強大支持。 3)自動化和腳本編寫方面,Python適用於自動化測試和系統管理等任務。

Python:自動化,腳本和任務管理

Apr 16, 2025 am 12:14 AM

Python:自動化,腳本和任務管理

Apr 16, 2025 am 12:14 AM

Python在自動化、腳本編寫和任務管理中表現出色。 1)自動化:通過標準庫如os、shutil實現文件備份。 2)腳本編寫:使用psutil庫監控系統資源。 3)任務管理:利用schedule庫調度任務。 Python的易用性和豐富庫支持使其在這些領域中成為首選工具。