Ollama-OCR 使用 Ollama 進行高精度 OCR

Llama 3.2-Vision 是多模態大語言模型,提供 11B 和 90B 尺寸,能夠處理文字和圖像輸入以產生文字輸出。該模型在視覺識別、圖像推理、圖像描述和回答圖像相關問題方面表現出色,在多個行業基準上優於現有的開源和閉源多模態模型。

Llama 3.2-視覺範例

手寫

光學字元辨識 (OCR)

在本文中,我將介紹如何呼叫 Ollama 運行的 Llama 3.2-Vision 11B 建模服務,並使用 Ollama-OCR 實現圖像文字辨識 (OCR) 功能。

Ollama-OCR 的特點

?使用 Llama 3.2-Vision 模型進行高精準度文字辨識

?保留原始文字格式和結構

?️支援多種圖片格式:JPG、JPEG、PNG

⚡️可自訂的識別提示和模型

? Markdown 輸出格式選項

?強大的錯誤處理

安裝奧拉瑪

在開始使用 Llama 3.2-Vision 之前,您需要安裝 Ollama,一個支援本地運行多模態模型的平台。請依照以下步驟安裝:

- 下載Ollama:造訪Ollama官方網站下載適合您作業系統的安裝包。

- 安裝Ollama:依照下載的安裝包依照指示完成安裝。

安裝 Llama 3.2-Vision 11B

安裝 Ollama 後,您可以使用以下指令安裝 Llama 3.2-Vision 11B 模型:

ollama run llama3.2-vision

如何使用 Ollama-OCR

npm install ollama-ocr # or using pnpm pnpm add ollama-ocr

光學字元辨識

代碼

import { ollamaOCR, DEFAULT_OCR_SYSTEM_PROMPT } from "ollama-ocr";

async function runOCR() {

const text = await ollamaOCR({

filePath: "./handwriting.jpg",

systemPrompt: DEFAULT_OCR_SYSTEM_PROMPT,

});

console.log(text);

}

輸入影像:

輸出:

Llama 3.2-Vision 多模態大語言模型 (LLM) 集合是一個經過指令調整的圖像推理生成模型集合,具有 118 和 908 尺寸(文字圖像輸入/文字輸出)。 Llama 3.2-Vision 指令調整模型針對視覺辨識、影像推理、字幕和回答有關影像的一般問題進行了最佳化。這些模型在常見行業基準上優於許多可用的開源和封閉多模式模型。

2. Markdown 輸出

import { ollamaOCR, DEFAULT_MARKDOWN_SYSTEM_PROMPT } from "ollama-ocr";

async function runOCR() {

const text = await ollamaOCR({

filePath: "./trader-joes-receipt.jpg",

systemPrompt: DEFAULT_MARKDOWN_SYSTEM_PROMPT,

});

console.log(text);

}

輸入圖片:

輸出:

ollama-ocr 使用本地視覺模型,如果您想使用線上 Llama 3.2-Vision 模型,請嘗試 llama-ocr 庫。

以上是Ollama-OCR 使用 Ollama 進行高精度 OCR的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

神秘的JavaScript:它的作用以及為什麼重要

Apr 09, 2025 am 12:07 AM

神秘的JavaScript:它的作用以及為什麼重要

Apr 09, 2025 am 12:07 AM

JavaScript是現代Web開發的基石,它的主要功能包括事件驅動編程、動態內容生成和異步編程。 1)事件驅動編程允許網頁根據用戶操作動態變化。 2)動態內容生成使得頁面內容可以根據條件調整。 3)異步編程確保用戶界面不被阻塞。 JavaScript廣泛應用於網頁交互、單頁面應用和服務器端開發,極大地提升了用戶體驗和跨平台開發的靈活性。

JavaScript的演變:當前的趨勢和未來前景

Apr 10, 2025 am 09:33 AM

JavaScript的演變:當前的趨勢和未來前景

Apr 10, 2025 am 09:33 AM

JavaScript的最新趨勢包括TypeScript的崛起、現代框架和庫的流行以及WebAssembly的應用。未來前景涵蓋更強大的類型系統、服務器端JavaScript的發展、人工智能和機器學習的擴展以及物聯網和邊緣計算的潛力。

JavaScript引擎:比較實施

Apr 13, 2025 am 12:05 AM

JavaScript引擎:比較實施

Apr 13, 2025 am 12:05 AM

不同JavaScript引擎在解析和執行JavaScript代碼時,效果會有所不同,因為每個引擎的實現原理和優化策略各有差異。 1.詞法分析:將源碼轉換為詞法單元。 2.語法分析:生成抽象語法樹。 3.優化和編譯:通過JIT編譯器生成機器碼。 4.執行:運行機器碼。 V8引擎通過即時編譯和隱藏類優化,SpiderMonkey使用類型推斷系統,導致在相同代碼上的性能表現不同。

JavaScript:探索網絡語言的多功能性

Apr 11, 2025 am 12:01 AM

JavaScript:探索網絡語言的多功能性

Apr 11, 2025 am 12:01 AM

JavaScript是現代Web開發的核心語言,因其多樣性和靈活性而廣泛應用。 1)前端開發:通過DOM操作和現代框架(如React、Vue.js、Angular)構建動態網頁和單頁面應用。 2)服務器端開發:Node.js利用非阻塞I/O模型處理高並發和實時應用。 3)移動和桌面應用開發:通過ReactNative和Electron實現跨平台開發,提高開發效率。

Python vs. JavaScript:學習曲線和易用性

Apr 16, 2025 am 12:12 AM

Python vs. JavaScript:學習曲線和易用性

Apr 16, 2025 am 12:12 AM

Python更適合初學者,學習曲線平緩,語法簡潔;JavaScript適合前端開發,學習曲線較陡,語法靈活。 1.Python語法直觀,適用於數據科學和後端開發。 2.JavaScript靈活,廣泛用於前端和服務器端編程。

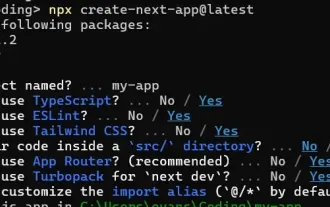

如何使用Next.js(前端集成)構建多租戶SaaS應用程序

Apr 11, 2025 am 08:22 AM

如何使用Next.js(前端集成)構建多租戶SaaS應用程序

Apr 11, 2025 am 08:22 AM

本文展示了與許可證確保的後端的前端集成,並使用Next.js構建功能性Edtech SaaS應用程序。 前端獲取用戶權限以控制UI的可見性並確保API要求遵守角色庫

從C/C到JavaScript:所有工作方式

Apr 14, 2025 am 12:05 AM

從C/C到JavaScript:所有工作方式

Apr 14, 2025 am 12:05 AM

從C/C 轉向JavaScript需要適應動態類型、垃圾回收和異步編程等特點。 1)C/C 是靜態類型語言,需手動管理內存,而JavaScript是動態類型,垃圾回收自動處理。 2)C/C 需編譯成機器碼,JavaScript則為解釋型語言。 3)JavaScript引入閉包、原型鍊和Promise等概念,增強了靈活性和異步編程能力。

如何安裝JavaScript?

Apr 05, 2025 am 12:16 AM

如何安裝JavaScript?

Apr 05, 2025 am 12:16 AM

JavaScript不需要安裝,因為它已內置於現代瀏覽器中。你只需文本編輯器和瀏覽器即可開始使用。 1)在瀏覽器環境中,通過標籤嵌入HTML文件中運行。 2)在Node.js環境中,下載並安裝Node.js後,通過命令行運行JavaScript文件。