人工智慧 (AI) 正在改變產業,Salesforce 的 AgentForce 等自主 AI 代理和 AutoGPT 等開源工具引領潮流。這些代理程式會自動執行複雜的任務,與其他系統合作並提高生產力。然而,隨著它們變得更加自主,負責任的人工智慧開發對於解決偏見、透明度和問責制等問題至關重要。

人工智慧代理的快速採用引發了關於其倫理影響的爭論。雖然它們具有徹底改變醫療保健、教育和銷售等行業的巨大潛力,但如果設計不負責任,它們也會帶來風險。開發者、組織和政府必須共同努力,確保這些系統既創新又符合道德。

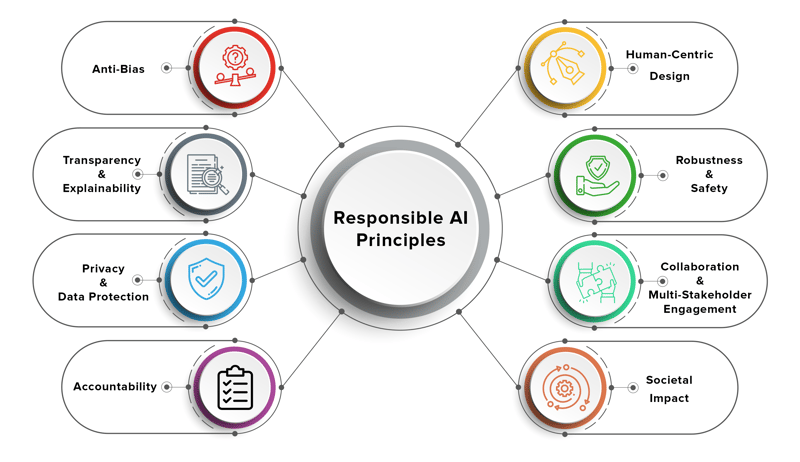

負責任的人工智慧代理被設計為道德、透明和負責的,確保它們符合人類價值觀並最大限度地減少傷害。這些代理人必須公平運作,尊重隱私,並為其決定提供明確的解釋。

建立負責任的人工智慧不僅僅是一項技術挑戰,它是一項多學科的努力,需要開發人員、倫理學家、政策制定者和最終用戶之間的合作。

隨著人工智慧代理變得更加自主,他們面臨道德困境,這對他們的設計和部署提出了挑戰。以下是一些現實世界的例子:

1.決策偏誤

在有偏見的資料集上訓練的人工智慧代理可能會做出歧視性的決定。例如:

2。缺乏透明度

許多人工智慧代理人以「黑盒子」的方式運作,做出難以解釋或解釋的決策。例如:

3。責任差距

當人工智慧代理犯錯時,誰負責?例如:

4。侵犯隱私

人工智慧代理通常需要存取敏感的用戶資料才能有效運作。然而:

5。在銷售和行銷中道德地使用人工智慧

Salesforce 的 AgentForce 等工具正在透過自動化潛在客戶開發和客戶參與來改變銷售和行銷。然而:

這些兩難凸顯了將道德考量納入人工智慧代理的設計和部署的重要性。

為了應對這些挑戰,開發人員和組織可以採用以下框架和最佳實踐:

1。道德人工智慧框架

多個組織已經制定了負責任的人工智慧指南,包括:

2。偏差緩解

3。可解釋性和透明度

4。問責機制

5。隱私與安全

6。持續監控與回饋

建構負責任的人工智慧代理是一項共同的責任,需要多個利害關係人之間的協作:

政府

組織

開發者

Salesforce 是客戶關係管理 (CRM) 領域的領導者,一直處於負責任的 AI 開發的前沿。他們的 AgentForce 平台利用人工智慧代理來自動化銷售流程、提高客戶參與度並推動業務成長。

Salesforce 的與眾不同之處在於其對道德人工智慧的承諾。該公司實施了強有力的指導方針,以確保其人工智慧系統公平、透明和負責任。例如:

透過優先考慮負責任的人工智慧,Salesforce 為其他組織樹立了可以效仿的基準。

隨著人工智慧代理變得更加自主,平衡創新與道德至關重要。透過解決偏見、透明度和問責制等問題,我們可以確保人工智慧代理不僅具有創新性,而且符合道德規範。

建構負責任的人工智慧代理需要開發人員、組織和政府之間的協作努力。透過採用道德框架、減少偏見和確保透明度,我們可以創造造福社會、同時最大限度地減少傷害的人工智慧系統。 Salesforce 的 AgentForce 等工具展示了負責任的人工智慧如何在保持信任和公平的同時推動創新。

人工智慧的未來是光明的,但我們要確保它也是負責任的。

以上是建構負責任的人工智慧代理:平衡創新與道德的詳細內容。更多資訊請關注PHP中文網其他相關文章!