> reft:一種革命性的微調LLMS

> 在斯坦福(Stanford)2024年5月的論文中引入的REFT(表示命名)提供了一種開創性的方法,可有效地微調大型語言模型(LLMS)。 它的潛力立即顯現出來,由Oxen.AI於2024年7月的2024年7月在短短14分鐘內的單個NVIDIA A10 GPU上進行了微調Llama3(8b)。 與現有的參數效率微調(PEFT)方法(如Lora)不同,lora修改模型權重或輸入,REFT利用分佈式互換干預(DII)方法。 DII項目將嵌入較低維的子空間嵌入,從而通過此子空間進行微調。>本文首先回顧了流行的PEFT算法(LORA,提示調整,前綴調整),然後解釋DII,然後再研究REFT及其實驗結果。

>參數有效的微調(PEFT)技術

擁抱臉提供了PEFT技術的全面概述。 讓我們簡要總結關鍵方法:

擁抱臉提供了PEFT技術的全面概述。 讓我們簡要總結關鍵方法:

在2021年推出,洛拉(Lora)的簡單性和概括性使其成為微調LLMS和擴散模型的領先技術。 Lora沒有調整所有層重量,而是增加了低級矩陣,大大降低了可訓練的參數(通常小於0.3%),加速訓練並最大程度地減少GPU內存使用。

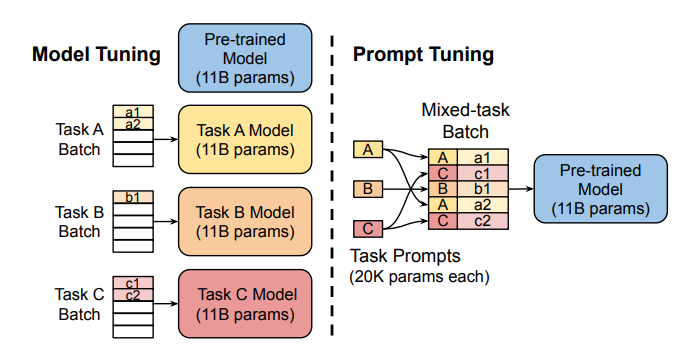

提示調整:

>

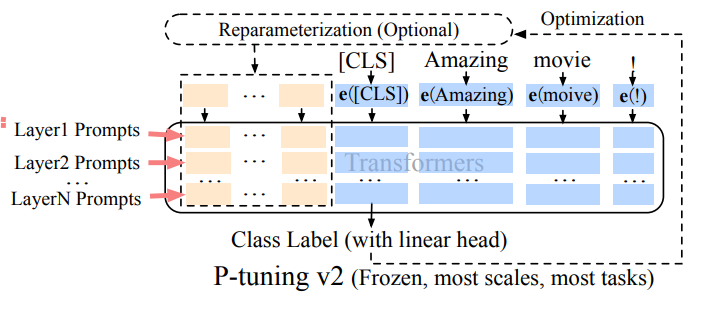

前綴調整(p-tuning v2): 解決迅速調整的限制,前綴調整將可訓練的及時嵌入到各種層中,從而允許在不同級別上進行特定於任務的學習。

解決迅速調整的限制,前綴調整將可訓練的及時嵌入到各種層中,從而允許在不同級別上進行特定於任務的學習。

洛拉的魯棒性和效率使其成為LLMS最廣泛使用的PEFT方法。 可以在 >中找到詳細的經驗比較。

>中找到詳細的經驗比較。

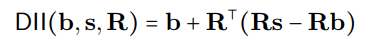

DII植根於因果抽像中,這是一種使用高級(因果)模型和低級(神經網絡)模型之間的干預框架來評估一致性的框架。 DII通過正交預測將這兩個模型投入到子空間中,從而通過旋轉操作創建了介入的模型。 一個詳細的視覺示例>。 DII過程可以用數學表示為: 其中

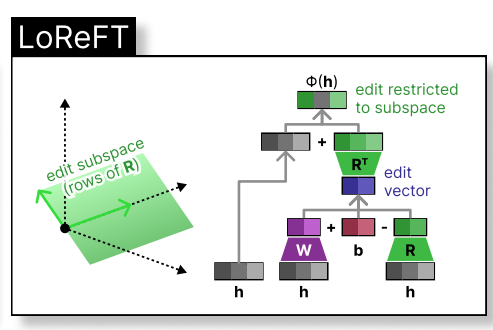

Loreft(低率線性子空間REFT)引入了一個學識淵博的投影來源: 其中 編輯 )。

原始的REFT紙提出了對全面微調(FT),Lora和前綴調整的比較實驗。 REFT技術始終優於現有方法,在達到卓越的性能的同時,將參數降低至少90%。 討論

R代表正交投影,分佈式對齊搜索(DAS)優化了子空間,以最大程度地提高預期後預期的反事實輸出的概率。 > reft - 表示finetuning

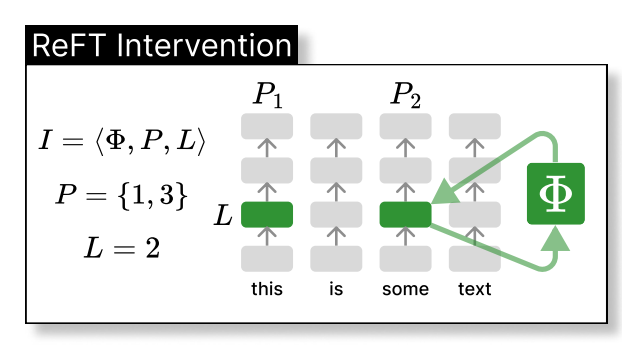

REFT在較低維空間內介入模型的隱藏表示形式。 下圖顯示了應用於L層和位置P的干預措施(PHI)

是隱藏的表示,而在由

是隱藏的表示,而在由h。 Loreft集成到神經網絡層中如下所示:Rs

hR  實驗結果

實驗結果phi={R, W, b}

參考

以上是我們需要的一切嗎?的詳細內容。更多資訊請關注PHP中文網其他相關文章!