現代大語言模型(LLMS)的關鍵特徵(LLMS)

內部文化學習(ICL)允許變形金剛根據輸入提示中的示例進行適應。 使用幾個任務示例,很少有提示有效地證明了所需的行為。 但是,變形金剛如何實現這種適應?本文探討了ICL背後的潛在機制。

ICL的核心是:給定的示例對((x,y)),注意機制可以學習算法以將新查詢(x)映射到其輸出(y)?

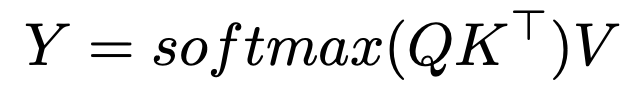

> SoftMax的注意力和最近的鄰居搜索

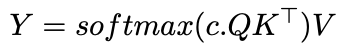

c ,修改了注意力分配:

> c 接近無窮大,注意變成了一個旋轉向量,僅關注最相似的令牌 - 實際上是最近的鄰居搜索。 使用有限的c ,注意與高斯內核平滑相似。 這表明ICL可能會在輸入輸出對上實現最近的鄰居算法。 的含義和進一步的研究

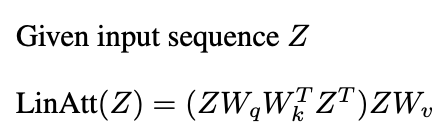

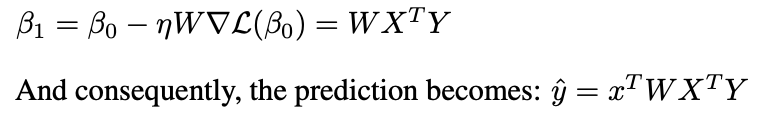

>類似於預處理的梯度下降(PGD):

一層線性注意執行一個PGD步驟。

結論 注意機制可以實現學習算法,通過從演示對學習來啟用ICL。儘管多個注意層和MLP的相互作用很複雜,但研究闡明了ICL的力學。本文提供了這些見解的高級概述。

注意機制可以實現學習算法,通過從演示對學習來啟用ICL。儘管多個注意層和MLP的相互作用很複雜,但研究闡明了ICL的力學。本文提供了這些見解的高級概述。

進一步閱讀:

>本文的靈感來自密歇根大學2024年秋季研究生課程。 任何錯誤都是作者的。

以上是封閉式學習背後的數學的詳細內容。更多資訊請關注PHP中文網其他相關文章!