揭示大語模型(LLMS)背後的魔力:兩部分探索

大型語言模型(LLM)通常看起來很神奇,但它們的內部運作令人驚訝地系統性。這個兩部分的系列揭示了LLM,並將其構建,培訓和精煉解釋為我們今天使用的AI系統。 受Andrej Karpathy的洞察力(和冗長!)YouTube視頻的啟發,該冷凝版以更容易訪問的格式提供了核心概念。強烈建議您使用Karpathy的視頻(僅10天內觀看800,000次!),但此10分鐘的讀取蒸發是最初1.5小時的關鍵要點。>

第1部分:從原始數據到基本模型> LLM發育涉及兩個關鍵階段:訓練前和訓練後。

1。預訓練:教語言> 在生成文本之前,LLM必須學習語言結構。這個計算密集的預訓練過程涉及多個步驟:

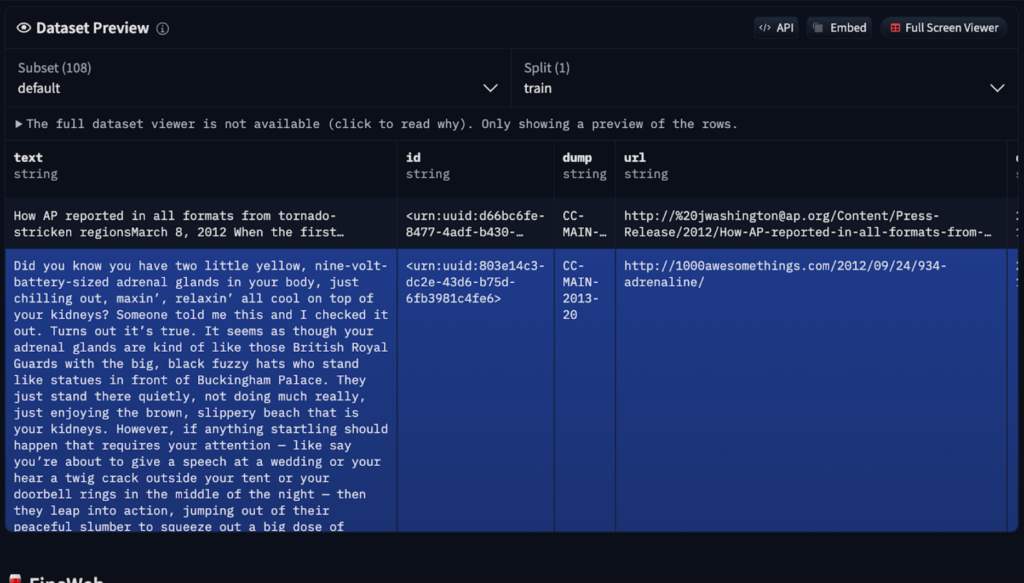

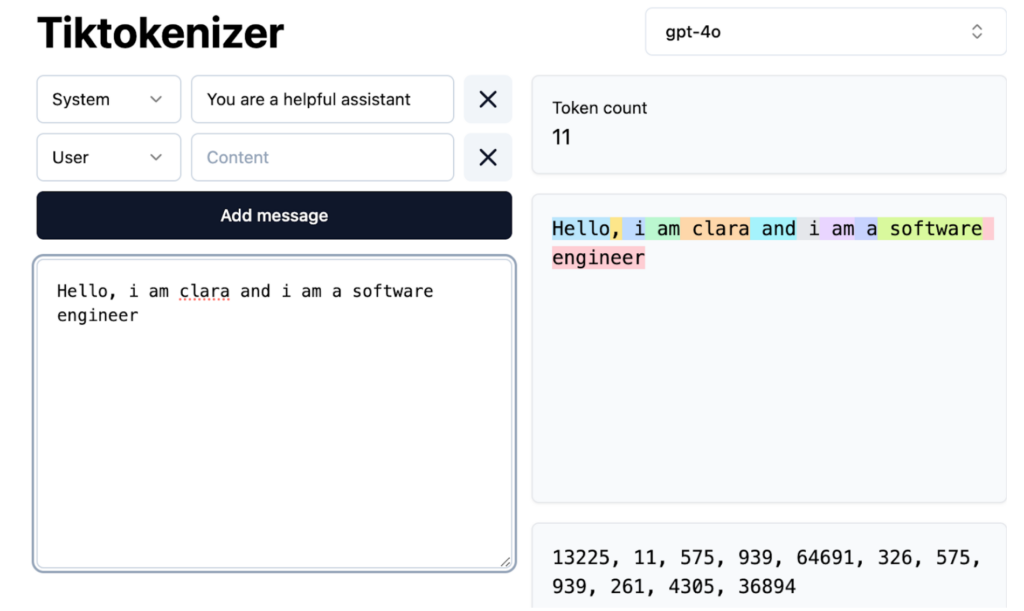

數據採集和預處理:

> 神經網絡培訓:

神經網絡培訓:

2。訓練後:用於實際用途的精煉通過使用較小的專業數據集進行培訓,可以完善基礎模型。 這不是明確的編程,而是通過結構化的示例進行隱式指令。

>

訓練後方法包括:

在任何階段執行的推論,評估模型學習。 該模型將概率分配給潛在的代幣和此分佈的樣本,從而在培訓數據中明確地創建文本,但在統計學上與之一致。此隨機過程允許從同一輸入中產生各種輸出。 >

>幻覺:解決虛假信息

> LLMS產生虛假信息的幻覺源於其概率性質。 他們不“知道”事實,而是預測可能的單詞序列。 緩解策略包括:

“我不知道”培訓:

>本部分探索了LLM開發的基本方面。第2部分將深入研究並檢查尖端模型。 歡迎您的問題和建議!

以上是LLM的工作方式:培訓前訓練,神經網絡,幻覺和推理的詳細內容。更多資訊請關注PHP中文網其他相關文章!