DeepSeek:深入研究LLMS的加強學習

DeepSeek最近的成功,以較低的成本取得了令人印象深刻的表現,突出了大語言模型(LLM)培訓方法的重要性。本文重點介紹了增強學習(RL)方面,探索TRPO,PPO和更新的GRPO算法。 假設對機器學習,深度學習和LLM的基本熟悉,我們將最大程度地減少複雜數學以使其可訪問。

>

> LLM培訓的三個支柱

LLM培訓通常涉及三個關鍵階段:

>

預訓練:

>該模型學會了使用大量數據集從先前的代幣中以序列進行序列預測下一個令牌。

- 監督的微調(SFT):

- 強化學習(RLHF):在本階段,本文的重點,進一步完善了通過直接反饋對更好的人類偏好的反應。

強化學習基礎-

強化學習涉及

代理

與

環境 的交互。代理存在於特定的

的交互。代理存在於特定的

狀態

中,採取>動作>過渡到新狀態。每個動作都會從環境中產生A獎勵,從而指導代理人的未來行動。 想想一個機器人在迷宮中瀏覽:其位置是國家,運動是行動,到達出口提供了積極的獎勵。

LLMS中的rl:詳細的外觀

在LLM培訓中,組件是:

-

代理: llm本身。 >

>- >環境:外部因素,例如用戶提示,反饋系統和上下文信息。

- 動作:令牌llm對查詢的響應生成。

- state:當前查詢和生成的令牌(部分響應)。

獎勵:- >通常由對人類通知數據訓練的單獨獎勵模型確定,對分配得分的響應進行排名。更高質量的回應獲得了更高的獎勵。 在特定情況下,例如DeepSeekmath。

策略

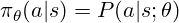

確定要採取的行動。 對於LLM,這是對可能令牌的概率分佈,用於採樣接下來的令牌。 RL培訓可以調整策略的參數(型號權重),以偏愛更高的代幣。 該策略通常表示為:

RL的核心是找到最佳策略。 與監督的學習不同,我們使用獎勵來指導政策調整。

> trpo(信任區域策略優化)

> trpo(信任區域策略優化)

trpo使用優勢函數,類似於監督學習中的損失函數,但從獎勵中得出:

> ppo(近端策略優化)

現在,對於Chatgpt和Gemini等LLM而言,PPO PPO,通過使用剪裁的替代目標來簡化TRPO,隱含地限制了策略更新並提高了計算效率。 PPO目標函數是:

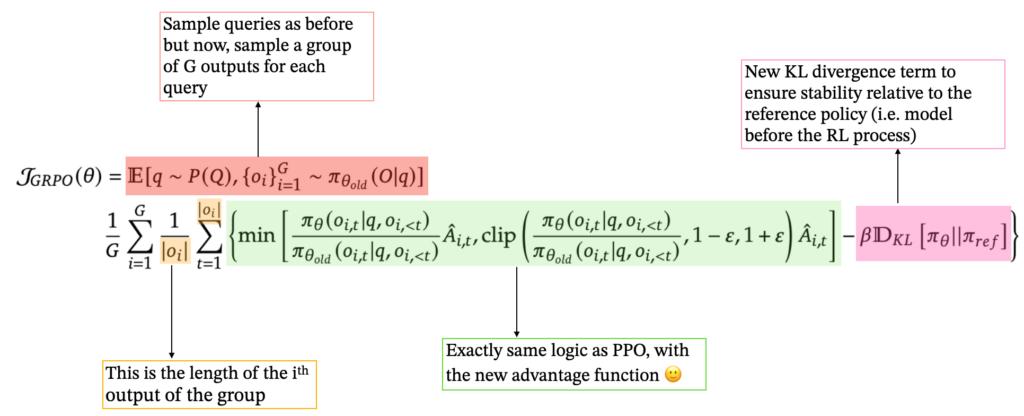

grpo(組相對策略優化)

通過消除單獨的值模型來簡化 grpo的訓練。對於每個查詢,它都會生成一組響應,並根據其獎勵計算優勢作為z評分:

>這簡化了過程,非常適合LLMS生成多個響應的能力。 GRPO還包含了KL Divergence術語,將當前策略與參考策略進行了比較。最終的GRPO公式是:

結論

增強學習,尤其是PPO和較新的GRPO,對於現代LLM培訓至關重要。 每種方法都基於RL基本面,提供不同的方法,以平衡穩定性,效率和人類對齊方式。 DeepSeek的成功利用了這些進步以及其他創新。 強化學習有望在促進LLM功能方面發揮越來越重要的作用。

>參考:(參考文獻保持不變,只是重新格式化以獲得更好的可讀性)

- [1]“大語言模型的基礎”,2025。 [2]“加固學習”。 enaris。可在以下位置獲得: https://www.php.cn/link/20E169B48C8F86987E2BBE1C5C3EA65

- >

[3] Y. Gokhale。 “ LLMS和生成AI第5部分:RLHF的簡介,”中

,2023。

- [4] L. Weng。 “強化學習概述”,2018年。網址:[5]“ deepSeek-r1:通過加固學習激勵LLM中的推理能力”,2025。 https://www.php.cn/link/link/d0ae1e3078888807c855d78d78d78d64f4d64f4d64f4dd64f4ded55cd5cd5cd5cd5cd5cd5cd5cb [6]“ deepSeekmath:開放語言模型中的數學推理的限制”,2025。 https://www.php.cn/link/link/link/f8b18593cdbb1ce289330330560a4444e33aaaa

[7]“信任區域策略優化”,2017年。

-

以上是培訓大語言模型:從TRPO到GRPO的詳細內容。更多資訊請關注PHP中文網其他相關文章!

的交互。代理存在於特定的

的交互。代理存在於特定的 > trpo(信任區域策略優化)

> trpo(信任區域策略優化)