>本教程展示了精神健康情感分析的Llama 3.1-8B-IT模型。 我們將自定義模型以預測文本數據中的患者心理健康狀況,將適配器與基本模型合併,並在擁抱面樞紐中部署完整的模型。 至關重要的是,請記住,在醫療保健中使用AI時,道德考慮是至關重要的。此示例僅用於說明目的。 >我們將使用Kaggle,使用Transformers庫進行推理以及微調過程本身來介紹訪問Llama 3.1型號。 先前對LLM微調的理解(請參閱我們的“微調LLMS介紹性指南”)是有益的。

>由作者

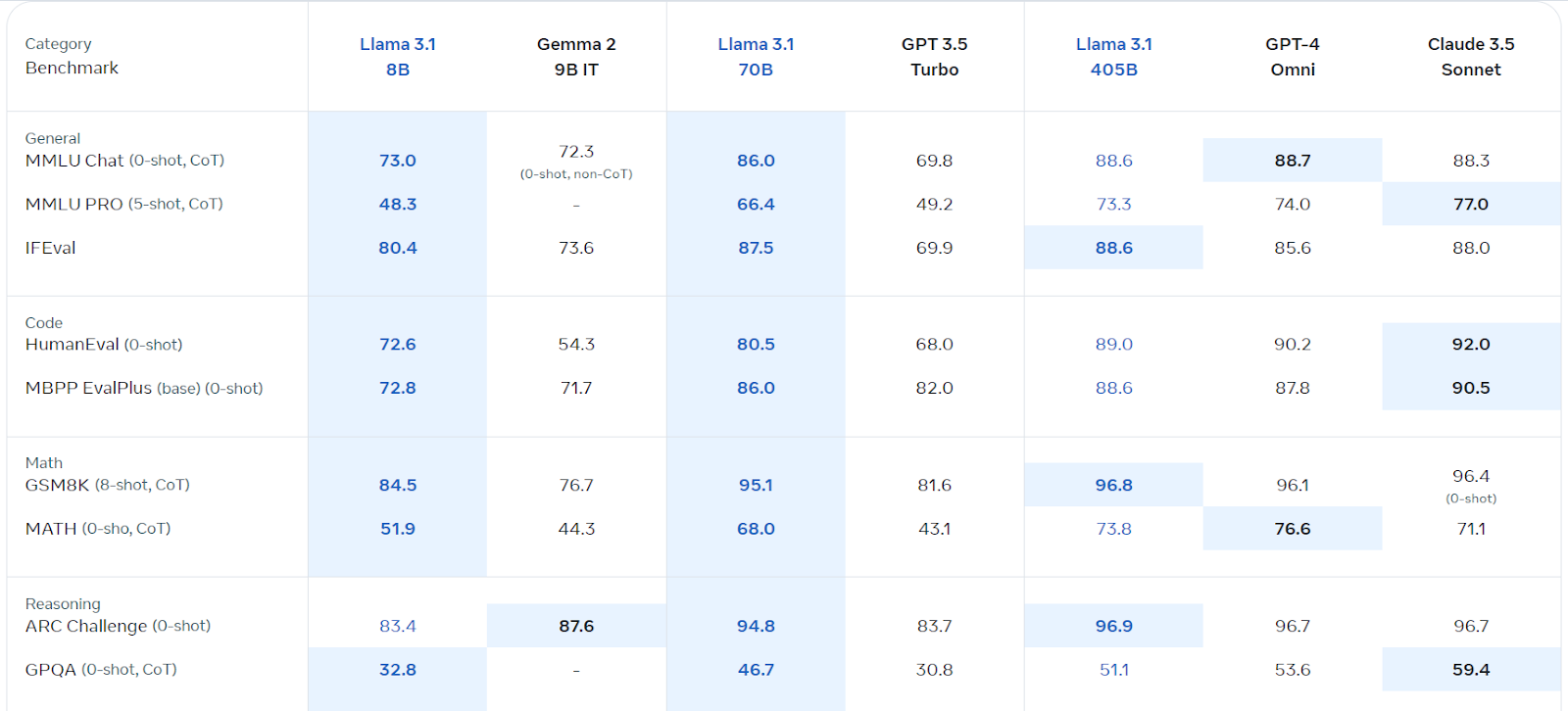

理解Llama 3.1

來源:Llama 3.1(Meta.com)

>

我們將利用Kaggle的免費GPU/TPU。 請按照以下步驟:

>在meta.com上註冊(使用您的kaggle電子郵件)。>

>訪問Llama 3.1 Kaggle存儲庫和請求模型訪問。

安裝必要的軟件包(

)。%pip install -U transformers accelerate

from transformers import AutoTokenizer, AutoModelForCausalLM, pipeline

import torch

base_model = "/kaggle/input/llama-3.1/transformers/8b-instruct/1"

tokenizer = AutoTokenizer.from_pretrained(base_model)

model = AutoModelForCausalLM.from_pretrained(base_model, return_dict=True, low_cpu_mem_usage=True, torch_dtype=torch.float16, device_map="auto", trust_remote_code=True)

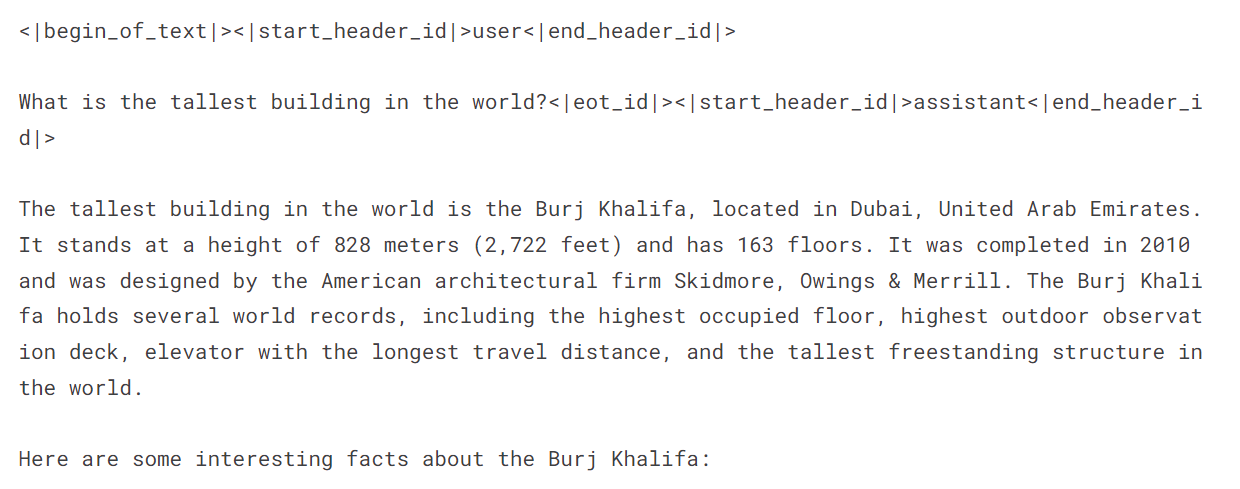

pipe = pipeline("text-generation", model=model, tokenizer=tokenizer, torch_dtype=torch.float16, device_map="auto")messages = [{"role": "user", "content": "What is the tallest building in the world?"}]

prompt = tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True)

outputs = pipe(prompt, max_new_tokens=120, do_sample=True)

print(outputs[0]["generated_text"])>使用Llama 3.1啟動新的Kaggle筆記本,安裝必需的軟件包( ,

,

,,,

,數據處理:加載數據集,清潔它(刪除模棱兩可的類別:“自殺”,“壓力”,“人格障礙”),洗牌並分成培訓,評估和測試集(使用3000個樣本提高效率)。 創建提示併入語句和標籤。

>模型加載:使用4位量化的記憶效率,加載Llama-3.1-8b-Insruct模型。加載令牌器並設置墊子令牌ID。

>>預先調整評估:創建功能以預測標籤和評估模型性能(準確性,分類報告,混淆矩陣)。 在微調之前評估模型的基線性能。

微調:使用適當的參數配置lora。設置培訓論點(根據您的環境根據需要進行調整)。使用SFTTrainer訓練模型。使用權重和偏見監控進度。

> 在調查後評估:

在微調後重新評估模型的性能。

合併並保存:PeftModel.from_pretrained()在新的kaggle筆記本中,使用model.merge_and_unload()和

/kaggle/input/...記住將佔位符(如

以上是微調駱駝3.1用於文本分類的詳細內容。更多資訊請關注PHP中文網其他相關文章!