Kimi K1.5與OpenAi O1:哪個更好的推理模型?

OpenAI是第一個引入O1和O1-Mini等推理模型的人,但這是遊戲中唯一的玩家嗎?不遠射! DeepSeek,Qwen和現在的Kimi等中國LLM正在加緊挑戰OpenAI,以更實惠的價格提供類似的能力。在DeepSeek令人印象深刻的首次亮相之後,Kimi Ai的新型Kimi K1.5型號輪到了。在本文中,我們將在同一任務上測試Kimi K1.5針對Openai O1,並查看哪個更好!

>

>目錄的表- >什麼是kimi k1.5? Web搜索

- 任務5:圖像分析

- 最終結果:kimi k1.5 vs openai o1

- 結論

- 請注意: 請注意:Kimi K1.5是免費的,同時訪問O1和O1-Mini的Chatgpt Plus的費用為20美元。在研究任務之前,讓我們比較兩種型號。

- > 什麼是kimi k1.5?

- Kimi K1.5是Moonshot AI的多模式LLM,接受了增強學習(RL)的訓練,旨在在文本,視覺和編碼的各種推理任務中表現出色。 Kimi K1.5最近推出,由於其令人印象深刻的性能而迅速引起了人們的關注,與OpenAI的O1型號的功能相匹配而沒有預覽或迷你後綴。 >

- 鍵功能

- >無限用法完全免費

>可輕鬆分析多達50個文件(PDF,DOC,PPTS,圖像) 高級COT推理,無需提供

增強的圖像理解,超越基本文本提取

也閱讀:

- openai o1:OpenAI的新型號系列

- o1-mini:一種改變遊戲的詞乾和推理模型

- >

- kimi k1.5 vs Openai O1和O1-Mini

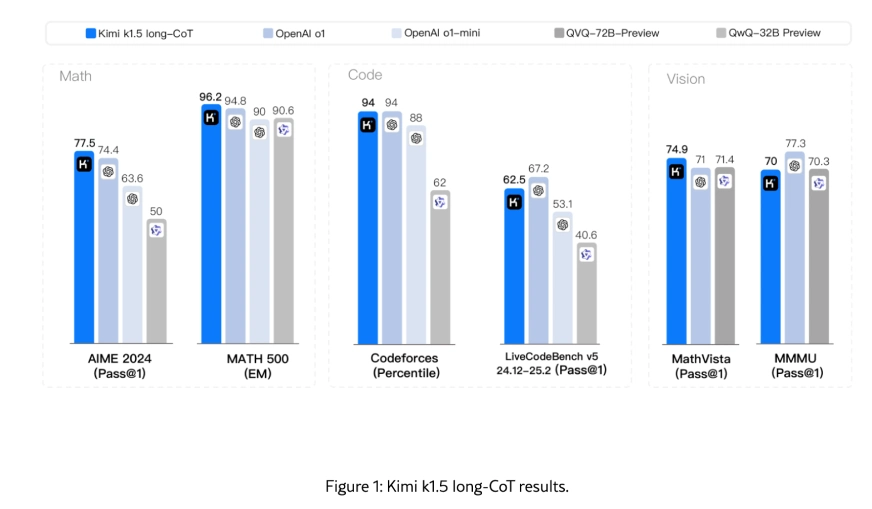

- Kimi K1.5在長期任務中匹配OpenAI的O1和O1-Mini,並且在短件任務中優於GPT-4O和Claude Sonnet 3.5。它的多模式功能,尤其是在視覺推理中,它將其作為OpenAI模型的強大競爭對手。 RL培訓技術,多模式數據配方和基礎設施優化的使用在實現這些結果方面一直是關鍵的。

k1.5長期模型:推進多模式推理

>kimi k1.5長距離模型通過長篇小說縮放,改進的策略優化方法和視覺文本增強學習(RL)的結合來實現最新的(SOTA)性能。與傳統的語言模型預處理不同,該模型依賴於下一步的預測,並且受到可用培訓數據的限制,Kimi K1.5利用RL通過學習獎勵來探索探索的培訓數據來擴展其培訓數據。這種方法建立了一個簡單而有效的RL框架,避免了諸如蒙特卡洛樹搜索或價值功能之類的複雜技術。  鍵基準強調了該模型的出色性能:

鍵基準強調了該模型的出色性能:- >數學推理

- :Math-500上的96.2和Aime 2024上的77.5分數,與OpenAI的O1和O1-Mini型號匹配。 編程

- :代碼方面的第94個百分位數,在競爭性編程方面表現出色。 視覺推理

- :74.9在Mathvista上,展示了強大的多模式集成。 >該模型處理長篇小說任務(例如計劃,反思和校正)的能力通過培訓期間的部分推出,提高效率和性能。

使用有效的long2short方法將長密碼模型的成功構建在長密度模型的成功基礎上,以將長密度技術提煉成更有效的框架。這種方法結合了微調,增強學習和遠程蒸餾,為短篇小說任務提供了快速而準確的推理。值得注意的成就包括:

數學推理

- :在數學500上的94.6和Aime 2024上的60.8得分,表現優於現有的短型型號,例如GPT-4O和Claude Sonnet 3.5,最高可達550%。

- 編程:47.3在LiveCodeBench上,在代碼生成和調試任務方面出色。

- 自然語言理解:對諸如聊天機器人和虛擬助手等實時應用程序有效。 >

- >遠程蒸餾技術,包括模型合併和最短拒絕採樣,確保通過降低的計算成本來確保高性能,從而使短點模型高效。 要知道更多您可以在這裡結帳他們的研究論文! >

任務1:斑馬拼圖

提示:>正確求解了這個斑馬拼圖。openai O1響應:

收集器詳細信息 Collector Position Nationality Lot Amount Spent Shirt Color Collector #1 Portuguese Toy Unknown Blue Collector #2 Japanese Lot 40 0,000 Purple Collector #3 Italian Lot 30 0,000 Pink Collector #4 Canadian Unknown 0,000 Yellow Collector #5 Unknown Unknown 0,000 Unknown

kimi k1.5響應:

收集器詳細信息 Collector # Nationality Lot Item Amount Shirt Color 1 Italian 30 Clock 0,000 Blue 2 Japanese 40 Painting 0,000 Purple 3 Canadian 10 Vase 0,000 Pink 4 Portuguese 34 Toy 0,000 Yellow 5 (Unknown)

觀察:

Openai O1提供的響應明顯不准確。結果表不符合問題中指定的所需格式,從而使回答不可靠。另一方面,Kimi K1.5根據問題提供了正確格式的響應,但答案本身的內容不正確。

>>判決:

>openai o1:❌| Kimi K1.5:❌

>任務2:邏輯推理

> 提示:

>您走進房間看床。在床上有兩隻狗,四隻貓,一隻長頸鹿,五頭牛和一隻鴨子。還有三把椅子和一張桌子。地板上有幾條腿? openai O1響應: kimi k1.5響應:

觀察:

正確答案:

> 22(2(人)4(表)4(bed)4(bed)12(3張椅子))

openai O1花費了太長時間來產生響應。雖然計算正確並包括一個詳細的解釋,但它未能說明地板上的人腿,這使得其答案不正確。相比之下,Kimi K1.5在更少的時間內提供了正確的答案。 >

>判決:>openai o1:❌| Kimi K1.5:✅ >任務3:創建一個HTML站點

>

提示:>創建一個簡單的html頁面,其中使用一個按鈕將背景顏色更改為粉紅色時,用一些五彩紙屑將其更改為粉紅色。 openai O1響應:

kimi k1.5響應:

觀察:

> >判決:>openai o1:❌| Kimi K1.5:✅ >任務4:Web搜索

提示:>閱讀文章 - https://www.analyticsvidhya.com/blog/2024/07/building-agentic-agentic-rag-systems-with-langgraph/,以了解構建wikipedia數據的矢量數據庫的過程。以簡潔的方式匯總關鍵步驟。openai O1響應: >構建wikipedia數據的矢量數據庫的過程:

- >收集數據:從轉儲或API中獲取Wikipedia文章。 >

- >>預處理文本:清潔文本並將其分成較小的連貫的“塊”。

- 選擇一個嵌入模型:使用語言模型(例如OpenAI嵌入)將文本塊轉換為數值向量。 生成嵌入

- :對於每個塊,產生其語義向量表示。 設置矢量數據庫 :選擇一個矢量存儲(例如Pinecone,Weaviate,Faiss,Chroma)以存儲和索引嵌入。

- > >插入向量 :將所有塊向量和關聯的元數據(例如,原始文章參考)加載到數據庫中。

- 測試檢索:與矢量化問題查詢數據庫,以確保返回相關的wikipedia塊。 >

- 優化並集成:將索引和集成與檢索效果生成(RAG)管道進行有效,準確的信息檢索。

- kimi k1.5響應: >“具有Langgraph的構建代理抹布系統的綜合指南”文章概述了為Wikipedia數據構建向量數據庫的過程,這是創建代理抹布系統的一部分。這是總結的關鍵步驟:

- 安裝依賴項:安裝必要的庫,例如Langchain,Langchain-Openai,Langchain-Community,Langgraph和Langchain-Chroma。 >

- 輸入API鍵:使用GetPass函數安全地輸入OpenAI和Tavily搜索的API鍵,以避免在代碼中公開它們。 設置環境變量

- :設置OpenAI和Tavily搜索API鍵的環境變量。 > >加載wikipedia data

- :

>從提供的Google Drive鏈接下載Wikipedia數據或使用本地存檔文件。

> - >提取並將數據加載到文檔列表中。

:

-

使用文本分離器將文檔分為較小,可管理的塊。

>本文使用遞歸的術語textsplitter將文檔分為大約2000個字符的塊,重疊為300個字符。

- >

- 創建矢量數據庫

- >初始化一個色度矢量數據庫客戶端。

>使用OpenAI的嵌入模型(Text-Embedding-3-Small)將文檔塊轉換為嵌入。

- >

- >將文檔塊及其嵌入在矢量數據庫索引中,將餘弦相似性指定為距離函數。

- 設置向量數據庫回收

- >配置獵犬以基於餘弦相似性獲取前3個最相似的文檔。

設置一個相似性閾值(例如,0.3),以過濾與查詢不夠相似的文檔。

- >

- 測試獵犬

- >用示例查詢測試獵犬,以確保其返回相關文檔。 >

對於vector數據庫中沒有相關文檔的查詢,檢索器應返回一個空列表。

- 觀察:

- 為了估算太空中數據中心所需的散熱器表面積的下限,我首先應用Stefan-Boltzmann定律,該法描述了表面輻射的功率:

> >判決:

>

openai o1:❌| Kimi K1.5:✅任務5:圖像分析

提示:

>圖像顯示了空間中數據中心的高度簡化示意圖,其中一些簡化的假設需要合理。

>任務:>估計數據中心所需的散熱器表面積的下限。

2。僅輻射傳熱:

地址。

地址如何在熱管理的背景下處理太陽和深空。 >輸入圖像:

openai O1響應:

下面的是一個逐步推理過程,具有明確規定的簡化假設,理由和熱力學第一定律的應用。最終結果將是在散熱器區域的下限,以消散由空間數據中心產生的1 gW的熱量。

關鍵假設和簡化1。功率輸入和熱量產生:

假設數據中心由1 GW太陽能電源提供動力。 GPU消耗的幾乎所有電力都將轉換為熱量(在穩態下電能轉換本質上是100%,因為所有未存儲的電能最終都必須隨熱量消散)。因此,要去除的廢熱約為1 gW = 1×10^9 W.> 在太空中,沒有對環境的對流或導電冷卻,只有輻射傳熱。因此,熱排斥的主要模式是從散熱器表面進入深空的熱輻射。

3。發射率和吸收性:

假設散熱器是用高發射率構造的,例如ε= 0.9

ε = 0.9。這對於塗有某些高發射率的油漆或材料的表面是合理的。對於所需區域的下限,我們假設理想的條件:散熱器主要遠離太陽,以最大程度地減少太陽能吸收。

- kimi k1.5響應:

為了處理熱管理中的太陽和深空,應使用陽光遮擋數據中心,或放在不暴露於陽光下的位置,例如行星或月球的陰暗面。必須設計散熱器以有效地輻射熱量進入空間的真空,這是非常冷的。 通過確保數據中心設備產生的熱量等於散熱器輻射的熱量,熱力學的第一定律適用於這種情況。該法律確保系統中的總能量保持恆定,並在散熱器的設計中充分考慮了熱量。>所需散熱器表面積的下限大約為

766平方米。數據中心應避免陽光直射,並應優化散熱器,以在空間真空中進行散熱以維持熱平衡。

觀察:

Kimi K1.5的響應是出色的,原因有幾個。從基本的Stefan-Boltzmann法律方程開始,它通過分步方法來證明明確的數學推理。 Kimi清楚地定義了所有變量及其值,顯示了解決散熱器區域的數學過程,並提供了766平方米的具體數值結果。該解釋包括有關熱管理策略的明確理由,例如將散熱器定位在地球的陰暗面,以及與現實世界應用的第一定律的直接聯繫。響應以特定數字和可行的建議結束。

> 相比之下,Openai O1的響應仍然更加理論上,重點是一般假設和設置,而不是完成實際計算。它缺乏具體的數值解決方案,並且沒有完全解決熱管理方面,與Kimi K1.5的詳細和以解決方案為導向的方法相比,它的實用性和行動性不佳。>判決:

openai o1:❌| Kimi K1.5:✅

最終結果:kimi k1.5 vs Openai O1

>任務結果

也請閱讀:Kimi K1.5 vs DeepSeek R1:最好的中國LLMS戰役Task Winner Zebra Puzzle Neither Logical Reasoning Kimi k1.5 Create an HTML Site Kimi k1.5 Web Search Kimi k1.5 Image Analysis Kimi k1.5 結論

諸如Kimi K1.5和DeepSeek R1之類的免費模型正在挑戰Openai O1的主導地位,無需免費提供推理,編碼和多模式任務的卓越性能。隨著Kimi K1.5在關鍵基準和DeepSeek R1方面的表現優於OpenAi,在編碼挑戰方面脫穎而出,為Openai O1支付20美元/月是否仍然是合理的?在下面的評論部分中讓我們知道!

>敬請期待分析vidhya博客,以獲取更多如此出色的內容!

以上是Kimi K1.5與OpenAi O1:哪個更好的推理模型?的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

開始使用Meta Llama 3.2 -Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

開始使用Meta Llama 3.2 -Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

Meta的Llama 3.2:多模式和移動AI的飛躍 Meta最近公佈了Llama 3.2,這是AI的重大進步,具有強大的視覺功能和針對移動設備優化的輕量級文本模型。 以成功為基礎

10個生成AI編碼擴展,在VS代碼中,您必須探索

Apr 13, 2025 am 01:14 AM

10個生成AI編碼擴展,在VS代碼中,您必須探索

Apr 13, 2025 am 01:14 AM

嘿,編碼忍者!您當天計劃哪些與編碼有關的任務?在您進一步研究此博客之前,我希望您考慮所有與編碼相關的困境,這是將其列出的。 完畢? - 讓&#8217

向員工出售AI策略:Shopify首席執行官的宣言

Apr 10, 2025 am 11:19 AM

向員工出售AI策略:Shopify首席執行官的宣言

Apr 10, 2025 am 11:19 AM

Shopify首席執行官TobiLütke最近的備忘錄大膽地宣布AI對每位員工的基本期望是公司內部的重大文化轉變。 這不是短暫的趨勢。這是整合到P中的新操作範式

AV字節:Meta' llama 3.2,Google的雙子座1.5等

Apr 11, 2025 pm 12:01 PM

AV字節:Meta' llama 3.2,Google的雙子座1.5等

Apr 11, 2025 pm 12:01 PM

本週的AI景觀:進步,道德考慮和監管辯論的旋風。 OpenAI,Google,Meta和Microsoft等主要參與者已經釋放了一系列更新,從開創性的新車型到LE的關鍵轉變

GPT-4O vs OpenAI O1:新的Openai模型值得炒作嗎?

Apr 13, 2025 am 10:18 AM

GPT-4O vs OpenAI O1:新的Openai模型值得炒作嗎?

Apr 13, 2025 am 10:18 AM

介紹 Openai已根據備受期待的“草莓”建築發布了其新模型。這種稱為O1的創新模型增強了推理能力,使其可以通過問題進行思考

視覺語言模型(VLMS)的綜合指南

Apr 12, 2025 am 11:58 AM

視覺語言模型(VLMS)的綜合指南

Apr 12, 2025 am 11:58 AM

介紹 想像一下,穿過美術館,周圍是生動的繪畫和雕塑。現在,如果您可以向每一部分提出一個問題並獲得有意義的答案,該怎麼辦?您可能會問:“您在講什麼故事?

如何在SQL中添加列? - 分析Vidhya

Apr 17, 2025 am 11:43 AM

如何在SQL中添加列? - 分析Vidhya

Apr 17, 2025 am 11:43 AM

SQL的Alter表語句:動態地將列添加到數據庫 在數據管理中,SQL的適應性至關重要。 需要即時調整數據庫結構嗎? Alter表語句是您的解決方案。本指南的詳細信息添加了Colu

閱讀AI索引2025:AI是您的朋友,敵人還是副駕駛?

Apr 11, 2025 pm 12:13 PM

閱讀AI索引2025:AI是您的朋友,敵人還是副駕駛?

Apr 11, 2025 pm 12:13 PM

斯坦福大學以人為本人工智能研究所發布的《2025年人工智能指數報告》對正在進行的人工智能革命進行了很好的概述。讓我們用四個簡單的概念來解讀它:認知(了解正在發生的事情)、欣賞(看到好處)、接納(面對挑戰)和責任(弄清我們的責任)。 認知:人工智能無處不在,並且發展迅速 我們需要敏銳地意識到人工智能發展和傳播的速度有多快。人工智能係統正在不斷改進,在數學和復雜思維測試中取得了優異的成績,而就在一年前,它們還在這些測試中慘敗。想像一下,人工智能解決複雜的編碼問題或研究生水平的科學問題——自2023年

鍵基準強調了該模型的出色性能:

鍵基準強調了該模型的出色性能: