雪板:使用雪花

的數據庫機器學習傳統的機器學習通常涉及將大量數據集從數據庫中移動到模型培訓環境。 當今的大型數據集越來越效率。 Snowflake Snowpark通過啟用數據庫處理來解決此問題。 Snowpark直接在Snowflake的雲中提供了庫和運行時間,以執行代碼(Python,Java,Scala),從而最大程度地減少數據移動並增強安全性。

>為什麼選擇Snowpark?

Snowpark提供了幾個關鍵優勢:

入門:逐步指南

該教程展示了使用Snowpark構建超參數調整的模型。

>虛擬環境設置:創建一個conda環境並安裝必要的庫(>,snowflake-snowpark-python,pandas,pyarrow,numpy,matplotlib,seaborn,ipykernel,

數據攝入:導入樣本數據(例如,海底鑽石數據集)進入雪花表。 (注意:在現實世界中,您通常會使用現有的雪花數據庫。)

> Snekark Session創建:config.py>使用您的憑據(帳戶名,用戶名,密碼)建立與雪花的連接,將其牢固存儲在.gitignore> file(添加到

>數據加載:

使用Snowpark會話訪問並將數據加載到Snowpark DataFrame中。了解Snowpark DataFrames

Snowpark DataFrames懶惰地操作,在將操作轉換為優化的SQL查詢之前,建立了邏輯的操作表示。這與熊貓的渴望執行形成鮮明對比,尤其是在大型數據集的情況下提供了可觀的性能增長。

何時使用Snowpark DataFrames:

to_pandas()>使用Snowpark DataFrames作為大型數據集,其中將數據傳輸到本地機器是不切實際的。 對於較小的數據集,熊貓可能就足夠了。 該方法允許在Snekpark和Pandas DataFrames之間進行轉換。 該方法提供了直接執行SQL查詢的替代方法。

Session.sql() Snowpark DataFrame轉換功能:

Snowpark的轉換功能(從F中導入為snowflake.snowpark.functions)為數據操作提供了強大的接口。 這些函數與.select(),.filter()和.with_column()方法一起使用。

>探索性數據分析(EDA):

可以通過從Snowpark DataFrame,將其轉換為Pandas DataFrame,並使用Matplotlib和Seaborn等可視化庫來進行EDA進行EDA。 另外,SQL查詢可以生成可視化的數據。>

機器學習模型培訓:

數據清潔:確保數據類型正確並處理任何預處理需求(例如,重命名列,鑄造數據類型,清潔文本功能)。 >

>預處理:>將雪花ML的與Pipeline和OrdinalEncoder一起使用。 使用StandardScaler。 joblib保存管道

模型培訓:使用預處理數據訓練XGBoost模型(XGBRegressor

random_split()

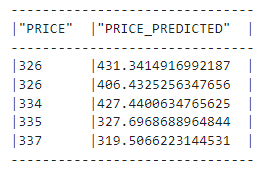

)等指標評估模型。

mean_squared_error

snowflake.ml.modeling.metrics

來優化模型超參數。

RandomizedSearchCV

類。

Registry

結論:

> Snowpark提供了一種強大而有效的方法來執行數據庫內的機器學習。 它的懶惰評估,與熟悉的庫集成以及模型註冊表使其成為處理大型數據集的寶貴工具。 請記住,請諮詢Snowpark API和ML開發人員指南以獲取更高級的功能。

注意:圖像URL從輸入中保存。 調整格式以獲得更好的可讀性和流動性。 保留了技術細節,但是該語言使更廣泛的受眾更加簡潔和訪問。

>以上是雪花雪板:全面的介紹的詳細內容。更多資訊請關注PHP中文網其他相關文章!