經常性神經網絡(RNNS)是一種強大的人工神經網絡(ANN)類型,用於蘋果Siri和Google的語音搜索。它們通過內部記憶保留過去輸入的獨特能力使它們非常適合諸如股票價格預測,文本生成,轉錄和機器翻譯等任務。與輸入和輸出是獨立的傳統神經網絡不同,RNN輸出取決於序列中的先前元素。此外,rnns跨網絡層共享參數,優化梯度下降期間的重量和偏差調整。

上圖說明了基本的RNN。在股票價格預測方案中,使用[45、56、45、49、50,...]之類的數據,每個輸入(x0至XT)都包含了過去的值。例如,x0為45,x1為56,這些值有助於預測下一個序列元素。

,通過循環進行信息週期,使輸出均與當前和上一個輸入的函數。 src =“ https://img.php.cn/upload/article/000/000/000/174165793768541.jpg” alt =“ recurrent recurrent neural網絡教程(rnn)”/> > > > > >

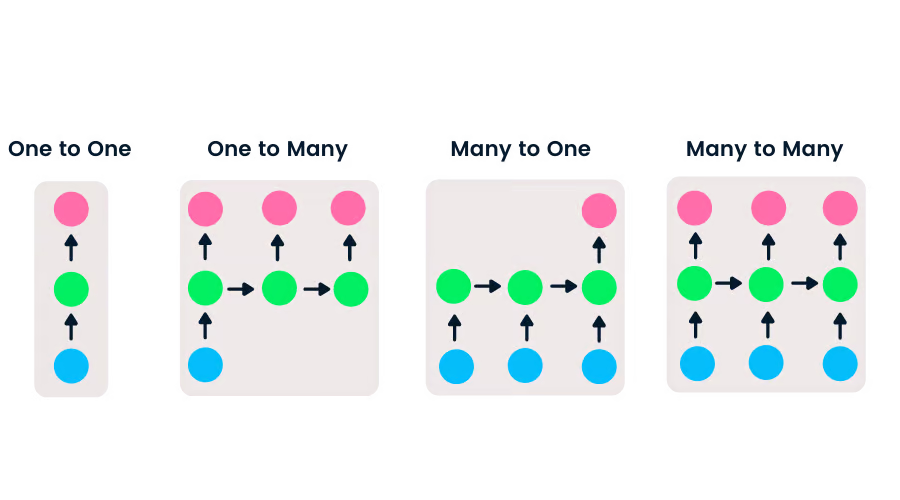

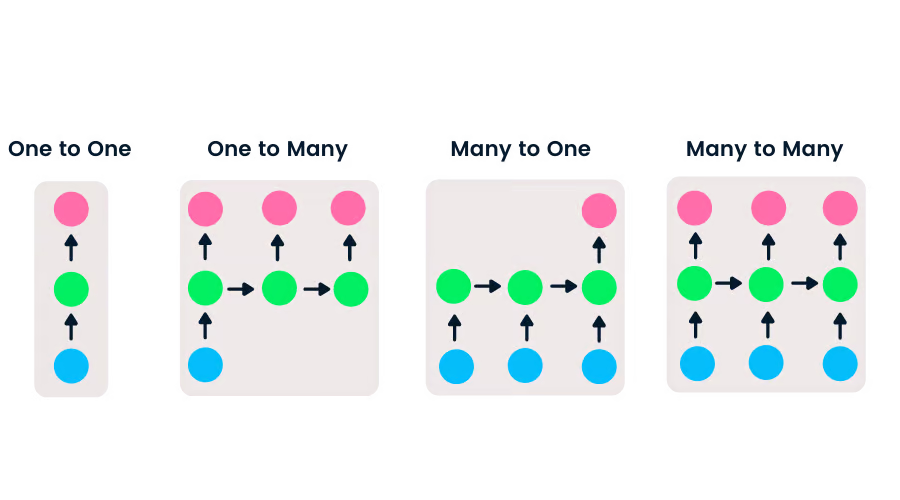

the Intut lay(x)的最初層(x),該層是simder tosives to sivers to sivering to sivil(compistion to siveristion to siviling to siviling to siviling in to sivive to siviling to sivil(a)。功能,權重和偏見。這些參數在隱藏的層上共享,創建一個單個循環圖層,而不是多個不同的層。 RNNS通過時間(BPTT)而不是傳統的反向傳播來計算梯度。 BPTT由於共享參數而在每個時間步中匯總錯誤。rnns的類型在輸入和輸出長度方面具有靈活性,與具有單個輸入和輸出的FeedForward網絡不同。這種適應性使RNN可以處理各種任務,包括音樂生成,情感分析和機器翻譯。存在四種主要類型:

長短期內存(LSTM):高級RNN,旨在減輕消失/爆炸梯度。它的四個相互作用層有助於長期記憶力保留,使其適合機器翻譯,語音合成等。

長短期內存(LSTM):高級RNN,旨在減輕消失/爆炸梯度。它的四個相互作用層有助於長期記憶力保留,使其適合機器翻譯,語音合成等。

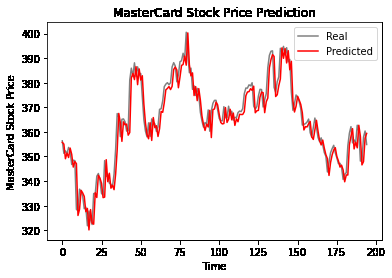

本節使用LSTM和GRU詳細介紹了一個項目,以預測萬事達卡股價。該代碼利用圖書館,例如熊貓,numpy,matplotlib,scikit-learn和tensorflow。

(此處省略了原始輸入中的詳細代碼示例,以概述以下核心步驟。

minmaxScaler 進行縮放,並重塑模型輸入。 Hybrid CNN-RNN networks are increasingly used for tasks requiring both spatial and時間理解。本教程提供了對LSTM和GRU等高級體系結構提供的RNN,其局限性和解決方案的基本理解。該項目證明了LSTM和GRU在股票價格預測中的應用,在此特定情況下強調了GRU的出色表現。完整的項目可在Datacamp Workspace上找到。

記住替換 https://www.php.cn/link/link/cc6a66632b380f3f6a1c54b12222222cd966c2 <code> https://www.php.cn/link/8708107B2FF5DE15D02444471AE041FDB 帶有指向相關課程的鏈接。假定圖像URL是正確且可訪問的。

以上是經常性神經網絡教程(RNN)的詳細內容。更多資訊請關注PHP中文網其他相關文章!