F-Beta分數:機器學習中模型評估的綜合指南

在機器學習和統計建模中,準確評估模型性能至關重要。儘管準確性是一個普遍的指標,但在處理不平衡數據集時通常會缺乏,因此無法充分捕獲精確度和召回之間的權衡。輸入F-BETA分數 - 更靈活的評估度量標準,可讓您根據特定任務確定精度或召回率。本文詳細說明了F-BETA分數,其計算,應用和實施Python。

學習目標:

目錄:

F-Beta得分是多少?

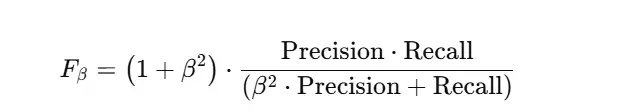

F-BETA分數通過考慮精度和召回來提供對模型輸出的細微評估。與F1分數平均得分和召回均等不同,F-beta得分使您可以使用β參數調整召回的權重相對於精度的加權。

何時使用F-beta分數

F-beta分數在要求精確和召回的仔細平衡或優先級的情況下特別有用。以下是一些關鍵情況:

數據集不平衡的數據集:在具有偏斜類分佈的數據集中(例如,欺詐檢測,醫學診斷),準確性可能會誤導。 F-beta分數使您可以調整β以強調召回率(較少的錯過陽性)或精度(較少的假陽性),與與每種誤差類型相關的成本保持一致。

特定於域的優先級:不同的應用程序對不同類型的錯誤具有不同的公差。例如:

優化Precision-Recall權衡: F-BETA分數提供了一個指標來指導優化過程,從而可以對精度或召回率進行有針對性的改進。

成本敏感的任務:當誤報和假否定因素的成本顯著差異時,F-BETA得分有助於選擇最佳平衡。

計算F-beta分數

F-beta分數是使用精確的,並從混淆矩陣中得出的回憶:

| 預測陽性 | 預測負面 | |

|---|---|---|

| 實際積極 | 真正的積極(TP) | 假陰性(FN) |

| 實際負面 | 假陽性(FP) | 真正的負(TN) |

F-beta分數的實際應用

F-Beta分數在許多域中找到了廣泛的應用:

Python實施

scikit-learn庫提供了一種直接計算F-Beta分數的方式:

來自sklearn.metrics導入fbeta_score,precision_score,recker_score,confusion_matrix

導入numpy作為NP

#示例數據

y_true = np.Array([1,0,1,1,1,0,1,0,0,0,1,0])

y_pred = np.Array([1,0,1,0,0,1,1,0,1,1,1,0])

#計算分數

precision = precision_score(y_true,y_pred)

回憶= recker_score(y_true,y_pred)

f1 = fbeta_score(y_true,y_pred,beta = 1)

f2 = fbeta_score(y_true,y_pred,beta = 2)

f05 = fbeta_score(y_true,y_pred,beta = 0.5)

打印(f“精度:{precision:.2f}”)

打印(f“召回:{召回:.2f}”)

打印(f“ F1分數:{f1:.2f}”)

打印(f“ f2分數:{f2:.2f}”)

打印(f“ f0.5得分:{f05:.2f}”)

#混亂矩陣

conf_matrix = Confusion_matrix(y_true,y_pred)

打印(“ \ n Conconfusion矩陣:”)

打印(conc_matrix)結論

F-BETA分數是評估機器學習模型的強大工具,尤其是在處理不同類型錯誤成本變化的不平衡數據集或情況時。它在加權精度和召回方面的靈活性使其適應廣泛的應用。通過理解和利用F-Beta分數,您可以顯著增強模型評估過程,並獲得更強大且相關的結果。

常見問題

Q1:使用F-Beta分數是什麼? A1:通過根據應用需求平衡精度和召回來評估模型性能。

Q2:β如何影響F-beta評分? A2:較高的β值確定召回優先級;較低的β值優先確定精度。

Q3:F-BETA得分是否適合不平衡數據集? A3:是的,這對於不平衡數據集非常有效。

Q4:F-beta得分與F1分數有何不同? A4:F1分數是F-beta評分的特殊情況,β= 1。

Q5:我可以在沒有庫的情況下計算F-Beta分數嗎? A5:是的,但是像scikit-learn這樣的庫簡化了過程。

以上是什麼是F-Beta分數?的詳細內容。更多資訊請關注PHP中文網其他相關文章!