Python爬蟲實戰之爬取 V2EX 網站帖子

背景:

PySpider:一個國人編寫的強大的網路爬蟲系統並帶有強大的WebUI。採用Python語言編寫,分散式架構,支援多種資料庫後端,強大的WebUI支援腳本編輯器,任務監視器,專案管理器以及結果檢視器。線上範例: http://demo.pyspider.org/

官方文件: http://docs.pyspider.org/en/l...

Github : https://github.com/binux/pysp. ..

本文爬蟲代碼Github 網址:https://github.com/zhisheng17...

更多精彩文章可以在微信公眾號:猿blog 閱讀到,歡迎關注。

說了這麼多,我們還是來看正文吧!

前提:

你已經安裝好了Pyspider 和MySQL-python(保存資料)

如果你還沒安裝的話,請看看我的前一篇文章,防止你也走彎路。

Pyspider 框架學習時走過的一些坑

HTTP 599: SSL certificate problem: unable to get local issuer certificate錯誤

我所遇到的一些錯誤:

框架爬取V2EX 網站的貼文中的問題和內容,然後將爬取的資料保存在本地。 V2EX 中大部分的帖子查看是不需要登入的,當然也有些帖子是需要登陸後才能夠查看的。 (因為後來爬取的時候發現一直error ,查看具體原因後才知道是需要登錄的才可以查看那些帖子的)所以我覺得沒必要用到Cookie,當然如果你非得要登錄,那也很簡單,簡單地方法就是加入你登入後的cookie 了。

V2EX 中大部分的帖子查看是不需要登入的,當然也有些帖子是需要登陸後才能夠查看的。 (因為後來爬取的時候發現一直error ,查看具體原因後才知道是需要登錄的才可以查看那些帖子的)所以我覺得沒必要用到Cookie,當然如果你非得要登錄,那也很簡單,簡單地方法就是加入你登入後的cookie 了。

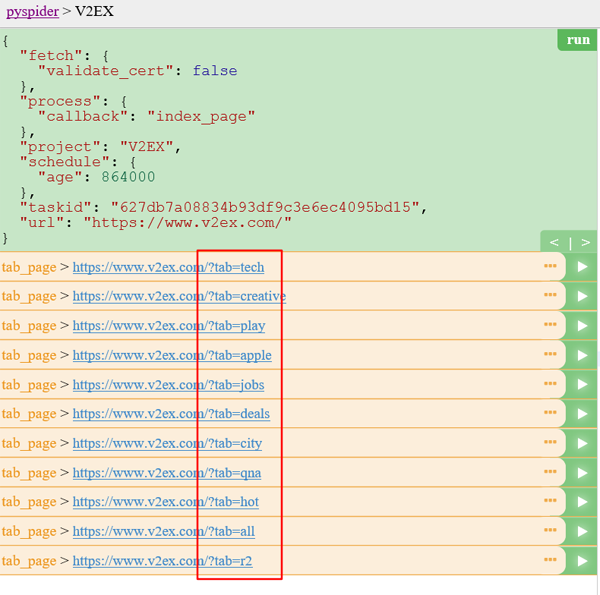

我們在 https://www.v2ex.com/ 掃了一遍,發現並沒有一個列表能包含所有的帖子,只能退而求其次,通過抓取分類下的所有的標籤列表頁,來遍歷所有的貼文:https://www.v2ex.com/?tab=tech 然後是 https://www.v2ex.com/go/progr... 最後每個貼文的詳情網址是(舉例): https: //www.v2ex.com/t/314683...

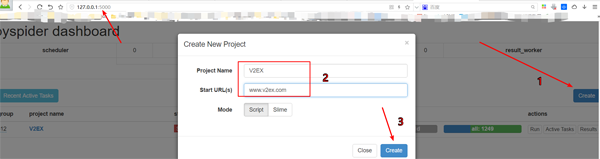

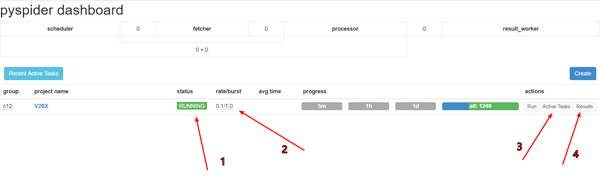

建立一個專案

在pyspider 的dashboard 的右下角,點選「Create」按鈕

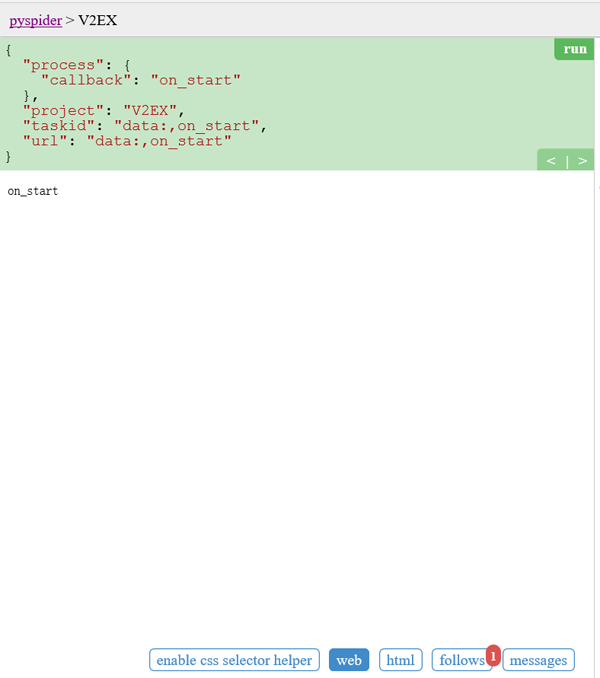

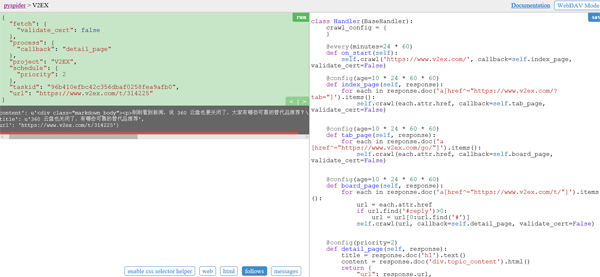

的替換@every(minutes=24 * 60)

def on_start(self):

self.crawl('https://www.v2ex.com/', callback=self.index_page, validate_cert=False)self.crawl 告訴pyspider 抓取指定頁面,然後使用callback 函數對結果進行解析。

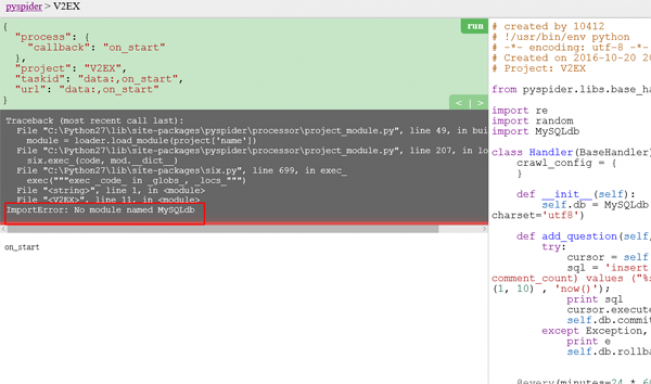

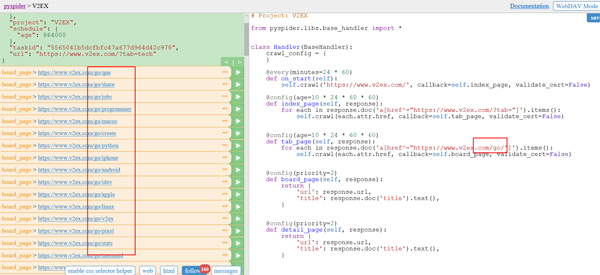

第二張截圖一開始是出現這個問題了,解決辦法看前面寫的文章,後來問題就不再會出現了。

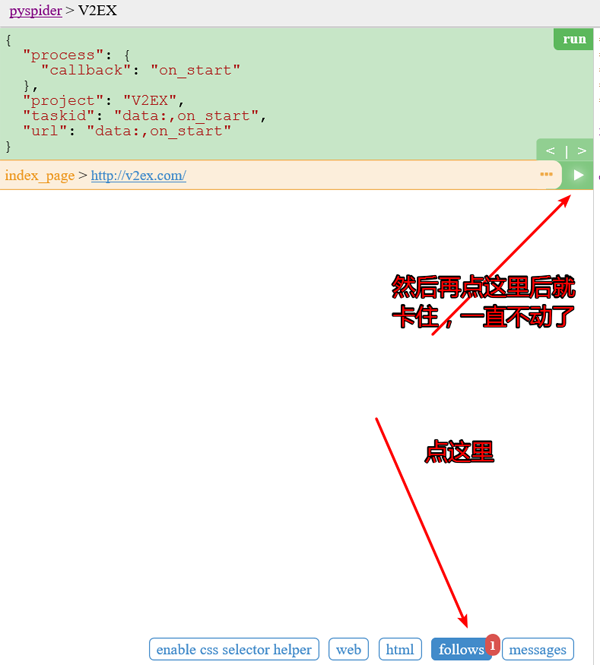

在 tab 清單頁 中,我們需要提取所有的主題清單頁 的 URL。你可能已經發現了,sample handler 已經提取了非常多大的URL

@config(age=10 * 24 * 60 * 60)

def index_page(self, response):

for each in response.doc('a[href^="https://www.v2ex.com/?tab="]').items():

self.crawl(each.attr.href, callback=self.tab_page, validate_cert=False)代碼:

@config(age=10 * 24 * 60 * 60) def tab_page(self, response): for each in response.doc('a[href^="https://www.v2ex.com/go/"]').items(): self.crawl(each.attr.href, callback=self.board_page, validate_cert=False)

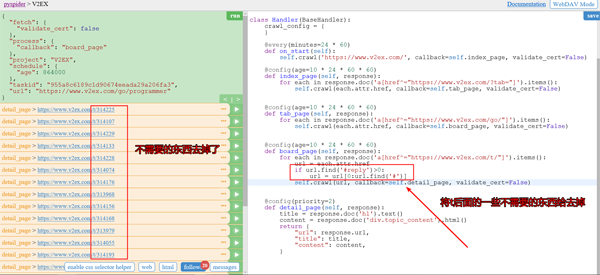

同時我們還需要讓他自己實現自動翻頁功能。

同時我們還需要讓他自己實現自動翻頁功能。

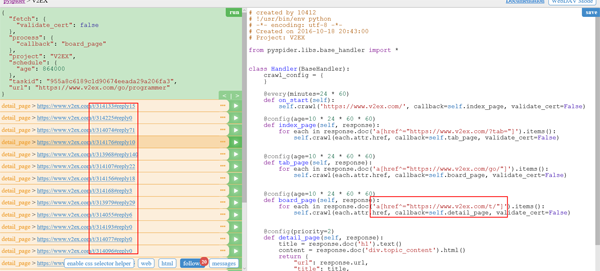

程式碼:

@config(age=10 * 24 * 60 * 60)

def board_page(self, response):

for each in response.doc('a[href^="https://www.v2ex.com/t/"]').items():

url = each.attr.href

if url.find('#reply')>0:

url = url[0:url.find('#')]

self.crawl(url, callback=self.detail_page, validate_cert=False)

for each in response.doc('a.page_normal').items():

self.crawl(each.attr.href, callback=self.board_page, validate_cert=False)

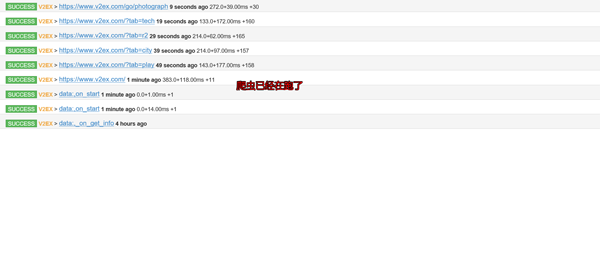

#实现自动翻页功能去掉後的運行截圖:

實現自動翻頁後的截圖:

此时我们已经可以匹配了所有的帖子的 url 了。

点击每个帖子后面的按钮就可以查看帖子具体详情了。

代码:

@config(priority=2)

def detail_page(self, response):

title = response.doc('h1').text()

content = response.doc('p.topic_content').html().replace('"', '\\"')

self.add_question(title, content) #插入数据库

return {

"url": response.url,

"title": title,

"content": content,

}插入数据库的话,需要我们在之前定义一个add_question函数。

#连接数据库

def __init__(self):

self.db = MySQLdb.connect('localhost', 'root', 'root', 'wenda', charset='utf8')

def add_question(self, title, content):

try:

cursor = self.db.cursor()

sql = 'insert into question(title, content, user_id, created_date, comment_count)

values ("%s","%s",%d, %s, 0)' %

(title, content, random.randint(1, 10) , 'now()');

#插入数据库的SQL语句

print sql

cursor.execute(sql)

print cursor.lastrowid

self.db.commit()

except Exception, e:

print e

self.db.rollback()查看爬虫运行结果:

先debug下,再调成running。pyspider框架在windows下的bug

设置跑的速度,建议不要跑的太快,否则很容易被发现是爬虫的,人家就会把你的IP给封掉的

查看运行工作

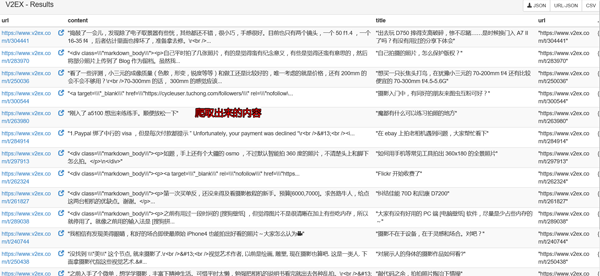

查看爬取下来的内容

然后再本地数据库GUI软件上查询下就可以看到数据已经保存到本地了。

自己需要用的话就可以导入出来了。

在开头我就告诉大家爬虫的代码了,如果详细的看看那个project,你就会找到我上传的爬取数据了。(仅供学习使用,切勿商用!)

当然你还会看到其他的爬虫代码的了,如果你觉得不错可以给个 Star,或者你也感兴趣的话,你可以fork我的项目,和我一起学习,这个项目长期更新下去。

最后:

代码:

# created by 10412

# !/usr/bin/env python

# -*- encoding: utf-8 -*-

# Created on 2016-10-20 20:43:00

# Project: V2EX

from pyspider.libs.base_handler import *

import re

import random

import MySQLdb

class Handler(BaseHandler):

crawl_config = {

}

def __init__(self):

self.db = MySQLdb.connect('localhost', 'root', 'root', 'wenda', charset='utf8')

def add_question(self, title, content):

try:

cursor = self.db.cursor()

sql = 'insert into question(title, content, user_id, created_date, comment_count)

values ("%s","%s",%d, %s, 0)' % (title, content, random.randint(1, 10) , 'now()');

print sql

cursor.execute(sql)

print cursor.lastrowid

self.db.commit()

except Exception, e:

print e

self.db.rollback()

@every(minutes=24 * 60)

def on_start(self):

self.crawl('https://www.v2ex.com/', callback=self.index_page, validate_cert=False)

@config(age=10 * 24 * 60 * 60)

def index_page(self, response):

for each in response.doc('a[href^="https://www.v2ex.com/?tab="]').items():

self.crawl(each.attr.href, callback=self.tab_page, validate_cert=False)

@config(age=10 * 24 * 60 * 60)

def tab_page(self, response):

for each in response.doc('a[href^="https://www.v2ex.com/go/"]').items():

self.crawl(each.attr.href, callback=self.board_page, validate_cert=False)

@config(age=10 * 24 * 60 * 60)

def board_page(self, response):

for each in response.doc('a[href^="https://www.v2ex.com/t/"]').items():

url = each.attr.href

if url.find('#reply')>0:

url = url[0:url.find('#')]

self.crawl(url, callback=self.detail_page, validate_cert=False)

for each in response.doc('a.page_normal').items():

self.crawl(each.attr.href, callback=self.board_page, validate_cert=False)

@config(priority=2)

def detail_page(self, response):

title = response.doc('h1').text()

content = response.doc('p.topic_content').html().replace('"', '\\"')

self.add_question(title, content) #插入数据库

return {

"url": response.url,

"title": title,

"content": content,

}以上就是Python爬虫实战之爬取 V2EX 网站帖子的内容,更多相关内容请关注PHP中文网(www.php.cn)!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

PHP和Python:解釋了不同的範例

Apr 18, 2025 am 12:26 AM

PHP和Python:解釋了不同的範例

Apr 18, 2025 am 12:26 AM

PHP主要是過程式編程,但也支持面向對象編程(OOP);Python支持多種範式,包括OOP、函數式和過程式編程。 PHP適合web開發,Python適用於多種應用,如數據分析和機器學習。

在PHP和Python之間進行選擇:指南

Apr 18, 2025 am 12:24 AM

在PHP和Python之間進行選擇:指南

Apr 18, 2025 am 12:24 AM

PHP適合網頁開發和快速原型開發,Python適用於數據科學和機器學習。 1.PHP用於動態網頁開發,語法簡單,適合快速開發。 2.Python語法簡潔,適用於多領域,庫生態系統強大。

sublime怎麼運行代碼python

Apr 16, 2025 am 08:48 AM

sublime怎麼運行代碼python

Apr 16, 2025 am 08:48 AM

在 Sublime Text 中運行 Python 代碼,需先安裝 Python 插件,再創建 .py 文件並編寫代碼,最後按 Ctrl B 運行代碼,輸出會在控制台中顯示。

PHP和Python:深入了解他們的歷史

Apr 18, 2025 am 12:25 AM

PHP和Python:深入了解他們的歷史

Apr 18, 2025 am 12:25 AM

PHP起源於1994年,由RasmusLerdorf開發,最初用於跟踪網站訪問者,逐漸演變為服務器端腳本語言,廣泛應用於網頁開發。 Python由GuidovanRossum於1980年代末開發,1991年首次發布,強調代碼可讀性和簡潔性,適用於科學計算、數據分析等領域。

Python vs. JavaScript:學習曲線和易用性

Apr 16, 2025 am 12:12 AM

Python vs. JavaScript:學習曲線和易用性

Apr 16, 2025 am 12:12 AM

Python更適合初學者,學習曲線平緩,語法簡潔;JavaScript適合前端開發,學習曲線較陡,語法靈活。 1.Python語法直觀,適用於數據科學和後端開發。 2.JavaScript靈活,廣泛用於前端和服務器端編程。

Golang vs. Python:性能和可伸縮性

Apr 19, 2025 am 12:18 AM

Golang vs. Python:性能和可伸縮性

Apr 19, 2025 am 12:18 AM

Golang在性能和可擴展性方面優於Python。 1)Golang的編譯型特性和高效並發模型使其在高並發場景下表現出色。 2)Python作為解釋型語言,執行速度較慢,但通過工具如Cython可優化性能。

vscode在哪寫代碼

Apr 15, 2025 pm 09:54 PM

vscode在哪寫代碼

Apr 15, 2025 pm 09:54 PM

在 Visual Studio Code(VSCode)中編寫代碼簡單易行,只需安裝 VSCode、創建項目、選擇語言、創建文件、編寫代碼、保存並運行即可。 VSCode 的優點包括跨平台、免費開源、強大功能、擴展豐富,以及輕量快速。

notepad 怎麼運行python

Apr 16, 2025 pm 07:33 PM

notepad 怎麼運行python

Apr 16, 2025 pm 07:33 PM

在 Notepad 中運行 Python 代碼需要安裝 Python 可執行文件和 NppExec 插件。安裝 Python 並為其添加 PATH 後,在 NppExec 插件中配置命令為“python”、參數為“{CURRENT_DIRECTORY}{FILE_NAME}”,即可在 Notepad 中通過快捷鍵“F6”運行 Python 代碼。