零基礎寫Java知乎爬蟲之先拿百度首頁練練手

上一集我們說到需要用Java來製作一個知乎爬蟲,那麼這次,我們就來研究一下如何使用程式碼取得到網頁的內容。

首先,沒有HTML和CSS和JS和AJAX經驗的建議先去W3C(點我點我)小小的了解一下。

說到HTML,這裡就牽涉到一個GET存取和POST存取的問題。

如果對這個方面缺乏了解可以閱讀W3C的這篇:《GET對比POST》。

啊哈,在此不再贅述。

然後咧,接下來我們需要用Java來爬取一個網頁的內容。

這時候,我們的百度就要派上用場了。

沒錯,他不再是那個默默無聞的網速測試器了,他即將成為我們的爬蟲小白鼠! ~

我們先來看看百度的首頁:

相信大家都知道,現在這樣的一個頁面,是HTML和CSS共同工作的結果。

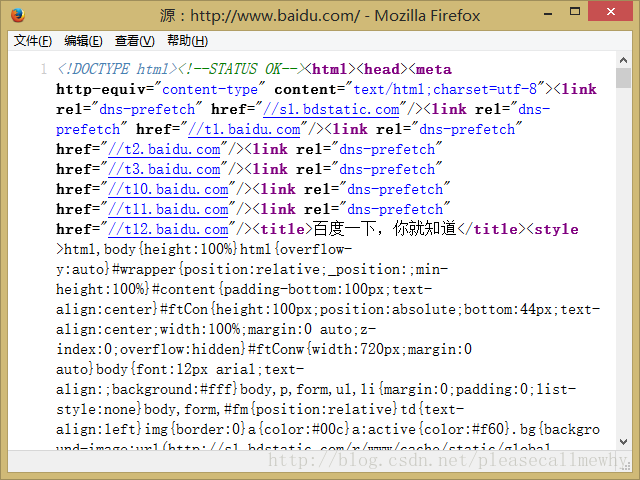

我們在瀏覽器中右鍵點擊頁面,選擇「查看頁面原始碼」:

沒錯,就是這一坨翔一樣的東西。這就是百度頁面的原始碼。

接下來我們的任務,就是使用我們的爬蟲也獲得到一樣的東西。

先來看一段簡單的源碼:

import java.io.*;

import java.net.*;

public class Main {

public static void main(String[] args) {

// 定义即将访问的链接

String url = "http://www.baidu.com";

// 定义一个字符串用来存储网页内容

String result = "";

// 定义一个缓冲字符输入流

BufferedReader in = null;

try {

// 将string转成url对象

URL realUrl = new URL(url);

// 初始化一个链接到那个url的连接

URLConnection connection = realUrl.openConnection();

// 开始实际的连接

connection.connect();

// 初始化 BufferedReader输入流来读取URL的响应

in = new BufferedReader(new InputStreamReader(

connection.getInputStream()));

// 用来临时存储抓取到的每一行的数据

String line;

while ((line = in.readLine()) != null) {

//遍历抓取到的每一行并将其存储到result里面

result += line;

}

} catch (Exception e) {

System.out.println("发送GET请求出现异常!" + e);

e.printStackTrace();

}

// 使用finally来关闭输入流

finally {

try {

if (in != null) {

in.close();

}

} catch (Exception e2) {

e2.printStackTrace();

}

}

System.out.println(result);

}

}以上就是Java模擬Get訪問百度的Main方法,

可以運行一下看看結果:

,和我們前面用啊哈瀏覽器看到的一模一樣。至此,一個最簡單的爬蟲就算是做好了。

但是這麼一大坨東西未必都是我想要的啊,怎麼從中抓取出我想要的東西呢?

以百度的大爪子Logo為例。

臨時需求:

取得百度Logo的大爪子的圖片連結。

先說一下瀏覽器的查看方法。

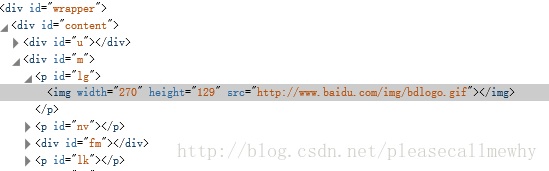

滑鼠對圖片右鍵,選擇審查元素(火狐,Google,IE11,均有此功能,只是名字不太一樣):

啊哈,可以看到在一大堆div的圍攻下的可憐的img標籤。

這個src就是圖片的連結了。

那麼在java中我們怎麼搞呢?

事先說明,為了方便示範程式碼,所有程式碼均未作類封裝,還請諒解。

我們先把前面的程式碼封裝成一個sendGet函數:

import java.io.*;

import java.net.*;

public class Main {

static String sendGet(String url) {

// 定义一个字符串用来存储网页内容

String result = "";

// 定义一个缓冲字符输入流

BufferedReader in = null;

try {

// 将string转成url对象

URL realUrl = new URL(url);

// 初始化一个链接到那个url的连接

URLConnection connection = realUrl.openConnection();

// 开始实际的连接

connection.connect();

// 初始化 BufferedReader输入流来读取URL的响应

in = new BufferedReader(new InputStreamReader(

connection.getInputStream()));

// 用来临时存储抓取到的每一行的数据

String line;

while ((line = in.readLine()) != null) {

// 遍历抓取到的每一行并将其存储到result里面

result += line;

}

} catch (Exception e) {

System.out.println("发送GET请求出现异常!" + e);

e.printStackTrace();

}

// 使用finally来关闭输入流

finally {

try {

if (in != null) {

in.close();

}

} catch (Exception e2) {

e2.printStackTrace();

}

}

return result;

}

public static void main(String[] args) {

// 定义即将访问的链接

String url = "http://www.baidu.com";

// 访问链接并获取页面内容

String result = sendGet(url);

System.out.println(result);

}

}這樣看起來稍微整潔了一點,請原諒我這個強迫症。

接下來的任務,就是從獲取到的一大堆東西裡面找到那個圖片的連結。

我們首先可以想到的方法,是對頁面原始碼的字串result使用indexof函數進行String的子字串搜尋。

沒錯這個方法是可以慢慢解決這個問題,例如直接indexOf("src")找到開始的序號,然後再稀裡嘩啦的搞到結束的序號。

不過我們不能一直使用這種方法,畢竟草鞋只適合出門走走,後期還是需要切假腿來拿人頭的。

請原諒我的亂入,繼續。

那我們用什麼方式來尋找這張圖片的src呢?

沒錯,正如下面觀眾所說,正則匹配。

如果有同學不太清楚正規則,可以參考這篇文章:[Python]網路爬蟲(七):Python中的正規表示式教學。

簡單來說,正規就像是匹配。

例如三個胖子站在這裡,分別穿著紅衣服,藍衣服,綠衣服。

正則是:抓住那個穿綠衣服的!

然後把綠胖子單獨抓了出來。

就是這麼簡單。

但是正規的語法卻還是博大精深的,剛接觸的時候難免有點摸不著頭腦,

向大家推荐一個正則的在線測試工具:正則表達式在線測試。

有了正規這個神兵利器,那麼怎麼在java裡面使用正規呢?

以上就是零基礎寫Java知乎爬蟲之先拿百度首頁練練手 的內容,更多相關內容請關注PHP中文網(www.php.cn)!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

PHP:網絡開發的關鍵語言

Apr 13, 2025 am 12:08 AM

PHP:網絡開發的關鍵語言

Apr 13, 2025 am 12:08 AM

PHP是一種廣泛應用於服務器端的腳本語言,特別適合web開發。 1.PHP可以嵌入HTML,處理HTTP請求和響應,支持多種數據庫。 2.PHP用於生成動態網頁內容,處理表單數據,訪問數據庫等,具有強大的社區支持和開源資源。 3.PHP是解釋型語言,執行過程包括詞法分析、語法分析、編譯和執行。 4.PHP可以與MySQL結合用於用戶註冊系統等高級應用。 5.調試PHP時,可使用error_reporting()和var_dump()等函數。 6.優化PHP代碼可通過緩存機制、優化數據庫查詢和使用內置函數。 7

突破或從Java 8流返回?

Feb 07, 2025 pm 12:09 PM

突破或從Java 8流返回?

Feb 07, 2025 pm 12:09 PM

Java 8引入了Stream API,提供了一種強大且表達力豐富的處理數據集合的方式。然而,使用Stream時,一個常見問題是:如何從forEach操作中中斷或返回? 傳統循環允許提前中斷或返回,但Stream的forEach方法並不直接支持這種方式。本文將解釋原因,並探討在Stream處理系統中實現提前終止的替代方法。 延伸閱讀: Java Stream API改進 理解Stream forEach forEach方法是一個終端操作,它對Stream中的每個元素執行一個操作。它的設計意圖是處

PHP與Python:了解差異

Apr 11, 2025 am 12:15 AM

PHP與Python:了解差異

Apr 11, 2025 am 12:15 AM

PHP和Python各有優勢,選擇應基於項目需求。 1.PHP適合web開發,語法簡單,執行效率高。 2.Python適用於數據科學和機器學習,語法簡潔,庫豐富。

PHP與其他語言:比較

Apr 13, 2025 am 12:19 AM

PHP與其他語言:比較

Apr 13, 2025 am 12:19 AM

PHP適合web開發,特別是在快速開發和處理動態內容方面表現出色,但不擅長數據科學和企業級應用。與Python相比,PHP在web開發中更具優勢,但在數據科學領域不如Python;與Java相比,PHP在企業級應用中表現較差,但在web開發中更靈活;與JavaScript相比,PHP在後端開發中更簡潔,但在前端開發中不如JavaScript。

PHP與Python:核心功能

Apr 13, 2025 am 12:16 AM

PHP與Python:核心功能

Apr 13, 2025 am 12:16 AM

PHP和Python各有優勢,適合不同場景。 1.PHP適用於web開發,提供內置web服務器和豐富函數庫。 2.Python適合數據科學和機器學習,語法簡潔且有強大標準庫。選擇時應根據項目需求決定。

PHP的影響:網絡開發及以後

Apr 18, 2025 am 12:10 AM

PHP的影響:網絡開發及以後

Apr 18, 2025 am 12:10 AM

PHPhassignificantlyimpactedwebdevelopmentandextendsbeyondit.1)ItpowersmajorplatformslikeWordPressandexcelsindatabaseinteractions.2)PHP'sadaptabilityallowsittoscaleforlargeapplicationsusingframeworkslikeLaravel.3)Beyondweb,PHPisusedincommand-linescrip

PHP:許多網站的基礎

Apr 13, 2025 am 12:07 AM

PHP:許多網站的基礎

Apr 13, 2025 am 12:07 AM

PHP成為許多網站首選技術棧的原因包括其易用性、強大社區支持和廣泛應用。 1)易於學習和使用,適合初學者。 2)擁有龐大的開發者社區,資源豐富。 3)廣泛應用於WordPress、Drupal等平台。 4)與Web服務器緊密集成,簡化開發部署。

PHP與Python:用例和應用程序

Apr 17, 2025 am 12:23 AM

PHP與Python:用例和應用程序

Apr 17, 2025 am 12:23 AM

PHP適用於Web開發和內容管理系統,Python適合數據科學、機器學習和自動化腳本。 1.PHP在構建快速、可擴展的網站和應用程序方面表現出色,常用於WordPress等CMS。 2.Python在數據科學和機器學習領域表現卓越,擁有豐富的庫如NumPy和TensorFlow。