在本文中,以'哈'來解釋作示例解釋所有的問題,「哈」的各種編碼如下:

1. UNICODE (UTF8-16),C854;

2. UTF-8,E59388;

3. GBK,B9FE。

一、python中的str和unicode

一直以來,python中的中文編碼就是一個極為頭大的問題,經常拋出編碼轉換的異常,python中的str和unicode到底是一個什麼東西呢?

在python中提到unicode,一般指的是unicode對象,例如'哈哈'的unicode對象為

u'u54c8u54c8'

而str,是一個位元組數組,這個位元組數組表示的是對unicode對象編碼(而str,是一個位元組數組,這個位元組數組表示的是對unicode對象編碼(而str可以是utf-8、gbk、cp936、GB2312)後的儲存的格式。這裡它只是一個位元組流,沒有其它的意義,如果你想讓這個位元組流顯示的內容有意義,就必須用正確的編碼格式,解碼顯示。

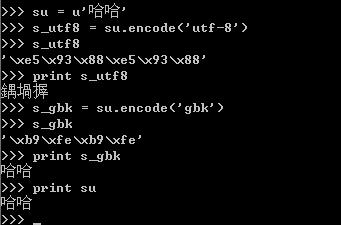

例如:

對於unicode物件哈哈進行編碼,編碼成一個utf-8編碼的str-s_utf8,s_utf8就是是一個位元組數組,存放的就是'xe5x93x88xe5x93x88',但是這組數組只是一個位元組,如果你想將它透過print語句輸出成哈哈,那你就失望了,為什麼呢?

因為print語句它的實現是將要輸出的內容傳送了操作系統,操作系統會根據系統的編碼對輸入的字節流進行編碼,這就解釋了為什麼utf-8格式的字符串“哈哈”,輸出的是“鍝堯”,因為'xe5x93x88xe5x93x88'用GB2312去解釋,其顯示的出來就是“鍝堯”。這裡再強調一下,str記錄的是位元組數組,只是某種編碼的儲存格式,至於輸出到檔案或列印出來是什麼格式,完全取決於其解碼的編碼將它解碼成什麼樣子。

這裡再對print進行一點補充說明:當將一個unicode物件傳給print時,在內部會將該unicode物件進行一次轉換,轉換成本地的預設編碼(這僅是個人猜測)

二、str和unicode物件的轉換

str和unicode物件的轉換,透過encode和decode實現,具體使用如下:

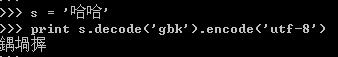

將GBK'哈哈'轉換成unicode,然後再轉換成UTF8

三、Setdefaultencoc%

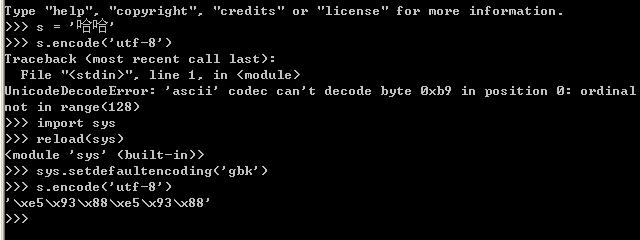

如上圖的示範程式碼所示:

如上圖的示範程式碼所示:

當把s(gbk字串)直接編碼成utf-8的時候,將拋出異常,但是透過呼叫如下碼:

import sys

reload( sys)

sys.setdefaultencoding('gbk')

後就可以轉換成功,為什麼呢?在python中str和unicode在編碼和解碼過程中,如果將一個str直接編碼成另一種編碼,會先把str解碼成unicode,採用的編碼為預設編碼,一般預設編碼是anscii,所以在上面範例程式碼中第一次轉換的時候會出錯,當設定目前預設編碼為'gbk'後,就不會出錯了。

至於reload(sys)是因為Python2.5 初始化後會刪除 sys.setdefaultencoding 這個方法,我們需要重新載入。

四、操作不同檔案的編碼格式的檔案

建立一個檔案test.txt,檔案格式用ANSI,內容為:

abc中文

用python來讀取

# open("Test.txt").read()

結果:abc中文

把檔案格式改成UTF-8:

結果:abc涓枃

顯然,這裡要解碼:

# co

gbkimport codecsprint open("Test.txt").read().decode("utf-8")結果:abc中文上面的test.txt我是用Editplus來編輯的,Editplus來編輯的,Editplus來編輯的,Editplus來編輯的,Editplus來編輯的,但當我用Windows自備的記事本編輯並存成UTF-8格式時,運行時錯誤:Traceback (most recent call last):File "ChineseTest.py", line 3, in File "ChineseTest.py", line 3, in File "ChineseTest.py", line 3, in File "ChineseTest.py", line 3, in 🎜🎜File "ChineseTest.py", line 3, in 🎜🎜File "ChineseTest.py", line 3, in 🎜🎜File print open("Test.txt").read().decode("utf-8")🎜UnicodeEncodeError: 'gbk' codec can't encode character u'ufeff' in position 0: illegal multibyte sequence

原來,某些軟體,如notepad,在儲存以UTF-8的地方插入三個不可見的字元(0xEF 0xBB 0xBF,即BOM)。

因此我們在讀取時需要自己去掉這些字符,python中的codecs module定義了這個常數:

# coding=gbk

import codecs

data = open("T..

if data[:3] == codecs.BOM_UTF8:

data = data[3:]

print data.decode("utf-8")

和編碼聲明的作用原始檔的編碼格式對字串的聲明有什麼作用呢?這個問題困擾一直困擾了我好久,現在終於有點眉目了,文件的編碼格式決定了在該源文件中聲明的字符串的編碼格式,例如:str = '哈哈'print repr(str) a.如果檔案格式為utf-8,則str的值為:'xe5x93x88xe5x93x88'(哈哈的utf-8編碼)b.如果檔案格式為gbk,則str的值為:'xb9xfexbxfe'哈哈的gbk編碼)在第一節已經說過,python中的字串,只是一個字節數組,所以當把a情況的str輸出到gbk編碼的控制台時,就將顯示為亂碼:鍝夾搱;而當把b情況下的str輸出utf-8編碼的控制台時,也會顯示亂碼的問題,是什麼也沒有,也許'xb9xfexb9xfe'用utf-8解碼顯示,就是空白吧。 >_說完文件格式,現在來談談編碼聲明的作用吧,每個文件在最上面的地方,都會用# coding=gbk 類似的語句聲明一下編碼,但是這個聲明到底有什麼用呢?到止前為止,我覺得它的作用也就是三個: 聲明源文件中將出現非ascii編碼,通常也就是中文;在高級的IDE中,IDE會將你的文件格式保存成你指定編碼格式。 決定源碼中類似u'哈'這類聲明的將'哈'解碼成unicode所用的編碼格式,也是一個比較容易讓人迷惑的地方,看例子:#coding:gbk#coding:gbk

#coding:gbk ss = u'哈哈'print repr(ss)print 'ss:%s' % ss將這個些代碼保存成一個utf-8文本,運行,你認為什麼會輸出呢?大家第一個感覺肯定輸出的肯定是:u'u54c8u54c8'ss:哈哈但其實輸出是:u'u935du581du6431'ss ,就是編碼聲明在作怪了,在運行ss = u'哈哈'的時候,整個過程可以分為以下幾步:1) 獲取'哈哈'的編碼:由文件編碼格式確定,為'xe5x93x88xe5x93x88'(哈哈的utf-8編碼形式)2) 轉成unicode編碼的時候,在這個轉換的過程中,對於'xe5x93x88xe5x93x88'的解碼,不是用utf-8解碼,而是用聲明編碼處指定的編碼GBK ,將'xe5x93x88xe5x93x88'按GBK解碼,得到就是''鍝堝搱'',這三個字的unicode編碼就是u'u935du581du6431',至止可以解釋為什麼print repr(ss)輸出的是u'u9655881du了。 好了,這裡有點繞,我們來分析下一個例子:#-*- coding:utf-8 -*-

ss = u'哈哈'

printprint

print :%s' % ss

將此範例這次保存成GBK編碼形式,運行結果,竟然是: