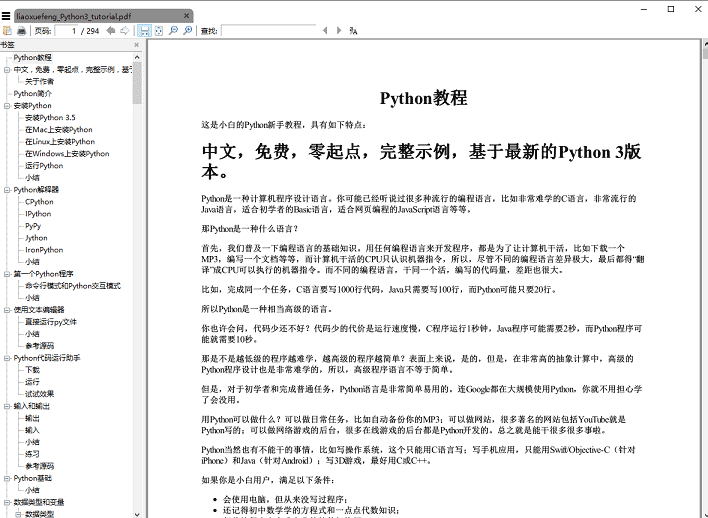

python爬蟲實作教學轉換成 PDF 電子書

本文給大家分享的是使用python爬蟲實作把《廖雪峰的Python 教學》轉換成PDF的方法和程式碼,有需要的小夥伴可以參考下

寫爬蟲似乎沒有比用Python 更合適了,Python 社區提供的爬蟲工具多得讓你眼花繚亂,各種拿來就可以直接用的library 分分鐘就可以寫出一個爬蟲出來,今天就琢磨著寫一個爬蟲,將廖雪峰的Python 教程爬下來做成PDF 電子書方便大家離線閱讀。

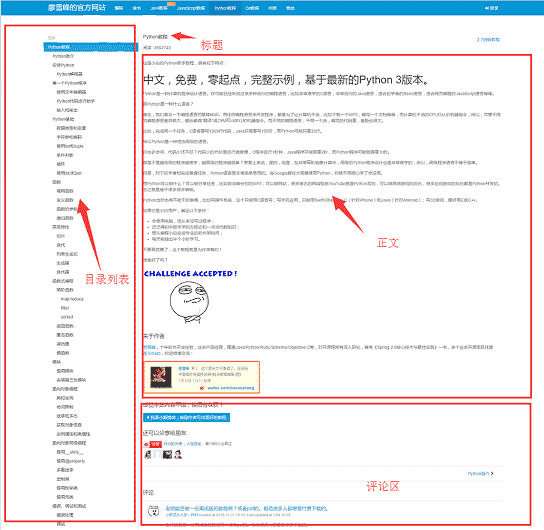

開始寫爬蟲前,我們先來分析一下該網站1的頁面結構,網頁的左側是教程的目錄大綱,每個URL 對應到右邊的一篇文章,右側上方是文章的標題,中間是文章的正文部分,正文內容是我們關心的重點,我們要爬的資料就是所有網頁的正文部分,下方是使用者的評論區,留言區對我們沒什麼用,所以可以忽略它。

工具準備

弄清楚了網站的基本結構後就可以開始準備爬蟲所依賴的工具包了。 requests、beautifulsoup 是爬蟲兩大神器,reuqests 用於網路請求,beautifusoup 用於操作 html 資料。有了這兩把梭子,幹起活來利索,scrapy 這樣的爬蟲框架我們就不用了,小程式派上它有點殺雞用牛刀的意思。此外,既然是把 html 檔案轉為 pdf,那麼也要有相應的庫支持, wkhtmltopdf 就是一個非常好的工具,它可以用適用於多平台的 html 到 pdf 的轉換,pdfkit 是 wkhtmltopdf 的Python封裝包。首先安裝好下面的依賴包,

接著安裝wkhtmltopdf

#pip install requests pip install beautifulsoup pip install pdfkit

安裝wkhtmltopdf

## Windows平台直接在wkhtmltopdf 官網2下載穩定版的進行安裝,安裝完成之後把程式的執行路徑加入到系統環境$PATH 變數中,否則pdfkit 找不到wkhtmltopdf 就出現錯誤「No wkhtmltopdf executable found」。 Ubuntu 和CentOS 可以直接用命令列進行安裝

$ sudo apt-get install wkhtmltopdf # ubuntu $ sudo yum intsall wkhtmltopdf # centos

#爬蟲實作

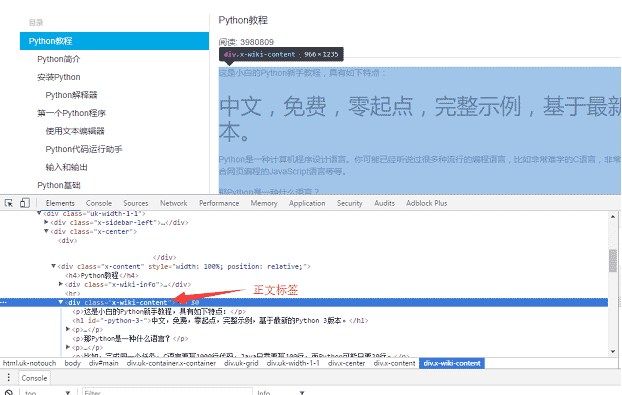

一切準備就緒後就可以上程式碼了,不過寫程式碼之前還是先整理一下思緒。程式的目的是要把所有 URL 對應的 html 正文部分儲存到本機,然後利用 pdfkit 把這些檔案轉換成一個 pdf 檔。我們把任務拆分一下,首先是把某一個 URL 對應的 html 正文儲存到本地,然後找到所有的 URL 執行相同的操作。 用 Chrome 瀏覽器找到頁面正文部分的標籤,按 F12 找到正文對應的 p 標籤:

,該 p 是網頁的正文內容。用 requests 把整個頁面載入到本機後,就可以使用 beautifulsoup 運算 HTML 的 dom 元素 來擷取正文內容了。

def parse_url_to_html(url):

response = requests.get(url)

soup = BeautifulSoup(response.content, "html5lib")

body = soup.find_all(class_="x-wiki-content")[0]

html = str(body)

with open("a.html", 'wb') as f:

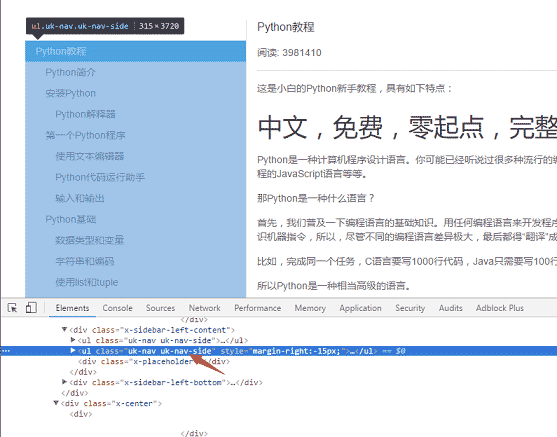

f.write(html)#特定程式碼實作邏輯:因為頁面上有兩個uk-nav uk-nav-side的class 屬性,而真正的目錄清單是第二個。所有的 url 獲取了,url 轉 html 的函數在第一步也寫好了。

def get_url_list():

"""

获取所有URL目录列表

"""

response = requests.get("http://www.liaoxuefeng.com/wiki/0014316089557264a6b348958f449949df42a6d3a2e542c000")

soup = BeautifulSoup(response.content, "html5lib")

menu_tag = soup.find_all(class_="uk-nav uk-nav-side")[1]

urls = []

for li in menu_tag.find_all("li"):

url = "http://www.liaoxuefeng.com" + li.a.get('href')

urls.append(url)

return urlsdef save_pdf(htmls):

"""

把所有html文件转换成pdf文件

"""

options = {

'page-size': 'Letter',

'encoding': "UTF-8",

'custom-header': [

('Accept-Encoding', 'gzip')

]

}

pdfkit.from_file(htmls, file_name, options=options)更多python爬蟲實作教學轉換成 PDF 電子書相關文章請關注PHP中文網!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

Python vs.C:申請和用例

Apr 12, 2025 am 12:01 AM

Python vs.C:申請和用例

Apr 12, 2025 am 12:01 AM

Python适合数据科学、Web开发和自动化任务,而C 适用于系统编程、游戏开发和嵌入式系统。Python以简洁和强大的生态系统著称,C 则以高性能和底层控制能力闻名。

Python:遊戲,Guis等

Apr 13, 2025 am 12:14 AM

Python:遊戲,Guis等

Apr 13, 2025 am 12:14 AM

Python在遊戲和GUI開發中表現出色。 1)遊戲開發使用Pygame,提供繪圖、音頻等功能,適合創建2D遊戲。 2)GUI開發可選擇Tkinter或PyQt,Tkinter簡單易用,PyQt功能豐富,適合專業開發。

Python與C:學習曲線和易用性

Apr 19, 2025 am 12:20 AM

Python與C:學習曲線和易用性

Apr 19, 2025 am 12:20 AM

Python更易學且易用,C 則更強大但複雜。 1.Python語法簡潔,適合初學者,動態類型和自動內存管理使其易用,但可能導致運行時錯誤。 2.C 提供低級控制和高級特性,適合高性能應用,但學習門檻高,需手動管理內存和類型安全。

Python和時間:充分利用您的學習時間

Apr 14, 2025 am 12:02 AM

Python和時間:充分利用您的學習時間

Apr 14, 2025 am 12:02 AM

要在有限的時間內最大化學習Python的效率,可以使用Python的datetime、time和schedule模塊。 1.datetime模塊用於記錄和規劃學習時間。 2.time模塊幫助設置學習和休息時間。 3.schedule模塊自動化安排每週學習任務。

Python vs.C:探索性能和效率

Apr 18, 2025 am 12:20 AM

Python vs.C:探索性能和效率

Apr 18, 2025 am 12:20 AM

Python在開發效率上優於C ,但C 在執行性能上更高。 1.Python的簡潔語法和豐富庫提高開發效率。 2.C 的編譯型特性和硬件控制提升執行性能。選擇時需根據項目需求權衡開發速度與執行效率。

Python標準庫的哪一部分是:列表或數組?

Apr 27, 2025 am 12:03 AM

Python標準庫的哪一部分是:列表或數組?

Apr 27, 2025 am 12:03 AM

pythonlistsarepartofthestAndArdLibrary,herilearRaysarenot.listsarebuilt-In,多功能,和Rused ForStoringCollections,而EasaraySaraySaraySaraysaraySaraySaraysaraySaraysarrayModuleandleandleandlesscommonlyusedDduetolimitedFunctionalityFunctionalityFunctionality。

Python:自動化,腳本和任務管理

Apr 16, 2025 am 12:14 AM

Python:自動化,腳本和任務管理

Apr 16, 2025 am 12:14 AM

Python在自動化、腳本編寫和任務管理中表現出色。 1)自動化:通過標準庫如os、shutil實現文件備份。 2)腳本編寫:使用psutil庫監控系統資源。 3)任務管理:利用schedule庫調度任務。 Python的易用性和豐富庫支持使其在這些領域中成為首選工具。

學習Python:2小時的每日學習是否足夠?

Apr 18, 2025 am 12:22 AM

學習Python:2小時的每日學習是否足夠?

Apr 18, 2025 am 12:22 AM

每天學習Python兩個小時是否足夠?這取決於你的目標和學習方法。 1)制定清晰的學習計劃,2)選擇合適的學習資源和方法,3)動手實踐和復習鞏固,可以在這段時間內逐步掌握Python的基本知識和高級功能。