詳解Python爬取網頁中的搜狗圖片方法

沒想到python是如此強大,令人著迷,以前看見圖片總是一張一張複製粘貼,現在好了,學會python就可以用程序將一張張圖片,保存下來。以下這篇文章主要為大家介紹了利用Python3.6爬取搜狗圖片網頁中圖片的相關資料,需要的朋友可以參考下。

前言

最近幾天,研究了一下一直很好奇的爬蟲演算法。這裡寫一下最近幾天的點點心得。下面進入正文:

我們這裡以sogou作為爬取的物件。

首先我們進入搜狗圖片,進入壁紙分類(當然只是個例子Q_Q),因為如果需要爬取某網站資料,那麼就要初步的了解它…

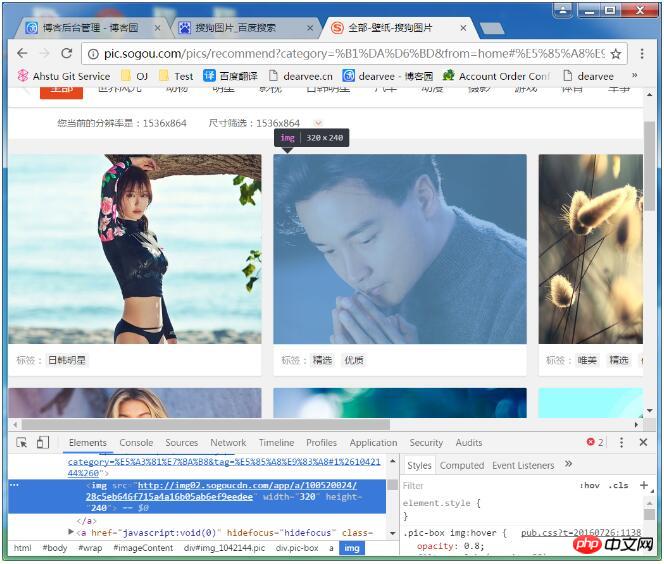

進去後就是這個啦,然後F12進入開發人員選項,筆者用的是Chrome。

右鍵圖片>>檢查

發現我們需要的圖片src是在img標籤下的,於是先試著用Python 的requests提取該元件,進而取得img的src然後使用urllib.request.urlretrieve逐一下載圖片,從而達到批量獲取資料的目的,思路好了,下面應該告訴程式要爬取的url為http://pic.sogou.com/ pics/recommend?category=%B1%DA%D6%BD,此url來自進入分類後的網址列。明白了url地址我們來開始愉快的程式碼時間:

在寫這段爬蟲程式的時候,最好要逐步調試,確保我們的每一步操作正確,這也是程式猿應該有的好習慣。筆者不知道自己算不算個程式猿哈。線面我們來剖析該url所指向的網頁。

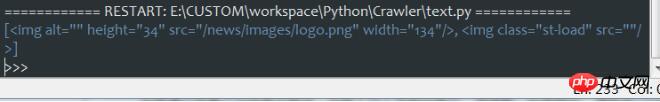

import requests import urllib from bs4 import BeautifulSoup res = requests.get('http://pic.sogou.com/pics/recommend?category=%B1%DA%D6%BD') soup = BeautifulSoup(res.text,'html.parser') print(soup.select('img'))

output:

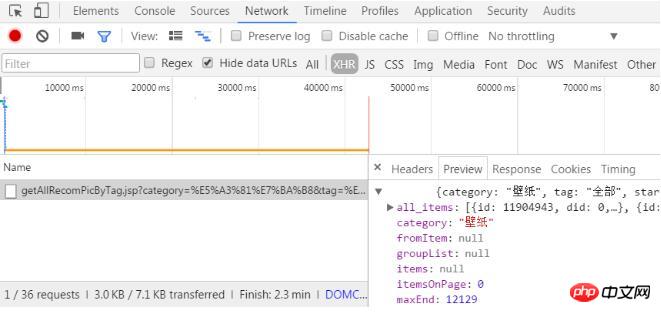

發現輸出內容並不包含我們要的圖片元素,而是只剖析到logo的img,這顯然不是我們想要的。也就是說需要的圖片資料不在url 即 http://pic.sogou.com/pics/recommend?category=%B1%DA%D6%BD裡面。因此考慮可能該元素是動態的,細心的同學可能會發現,當在網頁內,向下滑動滑鼠滾輪,圖片是動態刷新出來的,也就是說,該網頁並不是一次加載出全部資源,而是動態載入資源。這也避免了因為網頁過於臃腫,而影響載入速度。下面痛苦的探索開始了,我們是要找到所有圖片的真正的url 筆者也是剛剛接觸,找這個不是太有經驗。最後找的位置F12>>Network>>XHR>>(點擊XHR下的文件)>>Preview。

發現,有點接近我們需要的元素了,點開all_items 發現下面是0 1 2 3...一個一個的貌似是圖片元素。試著打開一個url。發現真的是圖片的地址。找到目標之後。點選XHR下的Headers

得到第二行

Request URL:

http://pic.sogou.com/pics/channel/getAllRecomPicByTag.jsp?category= %E5%A3%81%E7%BA%B8&tag=%E5%85%A8%E9%83%A8&start=0&len=15&width=1536&height=864,試著去掉一些不必要的部分,技巧就是,刪除可能的部分之後,訪問不受影響。經筆者篩選。最後得到的url:http://pic.sogou.com/pics/channel/getAllRecomPicByTag.jsp?category=%E5%A3%81%E7%BA%B8&tag=%E5%85%A8%E9%83%A8&start =0&len=15 字面意思,知道category後面可能為分類。 start為開始下標,len為長度,也即圖片的數量。好了,開始愉快的程式碼時間:

開發環境為Win7 Python 3.6,運作的時候Python需要安裝requests,

Python3.6 安裝requests 應該CMD敲入:

pip install requests

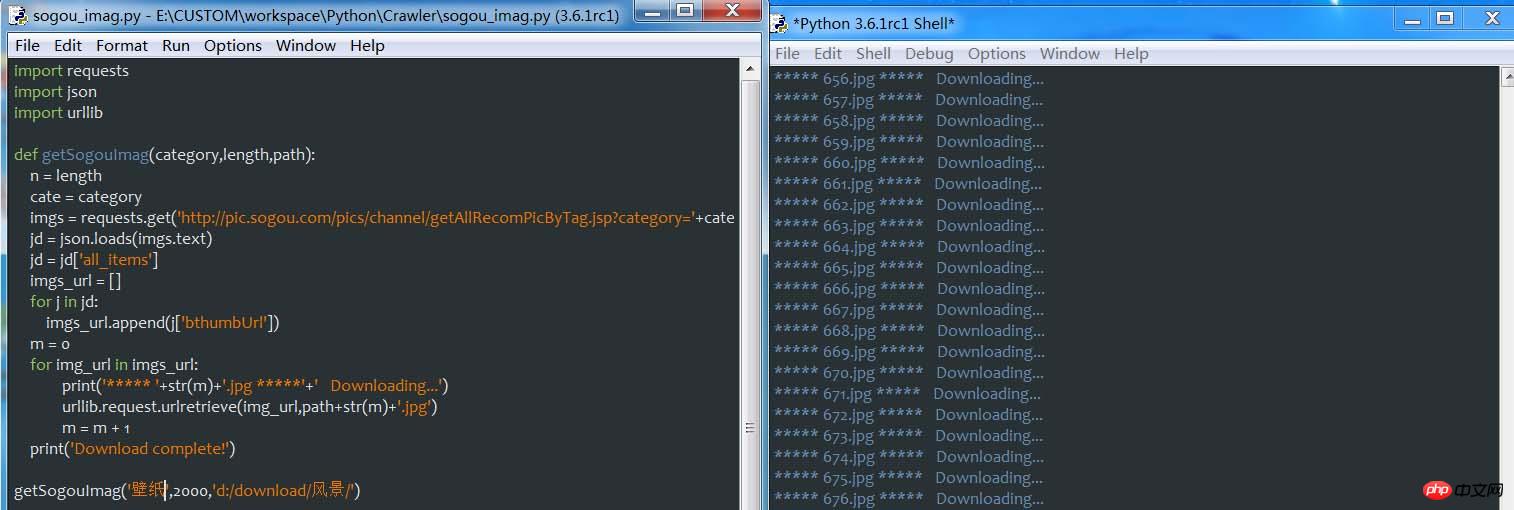

筆者在這裡也是邊調試邊寫,這裡把最終的程式碼貼出來:

import requests import json import urllib def getSogouImag(category,length,path): n = length cate = category imgs = requests.get('http://pic.sogou.com/pics/channel/getAllRecomPicByTag.jsp?category='+cate+'&tag=%E5%85%A8%E9%83%A8&start=0&len='+str(n)) jd = json.loads(imgs.text) jd = jd['all_items'] imgs_url = [] for j in jd: imgs_url.append(j['bthumbUrl']) m = 0 for img_url in imgs_url: print('***** '+str(m)+'.jpg *****'+' Downloading...') urllib.request.urlretrieve(img_url,path+str(m)+'.jpg') m = m + 1 print('Download complete!') getSogouImag('壁纸',2000,'d:/download/壁纸/')

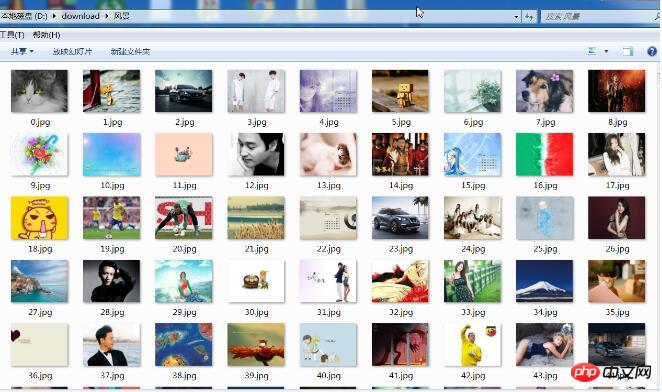

程式跑起來的時候,筆者還是有點小激動的。來,感受一下:

At this point, the description of the programming process of the crawler program is completed. Overall, finding the URL where the element needs to be crawled is the key in many aspects of the crawler

以上是詳解Python爬取網頁中的搜狗圖片方法的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

如何解決Linux終端中查看Python版本時遇到的權限問題?

Apr 01, 2025 pm 05:09 PM

如何解決Linux終端中查看Python版本時遇到的權限問題?

Apr 01, 2025 pm 05:09 PM

Linux終端中查看Python版本時遇到權限問題的解決方法當你在Linux終端中嘗試查看Python的版本時,輸入python...

如何在使用 Fiddler Everywhere 進行中間人讀取時避免被瀏覽器檢測到?

Apr 02, 2025 am 07:15 AM

如何在使用 Fiddler Everywhere 進行中間人讀取時避免被瀏覽器檢測到?

Apr 02, 2025 am 07:15 AM

使用FiddlerEverywhere進行中間人讀取時如何避免被檢測到當你使用FiddlerEverywhere...

在Python中如何高效地將一個DataFrame的整列複製到另一個結構不同的DataFrame中?

Apr 01, 2025 pm 11:15 PM

在Python中如何高效地將一個DataFrame的整列複製到另一個結構不同的DataFrame中?

Apr 01, 2025 pm 11:15 PM

在使用Python的pandas庫時,如何在兩個結構不同的DataFrame之間進行整列複製是一個常見的問題。假設我們有兩個Dat...

如何在10小時內通過項目和問題驅動的方式教計算機小白編程基礎?

Apr 02, 2025 am 07:18 AM

如何在10小時內通過項目和問題驅動的方式教計算機小白編程基礎?

Apr 02, 2025 am 07:18 AM

如何在10小時內教計算機小白編程基礎?如果你只有10個小時來教計算機小白一些編程知識,你會選擇教些什麼�...

Uvicorn是如何在沒有serve_forever()的情況下持續監聽HTTP請求的?

Apr 01, 2025 pm 10:51 PM

Uvicorn是如何在沒有serve_forever()的情況下持續監聽HTTP請求的?

Apr 01, 2025 pm 10:51 PM

Uvicorn是如何持續監聽HTTP請求的? Uvicorn是一個基於ASGI的輕量級Web服務器,其核心功能之一便是監聽HTTP請求並進�...

如何繞過Investing.com的反爬蟲機制獲取新聞數據?

Apr 02, 2025 am 07:03 AM

如何繞過Investing.com的反爬蟲機制獲取新聞數據?

Apr 02, 2025 am 07:03 AM

攻克Investing.com的反爬蟲策略許多人嘗試爬取Investing.com(https://cn.investing.com/news/latest-news)的新聞數據時,常常�...