python實作網路段子頁爬蟲案例

網路上的Python教學大都是2.X版本的,python2.X和python3.X相比較改動比較大,好多庫的用法不太一樣,我安裝的是python3.X,我們來看看詳細的例

0x01

春節閒著沒事(有多閒),就寫了個簡單的程序,來爬點笑話看,順帶記錄下寫程序的過程。第一次接觸爬蟲是看了這麼一個帖子,一個逗逼,爬取煎蛋網上妹子的照片,簡直不要太方便。於是乎就自己照貓畫虎,抓了點圖片。

科技啟迪未來,身為程式設計師,怎麼能幹這種事呢,還是爬點笑話比較有益於身心健康。

0x02

在我們擼起袖子開始搞之前,先來普及點理論知識。

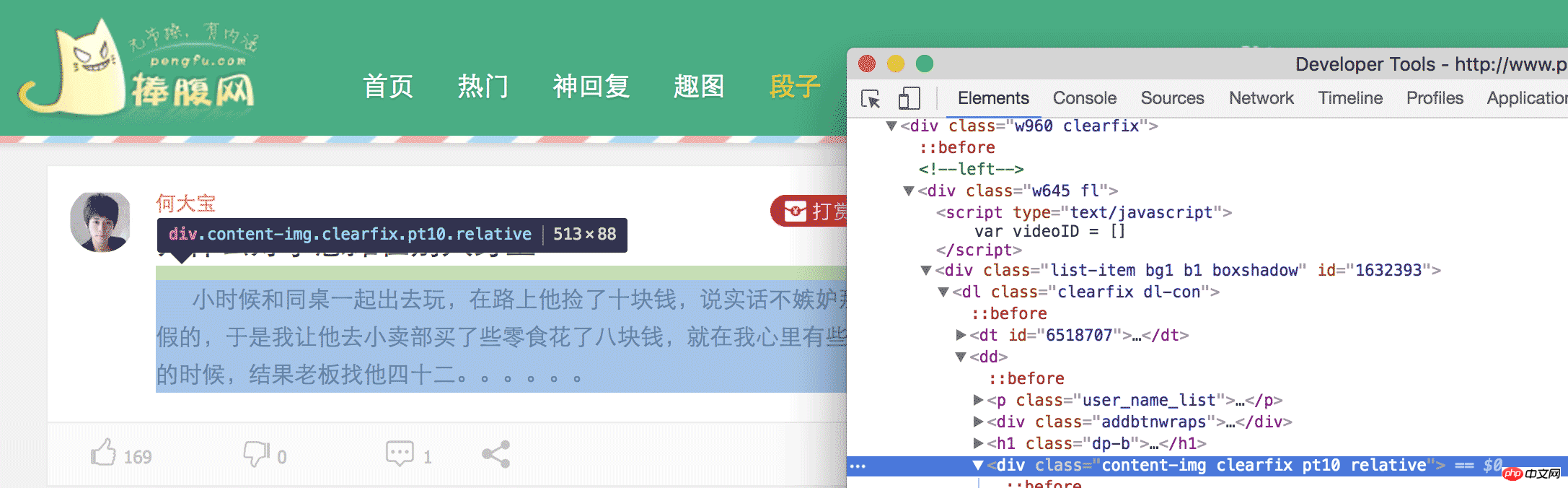

簡單地說,我們要把網頁上特定位置的內容,扒拉下來,具體怎麼扒拉,我們得先分析這個網頁,看那塊內容是我們需要的。例如,這次爬取的是捧腹網上的笑話,打開 捧腹網段子頁我們可以看到一大堆笑話,我們的目的就是獲取這些內容。看完回來冷靜一下,你這樣一直笑,我們沒辦法寫程式。在 chrome 中,我們打開 審查元素 然後一級一級的展開 HTML 標籤,或點擊那個小滑鼠,定位我們所需要的元素。

最後可以發現

中的內容就是我們所需要的笑話,在看第二個笑話,也是這樣。於是乎,我們就可以把這個網頁中所有的

找到,然後把裡邊的內容提取出來,就完成了。

0x03

好了,現在我們知道我們的目的了,就可以擼起袖子開始乾了。這裡我用的 python3,關於 python2 和 python3 的選用,大家可以自行決定,功能都可以實現,只是有些許不同。但還是建議用 python3。

我們要扒拉下我們需要的內容,首先我們得把這個網頁扒拉下來,怎麼扒拉呢,這裡我們要用到一個庫,叫 urllib,我們用這個庫提供的方法,來獲取整個網頁。

首先,我們匯入urllib

程式碼如下:

import urllib.request as request

然後,我們就可以使用request 來取得網頁了,

程式碼如下:

return request.urlopen(url).read()

人生苦短,我用python,一行程式碼,下載網頁,你說,還有什麼理由不用python。

下載完網頁後,我們就得解析這個網頁了來取得我們所需要的元素。為了解析元素,我們需要使用另一個工具,稱為 Beautiful Soup,使用它,可以快速解析 HTML 和 XML並取得我們所需的元素。

程式碼如下:

soup = BeautifulSoup(getHTML("http://www.pengfu.com/xiaohua_1.html"))用BeautifulSoup 來解析網頁也就一句話,但當你執行程式碼的時候,會出現這麼一個警告,提示要指定一個解析器,不然,可能會在其他平台或系統上報錯。

程式碼如下:

/Library/Frameworks/Python.framework/Versions/3.5/lib/python3.5/site-packages/bs4/init.py:181: UserWarning: No parser was explicitly specified, so I'm using the best available HTML parser for this system ("lxml"). This usually isn't a problem, but if you run this code on another system, or in a different virtual environment, it may use a different parser and behave differently.

The code that caused this warning is on line 64 of the file joke.py. To get rid of this warning, change code that looks like this:

BeautifulSoup([your markup])

to this:

BeautifulSoup([your markup], "lxml")

markup_type=markup_type))解析器的種類 和 不同解析器之間的差異 官方文件有詳細的說明,目前來說,還是用 lxml 解析比較可靠。

修改之後

程式碼如下:

soup = BeautifulSoup(getHTML("http://www.pengfu.com/xiaohua_1.html", 'lxml'))這樣,就沒有上述警告了。

程式碼如下:

p_array = soup.find_all('p', {'class':"content-img clearfix pt10 relative"})利用find_all 函數,來找出所有class = content-img clearfix pt10 relative 的p 標籤然後遍歷這個陣列

程式碼如下:

for x in p_array: content = x.string

這樣,我們就取到目的p 的內容了。至此,我們已經達到了我們的目的,爬到了我們的笑話。

但當以同樣的方式去爬取糗百的時候,會報這樣一個錯誤

程式碼如下:

raise RemoteDisconnected("Remote end closed connection without" http.client.RemoteDisconnected: Remote end closed connection without response说远端无响应,关闭了链接,看了下网络也没有问题,这是什么情况导致的呢?莫非是我姿势不对?

打开 charles 抓包,果然也没反应。唉,这就奇怪了,好好的一个网站,怎么浏览器可以访问,python 无法访问呢,是不是 UA 的问题呢?看了下 charles,发现,利用 urllib 发起的请求,UA 默认是 Python-urllib/3.5 而在 chrome 中访问 UA 则是 User-Agent:Mozilla/5.0 (Macintosh; Intel Mac OS X 10_12_3) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/56.0.2924.87 Safari/537.36,那会不会是因为服务器根据 UA 来判断拒绝了 python 爬虫。我们来伪装下试试看行不行

代码如下:

def getHTML(url):

head

ers = {'User-Agent': 'User-Agent:Mozilla/5.0 (Macintosh; Intel Mac OS X 10_12_3) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/56.0.2924.87 Safari/537.36'}

req = request.Request(url, headers=headers)

return request.urlopen(req).read()这样就把 python 伪装成 chrome 去获取糗百的网页,可以顺利的得到数据。

至此,利用 python 爬取糗百和捧腹网的笑话已经结束,我们只需要分析相应的网页,找到我们感兴趣的元素,利用 python 强大的功能,就可以达到我们的目的,不管是 XXOO 的图,还是内涵段子,都可以一键搞定,不说了,我去找点妹子图看看。

# -*- coding: utf-8 -*-

import sys

import urllib.request as request

from bs4 import BeautifulSoup

def getHTML(url):

headers = {'User-Agent': 'User-Agent:Mozilla/5.0 (Macintosh; Intel Mac OS X 10_12_3) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/56.0.2924.87 Safari/537.36'}

req = request.Request(url, headers=headers)

return request.urlopen(req).read()

def get_pengfu_results(url):

soup = BeautifulSoup(getHTML(url), 'lxml')

return soup.find_all('p', {'class':"content-img clearfix pt10 relative"})

def get_pengfu_joke():

for x in range(1, 2):

url = 'http://www.pengfu.com/xiaohua_%d.html' % x

for x in get_pengfu_results(url):

content = x.string

try:

string = content.lstrip()

print(string + '\n\n')

except:

continue

return

def get_qiubai_results(url):

soup = BeautifulSoup(getHTML(url), 'lxml')

contents = soup.find_all('p', {'class':'content'})

restlus = []

for x in contents:

str = x.find('span').getText('\n','<br/>')

restlus.append(str)

return restlus

def get_qiubai_joke():

for x in range(1, 2):

url = 'http://www.qiushibaike.com/8hr/page/%d/?s=4952526' % x

for x in get_qiubai_results(url):

print(x + '\n\n')

return

if name == 'main':

get_pengfu_joke()

get_qiubai_joke()【相关推荐】

1. Python免费视频教程

3. Python基础入门手册

以上是python實作網路段子頁爬蟲案例的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

PHP和Python:解釋了不同的範例

Apr 18, 2025 am 12:26 AM

PHP和Python:解釋了不同的範例

Apr 18, 2025 am 12:26 AM

PHP主要是過程式編程,但也支持面向對象編程(OOP);Python支持多種範式,包括OOP、函數式和過程式編程。 PHP適合web開發,Python適用於多種應用,如數據分析和機器學習。

在PHP和Python之間進行選擇:指南

Apr 18, 2025 am 12:24 AM

在PHP和Python之間進行選擇:指南

Apr 18, 2025 am 12:24 AM

PHP適合網頁開發和快速原型開發,Python適用於數據科學和機器學習。 1.PHP用於動態網頁開發,語法簡單,適合快速開發。 2.Python語法簡潔,適用於多領域,庫生態系統強大。

sublime怎麼運行代碼python

Apr 16, 2025 am 08:48 AM

sublime怎麼運行代碼python

Apr 16, 2025 am 08:48 AM

在 Sublime Text 中運行 Python 代碼,需先安裝 Python 插件,再創建 .py 文件並編寫代碼,最後按 Ctrl B 運行代碼,輸出會在控制台中顯示。

Python vs. JavaScript:學習曲線和易用性

Apr 16, 2025 am 12:12 AM

Python vs. JavaScript:學習曲線和易用性

Apr 16, 2025 am 12:12 AM

Python更適合初學者,學習曲線平緩,語法簡潔;JavaScript適合前端開發,學習曲線較陡,語法靈活。 1.Python語法直觀,適用於數據科學和後端開發。 2.JavaScript靈活,廣泛用於前端和服務器端編程。

PHP和Python:深入了解他們的歷史

Apr 18, 2025 am 12:25 AM

PHP和Python:深入了解他們的歷史

Apr 18, 2025 am 12:25 AM

PHP起源於1994年,由RasmusLerdorf開發,最初用於跟踪網站訪問者,逐漸演變為服務器端腳本語言,廣泛應用於網頁開發。 Python由GuidovanRossum於1980年代末開發,1991年首次發布,強調代碼可讀性和簡潔性,適用於科學計算、數據分析等領域。

Golang vs. Python:性能和可伸縮性

Apr 19, 2025 am 12:18 AM

Golang vs. Python:性能和可伸縮性

Apr 19, 2025 am 12:18 AM

Golang在性能和可擴展性方面優於Python。 1)Golang的編譯型特性和高效並發模型使其在高並發場景下表現出色。 2)Python作為解釋型語言,執行速度較慢,但通過工具如Cython可優化性能。

vscode在哪寫代碼

Apr 15, 2025 pm 09:54 PM

vscode在哪寫代碼

Apr 15, 2025 pm 09:54 PM

在 Visual Studio Code(VSCode)中編寫代碼簡單易行,只需安裝 VSCode、創建項目、選擇語言、創建文件、編寫代碼、保存並運行即可。 VSCode 的優點包括跨平台、免費開源、強大功能、擴展豐富,以及輕量快速。

notepad 怎麼運行python

Apr 16, 2025 pm 07:33 PM

notepad 怎麼運行python

Apr 16, 2025 pm 07:33 PM

在 Notepad 中運行 Python 代碼需要安裝 Python 可執行文件和 NppExec 插件。安裝 Python 並為其添加 PATH 後,在 NppExec 插件中配置命令為“python”、參數為“{CURRENT_DIRECTORY}{FILE_NAME}”,即可在 Notepad 中通過快捷鍵“F6”運行 Python 代碼。