scrapy爬蟲框架的介紹

介紹scrapy 爬蟲框架

安裝方法 pip install scrapy 就可以實作安裝了。我自己用anaconda 指令為conda install scrapy。

1 Engine從Spider處取得爬取請求(Request)<br>2Engine將爬取請求轉發給Scheduler,用於調度

3 Engine從Scheduler處獲得下一個要爬取的請求<br>4 Engine將爬取請求透過中間件發送給Downloader<br>5 爬取網頁後,Downloader形成回應(Response)透過中間件發給Engine<br>6 Engine將收到的回應透過中間件傳送給Spider處理Engine將爬取請求轉發給Scheduler,用於調度

7 Spider處理回應後產生爬取項目(scraped Item)<br>和新的爬取請求(Requests)給Engine<br>8 Engine將爬取項目發送給Item Pipeline(框架出口)<br>9 Engine將爬取請求發送給Scheduler

Engine控制各模組資料流,不間斷從Scheduler處<br>獲得爬取請求,直至請求為空<br>框架入口:Spider的初始爬取請求<br>框架出口:Item Pipeline

##

#Engine <br>(1) 控制所有模組之間的資料流(2) 依條件觸發事件<br><br>

##Downloader#Downloader ##根據請求下載網頁<br>不需要使用者修改<br>

Scheduler對所有爬取請求進行排程管理<br>不需要使用者修改<br>

#Downloader Middleware目的:實作Engine、Scheduler和Downloader<br>之間進行使用者可設定的控制<br>功能:修改、丟棄、新增請求或回應<br>使用者可以撰寫配置程式碼<br>

Spider(1) 解析Downloader回傳的回應(Response)<br>(2) 產生爬取項目(scraped item)<br>(3) 產生額外的爬取請求(Request)<br>需要使用者編寫設定碼<br>

Item Pipelines(1) 以管線方式處理Spider產生的爬取項目<br>( 2) 由一組操作順序組成,類似管線,每個操<br>作是一個Item Pipeline類型<br>(3) 可能操作包括:清理、檢驗和查重爬取項目中<br>的HTML數據、將資料儲存到資料庫<br>需要使用者編寫配置程式碼<br>

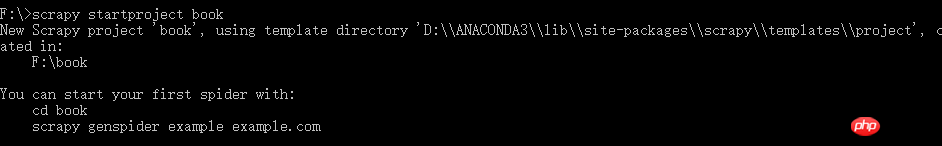

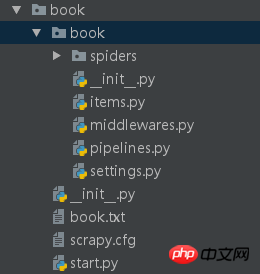

了解了基本概念之後我們開始寫第一個scrapy爬蟲吧。 首先要新建一個爬蟲計畫scrapy startproject xxx(計畫名稱)

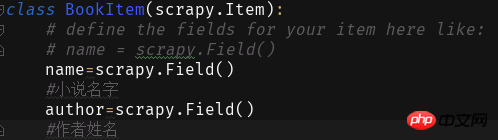

#接下來我們在items裡面填寫欄位:

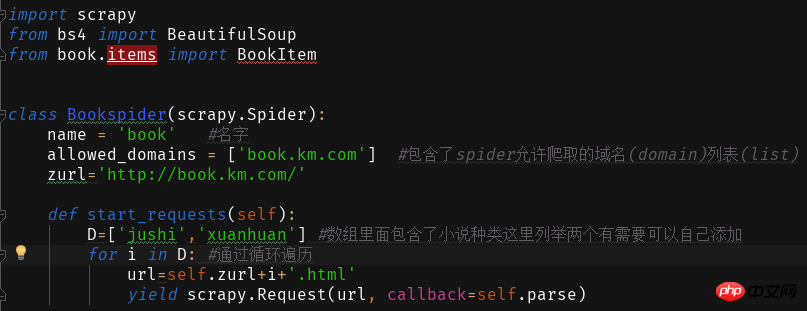

#然後在spider中建立爬蟲主程式book. py

我們要爬取的網站為

透過點擊網站不同種類小說會發現網站位址是+小說種類拼音.html

透過這個我們來寫讀取網頁的內容

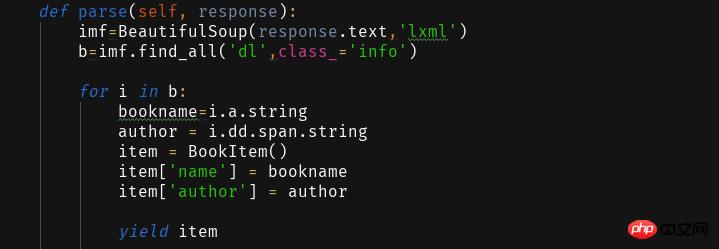

得到這個之後我們透過parse 函數來解析所取得的網頁並提取所需資訊。

網頁分析擷取資料是透過BeautifulSoup函式庫來的,這裡就略了。自己分析2333~

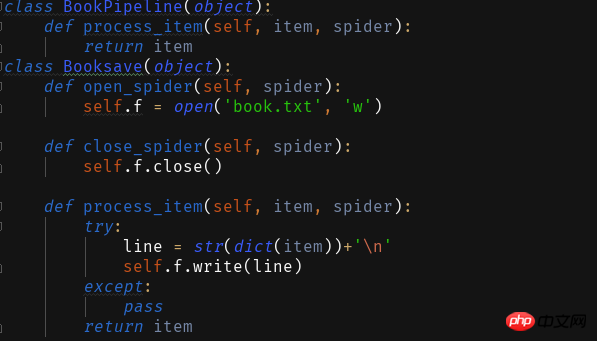

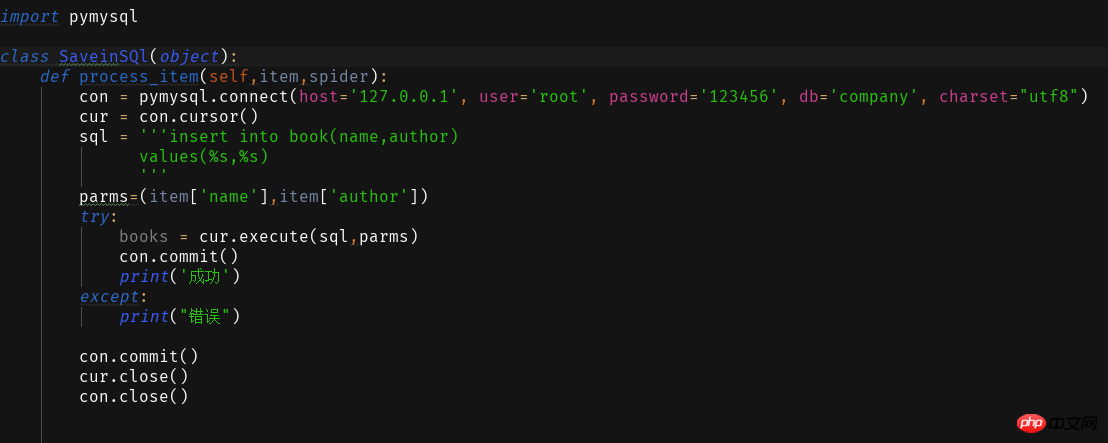

程式寫好我們要儲存所爬取的資訊就要編輯Pipelines.py 了

這裡提供兩個保存方式

1儲存為txt文字

2 存入資料庫

#要讓這個成功運行我們還需要在setting.py中設定

<span style="color: #000000">ITEM_PIPELINES = { 'book.pipelines.xxx': 300,}<br>xxx为存储方法的类名,想用什么方法存储就改成那个名字就好运行结果没什么看头就略了<br>第一个爬虫框架就这样啦期末忙没时间继续完善这个爬虫之后有时间将这个爬虫完善成把小说内容等一起爬下来的程序再来分享一波。<br>附一个book的完整代码:<br></span>import scrapyfrom bs4 import BeautifulSoupfrom book.items import BookItemclass Bookspider(scrapy.Spider):

name = 'book' #名字

allowed_domains = ['book.km.com'] #包含了spider允许爬取的域名(domain)列表(list)

zurl=''def start_requests(self):

D=['jushi','xuanhuan'] #数组里面包含了小说种类这里列举两个有需要可以自己添加for i in D: #通过循环遍历

url=self.zurl+i+'.html'yield scrapy.Request(url, callback=self.parse)

def parse(self, response):

imf=BeautifulSoup(response.text,'lxml')

b=imf.find_all('dl',class_='info')for i in b:

bookname=i.a.stringauthor = i.dd.span.stringitem = BookItem()

item['name'] = bookname

item['author'] = authoryield item<br>

以上是scrapy爬蟲框架的介紹的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

PHP和Python:解釋了不同的範例

Apr 18, 2025 am 12:26 AM

PHP和Python:解釋了不同的範例

Apr 18, 2025 am 12:26 AM

PHP主要是過程式編程,但也支持面向對象編程(OOP);Python支持多種範式,包括OOP、函數式和過程式編程。 PHP適合web開發,Python適用於多種應用,如數據分析和機器學習。

在PHP和Python之間進行選擇:指南

Apr 18, 2025 am 12:24 AM

在PHP和Python之間進行選擇:指南

Apr 18, 2025 am 12:24 AM

PHP適合網頁開發和快速原型開發,Python適用於數據科學和機器學習。 1.PHP用於動態網頁開發,語法簡單,適合快速開發。 2.Python語法簡潔,適用於多領域,庫生態系統強大。

sublime怎麼運行代碼python

Apr 16, 2025 am 08:48 AM

sublime怎麼運行代碼python

Apr 16, 2025 am 08:48 AM

在 Sublime Text 中運行 Python 代碼,需先安裝 Python 插件,再創建 .py 文件並編寫代碼,最後按 Ctrl B 運行代碼,輸出會在控制台中顯示。

PHP和Python:深入了解他們的歷史

Apr 18, 2025 am 12:25 AM

PHP和Python:深入了解他們的歷史

Apr 18, 2025 am 12:25 AM

PHP起源於1994年,由RasmusLerdorf開發,最初用於跟踪網站訪問者,逐漸演變為服務器端腳本語言,廣泛應用於網頁開發。 Python由GuidovanRossum於1980年代末開發,1991年首次發布,強調代碼可讀性和簡潔性,適用於科學計算、數據分析等領域。

Python vs. JavaScript:學習曲線和易用性

Apr 16, 2025 am 12:12 AM

Python vs. JavaScript:學習曲線和易用性

Apr 16, 2025 am 12:12 AM

Python更適合初學者,學習曲線平緩,語法簡潔;JavaScript適合前端開發,學習曲線較陡,語法靈活。 1.Python語法直觀,適用於數據科學和後端開發。 2.JavaScript靈活,廣泛用於前端和服務器端編程。

Golang vs. Python:性能和可伸縮性

Apr 19, 2025 am 12:18 AM

Golang vs. Python:性能和可伸縮性

Apr 19, 2025 am 12:18 AM

Golang在性能和可擴展性方面優於Python。 1)Golang的編譯型特性和高效並發模型使其在高並發場景下表現出色。 2)Python作為解釋型語言,執行速度較慢,但通過工具如Cython可優化性能。

vscode在哪寫代碼

Apr 15, 2025 pm 09:54 PM

vscode在哪寫代碼

Apr 15, 2025 pm 09:54 PM

在 Visual Studio Code(VSCode)中編寫代碼簡單易行,只需安裝 VSCode、創建項目、選擇語言、創建文件、編寫代碼、保存並運行即可。 VSCode 的優點包括跨平台、免費開源、強大功能、擴展豐富,以及輕量快速。

notepad 怎麼運行python

Apr 16, 2025 pm 07:33 PM

notepad 怎麼運行python

Apr 16, 2025 pm 07:33 PM

在 Notepad 中運行 Python 代碼需要安裝 Python 可執行文件和 NppExec 插件。安裝 Python 並為其添加 PATH 後,在 NppExec 插件中配置命令為“python”、參數為“{CURRENT_DIRECTORY}{FILE_NAME}”,即可在 Notepad 中通過快捷鍵“F6”運行 Python 代碼。