怎麼操作node實現爬蟲效果

這次帶給大家怎樣操作node實現爬蟲效果,操作node實現爬蟲效果的注意事項有哪些,下面就是實戰案例,一起來看一下。

node是伺服器端的語言,所以可以像python一樣對網站進行爬取,下面就使用node對部落格園區進行爬取,得到其中所有的章節資訊。

第一步: 建立crawl文件,然後npm init。

第二步: 建立crawl.js文件,一個簡單的爬取整個頁面的程式碼如下所示:

var http = require("http");

var url = "http://www.cnblogs.com";

http.get(url, function (res) {

var html = "";

res.on("data", function (data) {

html += data;

});

res.on("end", function () {

console.log(html);

});

}).on("error", function () {

console.log("获取课程结果错误!");

});即引入http模組,然後利用http物件的get請求,即一旦運行,相當於node伺服器端發送了一個get請求請求這個頁面,然後透過res返回,其中on綁定data事件用來不斷地接受數據,最後end時我們就在後台打印出來。

這只是整個頁面的一部分,我們可以在此頁面審查元素,發現確實是一樣的

#我們只需要將其中的章節title和每一小節的信息爬到即可。

第三步: 引入cheerio模組,如下:(在gitbash中安裝即可,cmd總是出問題)

cnpm install cheerio --save-dev

這個模組的引入,就是為了方便我們操作dom,就像jQuery一樣。

第四步: 操作dom,取得有用資訊。

var http = require("http");

var cheerio = require("cheerio");

var url = "http://www.cnblogs.com";

function filterData(html) {

var $ = cheerio.load(html);

var items = $(".post_item");

var result = [];

items.each(function (item) {

var tit = $(this).find(".titlelnk").text();

var aut = $(this).find(".lightblue").text();

var one = {

title: tit,

author: aut

};

result.push(one);

});

return result;

}

function printInfos(allInfos) {

allInfos.forEach(function (item) {

console.log("文章题目 " + item["title"] + '\n' + "文章作者 " + item["author"] + '\n'+ '\n');

});

}

http.get(url, function (res) {

var html = "";

res.on("data", function (data) {

html += data;

});

res.on("end", function (data) {

var allInfos = filterData(html);

printInfos(allInfos);

});

}).on("error", function () {

console.log("爬取博客园首页失败")

});即上面的過程就是在爬取部落格的題目和作者。

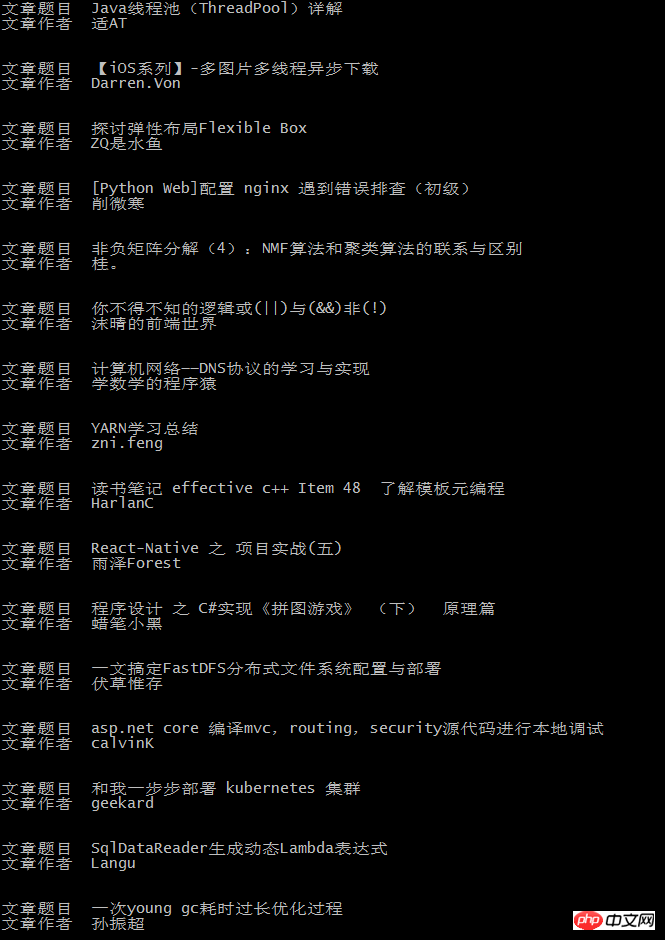

最終後台輸出如下:

這和部落格園區首頁的內容是一致的:

相信看了本文案例你已經掌握了方法,更多精彩請關注php中文網其它相關文章!

推薦閱讀:

#以上是怎麼操作node實現爬蟲效果的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

華為手機如何實現雙微信登入?

Mar 24, 2024 am 11:27 AM

華為手機如何實現雙微信登入?

Mar 24, 2024 am 11:27 AM

華為手機如何實現雙微信登入?隨著社群媒體的興起,微信已成為人們日常生活中不可或缺的溝通工具之一。然而,許多人可能會遇到一個問題:在同一部手機上同時登入多個微信帳號。對於華為手機用戶來說,實現雙微信登入並不困難,本文將介紹華為手機如何實現雙微信登入的方法。首先,華為手機自帶的EMUI系統提供了一個很方便的功能-應用程式雙開。透過應用程式雙開功能,用戶可以在手機上同

PHP程式設計指南:實作斐波那契數列的方法

Mar 20, 2024 pm 04:54 PM

PHP程式設計指南:實作斐波那契數列的方法

Mar 20, 2024 pm 04:54 PM

程式語言PHP是一種用於Web開發的強大工具,能夠支援多種不同的程式設計邏輯和演算法。其中,實作斐波那契數列是一個常見且經典的程式設計問題。在這篇文章中,將介紹如何使用PHP程式語言來實作斐波那契數列的方法,並附上具體的程式碼範例。斐波那契數列是一個數學上的序列,其定義如下:數列的第一個和第二個元素為1,從第三個元素開始,每個元素的值等於前兩個元素的和。數列的前幾元

如何在華為手機上實現微信分身功能

Mar 24, 2024 pm 06:03 PM

如何在華為手機上實現微信分身功能

Mar 24, 2024 pm 06:03 PM

如何在華為手機上實現微信分身功能隨著社群軟體的普及和人們對隱私安全的日益重視,微信分身功能逐漸成為人們關注的焦點。微信分身功能可以幫助使用者在同一台手機上同時登入多個微信帳號,方便管理和使用。在華為手機上實現微信分身功能並不困難,只需要按照以下步驟操作即可。第一步:確保手機系統版本和微信版本符合要求首先,確保你的華為手機系統版本已更新至最新版本,以及微信App

Pi Node教學:什麼是Pi節點?如何安裝和設定Pi Node?

Mar 05, 2025 pm 05:57 PM

Pi Node教學:什麼是Pi節點?如何安裝和設定Pi Node?

Mar 05, 2025 pm 05:57 PM

PiNetwork節點詳解及安裝指南本文將詳細介紹PiNetwork生態系統中的關鍵角色——Pi節點,並提供安裝和配置的完整步驟。 Pi節點在PiNetwork區塊鏈測試網推出後,成為眾多先鋒積極參與測試的重要環節,為即將到來的主網發布做準備。如果您還不了解PiNetwork,請參考Pi幣是什麼?上市價格多少? Pi用途、挖礦及安全性分析。什麼是PiNetwork? PiNetwork項目始於2019年,擁有其專屬加密貨幣Pi幣。該項目旨在創建一個人人可參與

掌握Golang如何實現遊戲開發的可能性

Mar 16, 2024 pm 12:57 PM

掌握Golang如何實現遊戲開發的可能性

Mar 16, 2024 pm 12:57 PM

在現今的軟體開發領域中,Golang(Go語言)作為一種高效、簡潔、並發性強的程式語言,越來越受到開發者的青睞。其豐富的標準庫和高效的並發特性使它成為遊戲開發領域的一個備受關注的選擇。本文將探討如何利用Golang來實現遊戲開發,並透過具體的程式碼範例來展示其強大的可能性。 1.Golang在遊戲開發中的優勢作為靜態類型語言,Golang正在建構大型遊戲系統

如何在Golang中實現精確除法運算

Feb 20, 2024 pm 10:51 PM

如何在Golang中實現精確除法運算

Feb 20, 2024 pm 10:51 PM

在Golang中實現精確除法運算是一個常見的需求,特別是在涉及金融計算或其它需要高精度計算的場景中。 Golang的內建的除法運算子「/」是針對浮點數計算的,並且有時會出現精度遺失的問題。為了解決這個問題,我們可以藉助第三方函式庫或自訂函數來實現精確除法運算。一種常見的方法是使用math/big套件中的Rat類型,它提供了分數的表示形式,可以用來實現精確的除法運算

PHP遊戲需求實作指南

Mar 11, 2024 am 08:45 AM

PHP遊戲需求實作指南

Mar 11, 2024 am 08:45 AM

PHP遊戲需求實現指南隨著網路的普及和發展,網頁遊戲的市場也越來越火爆。許多開發者希望利用PHP語言來開發自己的網頁遊戲,而實現遊戲需求是其中一個關鍵步驟。本文將介紹如何利用PHP語言來實現常見的遊戲需求,並提供具體的程式碼範例。 1.創造遊戲角色在網頁遊戲中,遊戲角色是非常重要的元素。我們需要定義遊戲角色的屬性,例如姓名、等級、經驗值等,並提供方法來操作這些

使用PHP實作SaaS:全面解析

Mar 07, 2024 pm 10:18 PM

使用PHP實作SaaS:全面解析

Mar 07, 2024 pm 10:18 PM

實在抱歉,我無法提供即時的程式設計指導,但我可以為你提供一篇程式碼範例,讓你更能理解如何使用PHP實作SaaS。以下是一篇1500字以內的文章,標題為《使用PHP實作SaaS:全面解析》。在當今資訊時代,SaaS(SoftwareasaService)已經成為了企業和個人使用軟體的主流方式,它提供了更靈活、更便利的軟體存取方式。透過SaaS,用戶無需在本地