這篇文章帶給大家的內容是關於PHP中的SAPI是什麼?如何實現? (圖文),有一定的參考價值,有需要的朋友可以參考一下,希望對你有幫助。

在Thread和Process中,應優選Process,因為Process更穩定,而且,Process可以分佈在多台機器上,而Thread最多只能分佈在同一台機器的多個CPU上。

Python的 multiprocessing 模組不但支援多進程, 其中 managers 子模組也支援把多進程分佈到多台機器上。一個服務進程可以作為調度者,將任務分佈到其他多個進程中,並依靠網路通訊。由於managers模組封裝很好,不必了解網路通訊的細節,就可以輕鬆地編寫分散式多進程程式。

透過managers模組把Queue透過網路暴露出去,就可以讓其他機器的進程存取Queue了。先看服務進程,服務進程負責啟動Queue,把Queue註冊到網路上,然後往Queue裡面寫入任務。

BaseManager: 提供了不同機器進程之間共享資料的一種方法;

(重要的点: ip:port)

# task_master.py

import random

from multiprocessing import freeze_support

from queue import Queue

from multiprocessing.managers import BaseManager

# 1. 创建需要的队列

# task_queue:发送任务的队列

# coding=utf-8

import random,time

from queue import Queue

from multiprocessing.managers import BaseManager

from multiprocessing import freeze_support

task_queue = Queue() # 发送任务的队列:

result_queue = Queue() # 接收结果的队列:

class QueueManager(BaseManager): # 从BaseManager继承的QueueManager:

pass

# windows下运行

def return_task_queue():

global task_queue

return task_queue # 返回发送任务队列

def return_result_queue ():

global result_queue

return result_queue # 返回接收结果队列

def test():

# 把两个Queue都注册到网络上, callable参数关联了Queue对象,它们用来进行进程间通信,交换对象

#QueueManager.register('get_task_queue', callable=lambda: task_queue)

#QueueManager.register('get_result_queue', callable=lambda: result_queue)

QueueManager.register('get_task_queue', callable=return_task_queue)

QueueManager.register('get_result_queue', callable=return_result_queue)

# 绑定端口4000, 设置验证码'sheenstar':

#manager = QueueManager(address=('', 4000), authkey=b'sheenstar')

# windows需要写ip地址

manager = QueueManager(address=('192.168.1.160', 4000), authkey=b'sheenstar')

manager.start() # 启动Queue:

# 获得通过网络访问的Queue对象:

task = manager.get_task_queue()

result = manager.get_result_queue()

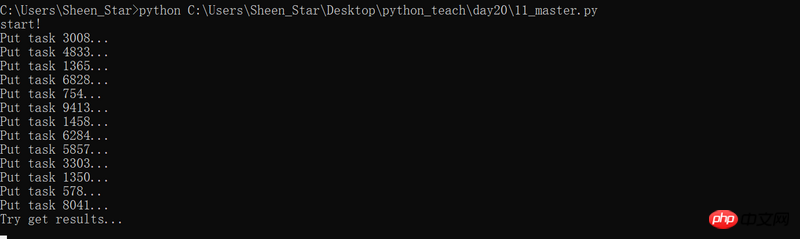

for i in range(13): # 放几个任务进去:

n = random.randint(0, 10000)

print('Put task %d...' % n)

task.put(n)

# 从result队列读取结果:

print('Try get results...')

for i in range(13):

r = result.get(timeout=10)

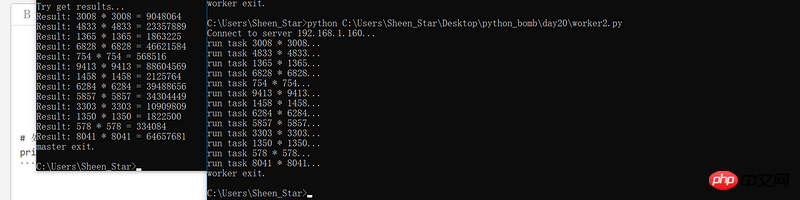

print('Result: %s' % r)

# 关闭:

manager.shutdown()

print('master exit.')

if __name__=='__main__':

freeze_support()

print('start!')

test()運行程序,會等待執行結果10s,如果沒有worker端獲取任務,返回結果,程序將報錯誤。

當我們在一台機器上寫多進程程式時,建立的Queue 可以直接拿來用,但是,在分散式多進程環境下,新增任務到Queue不可以直接對原始的task_queue 進行操作,那樣就繞過了QueueManager 的封裝,必須透過manager.get_task_queue()取得的Queue 介面新增。

# coding=utf-8

import time, sys

from queue import Queue

from multiprocessing.managers import BaseManager

# 创建类似的QueueManager:

class QueueManager(BaseManager):

pass

# 由于这个QueueManager只从网络上获取Queue,所以注册时只提供名字:

QueueManager.register('get_task_queue')

QueueManager.register('get_result_queue')

# 连接到服务器,也就是运行task_master.py的机器:

server_addr = '192.168.1.160'

print('Connect to server %s...' % server_addr)

# 端口和验证码注意保持与task_master.py设置的完全一致:

m = QueueManager(address=(server_addr, 4000), authkey=b'sheenstar')

# 从网络连接:

try:

m.connect()

except:

print('请先启动task_master.py!')

#sys.exit("sorry, goodbye!");

# 获取Queue的对象:

task = m.get_task_queue()

result = m.get_result_queue()

# 从task队列取任务,并把结果写入result队列:

for i in range(13):

try:

n = task.get()

print('run task %d * %d...' % (n, n))

r = '%d * %d = %d' % (n, n, n*n)

time.sleep(1)

result.put(r)

except ConnectionResetError as e:

print("任务执行结束,自动断开连接")

# 处理结束:

print('worker exit.')使用命令列執行程序,結果更直覺

以上是python中分散式進程的詳細介紹(附範例)的詳細內容。更多資訊請關注PHP中文網其他相關文章!