證件照轉數位人只需幾秒鐘,微軟實現首個3D擴散模型高品質生成效果,換裝改形像一句話搞定

這個3D生成擴散模型「羅丹」RODIN的名字,靈感來自法國雕塑藝術家奧古斯特·羅丹(Auguste Rodin)。

一張2D證件照,幾秒鐘就能設計出3D遊戲化身!

這是擴散模型在3D領域的最新成果。例如,只需一張法國雕塑家羅丹的舊照,就能分分鐘把他「變」進遊戲中:

△RODIN模型基於羅丹舊照生成的3D形象

甚至只需要一句話就能修改裝扮和形象。告訴AI生成羅丹「穿著紅色毛衣戴眼鏡的造型」:

不喜歡大背頭?那就換成「綁著辮子的造型」:

再試試換髮色?這是“棕色頭髮的時尚潮人造型”,連鬍子顏色都搞定了:

#(AI眼中的“時尚潮人”,確實有點潮過頭了)

上面這個最新的3D生成擴散模型「羅丹」RODIN(Roll-out Diffusion Network),來自微軟亞洲研究院。

RODIN也是第一個利用生成擴散模型在3D訓練資料上自動產生3D數位化身(Avatar)的模型,論文目前已被CVPR 2023接收。

一起來看看。

直接用3D資料訓練擴散模型

這個3D生成擴散模型「羅丹」RODIN的名字,靈感來自法國雕塑藝術家奧古斯特·羅丹(Auguste Rodin)。

先前2D生成3D影像模型,通常用2D資料訓練生成對抗網路(GAN)或變分自編碼器(VAE)得到,但結果往往不盡人意。

研究者分析,造成這種現象的原因在於這些方法存在一個基礎的欠定(ill posed)問題。即由於單一視角圖片存在幾何二義性,僅透過大量的2D數據,很難學到高品質3D化身的合理分佈,導致生成效果不佳。

因此,他們這次嘗試直接用3D資料來訓練擴散模型,主要解決了三個難題:

- 首先,如何用擴散模型生成3D模型多視角圖。先前擴散模型在3D資料上沒有可參考實務方法和可遵循前例。

- 其次,高品質和大規模3D圖像資料集很難獲取,且存在隱私版權風險,但網路公開3D圖像無法保證多視圖一致性。

- 最後, 2D擴散模型直接拓展成3D生成,所需的記憶體、儲存與計算開銷極大。

為了解決這三個難題,研究人員提出了「AI雕塑家」RODIN擴散模型,超越了現有模型的SOTA水準。

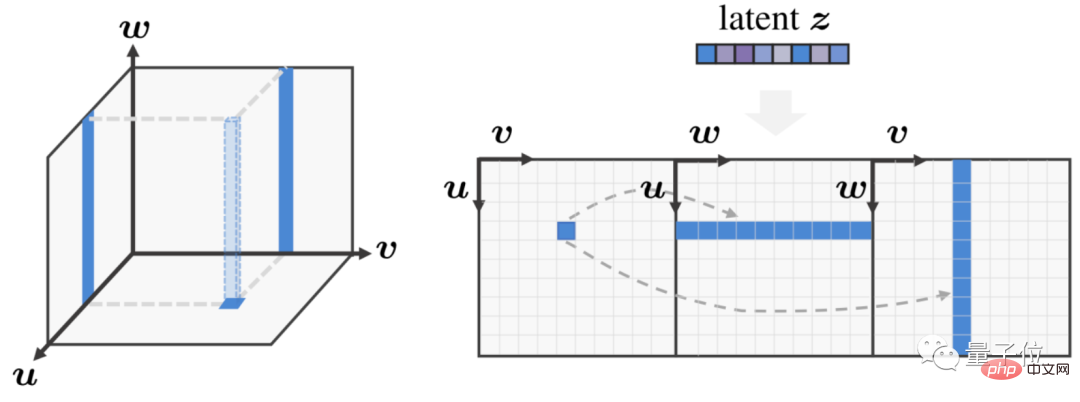

RODIN模型採用神經輻射場(NeRF)方法,借鑒英偉達的EG3D工作,將3D空間緊湊地表達為空間三個相互垂直的特徵平面(Triplane),並將這些圖展開至單一2D特徵平面中,再執行3D感知擴散。

具體而言,就是將3D空間在橫、縱、垂三個正交平面視圖上以二維特徵展開,這樣不僅可以讓RODIN模型使用高效的2D架構進行3D感知擴散,而且將3D影像降維成2D影像也大幅降低了運算複雜度和運算成本。

△3D感知卷積高效處理3D特徵

上圖左邊,用三平面(triplane)表達3D空間,此時底部特徵平面的特徵點對應於另外兩個特徵平面的兩條線;上圖右邊,則引入3D感知卷積處理展開的2D特徵平面,同時考慮到三個平面的三維固有對應關係。

具體而言,實現3D影像的產生需要三個關鍵要素:

其一,3D感知卷積,確保降維後的三個平面的內在關聯。

傳統2D擴散中使用的2D卷積神經網路(CNN),並不能很好地處理Triplane特徵圖。

3D感知卷積並不是簡單地產生三個2D特徵平面,而是在處理這樣的3D表達時,考慮了其固有的三維特性,即三個視圖平面中其中一個視圖的2D特徵本質上是3D空間中一條直線的投影,因此與其他兩個平面中對應的直線投影特徵存在關聯性。

為了實現跨平面通信,研究員們在卷積中考慮了這樣的3D相關性,因此高效地用2D的方式合成3D細節。

其二,隱空間協奏三平面3D表達生成。

研究員們透過隱向量來協調特徵生成,使其在整個三維空間中具有全局一致性,從而獲得更高品質的化身並實現語義編輯。

同時,也透過使用訓練資料集中的圖像訓練額外的圖像編碼器,該編碼器可提取語義隱向量作為擴散模型的條件輸入。

這樣,整體的生成網路可視為自動編碼器,以擴散模型作為解碼隱空間向量。對於語意可編輯性,研究員們採用了一個凍結的CLIP圖像編碼器,與文字提示共享隱空間。

其三,層級式合成,產生高保真立體細節。

研究員們利用擴散模型,先生成了一個低解析度的三視圖平面(64×64),然後再透過擴散上取樣產生高解析度的三平面(256×256) 。

這樣,基礎擴散模型集中於整體3D結構生成,而後續上取樣模型則專注於細節生成。

基於Blender產生大量隨機資料

在訓練資料集上,研究員們借助開源的三維渲染軟體Blender,透過隨機組合畫師手動創建的虛擬3D人物圖像,再加上從大量頭髮、衣服、表情和配件中隨機採樣,進而創建了10萬個合成個體,同時為每個個體渲染出了300個分辨率為256*256的多視圖圖像。

在文字到3D頭像的生成上,研究員們採用了LAION-400M資料集的人像子集,訓練從輸入模態到3D擴散模型隱空間的映射,最終讓RODIN模型只使用一張2D影像或一句文字描述,就能創造出逼真的3D頭像。

△給定一張照片產生虛擬形象

#不僅能一句話改變形象,如「留捲髮和大鬍子穿著黑色皮夾克的男性」:

甚至連性別都能隨意更換,「紅色衣著非洲髮型的女性」:(手動狗頭)

研究人員也給了一個應用程式Demo示範,創建自己的圖像只需要幾個按鈕:

△利用文字做3D肖像編輯

更多效果可以戳項目地址查看~

△更多隨機生成的虛擬形象

做出了RODIN後,團隊接下來的計劃是?

根據微軟亞洲研究院作者們表示,目前RODIN的作品還主要停留在3D半身人像上,這也與它主要採用人臉數據訓練有關,但3D圖像生成需求不僅限於人臉上。

下一步,團隊將會考慮嘗試用RODIN模型創建更多3D場景,包括花草樹木、建築、汽車家居等,實現「一個模型生成3D萬物」的終極目標。

論文網址:

https://arxiv.org/abs/2212.06135

專案頁:

https://3d-avatar-diffusion.microsoft.com

以上是證件照轉數位人只需幾秒鐘,微軟實現首個3D擴散模型高品質生成效果,換裝改形像一句話搞定的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

全球最強開源 MoE 模型來了,中文能力比肩 GPT-4,價格僅 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

全球最強開源 MoE 模型來了,中文能力比肩 GPT-4,價格僅 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

想像一下,一個人工智慧模型,不僅擁有超越傳統運算的能力,還能以更低的成本實現更有效率的效能。這不是科幻,DeepSeek-V2[1],全球最強開源MoE模型來了。 DeepSeek-V2是一個強大的專家混合(MoE)語言模型,具有訓練經濟、推理高效的特點。它由236B個參數組成,其中21B個參數用於啟動每個標記。與DeepSeek67B相比,DeepSeek-V2效能更強,同時節省了42.5%的訓練成本,減少了93.3%的KV緩存,最大生成吞吐量提高到5.76倍。 DeepSeek是一家探索通用人工智

你好,電動Atlas!波士頓動力機器人復活,180度詭異動作嚇到馬斯克

Apr 18, 2024 pm 07:58 PM

你好,電動Atlas!波士頓動力機器人復活,180度詭異動作嚇到馬斯克

Apr 18, 2024 pm 07:58 PM

波士頓動力Atlas,正式進入電動機器人時代!昨天,液壓Atlas剛「含淚」退出歷史舞台,今天波士頓動力就宣布:電動Atlas上崗。看來,在商用人形機器人領域,波士頓動力是下定決心要跟特斯拉硬剛一把了。新影片放出後,短短十幾小時內,就已經有一百多萬觀看。舊人離去,新角色登場,這是歷史的必然。毫無疑問,今年是人形機器人的爆發年。網友銳評:機器人的進步,讓今年看起來像人類的開幕式動作、自由度遠超人類,但這真不是恐怖片?影片一開始,Atlas平靜地躺在地上,看起來應該是仰面朝天。接下來,讓人驚掉下巴

替代MLP的KAN,被開源專案擴展到卷積了

Jun 01, 2024 pm 10:03 PM

替代MLP的KAN,被開源專案擴展到卷積了

Jun 01, 2024 pm 10:03 PM

本月初,來自MIT等機構的研究者提出了一種非常有潛力的MLP替代方法—KAN。 KAN在準確性和可解釋性方面表現優於MLP。而且它能以非常少的參數量勝過以更大參數量運行的MLP。例如,作者表示,他們用KAN以更小的網路和更高的自動化程度重現了DeepMind的結果。具體來說,DeepMind的MLP有大約300,000個參數,而KAN只有約200個參數。 KAN與MLP一樣具有強大的數學基礎,MLP基於通用逼近定理,而KAN基於Kolmogorov-Arnold表示定理。如下圖所示,KAN在邊上具

特斯拉機器人進廠打工,馬斯克:手的自由度今年將達到22個!

May 06, 2024 pm 04:13 PM

特斯拉機器人進廠打工,馬斯克:手的自由度今年將達到22個!

May 06, 2024 pm 04:13 PM

特斯拉機器人Optimus最新影片出爐,已經可以在工廠裡打工了。正常速度下,它分揀電池(特斯拉的4680電池)是這樣的:官方還放出了20倍速下的樣子——在小小的「工位」上,揀啊揀啊揀:這次放出的影片亮點之一在於Optimus在廠子裡完成這項工作,是完全自主的,全程沒有人為的干預。而且在Optimus的視角之下,它還可以把放歪了的電池重新撿起來放置,主打一個自動糾錯:對於Optimus的手,英偉達科學家JimFan給出了高度的評價:Optimus的手是全球五指機器人裡最靈巧的之一。它的手不僅有觸覺

FisheyeDetNet:首個以魚眼相機為基礎的目標偵測演算法

Apr 26, 2024 am 11:37 AM

FisheyeDetNet:首個以魚眼相機為基礎的目標偵測演算法

Apr 26, 2024 am 11:37 AM

目標偵測在自動駕駛系統當中是一個比較成熟的問題,其中行人偵測是最早得以部署演算法之一。在多數論文當中已經進行了非常全面的研究。然而,利用魚眼相機進行環視的距離感知相對來說研究較少。由於徑向畸變大,標準的邊界框表示在魚眼相機當中很難實施。為了緩解上述描述,我們探索了擴展邊界框、橢圓、通用多邊形設計為極座標/角度表示,並定義一個實例分割mIOU度量來分析這些表示。所提出的具有多邊形形狀的模型fisheyeDetNet優於其他模型,並同時在用於自動駕駛的Valeo魚眼相機資料集上實現了49.5%的mAP

牛津大學最新! Mickey:3D中的2D影像匹配SOTA! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

牛津大學最新! Mickey:3D中的2D影像匹配SOTA! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

寫在前面項目連結:https://nianticlabs.github.io/mickey/給定兩張圖片,可以透過建立圖片之間的對應關係來估計它們之間的相機姿態。通常,這些對應關係是二維到二維的,而我們估計的姿態在尺度上是不確定的。一些應用,例如隨時隨地實現即時增強現實,需要尺度度量的姿態估計,因此它們依賴外部的深度估計器來恢復尺度。本文提出了MicKey,這是一個關鍵點匹配流程,能夠夠預測三維相機空間中的度量對應關係。透過學習跨影像的三維座標匹配,我們能夠在沒有深度測試的情況下推斷度量相對

全面超越DPO:陳丹琦團隊提出簡單偏好優化SimPO,也煉出最強8B開源模型

Jun 01, 2024 pm 04:41 PM

全面超越DPO:陳丹琦團隊提出簡單偏好優化SimPO,也煉出最強8B開源模型

Jun 01, 2024 pm 04:41 PM

為了將大型語言模型(LLM)與人類的價值和意圖對齊,學習人類回饋至關重要,這能確保它們是有用的、誠實的和無害的。在對齊LLM方面,一種有效的方法是根據人類回饋的強化學習(RLHF)。儘管RLHF方法的結果很出色,但其中涉及了一些優化難題。其中涉及訓練一個獎勵模型,然後優化一個策略模型來最大化該獎勵。近段時間已有一些研究者探索了更簡單的離線演算法,其中之一就是直接偏好優化(DPO)。 DPO是透過參數化RLHF中的獎勵函數來直接根據偏好資料學習策略模型,這樣就無需顯示式的獎勵模型了。此方法簡單穩定

單卡跑Llama 70B快過雙卡,微軟硬生把FP6搞到A100哩 | 開源

Apr 29, 2024 pm 04:55 PM

單卡跑Llama 70B快過雙卡,微軟硬生把FP6搞到A100哩 | 開源

Apr 29, 2024 pm 04:55 PM

FP8和更低的浮點數量化精度,不再是H100的「專利」了!老黃想讓大家用INT8/INT4,微軟DeepSpeed團隊在沒有英偉達官方支援的條件下,硬生在A100上跑起FP6。測試結果表明,新方法TC-FPx在A100上的FP6量化,速度接近甚至偶爾超過INT4,而且比後者擁有更高的精度。在此基礎之上,還有端到端的大模型支持,目前已經開源並整合到了DeepSpeed等深度學習推理框架中。這項成果對大模型的加速效果也是立竿見影──在這種框架下用單卡跑Llama,吞吐量比雙卡還要高2.65倍。一名