重新檢視Prompt最佳化問題,預測偏差讓語言模型情境學習更強

LLMs 在 In-context Learning 下取得了良好的表現,但是選取不同的範例會導致截然不同的表現。一項最新的研究工作從預測偏差 (predictive bias) 角度,提出了 prompt 搜尋策略,近似找到了最優的範例組合。

- 論文連結: https://arxiv.org/abs/2303.13217

- 程式碼連結: https://github.com/MaHuanAAA /g_fair_searching

研究介紹

大型語言模型在上下文學習中表現出了驚人的能力,這些模型可以透過幾個輸入輸出範例建立的上下文進行學習,而無需微調優化直接應用於許多下游任務。然而,先前的研究表明,由於訓練樣本 (training examples)、範例順序 (example order) 和提示格式 (prompt formats) 的變化,上下文學習可能會表現出高度的不穩定性。因此,建立適當的 prompt 對於提高上下文學習的表現至關重要。

先前的研究通常從兩個方向研究這個問題:(1)編碼空間中的提示調整 (prompt tuning),(2)在原始空間中進行搜尋 (prompt searching)。

Prompt tuning 的關鍵思想是將任務特定的 embedding 注入隱藏層,然後使用基於梯度的最佳化來調整這些 embeddings。然而,這些方法需要修改模型的原始推理過程並且獲得模型梯度,這在像 GPT-3 和 ChatGPT 這樣的黑盒 LLM 服務中是不切實際的。此外,提示調整會引入額外的運算和儲存成本,這對於 LLM 通常是昂貴的。

更可行且有效率的方法是透過在原始文字空間中搜尋近似的演示樣本和順序來最佳化提示。一些工作從 “Global view” 或 “Local view” 建立提示。基於 Global view 的方法通常會將提示的不同元素作為整體進行最佳化,以達到更優異的效能。例如,Diversity-guided [1] 的方法利用演示的整體多樣性的搜索,或試圖優化整個範例組合順序 [2],以實現更好的效能。與 Global view 相反,基於 Local view 的方法透過設計不同的啟發式選擇標準,例如 KATE [3]。

但這些方法都有各自的限制:(1)目前的大多數研究主要集中在沿著單一因素搜尋提示,例如範例選擇或順序。然而各個因素對性能的整體影響尚不清楚。 (2)這些方法通常是基於啟發式標準,需要一個統一的視角來解釋這些方法是如何運作的。 (3)更重要的是,現有的方法會全域或局部地最佳化提示,這可能會導致效能不理想。

本文從 「預測偏差」 的角度重新審視了 NLP 領域中的 prompt 最佳化問題,發現了一個關鍵現象:一個給定的 prompt 的品質取決於它的內在偏差。基於這個現象,文章提出了一個基於預測偏差的替代標準來評估 prompt 的質量,該度量方法能夠在不需要額外開發集 (development set) 的情況下通過單個前向過程來評估 prompt。

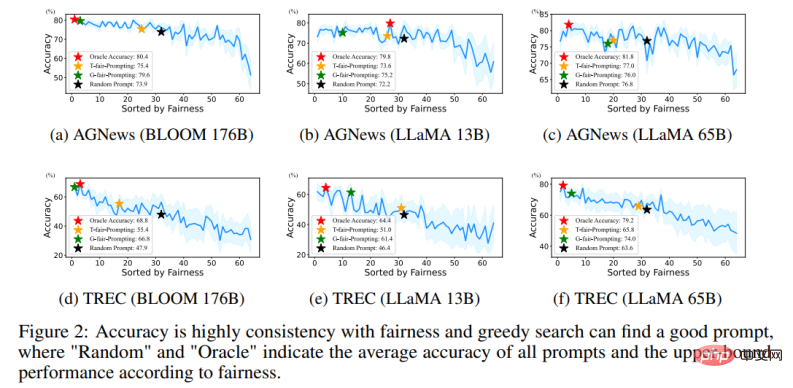

具體來說,透過在一個給定的prompt 下輸入一個「無內容」 的測試,期望模型輸出一個均勻的預測分佈(一個「無內容」 的輸入不包含任何有用的信息) 。因此,文中利用預測分佈的均勻性來表示給定 prompt 的預測偏差。這與先前的後校準方法 [4] 用的指標類似,但與後校準在固定的 prompt 情況下使用這個 metric 進行機率後校準不同的是,文中進一步探索了其在自動搜尋近似 prompt 中的應用。並且透過大量實驗證實了一個給定 prompt 的內在偏差和它在給定測試集上的平均任務表現之間的相關性。

此外,這種基於偏差的度量使該方法能夠以 “局部到全局” 的方式搜尋合適的 prompt。然而,一個現實的問題是無法透過遍歷所有組合的方式搜尋最優解,因為它的複雜度將超過 O (N!)。

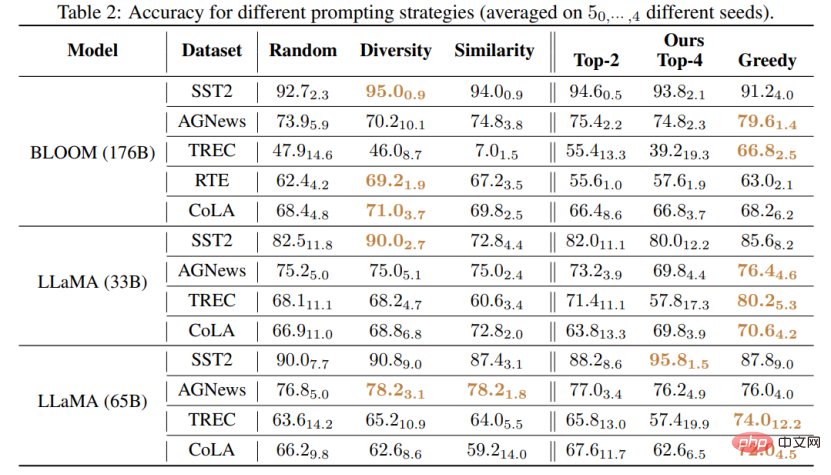

该工作提出了两种新颖的策略以高效的方式搜索高质量的 prompt:(1) T-fair-Prompting (2) G-fair-Prompting。T-fair-Prompting 使用一种直观的方式,首先计算每个示例单独组成 prompt 的偏差,然后选择 Top-k 个最公平示例组合成最终 prompt。这个策略相当高效,复杂度为 O (N)。但需要注意的是,T-fair-Prompting 基于这样的假设:最优的 prompt 通常是由偏差最小的示例构建的。然而,这在实际情况下可能并不成立,并且往往会导致局部最优解。因此,文章中进一步介绍了 G-fair-Prompting 来改善搜索质量。G-fair-Prompting 遵循贪心搜索的常规过程,通过在每个步骤上进行局部最优选择来找到最优解。在算法的每一步,所选择的示例都能使更新的 prompt 获得最佳的公平性,最坏情况时间复杂度为 O (N^2),搜索质量显著提高。G-fair-Prompting 从局部到全局的角度进行工作,其中在早期阶段考虑单个样本的偏差,而在后期阶段则侧重于减少全局预测偏差。

实验结果

该研究提出了一种有效和可解释的方法来提高语言模型的上下文学习性能,这种方法可以应用于各种下游任务。文章验证了这两种策略在各种 LLMs(包括 GPT 系列模型和最近发布的 LMaMA 系列)上的有效性,G-fair-Prompting 与 SOTA 方法相比,在不同的下游任务上获得了超过 10%的相对改进。

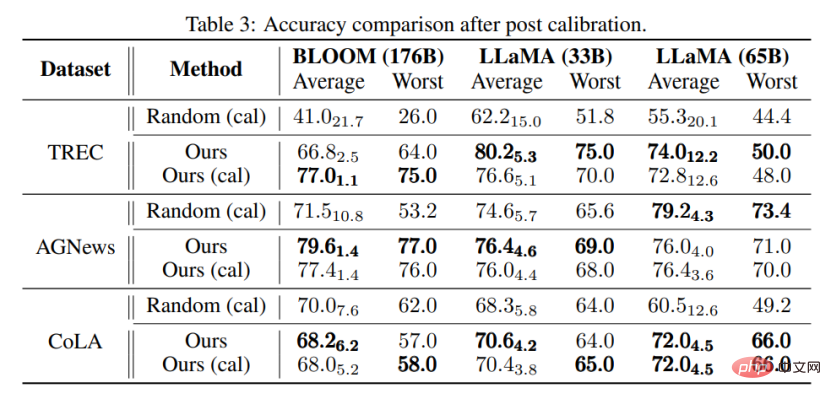

与该研究最相近的是 Calibration-before-use [4] 方法,两者都使用 “无内容” 的输入提高模型的表现。但是,Calibration-before-use 方法旨在使用该标准来校准输出,而该输出仍然容易受到所使用示例的质量的影响。与之相比,本文旨在搜索原始空间找到近似最优的 prompt,以提高模型的性能,而不需要对模型输出进行任何后处理。此外,该文首次通过大量实验验证了预测偏差与最终任务性能之间的联系,这在 Calibration-before-use 方法中尚未研究。

通过实验还能发现,即使不进行校准,该文章所提方法选择的 prompt 也可以优于经过校准的随机选择的 prompt。这表明该方法可以在实际应用中具有实用性和有效性,可以为未来的自然语言处理研究提供启示。

以上是重新檢視Prompt最佳化問題,預測偏差讓語言模型情境學習更強的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

深入探討模型、資料與架構:一份詳盡的54頁高效能大語言模型綜述

Jan 14, 2024 pm 07:48 PM

深入探討模型、資料與架構:一份詳盡的54頁高效能大語言模型綜述

Jan 14, 2024 pm 07:48 PM

大規模語言模型(LLMs)在許多重要任務中展現了引人注目的能力,包括自然語言理解、語言生成和複雜推理,並對社會產生了深遠的影響。然而,這些出色的能力卻需要大量的訓練資源(如左圖)和較長的推理時間(如右圖)。因此,研究人員需要開發有效的技術手段來解決它們的效率問題。此外,從圖的右邊還可以看出,一些高效率的LLMs(LanguageModels)如Mistral-7B,已經成功應用於LLMs的設計和部署中。這些高效的LLMs在保持與LLaMA1-33B相近的準確性的同時,能夠大大減少推理內存

碾壓H100,英偉達下一代GPU曝光!首個3nm多晶片模組設計,2024年亮相

Sep 30, 2023 pm 12:49 PM

碾壓H100,英偉達下一代GPU曝光!首個3nm多晶片模組設計,2024年亮相

Sep 30, 2023 pm 12:49 PM

3奈米製程,性能超越H100!最近,根據外媒DigiTimes爆料,英偉達正在開發下一代GPU,代號為「Blackwell」的B100據稱,作為面向人工智慧(AI)和高性能計算(HPC)應用的產品,B100將採用台積電的3nm工藝過程,以及更為複雜的多晶片模組(MCM)設計,並將於2024年第四季現身。對於壟斷了人工智慧GPU市場80%以上份額的英偉達來說,則可以藉著B100趁熱打鐵,在這波AI部署的熱潮中進一步狙擊AMD、英特爾等挑戰者。根據英偉達的估計,到2027年,該領域的產值預計將達到約

擴散+超解析度模型強強聯合,Google影像生成器Imagen背後的技術

Apr 10, 2023 am 10:21 AM

擴散+超解析度模型強強聯合,Google影像生成器Imagen背後的技術

Apr 10, 2023 am 10:21 AM

近年來,多模態學習受到重視,特別是文字 - 圖像合成和圖像 - 文字對比學習兩個方向。一些 AI 模型因在創意圖像生成、編輯方面的應用引起了公眾的廣泛關注,例如 OpenAI 先後推出的文本圖像模型 DALL・E 和 DALL-E 2,以及英偉達的 GauGAN 和 GauGAN2。谷歌也不甘落後,在 5 月底發布了自己的文字到圖像模型 Imagen,看起來進一步拓展了字幕條件(caption-conditional)圖像生成的邊界。僅僅給出一個場景的描述,Imagen 就能產生高品質、高解析度

多模態大模型最全綜述來了! 7位微軟研究員大力合作,5大主題,成文119頁

Sep 25, 2023 pm 04:49 PM

多模態大模型最全綜述來了! 7位微軟研究員大力合作,5大主題,成文119頁

Sep 25, 2023 pm 04:49 PM

多模態大模型最全綜述來了!由微軟7位華人研究員撰寫,足足119頁——它從目前已經完善的和還處於最前沿的兩類多模態大模型研究方向出發,全面總結了五個具體研究主題:視覺理解視覺生成統一視覺模型LLM加持的多模態大模型多模態agent並專注於一個現象:多模態基礎模型已經從專用走向通用。 Ps.這也是為什麼論文開頭作者就直接畫了一個哆啦A夢的形象。誰適合閱讀這份綜述(報告)?用微軟的原話來說:只要你有興趣學習多模態基礎模型的基礎知識和最新進展,無論你是專業研究員還是在校學生,這個內容都非常適合你一起來

SD社群的I2V-Adapter:無需配置,即插即用,完美相容於圖生視訊插件

Jan 15, 2024 pm 07:48 PM

SD社群的I2V-Adapter:無需配置,即插即用,完美相容於圖生視訊插件

Jan 15, 2024 pm 07:48 PM

影像到影片生成(I2V)任務是電腦視覺領域的一項挑戰,旨在將靜態影像轉化為動態影片。這個任務的困難在於從單張影像中提取並產生時間維度的動態訊息,同時保持影像內容的真實性和視覺上的連貫性。現有的I2V方法通常需要複雜的模型架構和大量的訓練資料來實現這一目標。近期,快手主導的一項新研究成果《I2V-Adapter:AGeneralImage-to-VideoAdapterforVideoDiffusionModels》發布。該研究引入了一種創新的圖像到視頻轉換方法,提出了一種輕量級適配器模組,即I

VPR 2024 滿分論文! Meta提出EfficientSAM:快速分割一切!

Mar 02, 2024 am 10:10 AM

VPR 2024 滿分論文! Meta提出EfficientSAM:快速分割一切!

Mar 02, 2024 am 10:10 AM

EfficientSAM這篇工作以5/5/5滿分收錄於CVPR2024!作者在某社群媒體上分享了這個結果,如下圖所示:LeCun圖靈獎得主也強烈推薦了這份工作!在近期的研究中,Meta研究者提出了一種新的改進方法,即使用SAM的遮罩影像預訓練(SAMI)。此方法結合了MAE預訓練技術和SAM模型,旨在實現高品質的預訓練ViT編碼器。透過SAMI,研究者試圖提高模型的表現和效率,為視覺任務提供更好的解決方案。這項方法的提出為進一步探索和發展電腦視覺和深度學習領域帶來了新的思路和機會。透過結合不同的

揭曉2022年玻爾茲曼獎:Hopfield網路創辦人榮獲獎項

Aug 13, 2023 pm 08:49 PM

揭曉2022年玻爾茲曼獎:Hopfield網路創辦人榮獲獎項

Aug 13, 2023 pm 08:49 PM

兩位獲得2022年玻爾茲曼獎的科學家已經公佈,這個獎項由IUPAP統計物理委員會(C3)設立,旨在表彰在統計物理學領域取得傑出成就的研究者。獲獎者必須是之前沒有獲得玻爾茲曼獎或諾貝爾獎的科學家。這個獎項始於1975年,每三年頒發一次,以紀念統計物理學的奠基人路德維希·玻爾茲曼DeepakDharistheoriginalstatement.獲獎理由:表彰DeepakDharistheoriginalstatement.對統計物理學領域作出的開創性貢獻,包括自組織臨界模型的精確解、界面生長、無序

GoogleAI新星轉投Pika:影片生成Lumiere一作,擔任創始科學家

Feb 26, 2024 am 09:37 AM

GoogleAI新星轉投Pika:影片生成Lumiere一作,擔任創始科學家

Feb 26, 2024 am 09:37 AM

影片產生進展如火如荼,Pika迎來一位大將-Google研究員OmerBar-Tal,擔任Pika創始科學家。一個月前,還在Google以共同一作的身份發布影片生成模型Lumiere,效果十分驚艷。當時網友表示:Google加入影片生成戰局,又有好戲可看了。 StabilityAICEO、谷歌前同事等在內一些業內人士送上了祝福。 Lumiere一作,剛碩士畢業OmerBar-Tal,2021年本科畢業於特拉維夫大學的數學與計算機系,隨後前往魏茨曼科學研究所攻讀計算機碩士,主要聚焦於圖像和視頻合成領域的研究。其論文成果多次