我們已經開始體驗到,矽計算體驗到達上限的感覺。未來10年,將出現嚴重的算力差距,而無論是現有的科技公司或政府,都沒能解決這個問題。

現在,我們已經習慣了計算會變得越來越便宜,以至於我們從來不曾懷疑過,也許有一天我們會用不起它。

現在,Rodolfo Rosini,一家新創公司的CEO提出了一個令我們震驚的問題:如果我們正在達到經典計算模型的基本物理極限,就像我們的經濟依賴廉價的計算一樣,那該怎麼辦?

現在,由於缺乏技術創新,美國已經到達了一個平穩期。

賴特定律(Wright’s Law)在許多產業中都成立-製造流程每改進20%左右,生產力就會翻倍。

在技術領域,它表現為摩爾定律。

在1960年代,英特爾聯合創始人Gordon Moore注意到積體電路中的電晶體數量似乎比去年同期翻了一番,提出了摩爾定律。

從此,這個定律就成為市場和工程之間契約的基礎,利用過剩的運算能力和尺寸的縮小,推動運算堆疊中產品的建構。

那時的預期是,有了更快、更便宜的處理器,運算能力會隨著時間呈指數級而提高。

然而,構成摩爾定律的不同力量已經改變了。

幾十年來,摩爾定律背後的動力是Dennard縮放定律。電晶體尺寸和功耗同步減半,使每單位能量的計算量增加一倍(後者也稱為Koomey’s LawKoomey定律)。

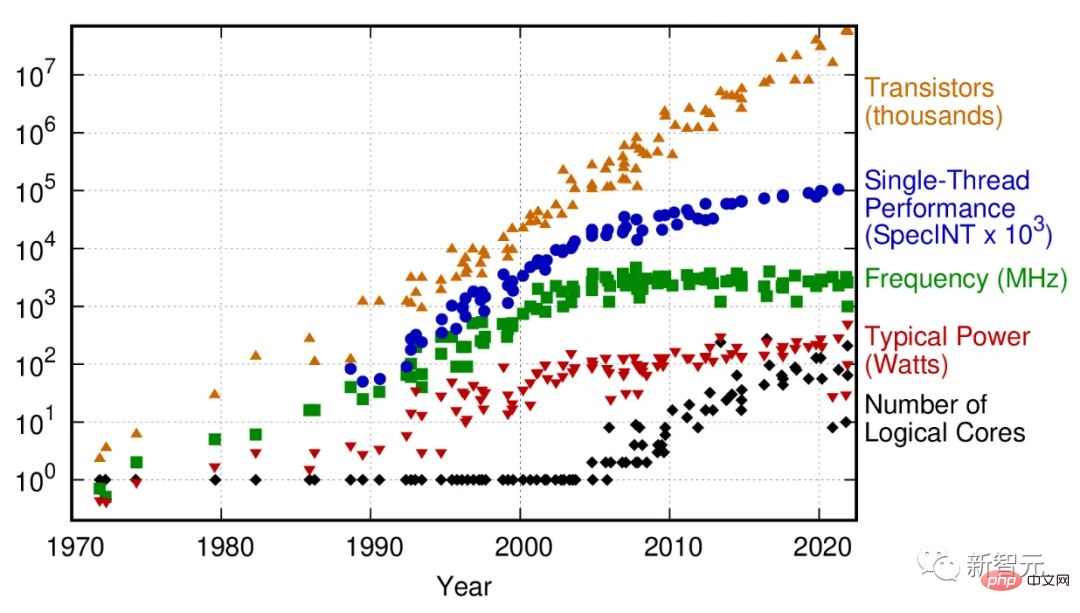

50年的微處理器趨勢資料

2005 年,由於電流洩漏導致晶片升溫,這種縮放比例開始失效,隨之而來的是具有單一處理核心的晶片的性能停滯不前。

為了保持運算成長軌跡,晶片產業轉向了多核心架構:多個微處理器「黏合」在一起。雖然這可能在晶體管密度方面延長了摩爾定律,但它增加了整個計算堆疊的複雜性。

對於某些類型的計算任務,如機器學習或電腦圖形,這帶來了效能提升。但是對於許多並行化不好的通用運算任務,多核心架構無能為力。

總之,很多任務的運算能力不再呈指數級增長。

即使在多核心超級電腦的效能上,從TOP500 (全球最快超級電腦排名)來看,2010年左右也出現了明顯的拐點。

這種放緩的影響是什麼?計算在不同行業中發揮的越來越重要的作用表明,影響是立竿見影的,而且只有在摩爾定律進一步動搖的情況下才會變得更加重要。

舉出兩個極端的例子:運算能力的提高和成本的降低使得能源產業石油勘探的生產力成長了49%,生技產業的蛋白質折疊預測成長了94%。

這意味著計算速度的影響不僅限於科技業,過去50年的大部分經濟成長都是摩爾定律驅動的二階效應,沒有它,世界經濟可能會停止成長。

還有一個需要更多算力的突出原因,就是人工智慧的興起。在今天,訓練大語言模型 (LLM) 可能花費數百萬美元,並需要數週時間。

如果不繼續增加數字運算和資料擴展,機器學習所承諾的未來就無法實現。

隨著機器學習模型在消費技術中的日益普及,預示著其他行業對計算的巨大需求,而且可能是雙曲線的需求,廉價的處理正成為生產力的基石。

摩爾定律的死亡可能會帶來計算的大停滯。與達到AGI可能需要的多模態神經網路相比,今天的LLM仍然相對較小,且容易訓練。未來的GPT和它們的競爭對手將需要特別強大的高效能電腦來改進,甚至進行最佳化。

或許很多人會感到懷疑。畢竟,摩爾定律的終結已經被預言過很多次了。為什麼應該是現在?

從歷史上看,這些預測中有許多都源自於工程上的挑戰。在此之前,人類的聰明才智曾一次又一次克服了這些障礙。

現在的不同之處在於,我們面臨的不再是工程和智慧方面的挑戰,而是物理學施加的限制。

MIT Technology Review2月24日發文稱,我們沒有為摩爾定律的終結做好準備

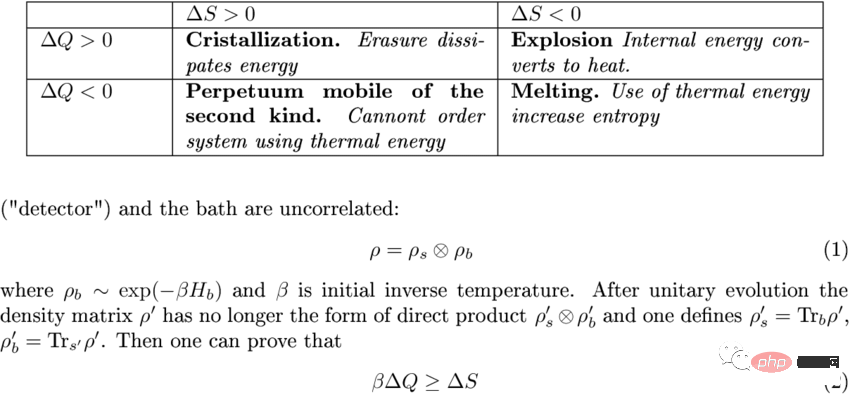

電腦是透過處理資訊來運作的。

當他們處理資訊時,其中一些資訊會隨著微處理器合併計算分支或覆蓋註冊表而被丟棄。這並不是免費的。

熱力學定律對某些過程的效率有嚴格的限制,而它也適用於計算,就像它適用於蒸汽機一樣。這個成本稱為Landauer’s limit蘭道爾極限(Landauer’s limit)。

它是每次計算操作過程中散發的微量熱量:大約每位元10^-21焦耳。

鑑於這種熱量這麼小,蘭道爾極限長期以來一直被認為可以忽略。

然而,現在的工程能力已經發展到了可以達到這種能量規模的程度,因為由於電流洩漏等其他開銷,現實世界的極限估計比Landauer的邊界大了10-100倍。晶片有數以千計的晶體管,以每秒數十億次的速度運行。

把這些數字加起來,或許在到達熱障礙之前,摩爾定律或許還剩下一個數量級的成長。

到那時,現有的電晶體架構將無法進一步提高能源效率,而且產生的熱量會阻止將電晶體封裝得更緊密。

如果我們不弄清楚這一點,就無法看清產業價值觀將會發生什麼變化。

微處理器將受到限制,產業將爭奪邊際能源效率的較低獎勵。

晶片尺寸會膨脹。看看英偉達4000系列的GPU 卡:儘管使用了更高密度的工藝,但它只有一隻小狗那麼大,功率高達650W。

這促使NVIDIA執行長黃仁勳在2022年底宣布「摩爾定律已死」——儘管這項聲明大部分正確,但其他半導體公司否認了這項聲明。

IEEE每年都會發布半導體路線圖,最新的評估是2D的微縮將在2028年完成,3D微縮應該在2031年全面啟動。

3D 微縮(晶片在其中相互堆疊)已經很普遍,但它是在電腦記憶體中,而不是在微處理器中。

這是因為記憶體的散熱要低得多;然而,散熱在3D架構中很複雜,因此主動記憶體冷卻變得很重要。

具有256層的記憶體即將出現,預計2030年將達到1,000層大關。

回到微處理器,正在成為商業標準的多門裝置架構(如Fin場效電晶體和Gates-all-round)將在未來幾年繼續遵循摩爾定律。

然而,由於固有的熱問題,在20世紀30年代以後都不可能有真正的垂直擴展(vertical scaling)。

事實上,目前的晶片組會仔細監督處理器的哪些部分隨時處於活躍狀態,即使在單一平面上也能避免過熱。

一個世紀前, 美國詩人Robert Frost曾經這樣問道:世界會在霜還是火中終結?

如果答案是火,那就幾乎預示著計算的終結。

或者,就接受這個事實:電力使用會增加,然後擴大微處理器的製造規模。

為了這個目的,人類已經消耗了地球能源很大一部分。

也許另一個選擇是簡單地接受增加的電力使用並擴大微處理器的製造規模。我們已經為此目的使用了地球能源供應的很大一部分。

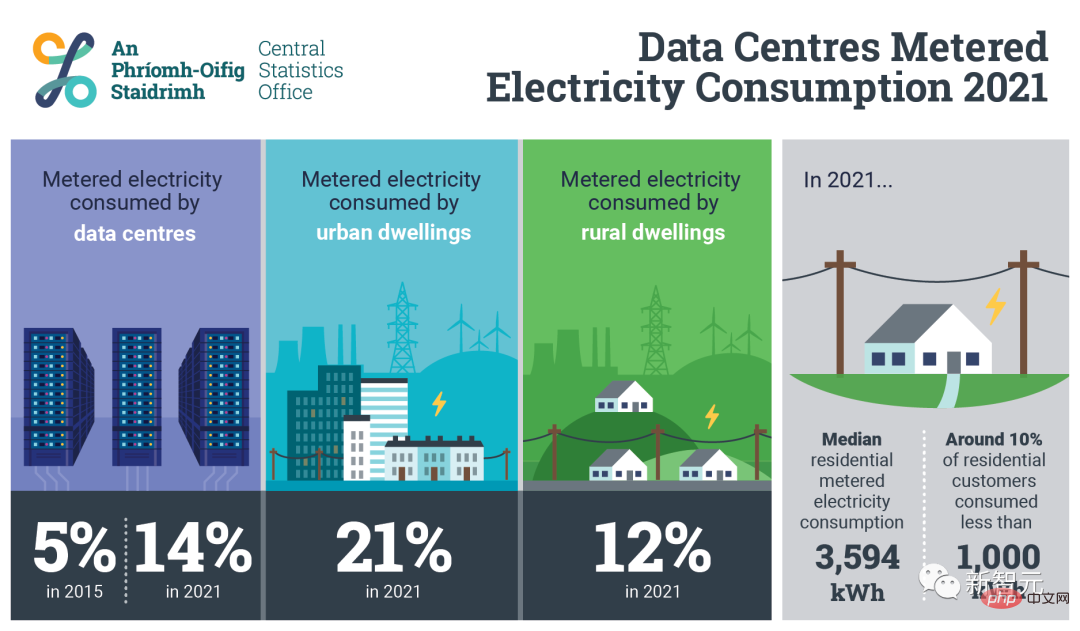

在愛爾蘭,光是70個資料中心就消耗了全國14%的能源。到2030年代,預計全球生產電力的30-50%將用於計算和冷卻。

(有趣的是,在3月19日部落格文章發表後,作者又刪除這個預測了。他的解釋是,這是基於Nature論文中最壞情況的推斷,為了論證的清晰和精確,現在已將其刪除)

而現在的能源生產的規模化速度,在這之後會導致摩爾定律規模化的成本略微增加。

而在設計(能源效率)和實施層面(將仍在使用的舊設計替換為最新技術)的一系列一次性優化措施,將允許印度等發展中經濟體趕上全球的整體生產力。

而摩爾定律終結後,人類在微處理器晶片的製造還沒有達到極限之前,就會耗盡能源,計算成本下降的步伐將停滯不前。

雖然量子運算被吹捧為超越摩爾定律的有效途徑,但它存在太多未知數了,離商用還有數十年的發展,至少在未來20到30年內,都派不上用場。

顯然,未來10年將出現嚴重的算力差距,現有的科技公司、投資人或政府機構都沒辦法解決。

摩爾定律和蘭道爾極限的碰撞已經有數十年了,可以說是2030年代最重大、最關鍵的事件之一。

但現在,知道這件事的人,似乎不多。

以上是人類已達矽運算架構上限!預計2030年,AI會消耗全球電力供應的50%的詳細內容。更多資訊請關注PHP中文網其他相關文章!