微軟提出自動化神經網路訓練剪枝框架OTO,一站式取得高效能輕量化模型

OTO 是業界首個自動化、一站式、使用者友好且通用的神經網路訓練與結構壓縮框架。

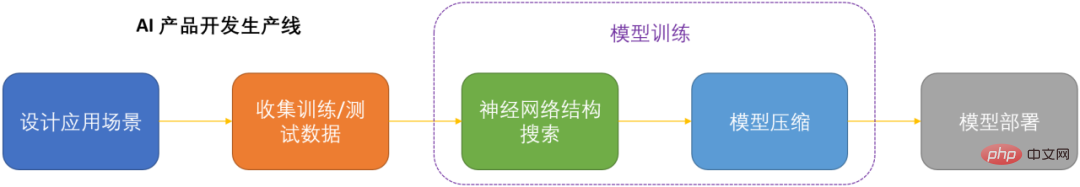

在人工智慧時代,如何部署和維護神經網路是產品化的關鍵問題考慮到節省運算成本,同時盡可能小地損失模型效能,壓縮神經網路成為了DNN 產品化的關鍵之一。

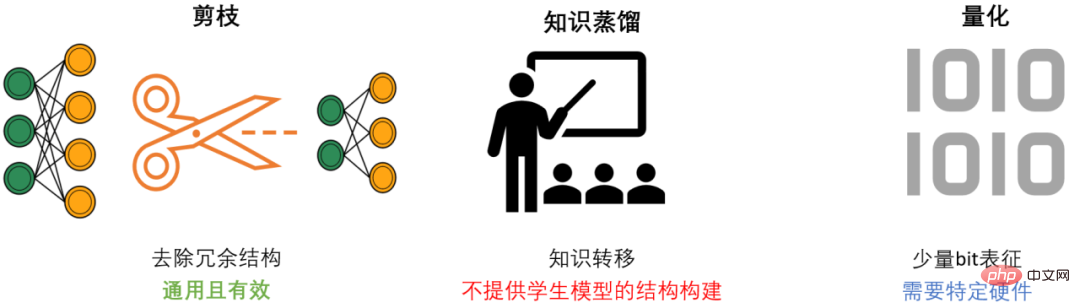

DNN 壓縮通常來說有三種方式,剪枝,知識蒸餾和量化。剪枝旨在識別並去除冗餘結構,給 DNN 瘦身的同時盡可能地保持模型性能,是最通用且有效的壓縮方法。三種方法通常來講可以相輔相成,共同作用來達到最佳的壓縮效果。

然而現存的剪枝方法大都只針對特定模型,特定任務,且需要很強的專業領域知識,因此通常需要AI 開發人員花費大量的精力才能將這些方法應用於自己的場景中,非常消耗人力物力成本。

OTO 概述

為了解決現存剪枝方法的問題並給 AI 開發者提供便利,微軟團隊提出了 Only-Train-Once OTO 框架。 OTO 是業界首個自動化、一站式、使用者友好且通用的神經網路訓練與結構壓縮框架,系列工作陸續發表於 ICLR2023 和 NeurIPS2021。

透過使用 OTO,AI 工程師可以輕鬆地訓練目標神經網絡,一站式地取得高效能且輕量化的模型。 OTO 最小化了開發者的工程時間精力的投入,且全程無需現有方法通常需要的非常耗時的預訓練和額外的模型微調。

- 論文連結:

- OTOv2 ICLR 2023: https://openreview.net/pdf?id=7ynoX1ojPMt

- OTOv1 NeurIPS 2021:https://proceedings .neurips.cc/paper_files/paper/2021/file/a376033f78e144f494bfc743c0be3330-Paper.pdf

- #程式碼連結:

https://github.com/tianyic/only 框架核心演算法

理想化的結構剪枝演算法應該做到:針對通用神經網絡,自動化地一站式地從零開始訓練,同時達到高性能且輕量化的模型,並無需後續微調。但因為神經網路的複雜性,要實現這個目標是一件極為有挑戰性的事情。為了實現這個最終目的,以下的三個核心問題需要被系統性地解決:

如何找出哪些網路結構可以移除?- 如何在移除網路結構的過程中,盡可能不損失模型效能?

- 如何能自動化地完成如前兩點?

- 微軟團隊設計並實現了三套核心演算法,首次系統性地,全面性地解決這三個核心問題。

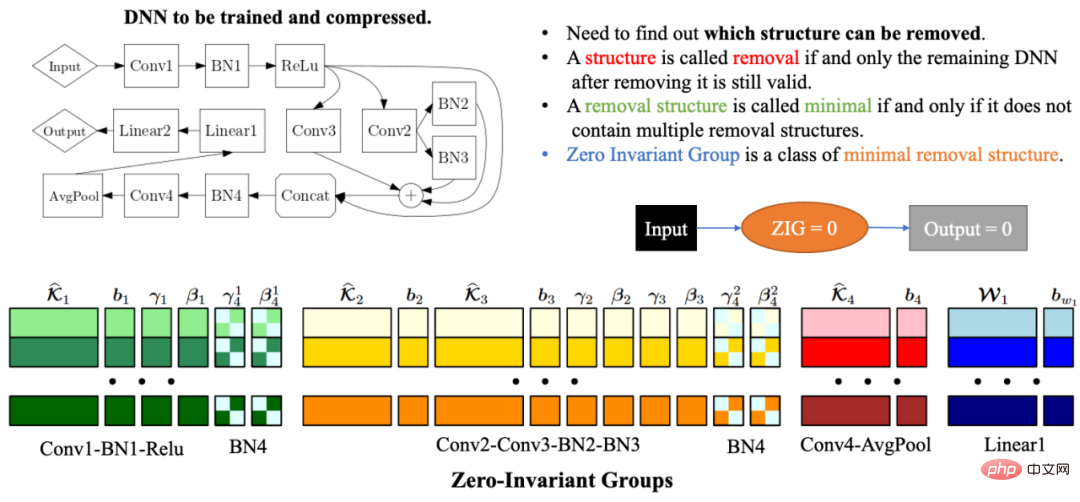

由於網路結構的複雜性和關聯性,刪除任意網路結構可能會導致剩餘的網路結構無效。因此自動化網路結構壓縮的一個最大的問題之一是如何找到必須一起剪枝的模型參數,使得餘下的網路仍然有效。為了解決這個問題,微軟團隊在 OTOv1 中提出了零不變組 Zero-Invariant Groups (ZIGs)。零不變組可以理解為一類最小的可移除單元,使得該組對應的網路結構移除後剩餘網路依然有效。零不變組的另一個主要特性是,如果一個零不變組等於零,那麼無論輸入值是什麼,輸出值永遠是零。在 OTOv2 中,研究者進一步提出並實作了一套自動化演算法來解決通用網路的零不變組的分組問題。自動化分組演算法是由一系列圖演算法精心設計組合而成,整套演算法非常高效,具有線性的時間空間複雜度。

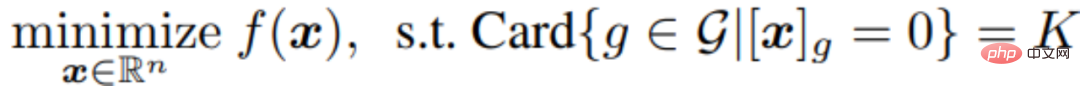

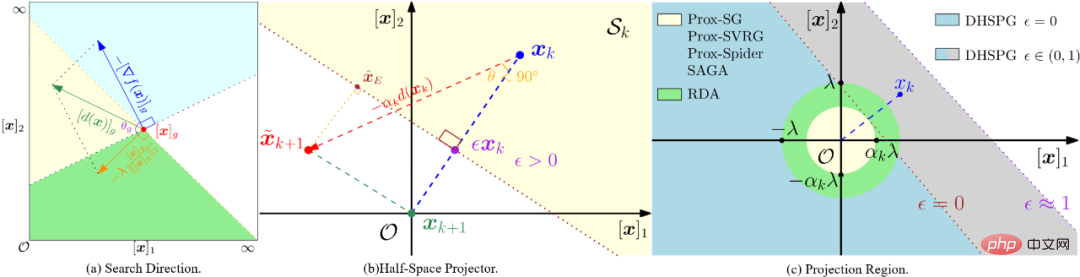

當分割目標網路所有的零不變組後,接下來的模型訓練和剪枝任務需要找出哪些零不變組是冗餘的,哪些又是重要的。冗餘的零不變組對應的網路結構需要被刪除,重要的零不變組需要保留並確保壓縮模型的效能。研究者公式化這個問題為一個結構性稀疏化問題,並提出全新的 Dual Half-Space Projected Gradient (DHSPG) 最佳化演算法來解決。

DHSPG 可以非常有效地找出冗餘的零不變組並將其投影成零,並持續訓練重要的零不變組來取得跟原始模型相媲美的性能。

與傳統稀疏優化演算法相比,DHSPG 具有更強更穩定地稀疏結構探索能力,且擴展了訓練搜尋空間並因此通常要獲得更高的實際表現效果。

自動化建立輕量壓縮模型

#透過使用DHSPG 對模型進行訓練,我們會得到一個服從於零不變組的高結構稀疏性的解,即該解裡面有很多被投影成零的零不變組,此外該解還會具有很高的模型性能。接下來,研究者把所有對應與冗餘零不變組的結構刪除來自動化地建構壓縮網路。由於零不變組的特性,即如果一個零不變組等於零,那麼無論輸入值是什麼,輸出值永遠是零,因此刪除冗餘的零不變組不會對網路產生任何影響。所以透過 OTO 得到的壓縮網路和完整網路會有相同的輸出,無需傳統方法所需的進一步模型微調。

數值實驗

分類任務

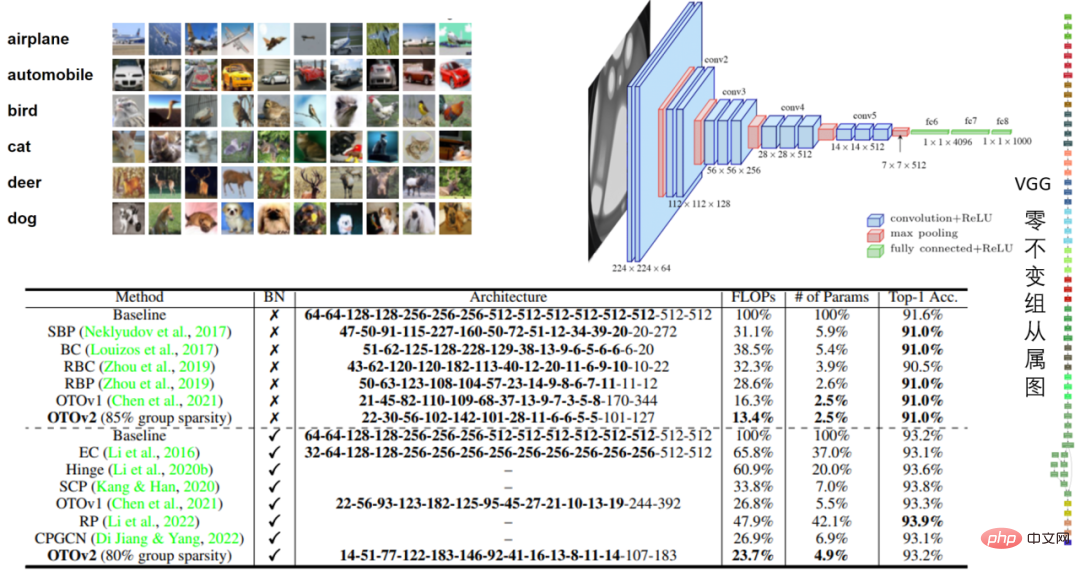

表1:CIFAR10 中的VGG16 及VGG16- BN 模型表現

在CIFAR10 的VGG16 實驗中,OTO 將浮點數減少了86.6%,將參數量減少了97.5%,效能表現令人印象深刻。

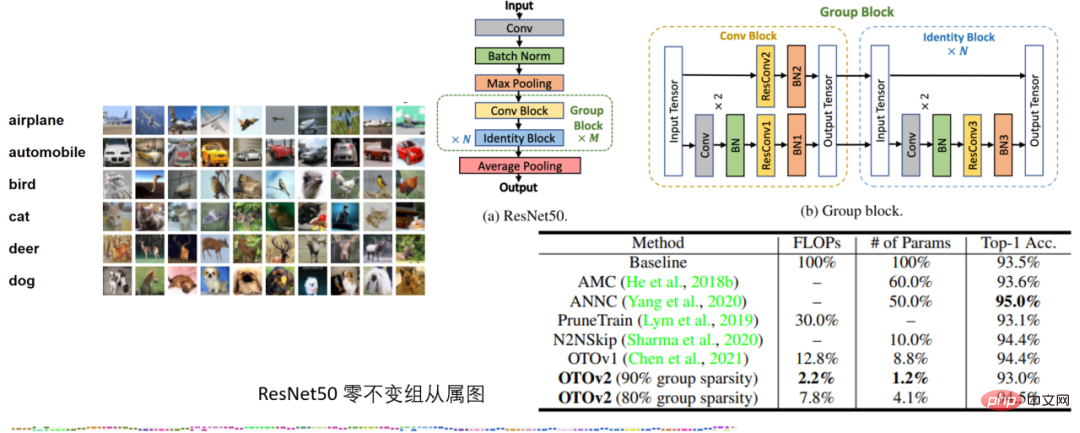

表2:CIFAR10 的ResNet50 實驗

在CIFAR10 的ResNet50 實驗中,OTO 在沒有量化的情況下優於SOTA 神經網路壓迫框架AMC 和ANNC,僅使用了7.8% 的FLOPs 和4.1% 的參數。

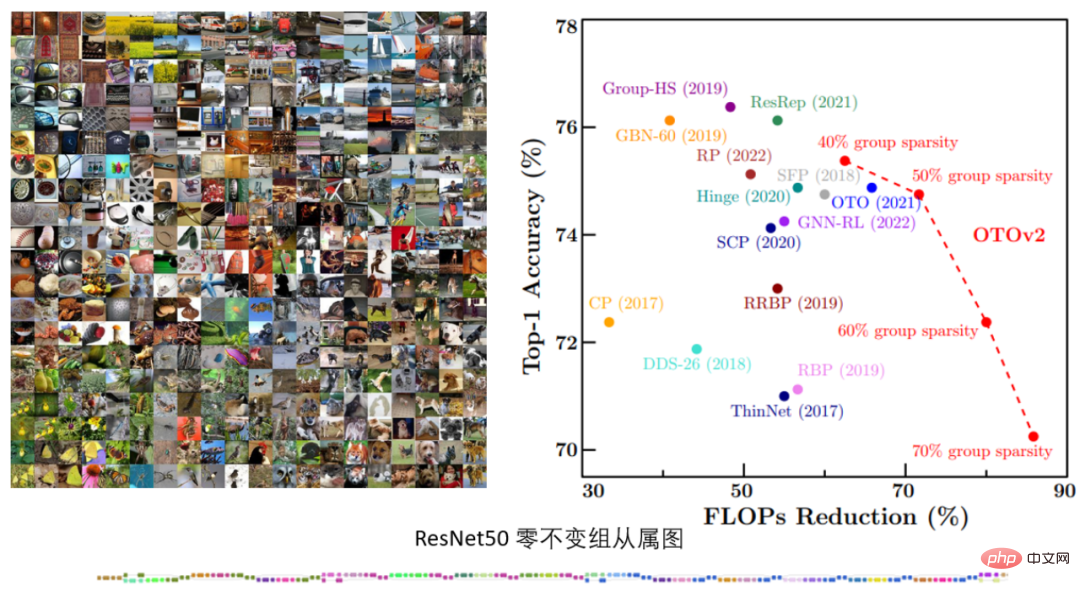

表3. ImageNet 的ResNet50 實驗

在ImageNet 的ResNet50 實驗中,OTOv2 在不同結構稀疏化目標下,展現出跟現存SOTA 方法相媲美甚至更優的表現。

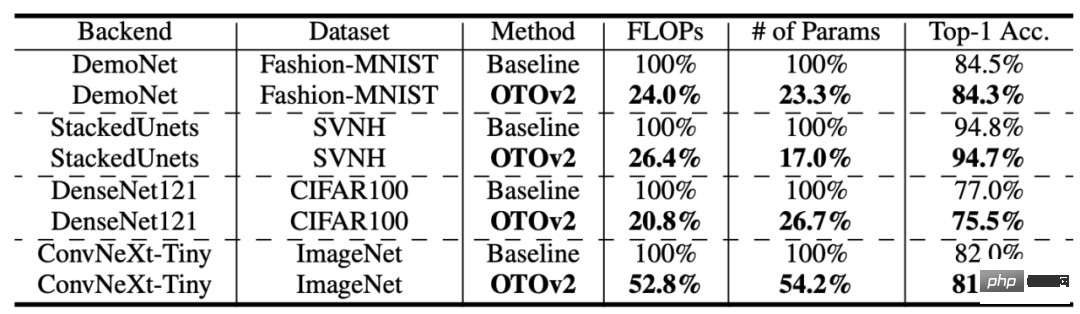

表4: 更多結構與資料集

OTO 也在更多的資料集和模型結構上取得了不錯的表現。

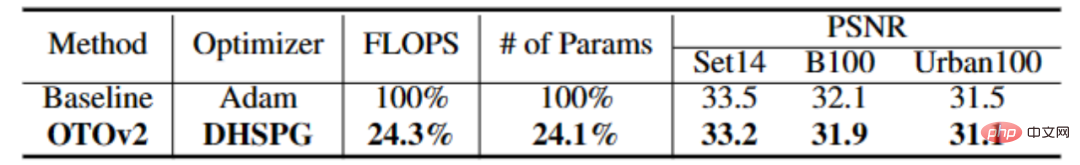

Low-Level Vision 任務

#表4:CARNx2 的實驗

#在super-resolution 的任務中,OTO 一站式訓練壓縮了CARNx2 網絡,得到了跟原始模型有競爭力的性能且壓縮了越75% 的運算量和模型大小。

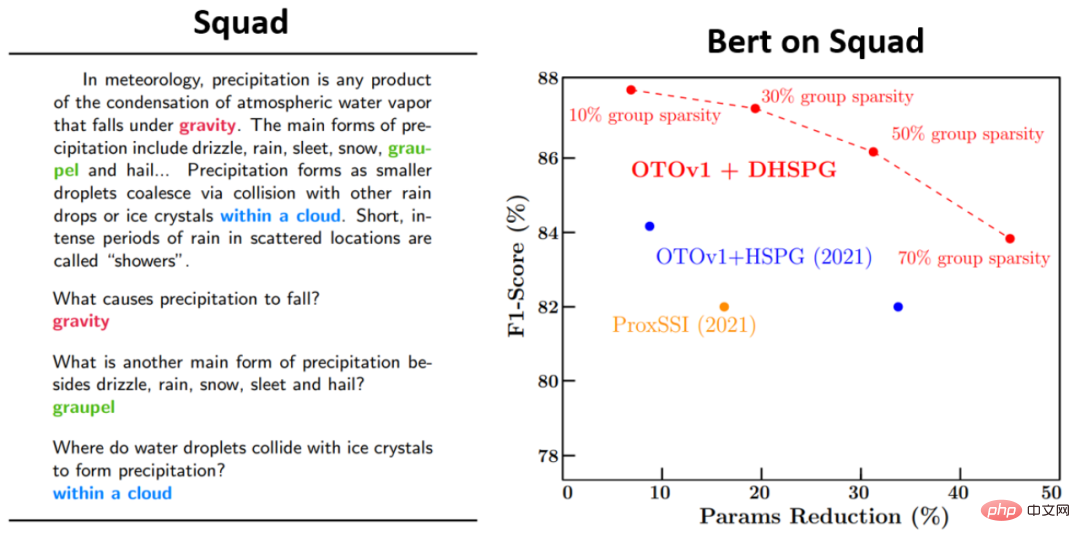

語言模型任務

此外,研究者在Bert 上也針對核心演算法之一,DHSPG 最佳化演算法,進行了對比試驗,驗證了其相較於其他稀疏最佳化演算法的高效能性。可以發現在 Squad 上,利用 DHSPG 進行訓練所得到的參數量減少和模型性能要遠遠優於其他稀疏優化演算法。

結論

微軟團隊提出了一個名為 OTO(Only-Train-Once)的 自動化一站式神經網路訓練結構剪枝框架。它可以將一個完整的神經網路自動化地壓縮為輕量級網絡,同時保持較高的效能。 OTO 大幅簡化了現有結構剪枝方法複雜的多階段流程,適合各類網路架構和應用,且最小化了使用者的額外工程投入,具有通用性,有效性和易用性。

以上是微軟提出自動化神經網路訓練剪枝框架OTO,一站式取得高效能輕量化模型的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

Microsoft Edge升級:自動儲存密碼功能遭禁? !用戶驚了!

Apr 19, 2024 am 08:13 AM

Microsoft Edge升級:自動儲存密碼功能遭禁? !用戶驚了!

Apr 19, 2024 am 08:13 AM

4月18日消息,近日,一些使用Canary頻道的MicrosoftEdge瀏覽器的用戶反映,在升級到最新版本後,他們發現自動保存密碼的選項被禁用了。經過調查,這是瀏覽器升級後的微調,而非功能被取消。在使用Edge瀏覽器造訪網站前,使用者回饋說瀏覽器會彈出一個視窗詢問是否希望儲存網站的登入密碼。選擇儲存後,下次登入時,Edge會自動填入已儲存的帳號和密碼,為使用者提供了極大的便利。但最近的更新類似於微調,修改了預設設定。使用者需要在選擇儲存密碼後,再手動在設定中開啟自動填入已儲存的帳號和密碼

微軟 Win11 壓縮為 7z、TAR 檔案的功能已從 24H2 下放到 23H2/22H2 版本

Apr 28, 2024 am 09:19 AM

微軟 Win11 壓縮為 7z、TAR 檔案的功能已從 24H2 下放到 23H2/22H2 版本

Apr 28, 2024 am 09:19 AM

本站4月27日消息,微軟本月初向Canary和Dev頻道發布了Windows11Build26100預覽版更新,預估會成為Windows1124H2更新的候選RTM版本。新版本中最主要的變化在於檔案總管、整合Copilot、編輯PNG檔案元資料、建立TAR和7z壓縮檔案等等。 @PhantomOfEarth發現,微軟已經將24H2版本(Germanium)部分功能下放到23H2/22H2(Nickel)版本中,例如創建TAR和7z壓縮檔。如示意圖所示,Windows11將支援原生建立TAR

微軟發布 Win11 八月累積更新:提高安全性、優化鎖定螢幕等

Aug 14, 2024 am 10:39 AM

微軟發布 Win11 八月累積更新:提高安全性、優化鎖定螢幕等

Aug 14, 2024 am 10:39 AM

本站8月14日訊息,在今天的8月補丁星期二活動日中,微軟發布了適用於Windows11系統的累積更新,包括針對22H2和23H2的KB5041585更新,面向21H2的KB5041592更新。上述設備安裝8月累積更新之後,本站附上版本號變更如下:21H2設備安裝後版本號升至Build22000.314722H2設備安裝後版本號升至Build22621.403723H2設備安裝後版本號升至Build22631.4037面向Windows1121H2的KB5041585更新主要內容如下:改進:提高了

微軟Edge瀏覽器更新:新增「放大影像」功能,提升使用者體驗

Mar 21, 2024 pm 01:40 PM

微軟Edge瀏覽器更新:新增「放大影像」功能,提升使用者體驗

Mar 21, 2024 pm 01:40 PM

3月21日消息,微軟近日對其MicrosoftEdge瀏覽器進行了更新,新增了一個實用的「放大影像」功能。現在,用戶在使用Edge瀏覽器時,只需右鍵點擊圖片,便可在彈出的選單中輕鬆找到這項新功能。更方便的是,使用者還可以將遊標停留在圖片上方,然後雙擊Ctrl鍵,即可快速呼出放大影像的功能。根據小編的了解,最新發布的MicrosoftEdge瀏覽器已經在Canary頻道進行了新功能測試。該瀏覽器的穩定版中也已經正式推出了實用的「放大影像」功能,為用戶提供了更便利的圖片瀏覽體驗。外國科技媒體也對此

微軟全螢幕彈窗催促:Windows 10用戶抓緊時間升級到Windows 11

Jun 06, 2024 am 11:35 AM

微軟全螢幕彈窗催促:Windows 10用戶抓緊時間升級到Windows 11

Jun 06, 2024 am 11:35 AM

6月3日訊息,微軟正在積極向所有Windows10用戶發送全螢幕通知,鼓勵他們升級到Windows11作業系統。這項舉措涉及了那些硬體配置並不支援新系統的設備。自2015年起,Windows10已經佔了近70%的市場份額,穩坐Windows作業系統的霸主地位。然而,市佔率遠超過82%的市場份額,佔有率遠超過2021年問世的Windows11。儘管Windows11已經推出已近三年,但其市場滲透率仍顯緩慢。微軟已宣布,將於2025年10月14日後終止對Windows10的技術支持,以便更專注於

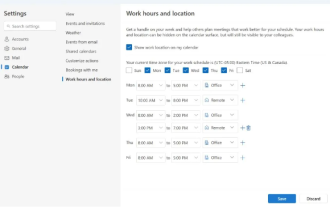

微軟推出新版Outlook for Windows:行事曆功能全面升級

Apr 27, 2024 pm 03:44 PM

微軟推出新版Outlook for Windows:行事曆功能全面升級

Apr 27, 2024 pm 03:44 PM

在4月27日的消息中,微軟公司宣布即將發布新版OutlookforWindows客戶端的測試。此次更新主要聚焦於優化行事曆功能,旨在提升使用者的工作效率,進一步簡化日常工作流程。新版OutlookforWindows客戶端的改進點在於其更強大的行事曆管理功能。現在,使用者能夠更方便地分享個人的工作時間與地點訊息,使得會議規劃更有效率。此外,Outlook還新增了人性化設置,讓用戶設定會議自動提前結束或推遲開始,為用戶提供了更多的靈活性,無論是換會議室、稍作休息還是享受一杯咖啡,都能輕鬆安排。根據

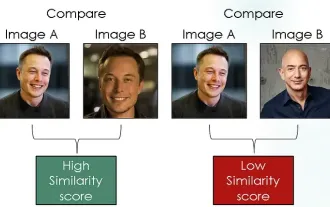

探索使用對比損失的孿生網路進行影像相似性比較

Apr 02, 2024 am 11:37 AM

探索使用對比損失的孿生網路進行影像相似性比較

Apr 02, 2024 am 11:37 AM

簡介在電腦視覺領域,準確地測量影像相似性是一項關鍵任務,具有廣泛的實際應用。從圖像搜尋引擎到人臉辨識系統和基於內容的推薦系統,有效比較和尋找相似圖像的能力非常重要。 Siamese網路與對比損失相結合,為數據驅動方式學習影像相似性提供了強大的框架。在這篇文章中,我們將深入了解Siamese網路的細節,探討對比損失的概念,並探討這兩個組件如何共同運作以創建一個有效的圖像相似性模型。首先,Siamese網路由兩個相同的子網路組成,這兩個子網路共享相同的權重和參數。每個子網路將輸入圖像編碼為特徵向量,這

微軟計畫2024年下半年在Windows 11中淘汰NTLM,全面轉向Kerberos認證

Jun 09, 2024 pm 04:17 PM

微軟計畫2024年下半年在Windows 11中淘汰NTLM,全面轉向Kerberos認證

Jun 09, 2024 pm 04:17 PM

2024年下半年,微軟安全官方部落格發布了一則訊息,回應安全社群的呼籲。本公司計畫在2024年下半年發布的Windows11中淘汰NTLANManager(NTLM)認證協議,以提升安全性。根據先前的解釋,微軟先前已經有過類似的動作。去年10月12日,微軟在一份官方新聞稿中就已經提出了一個過渡計劃,旨在逐步淘汰NTLM身份驗證方式,並推動更多企業和用戶轉向使用Kerberos。為了幫助那些可能在關閉NTLM驗證後遇到硬連線(hardwired)應用程式和服務問題的企業,微軟提供了IAKerb和