Google超強AI超算碾壓英偉達A100! TPU v4效能提升10倍,細節首次公開

雖然Google早在2020年,就在自家的資料中心上部署了當時最強的AI晶片—TPU v4。

但直到今年的4月4日,Google才首次公佈了這台AI超算的技術細節。

#論文網址:https://arxiv.org/abs/2304.01433

比起TPU v3,TPU v4的效能高出2.1倍,而整合4096個晶片之後,超算的效能更是提升了10倍。

另外,Google也聲稱,自家晶片要比英偉達A100更快、更節能。

與A100對打,速度快1.7倍

論文中,Google表示,對於規模相當的系統,TPU v4可以提供比英偉達A100強1.7倍的性能,同時在能源效率上也能提升1.9倍。

另外,Google超算速度還要比Graphcore IPU Bow快約4.3倍至4.5倍。

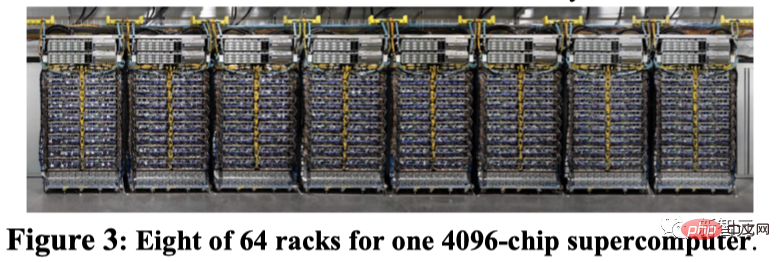

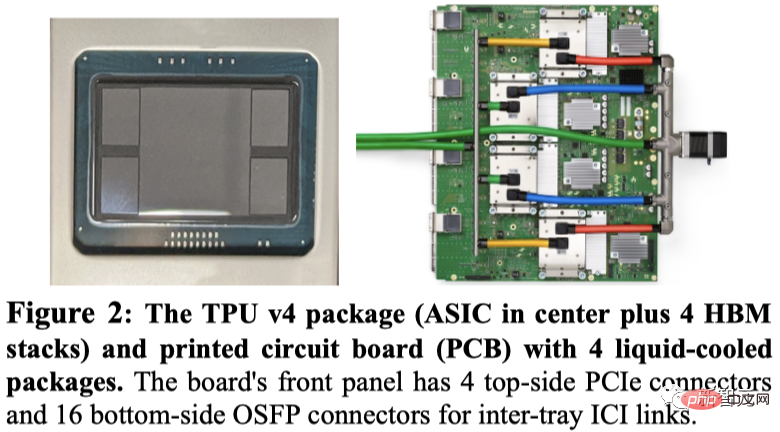

Google展示了TPU v4的封裝,以及4個安裝在電路板上的封裝。

與TPU v3一樣,每個TPU v4包含兩個TensorCore(TC)。每個TC包含四個128x128矩陣乘法單元(MXU),一個具有128個通道(每個通道16個ALU),以及16 MiB向量記憶體(VMEM)的向量處理單元(VPU)。

兩個TC共用一個128 MiB的公共記憶體(CMEM)。

值得注意的是,A100晶片與Google第四代TPU同時上市,那麼其具體效能比較如何?

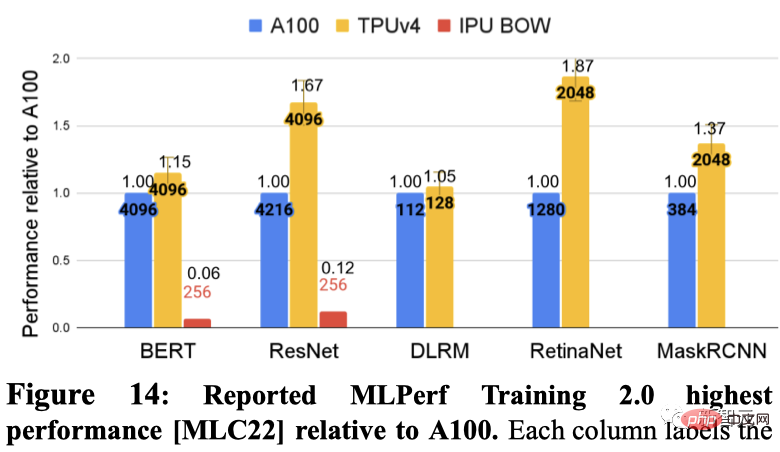

Google分別展示了在5個MLPerf基準測試中每個DSA的最快效能。其中包括BERT、ResNET、DLRM、RetinaNet、MaskRCNN。

其中,Graphcore IPU在BERT和ResNET提交了結果。

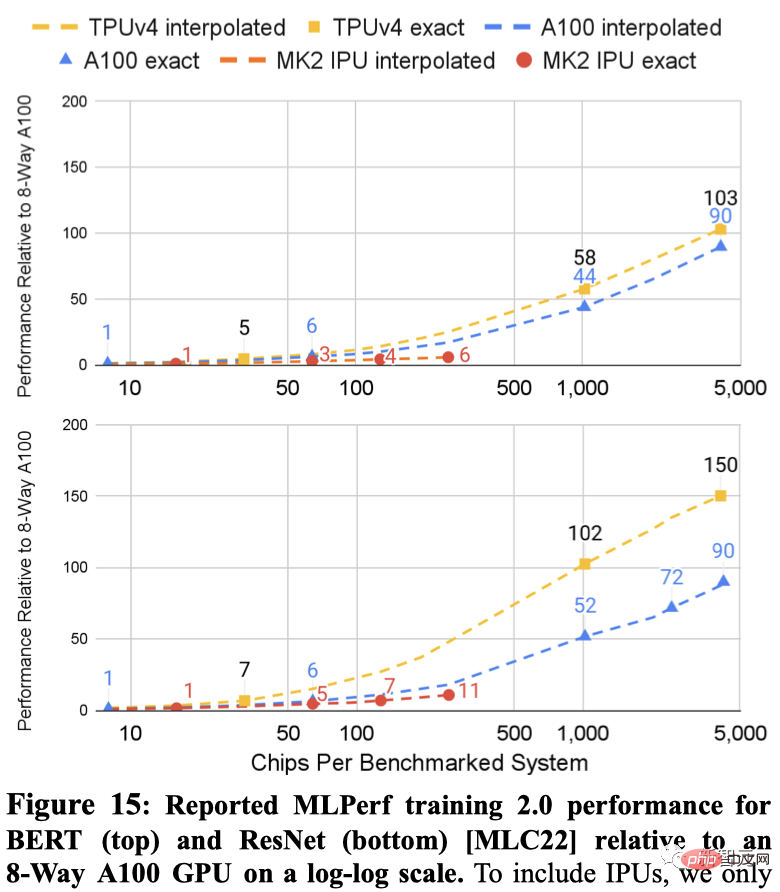

如下顯示了兩個系統在ResNet和BERT的結果,點之間的虛線是基於晶片數的插值。

TPU v4和A100的MLPerf結果都擴展到比IPU更大的系統(4096個晶片對比256個晶片)。

對於相似規模的系統,TPU v4在BERT上比A100快1.15倍,比IPU快約4.3倍。對於ResNet,TPU v4分別快速1.67倍和約4.5倍。

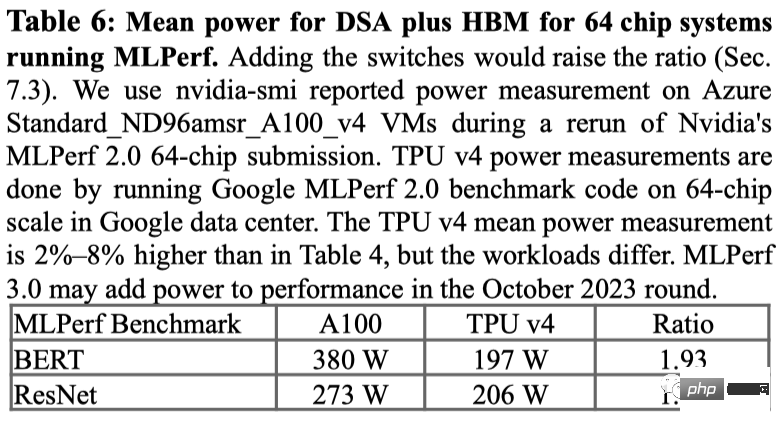

對於在MLPerf基準測試上的功耗使用情況,A100平均上使用了1.3倍至1.9倍的功率。

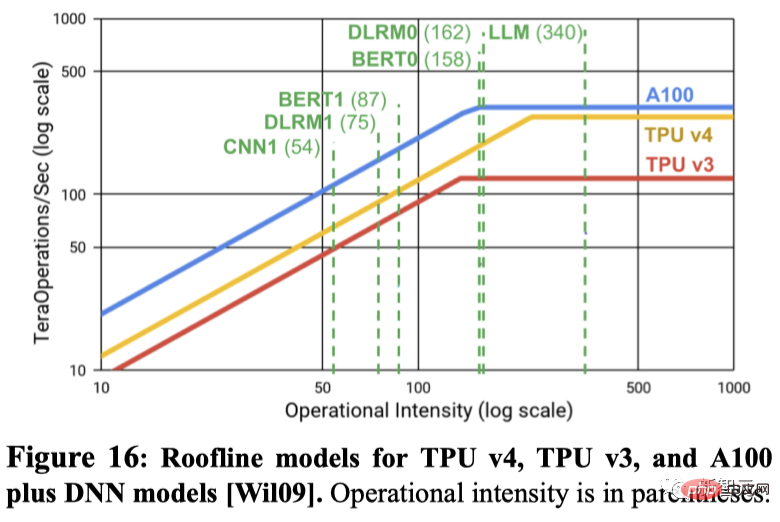

峰值每秒浮點運算次數是否能預測實際效能?許多機器學習領域的人認為峰值每秒浮點運算次數是一個很好的效能代理指標,但實際上並非如此。

例如,儘管在峰值每秒浮點運算次數上僅具有1.10倍的優勢,TPU v4在兩個MLPerf基準測試上比IPU Bow在相同規模的系統上快4.3倍至4.5倍。

另一個例子是,A100的峰值每秒浮點運算次數是TPU v4的1.13倍,但對於相同數量的晶片,TPU v4卻快1.15倍至1.67倍。

如下圖所示使用Roofline模型展示了峰值FLOPS/秒與記憶體頻寬之間的關係。

那麼,問題來了,為什麼谷歌不跟英偉達最新的H100比較呢?

Google表示,由於H100是在Google晶片推出後使用更新技術製造的,所以沒有將其第四代產品與英偉達目前的旗艦H100晶片進行比較。

不過Google暗示,它正在研發一款與Nvidia H100競爭的新TPU,但沒有提供詳細資訊。谷歌研究員Jouppi接受路透社採訪時表示,Google擁有「未來晶片的生產線」。

TPU vs GPU

在ChatGPT和Bard「決一死戰」的同時,兩個龐然大物也在幕後努力運行,以保持它們的運作-英偉達CUDA支持的GPU(圖形處理單元)和Google定制的TPU(張量處理單元)。

換句話說,這已經不再是關於ChatGPT與Bard的對抗,而是TPU與GPU之間的對決,以及它們如何有效地進行矩陣乘法。

由於硬體架構方面的出色設計,英偉達的GPU非常適合矩陣乘法任務-能有效地在多個CUDA核心之間實作並行處理。

因此從2012年開始,在GPU上訓練模型便成為了深度學習領域的共識,至今都未曾改變。

而隨著NVIDIA DGX的推出,英偉達能夠為幾乎所有的AI任務提供一站式硬體和軟體解決方案,這是競爭對手由於缺乏知識產權而無法提供的。

相比之下,Google則在2016年推出了第一代張量處理單元(TPU),其中不僅包含了專門為張量計算優化的客製化ASIC(專用積體電路),也針對自家的TensorFlow框架進行了最佳化。而這也讓TPU在矩陣乘法之外的其他AI運算任務中具有優勢,甚至還可以加速微調和推理任務。

此外,GoogleDeepMind的研究人員也找到了一種能夠創造出更好矩陣乘法演算法的方法-AlphaTensor。

然而,即便Google透過自研的技術和新興的AI運算優化方法取得了良好的成果,但微軟與英偉達長久以來的深度合作,則透過利用各自在產業上的積累,同時擴大了雙方的競爭優勢。

第四代TPU

#時間回到21年的GoogleI/O大會上,劈柴首次公佈了Google最新一代AI晶片TPU v4。

「這是我們在Google上部署的最快的系統,對我們來說是一個具有歷史意義的里程碑。」

########################### ##########這次的改進已經成為建立AI超算的公司之間競爭的關鍵點,因為像Google的Bard、或OpenAI的ChatGPT類似的大型語言模型已經在參數規模上實現爆炸性增長。 ############這意味著它們遠大於單一晶片所能儲存的容量,對算力需求是一個巨大的「黑洞」。 ######

因此這些大模型必須分佈在數千個晶片上,然後這些晶片必須協同工作數週,甚至更長時間來訓練模型。

目前,Google迄今公開揭露的最大的語言模型PaLM,有5400億參數,便是在50天內將其分割到兩台4000晶片的超級電腦上進行訓練的。

Google表示,自家的超級電腦能夠輕鬆地重新配置晶片之間的連接,能夠避免問題,並進行效能調優。

Google研究員Norm Jouppi和Google傑出工程師David Patterson在關於該系統的部落格文章中寫道,

「電路交換使得繞過度失效組件變得容易。這種靈活性甚至允許我們改變超算互連的拓撲結構,以加速機器學習模型的性能。」

##儘管谷歌現在才發布有關其超級電腦的詳細信息,但自2020年以來,該超級電腦已在位於俄克拉荷馬州梅斯縣的數據中心內上線。

Google表示,Midjourney使用該系統訓練了其模型,最新版的V5讓所有人見識到圖像生成的驚艷。

最近,劈柴在接受《紐約時報》採訪稱,Bard將從LaMDA轉到PaLM上。

現在有了TPU v4超算的加持,Bard只會變得更強。

以上是Google超強AI超算碾壓英偉達A100! TPU v4效能提升10倍,細節首次公開的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

量化交易所排行榜2025 數字貨幣量化交易APP前十名推薦

Apr 30, 2025 pm 07:24 PM

量化交易所排行榜2025 數字貨幣量化交易APP前十名推薦

Apr 30, 2025 pm 07:24 PM

交易所內置量化工具包括:1. Binance(幣安):提供Binance Futures量化模塊,低手續費,支持AI輔助交易。 2. OKX(歐易):支持多賬戶管理和智能訂單路由,提供機構級風控。獨立量化策略平台有:3. 3Commas:拖拽式策略生成器,適用於多平台對沖套利。 4. Quadency:專業級算法策略庫,支持自定義風險閾值。 5. Pionex:內置16 預設策略,低交易手續費。垂直領域工具包括:6. Cryptohopper:雲端量化平台,支持150 技術指標。 7. Bitsgap:

輕鬆協議(Easeprotocol.com)將ISO 20022消息標准直接實現為區塊鏈智能合約

Apr 30, 2025 pm 05:06 PM

輕鬆協議(Easeprotocol.com)將ISO 20022消息標准直接實現為區塊鏈智能合約

Apr 30, 2025 pm 05:06 PM

這種開創性的開發將使金融機構能夠利用全球認可的ISO20022標準來自動化不同區塊鏈生態系統的銀行業務流程。 Ease協議是一個企業級區塊鏈平台,旨在通過易用的方式促進廣泛採用,今日宣布已成功集成ISO20022消息傳遞標準,直接將其納入區塊鏈智能合約。這一開發將使金融機構能夠使用全球認可的ISO20022標準,輕鬆自動化不同區塊鏈生態系統的銀行業務流程,該標準正在取代Swift消息傳遞系統。這些功能將很快在“EaseTestnet”上進行試用。 EaseProtocolArchitectDou

數字貨幣app有前途嗎 蘋果手機數字貨幣交易平台app下載TOP10

Apr 30, 2025 pm 07:00 PM

數字貨幣app有前途嗎 蘋果手機數字貨幣交易平台app下載TOP10

Apr 30, 2025 pm 07:00 PM

數字貨幣App的前景廣闊,具體體現在:1. 技術創新驅動功能升級,通過DeFi與NFT融合及AI與大數據應用提升用戶體驗;2. 監管合規化趨勢,全球框架完善及AML、KYC要求趨嚴;3. 功能多元化與服務拓展,整合借貸、理財等服務並優化用戶體驗;4. 用戶基數與全球化擴張,預計2025年用戶規模突破10億。

幣圈中的三巨頭是哪些?虛擬幣主流交易所APP前十名推薦

Apr 30, 2025 pm 06:27 PM

幣圈中的三巨頭是哪些?虛擬幣主流交易所APP前十名推薦

Apr 30, 2025 pm 06:27 PM

在幣圈中,所謂的三巨頭通常指的是三種最具影響力和廣泛使用的加密貨幣。這些加密貨幣在市場上佔據了重要的地位,並在交易量和市值方面都表現出色。同時,虛擬幣主流交易所APP也是投資者和交易者進行加密貨幣交易的重要工具。本文將詳細介紹幣圈中的三巨頭以及推薦前十名的虛擬幣主流交易所APP。

已倒閉的加密交易所FTX在最新嘗試中對特定發行人採取法律訴訟

Apr 30, 2025 pm 05:24 PM

已倒閉的加密交易所FTX在最新嘗試中對特定發行人採取法律訴訟

Apr 30, 2025 pm 05:24 PM

在其最新嘗試中,已解決的加密交易所FTX採取了法律行動,以收回債務並償還客戶。在收回債務和償還客戶的最新努力中,已解決的加密交易所FTX已對特定發行人提起法律訴訟。 FTX交易和FTX恢復信託基金已針對未能履行其協議的某些代幣發行人提起訴訟,以將約定的硬幣匯出到交易所。具體來說,重組團隊在周一就合規性問題起訴了NFTStarsLimited和OrosemiInc.。 FTX正在起訴令牌發行人,以收回到期硬幣。 FTX曾經是美國最傑出的加密貨幣交易平台之一。該銀行在2022年11月因報導稱其創始人山姆·

AI和作曲家:增強代碼質量和開發

May 09, 2025 am 12:20 AM

AI和作曲家:增強代碼質量和開發

May 09, 2025 am 12:20 AM

AI在Composer中主要通過依賴推薦、依賴衝突解決和代碼質量提升來提高開發效率和代碼質量。 1.AI可以根據項目需求推薦合適的依賴包。 2.AI提供智能解決方案來處理依賴衝突。 3.AI審查代碼並提供優化建議,提升代碼質量。通過這些功能,開發者可以更專注於業務邏輯的實現。

全球十大支持多鏈交易的加密貨幣平台2025年權威發布

May 08, 2025 pm 07:15 PM

全球十大支持多鏈交易的加密貨幣平台2025年權威發布

May 08, 2025 pm 07:15 PM

根據 2025 年權威機構的最新評估和行業趨勢,以下是全球十大支持多鏈交易的加密貨幣平台,結合交易量、技術創新、合規性及用戶口碑綜合分析:

2025年十大數字虛擬幣交易APP排行 十大數字幣交易所app匯總

May 08, 2025 pm 05:24 PM

2025年十大數字虛擬幣交易APP排行 十大數字幣交易所app匯總

May 08, 2025 pm 05:24 PM

2025年十大數字虛擬幣交易APP排行:1. Binance:全球領先,提供高效交易和多種金融產品。 2. OKX:創新多樣,支持多種交易類型。 3. Huobi:穩定可靠,服務優質。 4. Coinbase:新手友好,界面簡潔。 5. Kraken:專業交易者首選,工具強大。 6. Bitfinex:高效交易,交易對豐富。 7. Bittrex:安全合規,監管合作。