吵翻天! ChatGPT到底懂不懂語言? PNAS:先研究什麼是「理解」吧

機器會不會思考這個問題就像問潛水艇會不會游泳一樣。 ——Dijkstra

早在ChatGPT發表前,業界就已經嗅到大模型帶來的改變了。

去年10月14日,聖塔菲研究所(Santa Fe Institute)的教授Melanie Mitchell和David C. Krakauer在arXiv發布了一篇綜述,全面調查了所有關於「大規模預訓練語言模型是否可以理解語言」的相關爭論,文中描述了「正方」和「反方」的論點,以及根據這些論點衍生的更廣泛的智力科學的關鍵問題。

論文連結:https://arxiv.org/pdf/2210.13966.pdf

發表期刊:《美國科學院院報》(PNAS)

太長不看版:

支持「理解」的主要論點是大型語言模型能夠完成許多似乎需要理解後才能完成的任務。

反對「理解」的主要論點是,以人類的角度來看,大型語言模型的理解力非常脆弱,例如無法理解prompt間的微妙變化;並且語言模型也沒有現實世界的生活經驗來驗證他們的知識,多模態的語言模型可能會緩解這個問題。

最關鍵的問題在於,目前還沒有人對「什麼是理解」有一個可靠的定義,也不知道如何測試語言模型的理解能力,用於人類的測驗不一定適用於測驗大型語言模型的理解能力。

總之,大型語言模型能夠理解語言,但可能是以一種不同於人類的理解方式。

研究者認為,可以發展一種新的智力科學,深入研究不同的理解類型,找出不同理解模式的優勢和局限性,同時整合不同理解形式所產生的認知差異。

論文的第一作者Melanie Mitchell是Santa Fe研究所的教授,她於1990年博士畢業於密西根大學,導師為侯世達(《哥德爾、艾舍爾、巴赫:集異璧之大成》的作者)和約翰霍蘭德,她的主要研究方向為類比推理、複雜系統、遺傳演算法和細胞自動機。

到底什麼叫做「理解」?

「何為理解」一直困擾著哲學家、認知科學家和教育家,研究人員經常以人類或其他動物作為「理解能力」的參考物。

直到最近,隨著大規模人工智慧系統的興起,特別是大型語言模型(LLM)的出現,在人工智慧界掀起了一場激烈的辯論,即現在是否可以說機器已經能夠理解自然語言,從而理解語言所描述的物理和社會情況。

這不是一場單純的學術辯論,機器理解世界的程度和方式對於人類能在多大程度上信任AI能夠執行駕駛汽車、診斷疾病、照顧老人、教育兒童等任務,以便在人類有關的任務中採取有力且透明的行動。

目前的辯論表明,學術界在如何思考智慧系統中的理解方面存在著一些分歧,特別是在依靠「統計相關性」和「因果機制」的心智模型(mental models)中,分歧更加明顯。

不過,人工智慧研究界對機器理解仍然達成了普遍共識,即,雖然人工智慧系統在許多特定任務中表現出看似智慧的行為,但它們並不像人類一樣理解它們所處理的資料。

比如說,臉部辨識軟體並不能理解臉部是身體的一部分,也不理解臉部表情在社會互動中的作用,更不能理解人類是如何以近乎無窮種方式來使用臉部概念的。

同樣,語音轉文字和機器翻譯程式也不理解它們所處理的語言,自動駕駛系統也不理解駕駛和行人用來避免事故的微妙眼神接觸或肢體語言的含義。

事實上,這些人工智慧系統經常被提及的脆性(brittleness),即不可預測的錯誤和缺乏穩健的泛化能力,是評估AI理解力的關鍵指標。

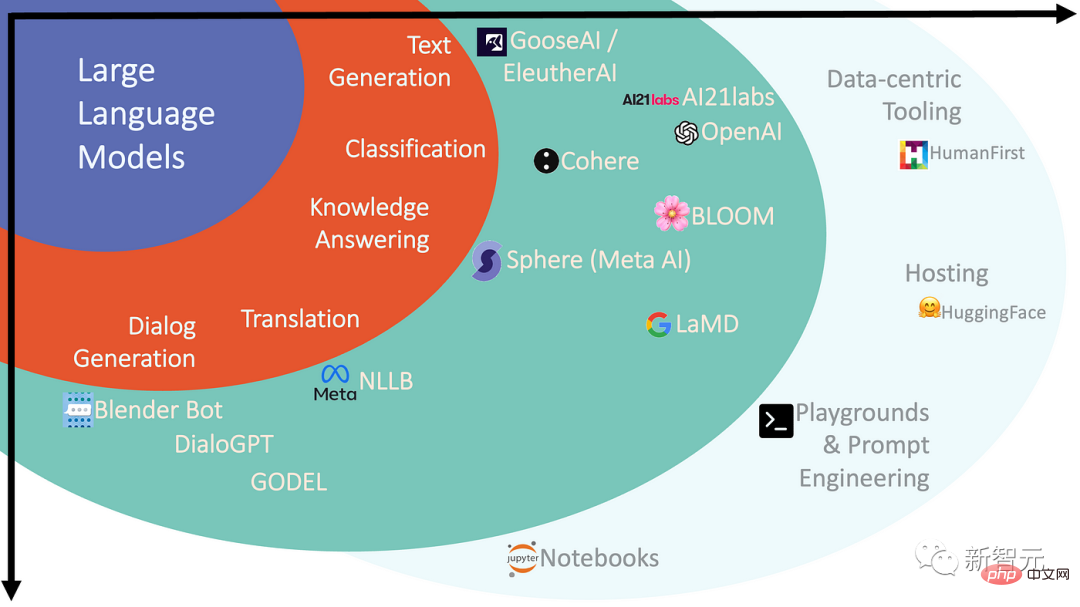

在過去的幾年裡,大型語言模型(LLMs)在人工智慧領域的受眾和影響力激增,也改變了一些人對機器理解語言前景的看法。

#大型預訓練模型,也可以稱為基礎模型(Foundation Models)是具有數十億到上萬億個參數(權重)的深度神經網絡,在海量自然語言語料庫(包括網絡文本、在線圖書等)上進行「預訓練」後得到。

模型在訓練期間的任務是預測輸入句子中的缺失部分,所以這種方法也叫做「自我監督學習」,由此產生的網路是一個複雜的統計模型,可以得到訓練資料中的單字和短語之間是如何相互關聯的。

這種模型可以用來產生自然語言,並為特定的自然語言任務進行微調,或者進一步訓練以更好地匹配“用戶意圖”,不過對於非專業人士和科學家來說,語言模型到底如何完成這些任務的,仍然是個謎。

神經網路的內部運作原理在很大程度上是不透明的,即使是建構這些網路的研究人員對這種規模的系統的直覺也是有限的。

神經科學家Terrence Sejnowski這樣描述LLMs的湧現能力(emergence):

#突破了某個閾值後,就好像外星人一下子出現了,可以用一種可怕的、人類交流的方式與我們交流。目前只有一件事是清楚的,大型語言模型並非人類,它們行為的某些方面似乎是智能的,但如果不是人類的智能,它們的智能的本質是什麼?

支持理解派VS反對理解派

儘管大型語言模型展現出的性能讓人震撼,但最先進的LLMs仍然容易受到脆性和非人類錯誤的影響。

不過可以觀察到,網路效能隨著其參數數量和訓練語料規模的擴大而有明顯改善,這也使得該領域的一些研究者聲稱,只要有足夠大的網路和訓練資料集,語言模型(多模態版本)也許是多模式版本--將導致人類層面的智慧和理解。

一個新的人工智慧口號已經出現:唯一要做的就是提升模型規模(Scale is all you need)!

這種說法也體現了人工智慧研究界關於大型語言模型的爭論:

一派認為,語言模型能夠真正理解語言,並能以通用的方式進行推理(儘管還沒有達到人類的層次)。

例如,Google的LaMDA系統在文字上進行了預訓練,然後在對話任務上進行了微調,能夠在非常廣泛的領域內與用戶進行對話。

另一派認為,像GPT-3或LaMDA這樣的大型預訓練模型,無論它們的語言輸出多麼流暢,都不能擁有理解力,因為這些模型沒有實務經驗,也沒有世界的心智模式。

語言模型只是在預測大量文本集合中的單字方面的訓練讓它們學會了語言的形式,遠遠沒有學會語言背後的意義。

僅靠語言訓練的系統永遠不會接近人類的智慧,即使從現在起一直訓練到宇宙消亡為止。很明顯,這些系統注定只能是淺層次的理解,永遠無法接近我們在人類身上看到的全身心的思考。

另一位學者認為,在談論這些系統時,智能、智能體以及推而廣之的理解是錯誤的,語言模型實際上是人類知識的壓縮庫,更類似圖書館或百科全書,而不是智能體。

例如,人類知道「癢」讓我們發笑是什麼意思,因為我們有身體;語言模型可以使用「癢」這個詞,但它顯然沒有過這種感覺,理解「癢」是將一個詞映射到一種感覺上,而不是映射到另一個詞。

那些站「LLMs沒有理解能力」一派的人認為,雖然大型語言模型的流暢性令人驚訝,但我們的驚訝反映了我們對統計相關性在這些模型的規模上能生成什麼缺乏直覺。

2022年對自然語言處理社群的活躍研究人員進行的一項調查報告顯示了這場辯論中的明顯分歧。

當詢問480位受訪者是否同意關於LLMs是否能在原理上理解語言的說法,即「只對文本進行訓練的生成式語言模型,只要有足夠的數據和計算資源,就能在某種意義上理解自然語言”

調查結果五五開,一半(51%)同意,另一半(49%)不同意。

#機器的理解不同於人類

雖然參與「LLM理解能力」辯論的雙方都有充分的直覺來支持各自的觀點,但目前可用來深入了解理解力的且基於認知科學的方法並不足以回答關於LLM的這類問題。

事實上,有些研究人員已經將心理測驗(最初是為了評估人類的理解和推理機制)應用於LLMs,發現在某些情況下,LLMs確實在思想理論測試中表現出類似人類的反應,以及在推理評估中表現出類似人類的能力和偏見。

雖然這些測試被認為是評估人類泛化能力的可靠智能體,但對於人工智慧系統來說可能不是這樣。

大型語言模型有一種特別的能力來學習其訓練資料和輸入中的token之間的相關性,並且可以使用這種相關性來解決問題;相反,人類使用反映其現實世界經驗的壓縮概念。

當把為人類設計的測試應用於LLMs時,對結果的解釋可能依賴於對人類認知的假設,而這些假設對這些模型來說可能根本不真實。

為了取得進展,科學家將需要開發新的基準和探測方法,以了解不同類型的智慧和理解的機制,包括我們所創造的新形式的「奇異的、類似心靈的實體」,目前也已經有了一些相關工作。

隨著模型規模越來越大,能力更強的系統被開發出來後,關於LLMs中的理解能力的爭論強調了我們需要「擴展我們的智能科學」 ,以便使得「理解」是有意義的,無論是對人或機器都是如此。

神經科學家Terrence Sejnowski指出,專家們對LLMs智慧的不同意見表明,我們基於自然智慧的舊觀念是不夠的。

如果LLMs和相關模型透過利用前所未有的規模的統計相關性就能獲得成功,也許可以被認為是一種「新的理解形式」, 一種能夠實現非凡的、超人的預測能力的形式,例如DeepMind的AlphaZero和AlphaFold系統,它們分別為下棋和蛋白質結構預測領域帶來了一種「外來」的直覺形式。

因此可以說,近年來,人工智慧領域創造了具有新的理解模式的機器,很可能是一個全新的概念,隨著我們在追求智能的難以捉摸的本質方面取得進展,這些新概念將繼續得到豐富。

那些需要大量編碼的知識、對效能要求很高的問題將會繼續促進大規模統計模型的開發,而那些擁有有限知識和強大因果機制的問題將有利於理解人類智能。

未來的挑戰是開發新的科學方法,以揭示不同形式的智慧的詳細理解機制,辨別它們的優勢和局限,並學習如何整合這些真正不同的認知模式。

參考資料:

https://www.pnas.org/doi/10.1073/pnas.2215907120

#以上是吵翻天! ChatGPT到底懂不懂語言? PNAS:先研究什麼是「理解」吧的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

ChatGPT 現在允許免費用戶使用 DALL-E 3 產生每日限制的圖像

Aug 09, 2024 pm 09:37 PM

ChatGPT 現在允許免費用戶使用 DALL-E 3 產生每日限制的圖像

Aug 09, 2024 pm 09:37 PM

DALL-E 3 於 2023 年 9 月正式推出,是比其前身大幅改進的車型。它被認為是迄今為止最好的人工智慧圖像生成器之一,能夠創建具有複雜細節的圖像。然而,在推出時,它不包括

在 iPhone 上更改語言的 3 種方法

Feb 02, 2024 pm 04:12 PM

在 iPhone 上更改語言的 3 種方法

Feb 02, 2024 pm 04:12 PM

眾所周知,iPhone是最人性化的電子產品之一,其中一個原因是它可以輕鬆地根據您的喜好進行個性化設定。在個人化設定中,您可以變更語言,這與您在設定iPhone時選擇的語言不同。如果您對多種語言熟悉,或者您的iPhone語言設定錯誤,您可以按照我們下面解釋的方法進行更改。如何更改iPhone的語言[3種方法]iOS允許使用者在iPhone上自由切換首選語言,以適應不同的需求。您可以更改與Siri的互動語言,方便與語音助理溝通。同時,在使用本機鍵盤時,您可以輕鬆地在多種語言之間切換,提高輸入效率。

手機怎麼安裝chatgpt

Mar 05, 2024 pm 02:31 PM

手機怎麼安裝chatgpt

Mar 05, 2024 pm 02:31 PM

安裝步驟:1、在ChatGTP官網或手機商店下載ChatGTP軟體;2、開啟後在設定介面中,選擇語言為中文;3、在對局介面中,選擇人機對局並設定中文相譜;4 、開始後在聊天視窗中輸入指令,即可與軟體互動。

如何將Win10電腦的語言設定為漢語?

Jan 05, 2024 pm 06:51 PM

如何將Win10電腦的語言設定為漢語?

Jan 05, 2024 pm 06:51 PM

有時候我們再剛入手安裝好電腦系統之後發現系統時英文的,遇到這種情況我們就需要把電腦的語言改成中文,那麼win10系統裡面該怎麼把電腦的語言改成中文呢,現在就給大家帶來具體的操作方法。 win10電腦語言怎麼改成中文1、開啟電腦點選左下角的開始按鍵。 2、點選左側的設定選項。 3.開啟的頁面選擇「時間和語言」4、開啟後,再點選左側的「語言」5、在這裡就可以設定你要的電腦語言。

如何使用ChatGPT和Java開發智慧聊天機器人

Oct 28, 2023 am 08:54 AM

如何使用ChatGPT和Java開發智慧聊天機器人

Oct 28, 2023 am 08:54 AM

在這篇文章中,我們將介紹如何使用ChatGPT和Java開發智慧聊天機器人,並提供一些具體的程式碼範例。 ChatGPT是由OpenAI開發的困境預測轉換(GenerativePre-trainingTransformer)的最新版本,它是一種基於神經網路的人工智慧技術,可以理解自然語言並產生人類類似的文本。使用ChatGPT,我們可以輕鬆地創建自適應的聊天

chatgpt國內可以使用嗎

Mar 05, 2024 pm 03:05 PM

chatgpt國內可以使用嗎

Mar 05, 2024 pm 03:05 PM

chatgpt在國內可以使用,但不能註冊,港澳也不行,用戶想要註冊的話,可以使用國外的手機號碼進行註冊,注意註冊過程中要將網路環境切換成國外ip。

如何使用ChatGPT PHP建構智慧客服機器人

Oct 28, 2023 am 09:34 AM

如何使用ChatGPT PHP建構智慧客服機器人

Oct 28, 2023 am 09:34 AM

如何使用ChatGPTPHP建構智慧客服機器人引言:隨著人工智慧技術的發展,機器人在客服領域的應用越來越廣泛。使用ChatGPTPHP建構智慧客服機器人,可以幫助企業提供更有效率、更個人化的客戶服務。本文將介紹如何使用ChatGPTPHP建構智慧客服機器人,並提供具體的程式碼範例。一、安裝ChatGPTPHP要使用ChatGPTPHP建構智慧客服機器人

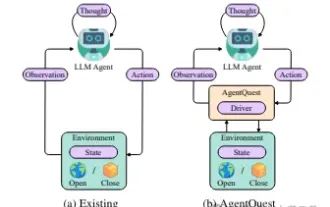

探索智能體的邊界:AgentQuest,一個全面衡量和提升大型語言模型智能體性能的模組化基準框架

Apr 11, 2024 pm 08:52 PM

探索智能體的邊界:AgentQuest,一個全面衡量和提升大型語言模型智能體性能的模組化基準框架

Apr 11, 2024 pm 08:52 PM

基於大模型的持續最佳化,LLM智能體-這些強大的演算法實體已經展現出解決複雜多步驟推理任務的潛力。從自然語言處理到深度學習,LLM智能體正逐漸成為研究和工業界的焦點,它們不僅能理解和生成人類語言,還能在多樣的環境中製定策略、執行任務,甚至使用API調用和編碼來建置解決方案。在這種背景下,AgentQuest框架的提出具有里程碑意義,它不僅僅是一個LLM智能體的評估和進步提供了一個模組化的基準測試平台,而且透過其易於擴展的API,為研究人員提供了一個強大的工具,以更細緻地追蹤和改進這些智能體的性能